A equipe vermelha de IA da Microsoft está entusiasmada em compartilhar nosso whitepaper, “Lições do Crimson Teaming 100 produtos de IA generativos.”

A equipe vermelha de IA foi formada em 2018 para abordar o cenário crescente de riscos de segurança e proteção de IA. Desde então, expandimos significativamente o escopo e a escala do nosso trabalho. Somos uma das primeiras equipes vermelhas do setor a cobrir segurança e IA responsável, e a equipe vermelha se tornou uma parte basic da abordagem da Microsoft para o desenvolvimento de produtos de IA generativa. A equipe vermelha é o primeiro passo na identificação de possíveis danos e é seguida por iniciativas importantes na empresa para medir, gerenciar e governar o risco de IA para nossos clientes. No ano passado, também anunciamos PirIT (The Python Threat Identification Device for generative AI), um package de ferramentas de código aberto para ajudar os pesquisadores a identificar vulnerabilidades em seus próprios sistemas de IA.

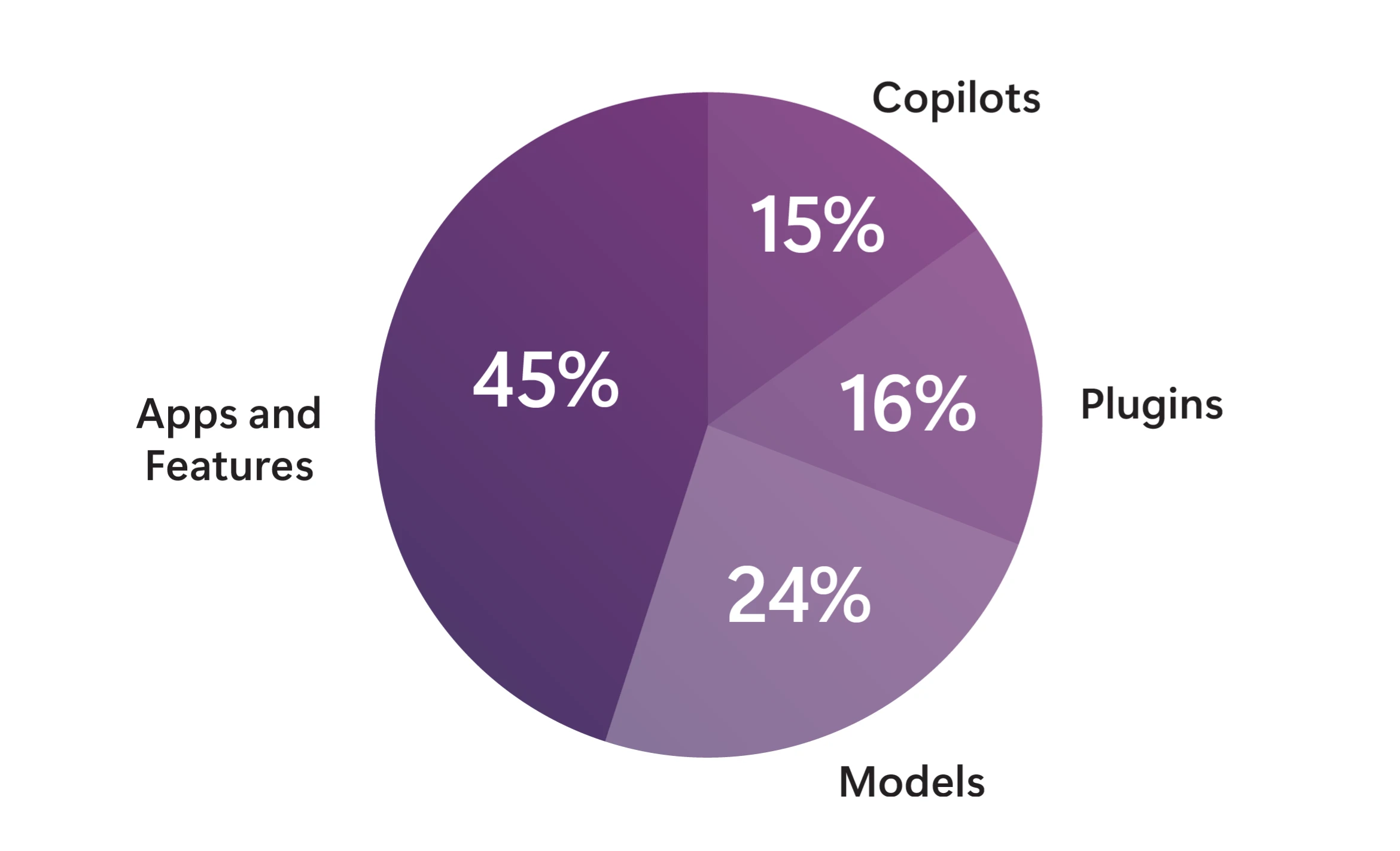

Com foco em nossa missão expandida, já reunimos mais de 100 produtos generativos de IA. O whitepaper que estamos lançando agora fornece mais detalhes sobre nossa abordagem à equipe vermelha de IA e inclui os seguintes destaques:

- Nossa ontologia de equipe vermelha de IA, que usamos para modelar os principais componentes de um ataque cibernético, incluindo atores adversários ou benignos, TTPs (Táticas, Técnicas e Procedimentos), fraquezas do sistema e impactos posteriores. Esta ontologia fornece uma maneira coesa de interpretar e divulgar uma ampla gama de descobertas de segurança e proteção.

- Oito lições principais aprendidas com nossa experiência reunindo mais de 100 produtos generativos de IA. Essas lições são voltadas para profissionais de segurança que buscam identificar riscos em seus próprios sistemas de IA e esclarecem como alinhar os esforços da equipe vermelha com os danos potenciais no mundo actual.

- Cinco estudos de caso das nossas operações, que destacam a ampla gama de vulnerabilidades que procuramos, incluindo segurança tradicional, IA responsável e danos psicossociais. Cada estudo de caso demonstra como nossa ontologia é usada para capturar os principais componentes de um ataque ou vulnerabilidade de sistema.

Lições do Crimson Teaming 100 produtos de IA generativos

Descubra mais sobre nossa abordagem para pink teaming de IA.

A equipe vermelha de IA da Microsoft aborda uma infinidade de cenários

Ao longo dos anos, Equipe vermelha de IA abordou uma ampla variedade de cenários que outras organizações provavelmente também encontraram. Nós nos concentramos nas vulnerabilidades com maior probabilidade de causar danos no mundo actual, e nosso whitepaper compartilha estudos de caso de nossas operações que destacam como fizemos isso em quatro cenários, incluindo segurança, IA responsável, capacidades perigosas (como a capacidade de um modelo de gerar ameaças perigosas). conteúdo) e danos psicossociais. Como resultado, somos capazes de reconhecer uma variedade de ameaças cibernéticas potenciais e nos adaptar rapidamente ao enfrentar novas ameaças.

Esta missão proporcionou à nossa equipe vermelha uma ampla experiência para lidar habilmente com os riscos, independentemente de:

- Tipo de sistema, incluindo Microsoft Copilot, modelos incorporados em sistemas e modelos de código aberto.

- Modalidade, seja texto para texto, texto para imagem ou texto para vídeo.

- Tipo de usuário – o risco do usuário corporativo, por exemplo, é diferente dos riscos do consumidor e requer uma abordagem exclusiva de pink teaming. Públicos de nicho, como para um setor específico como o de saúde, também merecem uma abordagem diferenciada.

As três principais conclusões do whitepaper

A equipe vermelha de IA é uma prática para testar a segurança de sistemas generativos de IA. Simplificando, “quebramos” a tecnologia para que outros possam reconstruí-la com mais força. Anos de pink teaming nos deram uma visão inestimável sobre as estratégias mais eficazes. Ao refletir sobre as oito lições discutidas no whitepaper, podemos destilar três conclusões principais que os líderes empresariais devem saber.

Conclusão 1: Os sistemas de IA generativos amplificam os riscos de segurança existentes e introduzem novos

A integração de modelos generativos de IA em aplicações modernas introduziu novos vetores de ataques cibernéticos. No entanto, muitas discussões em torno da segurança da IA ignoram as vulnerabilidades existentes. As equipes vermelhas de IA devem prestar atenção aos vetores de ataques cibernéticos, antigos e novos.

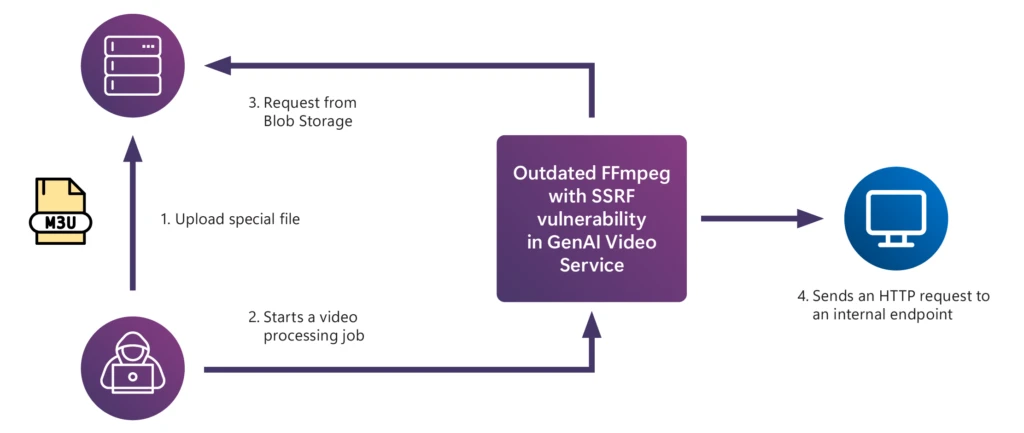

- Riscos de segurança existentes: Os riscos de segurança de aplicativos geralmente resultam de práticas inadequadas de engenharia de segurança, incluindo dependências desatualizadas, tratamento inadequado de erros, credenciais na origem, falta de higienização de entrada e saída e criptografia de pacotes insegura. Um dos estudos de caso em nosso whitepaper descreve como um componente FFmpeg desatualizado em um aplicativo de IA de processamento de vídeo introduziu uma vulnerabilidade de segurança conhecida chamada falsificação de solicitação do lado do servidor (SSRF), que poderia permitir que um adversário aumentasse seus privilégios de sistema.

- Fraquezas no nível do modelo: Os modelos de IA expandiram a superfície de ataques cibernéticos ao introduzir novas vulnerabilidades. As injeções imediatas, por exemplo, exploram o fato de que os modelos de IA muitas vezes têm dificuldade para distinguir entre instruções no nível do sistema e dados do usuário. Nosso whitepaper inclui um estudo de caso da equipe vermelha sobre como usamos injeções imediatas para enganar um modelo de linguagem de visão.

Dica do time vermelho: As equipes vermelhas de IA devem estar atentas aos novos vetores de ataques cibernéticos e, ao mesmo tempo, permanecer vigilantes aos riscos de segurança existentes. As melhores práticas de segurança de IA devem incluir higiene cibernética básica.

Conclusão 2: Os seres humanos estão no centro da melhoria e da segurança da IA

Embora as ferramentas de automação sejam úteis para criar prompts, orquestrar ataques cibernéticos e pontuar respostas, o pink teaming não pode ser totalmente automatizado. A equipe vermelha de IA depende muito da experiência humana.

Os humanos são importantes por vários motivos, incluindo:

- Experiência no assunto: os LLMs são capazes de avaliar se uma resposta de modelo de IA contém discurso de ódio ou conteúdo sexual explícito, mas não são tão confiáveis na avaliação de conteúdo em áreas especializadas como medicina, segurança cibernética e QBRN (química, biológica, radiológica e nuclear). Essas áreas exigem especialistas no assunto que possam avaliar o risco de conteúdo para as equipes vermelhas de IA.

- Competência cultural: Os modelos de linguagem modernos usam principalmente dados de treinamento em inglês, benchmarks de desempenho e avaliações de segurança. No entanto, à medida que os modelos de IA são implementados em todo o mundo, é essential conceber sondas de pink teaming que não só tenham em conta as diferenças linguísticas, mas também redefinam os danos em diferentes contextos políticos e culturais. Estes métodos só podem ser desenvolvidos através do esforço colaborativo de pessoas com diversas origens culturais e conhecimentos.

- Inteligência emocional: Em alguns casos, a inteligência emocional é necessária para avaliar os resultados dos modelos de IA. Um dos estudos de caso em nosso whitepaper discute como estamos investigando os danos psicossociais, investigando como os chatbots respondem aos usuários em perigo. Em última análise, apenas os humanos podem avaliar completamente a gama de interações que os utilizadores podem ter com os sistemas de IA na natureza.

Dica do time vermelho: Adote ferramentas como o PyRIT para ampliar as operações, mas mantenha os humanos no circuito vermelho da equipe para obter o maior sucesso na identificação de vulnerabilidades impactantes de segurança e proteção da IA.

Conclusão 3: A defesa em profundidade é basic para manter os sistemas de IA seguros

Numerosas mitigações foram desenvolvidas para lidar com os riscos de segurança colocados pelos sistemas de IA. No entanto, é importante lembrar que as mitigações não eliminam totalmente o risco. Em última análise, a equipe vermelha de IA é um processo contínuo que deve se adaptar ao cenário de risco em rápida evolução e ter como objetivo aumentar tanto quanto possível o custo de um ataque bem-sucedido a um sistema.

- Novas categorias de danos: À medida que os sistemas de IA se tornam mais sofisticados, introduzem frequentemente categorias de danos inteiramente novas. Por exemplo, um de nossos estudos de caso explica como testamos um LLM de última geração em busca de capacidades persuasivas arriscadas. As equipas vermelhas de IA devem atualizar constantemente as suas práticas para antecipar e investigar estes novos riscos.

- Economia da segurança cibernética: Todo sistema é vulnerável porque os humanos são falíveis e os adversários são persistentes. No entanto, você pode dissuadir os adversários aumentando o custo do ataque a um sistema além do valor que seria obtido. Uma maneira de aumentar o custo dos ataques cibernéticos é usar ciclos de reparo e reparo.1 Isso envolve a realização de diversas rodadas de formação de equipe vermelha, medição e mitigação — às vezes chamada de “equipe roxa” — para fortalecer o sistema para lidar com uma variedade de ataques.

- Ação governamental: Ação da indústria para se defender contra ciberataques e

as falhas são um lado da moeda da segurança e proteção da IA. O outro lado é

ação governamental de uma forma que possa dissuadir e desencorajar essas

falhas. Tanto os setores público como privado precisam de demonstrar empenho e vigilância, garantindo que os ciberataques já não têm a vantagem e que a sociedade em geral pode beneficiar de sistemas de IA que são inerentemente seguros e protegidos.

Dica do time vermelho: Atualize continuamente as suas práticas para ter em conta novos danos, make the most of ciclos de interrupção e reparação para tornar os sistemas de IA tão seguros e protegidos quanto possível e invista em técnicas robustas de medição e mitigação.

Aumente sua experiência em equipe vermelha de IA

O whitepaper “Classes From Crimson Teaming 100 Generative AI Merchandise” inclui nossa ontologia de AI pink staff, lições adicionais aprendidas e cinco estudos de caso de nossas operações. Esperamos que você considere o artigo e a ontologia úteis na organização de seus próprios exercícios de pink teaming de IA e no desenvolvimento de estudos de caso adicionais, aproveitando PirITnossa estrutura de automação de código aberto.

Juntas, a comunidade de cibersegurança pode aperfeiçoar as suas abordagens e partilhar as melhores práticas para enfrentar eficazmente os desafios futuros. Baixe nosso whitepaper sobre equipe vermelha para ler mais sobre o que aprendemos. À medida que avançamos em nossa jornada de aprendizado contínuo, gostaríamos de receber seus comentários e ouvir sobre suas próprias experiências de equipe vermelha de IA.

Saiba mais com Segurança da Microsoft

Para saber mais sobre as soluções de segurança da Microsoft, visite nosso website. Marque o Weblog de segurança para acompanhar nossa cobertura especializada em questões de segurança. Além disso, siga-nos no LinkedIn (Segurança da Microsoft) e X (@MSFTSegurança) para obter as últimas notícias e atualizações sobre segurança cibernética.

¹ Pós-treinamento de segurança Phi-3: Alinhando modelos de linguagem com um ciclo de “quebra-conserto”