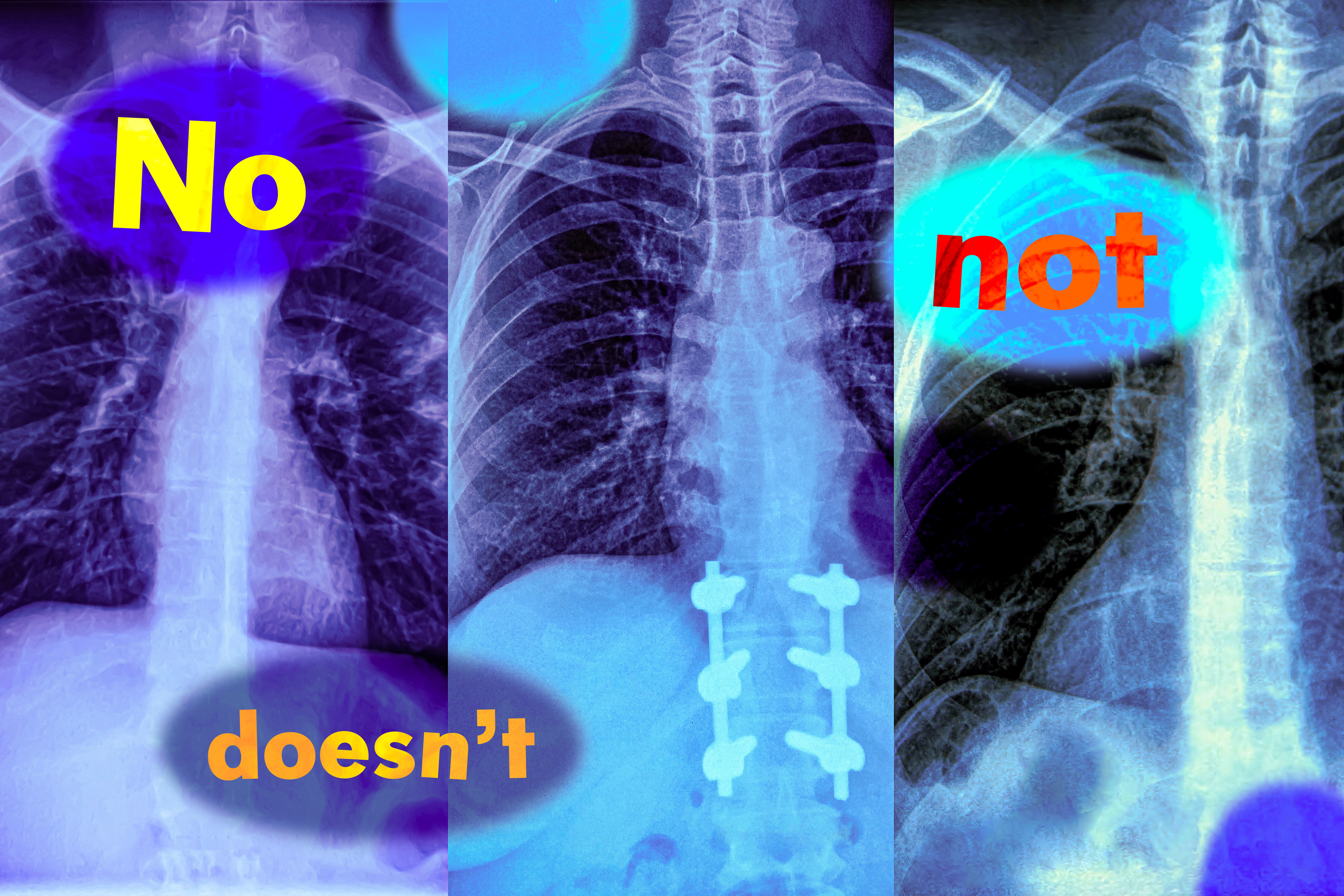

Think about um radiologista examinando uma radiografia de tórax de um novo paciente. Ela percebe que o paciente tem inchaço no tecido, mas não tem um coração aumentado. Procurando acelerar o diagnóstico, ela pode usar um modelo de aprendizagem de máquina em linguagem de visão para procurar relatórios de pacientes semelhantes.

Mas se o modelo por engano identificar por engano relatos com ambas as condições, o diagnóstico mais provável poderá ser bem diferente: se um paciente tiver inchaço de tecido e um coração aumentado, é muito provável que a condição esteja relacionada cardíaca, mas sem coração aumentado, pode haver várias causas subjacentes.

Em um novo estudo, os pesquisadores do MIT descobriram que os modelos de linguagem da visão têm uma probabilidade de cometer esse erro em situações do mundo actual porque não entendem a negação-palavras como “não” e “não” que especificam o que é falso ou ausente.

“Essas palavras de negação podem ter um impacto muito significativo e, se estamos apenas usando esses modelos cegamente, podemos ter consequências catastróficas”, diz Kumail Alhamoud, um estudante de graduação do MIT e principal autor de este estudo.

Os pesquisadores testaram a capacidade dos modelos de linguagem da visão para identificar a negação nas legendas da imagem. Os modelos costumavam ter um palpite e um palpite aleatório. Com base nessas descobertas, a equipe criou um conjunto de dados de imagens com legendas correspondentes que incluem palavras de negação que descrevem objetos ausentes.

Eles mostram que a reciclagem de um modelo de linguagem de visão com esse conjunto de dados leva a melhorias de desempenho quando um modelo é solicitado a recuperar imagens que não contêm determinados objetos. Também aumenta a precisão da resposta de perguntas de múltipla escolha com legendas negadas.

Mas os pesquisadores advertem que é necessário mais trabalho para resolver as causas raiz desse problema. Eles esperam que sua pesquisa alerte os usuários em potencial para uma falha despercebida anteriormente que possa ter implicações sérias em ambientes de alto risco, onde esses modelos estão sendo usados atualmente, desde a determinação de quais pacientes recebam certos tratamentos para identificar defeitos do produto nas fábricas.

“Este é um artigo técnico, mas há problemas maiores a serem considerados. Se algo tão elementary quanto a negação estiver quebrada, não devemos usar grandes modelos de visão/idioma de muitas das maneiras pelas quais estamos usando -os agora – sem avaliação intensiva”, diz o autor e o SMORYEH SYMINGSTUTE, um membro associado do Departamento de Engenharia Médica e Ciência da Computação (EECs) e um membro do Instituto do Instituto do Instituto do Instituto do Instituto,

Ghassemi e Alhamoud se juntam ao jornal de Shaden Alshammari, um estudante de pós -graduação do MIT; Yonglong Tian de Openai; Guohao Li, ex -pós -doutorado na Universidade de Oxford; Philip HS Torr, professor de Oxford; e Yoon Kim, professor assistente de EECs e membro do Laboratório de Ciência da Computação e Inteligência Synthetic (CSAIL) no MIT. A pesquisa será apresentada na conferência sobre visão computacional e reconhecimento de padrões.

Negligenciando a negação

Os modelos de linguagem de visão (VLM) são treinados usando enormes coleções de imagens e legendas correspondentes, que eles aprendem a codificar como conjuntos de números, chamados representações vetoriais. Os modelos usam esses vetores para distinguir entre imagens diferentes.

Um VLM utiliza dois codificadores separados, um para texto e outro para imagens, e os codificadores aprendem a produzir vetores semelhantes para uma imagem e sua legenda de texto correspondente.

“As legendas expressam o que está nas imagens – elas são um rótulo positivo. E esse é realmente o problema. Ninguém olha para a imagem de um cachorro pulando sobre uma cerca e legendando -a dizendo ‘um cachorro pulando sobre uma cerca, sem helicópteros'”, diz Ghassemi.

Como os conjuntos de dados de captura de imagem não contêm exemplos de negação, os VLMs nunca aprendem a identificá-lo.

Para aprofundar esse problema, os pesquisadores criaram duas tarefas de referência que testam a capacidade dos VLMs de entender a negação.

Para o primeiro, eles usaram um modelo de idioma grande (LLM) para recaiar as imagens em um conjunto de dados existente, solicitando ao LLM que pense em objetos relacionados não em uma imagem e escrevê-los na legenda. Em seguida, eles testaram modelos, levando -os com palavras de negação a recuperar imagens que contêm certos objetos, mas não outros.

Para a segunda tarefa, eles projetaram perguntas de múltipla escolha que solicitam a um VLM para selecionar a legenda mais apropriada a partir de uma lista de opções intimamente relacionadas. Essas legendas diferem apenas adicionando uma referência a um objeto que não aparece na imagem ou negando um objeto que apareça na imagem.

Os modelos geralmente falharam nas duas tarefas, com o desempenho da recuperação de imagens caindo quase 25 % com legendas negadas. Quando se trata de responder a perguntas de múltipla escolha, os melhores modelos alcançaram apenas cerca de 39 % de precisão, com vários modelos apresentando ou mesmo abaixo da likelihood aleatória.

Uma razão para essa falha é um atalho que os pesquisadores chamam de viés de afirmação – os VLMs ignoram as palavras da negação e se concentram nos objetos nas imagens.

“Isso não acontece apenas para palavras como ‘não’ e ‘não’. Independentemente de como você expressa negação ou exclusão, os modelos simplesmente a ignoram ”, diz Alhamoud.

Isso foi consistente em todos os VLM que eles testaram.

“Um problema solucionável”

Como os VLMs não são normalmente treinados em legendas de imagem com negação, os pesquisadores desenvolveram conjuntos de dados com palavras de negação como um primeiro passo para resolver o problema.

Usando um conjunto de dados com 10 milhões de pares de legendas de texto de imagem, eles levaram um LLM a propor legendas relacionadas que especificam o que é excluído das imagens, produzindo novas legendas com palavras de negação.

Eles tinham que ser especialmente cuidadosos com o fato de essas legendas sintéticas ainda ler naturalmente, ou isso poderia fazer com que um VLM falhe no mundo actual quando se depara com legendas mais complexas escritas por seres humanos.

Eles descobriram que o Finetuning VLMS com seu conjunto de dados levou a ganhos de desempenho em geral. Ele melhorou as habilidades de recuperação de imagens dos modelos em cerca de 10 %, além de aumentar o desempenho na tarefa de resposta a perguntas de múltipla escolha em cerca de 30 %.

“Mas nossa solução não é perfeita. Estamos apenas recapitando os conjuntos de dados, uma forma de aumento de dados. Nem tocamos como esses modelos funcionam, mas esperamos que este seja um sinal de que esse seja um problema solucionável e outros podem pegar nossa solução e melhorá -la”, diz Alhamoud.

Ao mesmo tempo, ele espera que o trabalho deles incentive mais usuários a pensar no problema que desejam usar um VLM para resolver e projetar alguns exemplos para testá -lo antes da implantação.

No futuro, os pesquisadores poderiam expandir esse trabalho ensinando VLMs a processar texto e imagens separadamente, o que pode melhorar sua capacidade de entender a negação. Além disso, eles podem desenvolver conjuntos de dados adicionais que incluem pares de capturas de imagem para aplicativos específicos, como cuidados de saúde.