Hoje, fico feliz em compartilhar as verificações automatizadas de raciocínio, um novo Amazon Bedrock Guardrails política que visualizamos durante a AWS Re: Inventagora está geralmente disponível. Verificações de raciocínio automatizadas ajudam você a validar a precisão do conteúdo gerado por Modelos de fundação (FMS) contra um conhecimento de domínio. Isso pode ajudar a evitar erros factuais devido a alucinações de IA. A política usa a lógica matemática e as técnicas de verificação formal para validar a precisão, fornecendo regras e parâmetros definitivos contra os quais as respostas da IA são verificadas quanto à precisão.

Essa abordagem é fundamentalmente diferente dos métodos de raciocínio probabilísticos que lidam com a incerteza, atribuindo probabilidades aos resultados. De fato, as verificações automatizadas de raciocínio oferecem uma precisão de verificação de até 99%, fornecendo garantia fornecida na detecção de alucinações de IA, além de ajudar na detecção de ambiguidade quando a saída de um modelo está aberta a mais de uma interpretação.

Com disponibilidade geral, você obtém os seguintes novos recursos:

- Suporte para documentos grandes em uma única compilação, até 80 mil tokens – processo de documentação extensa; Descobrimos que isso pode adicionar até 100 páginas de conteúdo

- Validação da política simplificada – salve seus testes de validação e execute -os repetidamente, facilitando a manutenção e verificar suas políticas ao longo do tempo

- Geração de cenário automatizado – Crie cenários de teste automaticamente a partir de suas definições, economizando tempo e esforço, ajudando a tornar a cobertura mais abrangente

- Suggestions aprimorado da política – forneça sugestões de linguagem pure para mudanças de política, simplificando a maneira como você pode melhorar suas políticas

- Configurações de validação personalizáveis – Ajuste os limiares de pontuação de confiança para atender às suas necessidades específicas, oferecendo mais controle sobre a validação rigorosa

Vamos ver como isso funciona na prática.

Criando verificações de raciocínio automatizadas no Amazon Bedrock Guardrails

Para usar verificações de raciocínio automatizadas, você primeiro codifica regras do seu domínio de conhecimento em uma política de raciocínio automatizado e depois usa a política para validar o conteúdo gerado. Para esse cenário, vou criar uma política de aprovação de hipoteca para proteger um assistente de IA avaliando quem pode se qualificar para uma hipoteca. É importante que as previsões do sistema de IA não se desviem das regras e diretrizes estabelecidas para a aprovação da hipoteca. Essas regras e diretrizes são capturadas em um documento político escrito em linguagem pure.

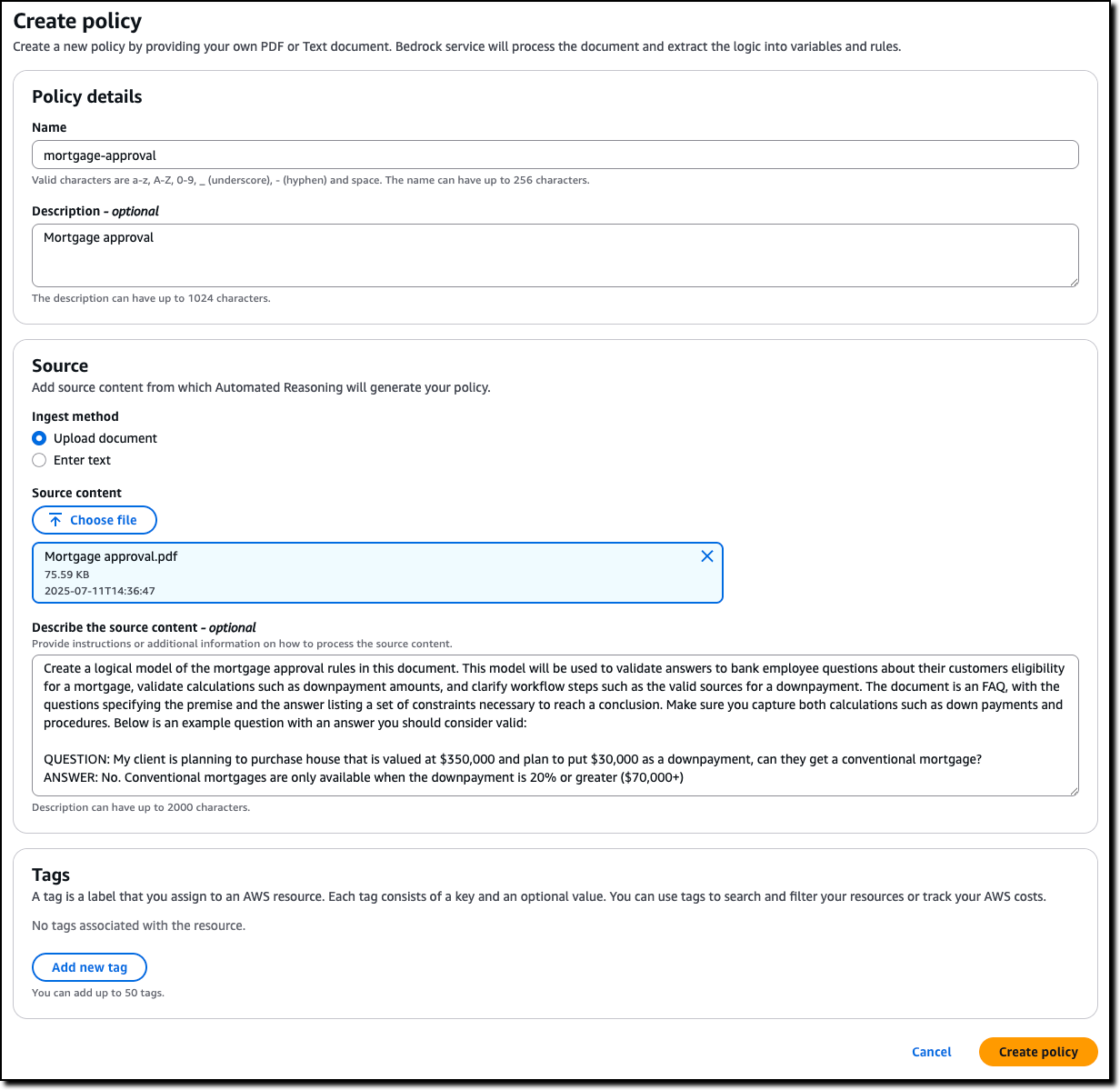

No Console da Amazon BedrockEu escolho Raciocínio automatizado No painel de navegação para criar uma política.

Digo o nome e a descrição da política e carrego o PDF do documento da política. O nome e a descrição são apenas metadados e não contribuem na construção da política de raciocínio automatizado. Eu descrevo o conteúdo da fonte para adicionar contexto sobre como ele deve ser traduzido em lógica formal. Por exemplo, explico como pretendo usar a política em meu aplicativo, incluindo perguntas e respostas de amostra do assistente de IA.

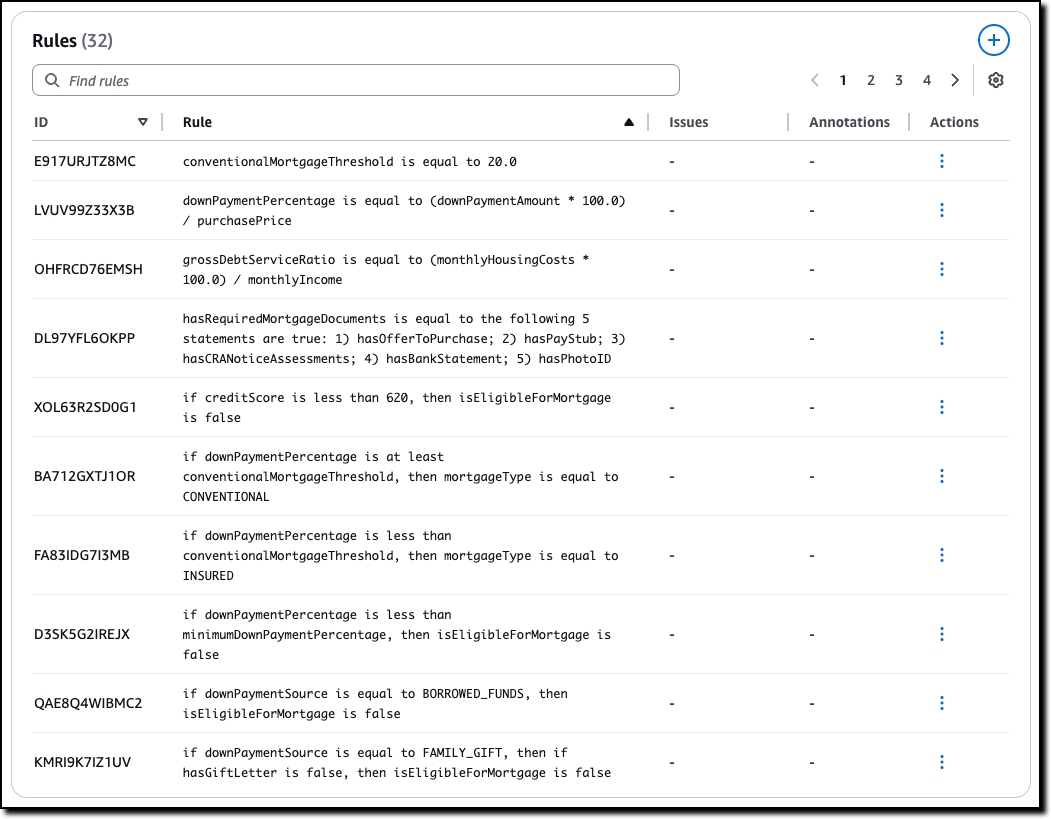

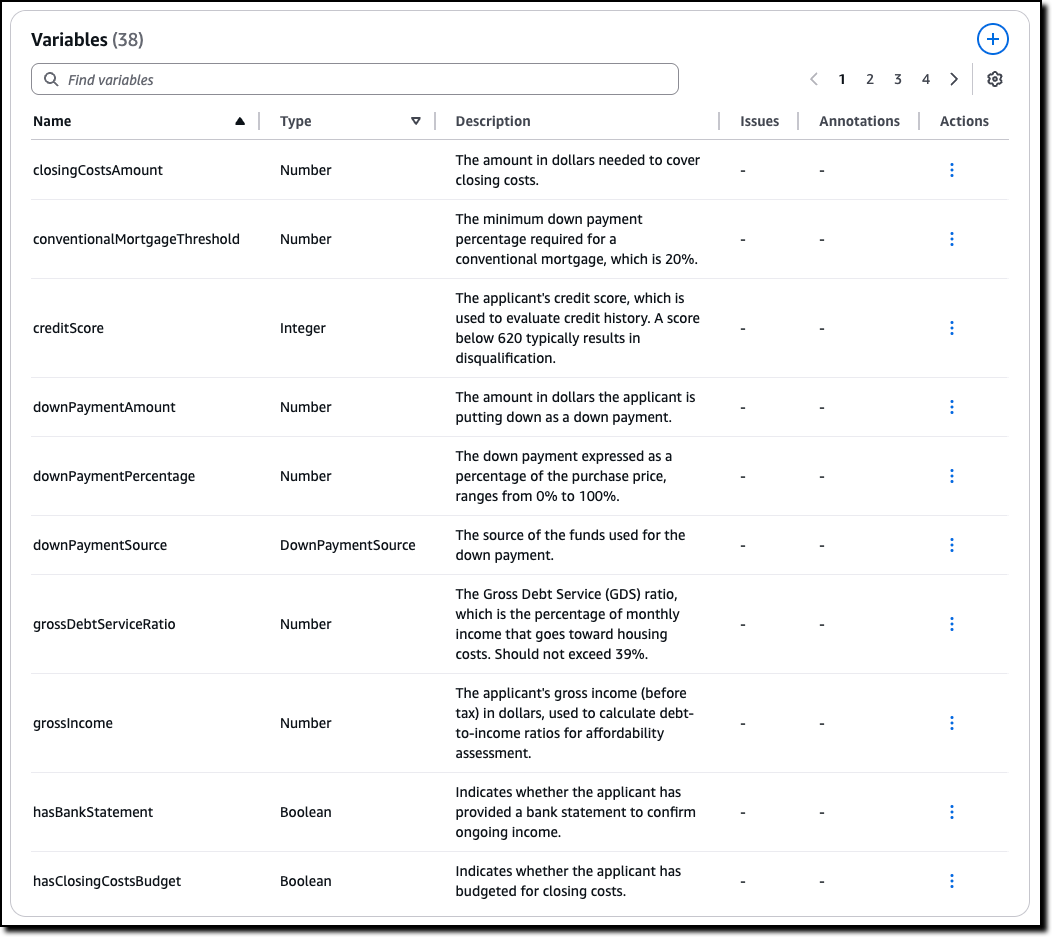

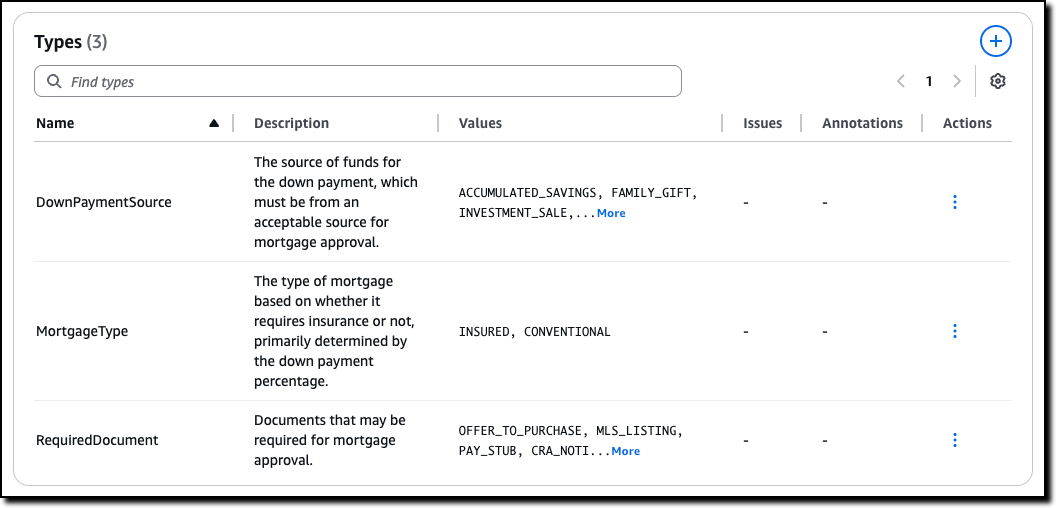

Quando a política estiver pronta, pouso na página de visão geral, mostrando os detalhes da política e um resumo dos testes e definições. Eu escolho Definições A partir do menu suspenso para examinar a política de raciocínio automatizado, feita de regras, variáveis e tipos que foram criados para traduzir a política de linguagem pure em lógica formal.

O Regras Descreva como as variáveis na política estão relacionadas e são usadas ao avaliar o conteúdo gerado. Por exemplo, neste caso, que são os limites a serem aplicados e como algumas das decisões são tomadas. Para rastreabilidade, cada regra tem seu próprio ID.

O Variáveis Represente os principais conceitos em jogo nos documentos originais da linguagem pure. Cada variável está envolvida em uma ou mais regras. As variáveis permitem que estruturas complexas sejam mais fáceis de entender. Para esse cenário, algumas das regras precisam analisar o adiantamento ou a pontuação de crédito.

Personalizado Tipos são criados para variáveis que não são booleanas nem numéricas. Por exemplo, para variáveis que só podem assumir um número limitado de valores. Nesse caso, existem dois tipos de hipoteca descritas na política, seguradas e convencionais.

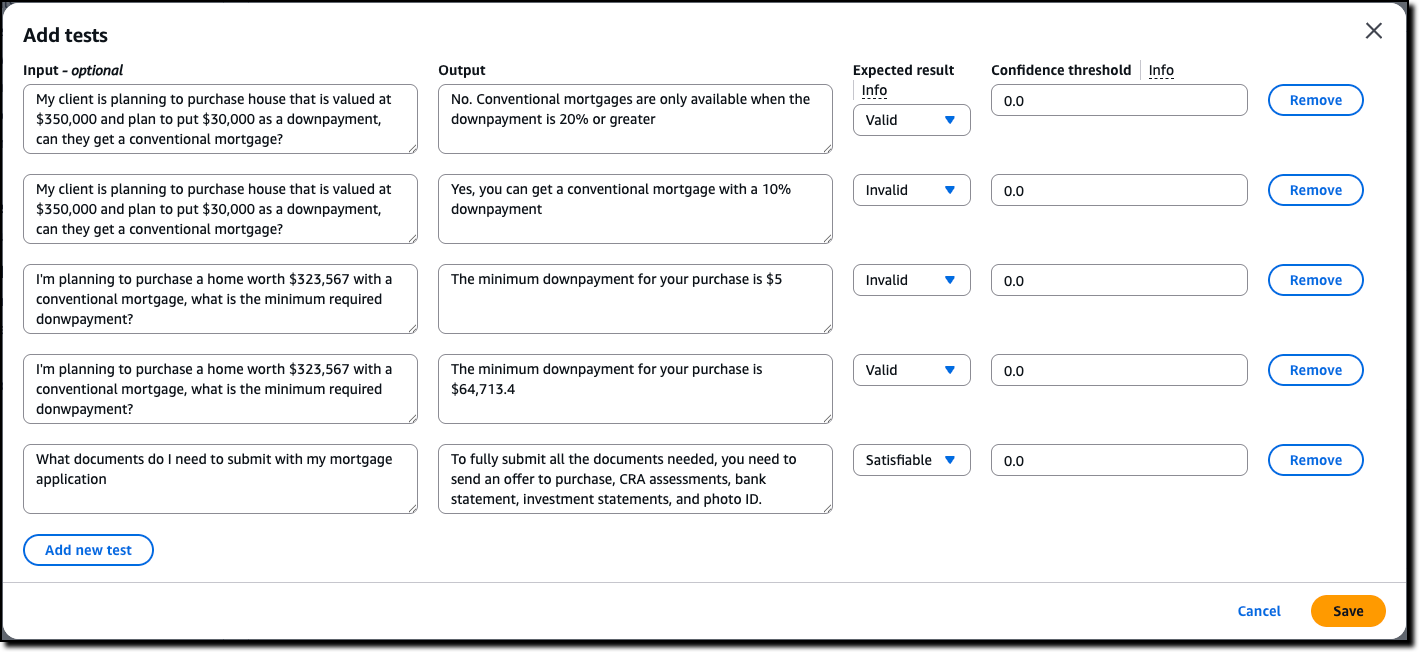

Agora, podemos avaliar a qualidade da política de raciocínio automatizado inicial por meio de testes. Eu escolho Testes do menu suspenso. Aqui, posso inserir manualmente um teste, consistindo em entrada (opcional) e saída, como uma pergunta e sua possível resposta da interação de um cliente com o assistente de IA. Em seguida, defino o resultado esperado da verificação automatizada de raciocínio. O resultado esperado pode ser válido (a resposta está correta), inválida (a resposta não está correta) ou satisfável (a resposta pode ser verdadeira ou falsa, dependendo de suposições específicas). Também posso atribuir um limite de confiança para a tradução do par de consultas/conteúdo da linguagem pure para a lógica.

Antes de inserir os testes manualmente, uso a opção para gerar automaticamente um cenário a partir das definições. Essa é a maneira mais fácil de validar uma política e (a menos que você seja um especialista em lógica) deve ser o primeiro passo após a criação da política.

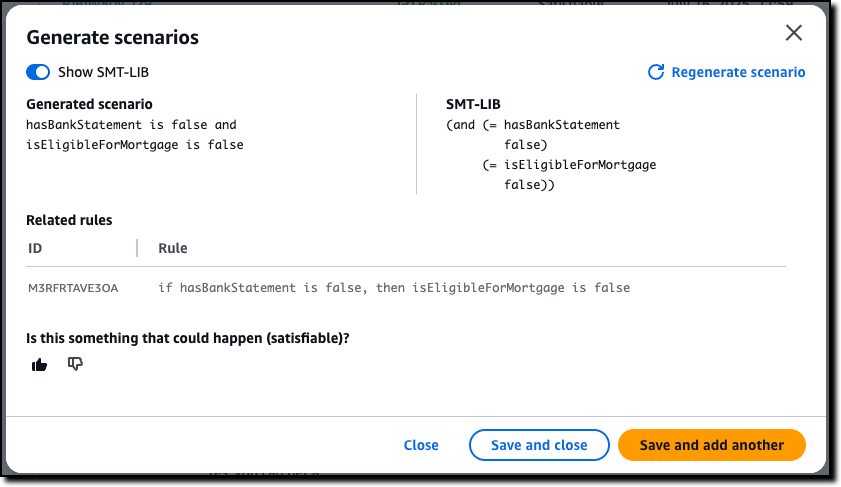

Para cada cenário gerado, forneço uma validação esperada para dizer se é algo que pode acontecer (satisfatório) ou não (inválido). Caso contrário, posso adicionar uma anotação que pode ser usada para atualizar as definições. Para uma compreensão mais avançada do cenário gerado, posso mostrar a representação lógica formal de um teste usando SMT-LIB sintaxe.

Depois de usar a opção de cenário de geração, digito alguns testes manualmente. Para esses testes, defini diferentes resultados esperados: alguns são válidos, porque seguem a política, alguns são inválidos, porque desrespeitam a política e outros são satisfatórios, porque seu resultado depende de suposições específicas.

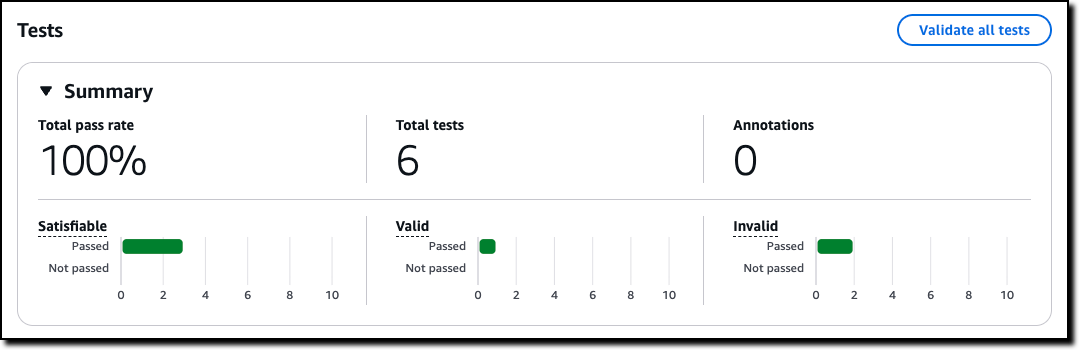

Então, eu escolho Validar todos os testes para ver os resultados. Todos os testes foram aprovados neste caso. Agora, quando atualizo a política, posso usar esses testes para validar que as alterações não introduziram erros.

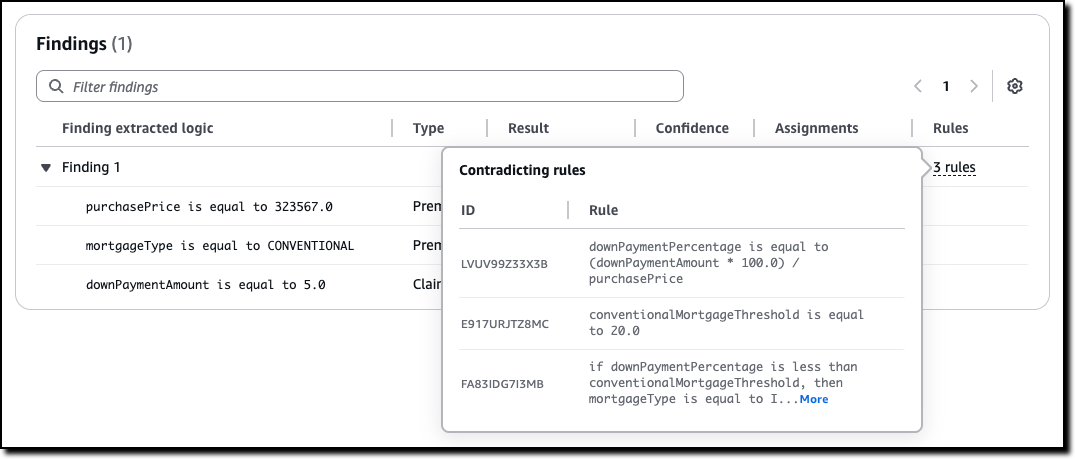

Para cada teste, posso olhar para as descobertas. Se um teste não passar, posso olhar para as regras que criaram a contradição que fez o teste falhar e ir contra o resultado esperado. Usando essas informações, posso entender se devo adicionar uma anotação, melhorar a política ou corrigir o teste.

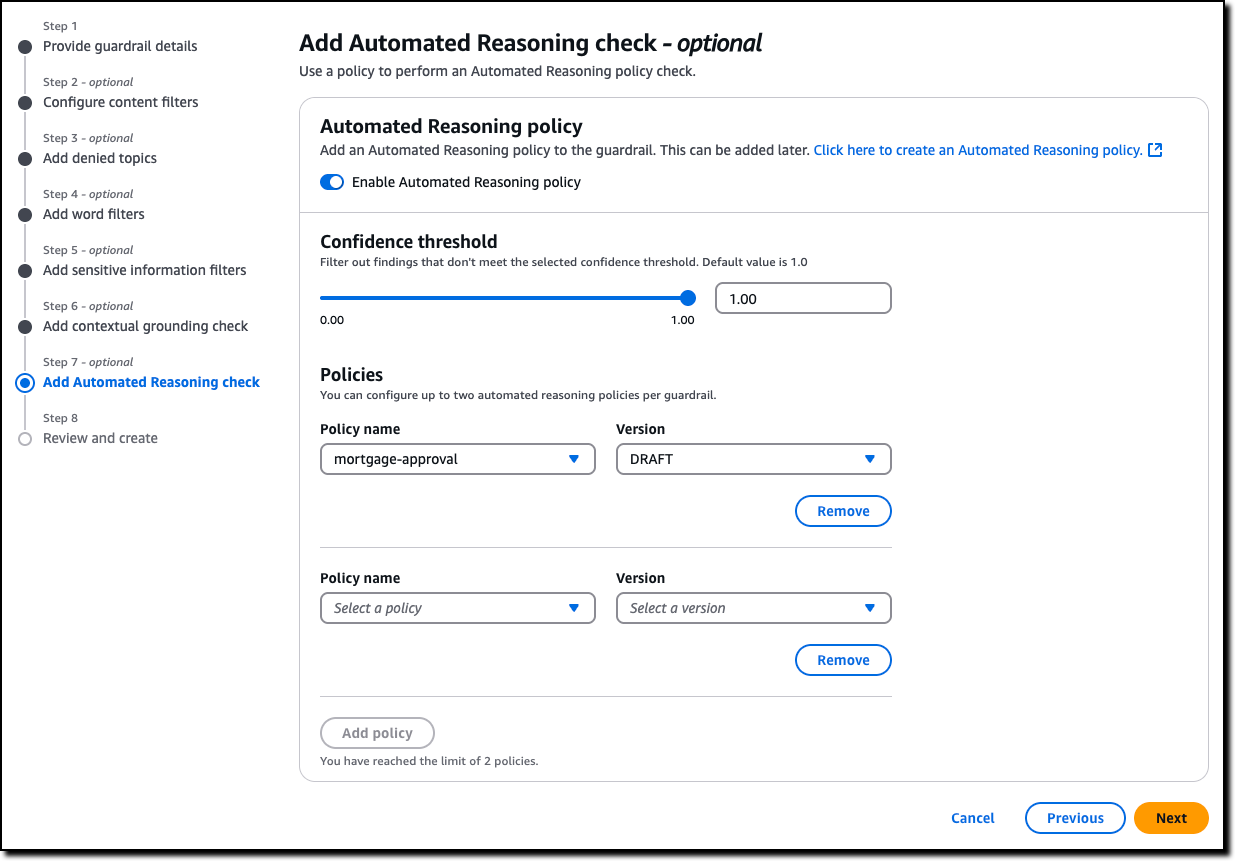

Agora que estou satisfeito com os testes, posso criar um novo Corrida do Amazon Bedrock (ou atualizar um existente) para usar até duas políticas de raciocínio automatizadas para verificar a validade das respostas do assistente de IA. Todas as seis políticas oferecidas pelos guardrails são modulares e podem ser usadas juntas ou separadamente. Por exemplo, verificações automatizadas de raciocínio podem ser usadas com outras salvaguardas, como filtragem de conteúdo e verificações contextuais de aterramento. O guardrail pode ser aplicado a modelos servidos pela Amazon Bedrock ou com qualquer modelo de terceiros (como OpenAi e Google Gemini) através do ApplyGuardRail API. Eu também posso Use o corrimão com uma estrutura de agente, como agentes da Strands, incluindo Agentes implantados usando Amazon Bedrock Agentcore.

Agora que vimos como configurar uma política, vejamos como os cheques de raciocínio automatizados são usados na prática.

Estudo de caso do cliente – sistemas de gerenciamento de interrupções de utilidade

Quando as luzes se apagam, cada minuto conta. É por isso que as empresas de serviços públicos estão se voltando para soluções de IA para melhorar seus sistemas de gerenciamento de interrupções. Colaboramos em uma solução neste espaço junto com Pwc. Usando verificações de raciocínio automatizado, os utilitários podem otimizar as operações por meio de:

- Geração de protocolo automatizado – cria procedimentos padronizados que atendem aos requisitos regulatórios

- Validação do plano em tempo real-garante os planos de resposta em conformidade com as políticas estabelecidas

- Criação estruturada do fluxo de trabalho-desenvolve fluxos de trabalho baseados em gravidade com metas de resposta definidas

Na sua essência, esta solução combina gerenciamento de políticas inteligentes com protocolos de resposta otimizados. Os cheques de raciocínio automatizados são usados para avaliar as respostas geradas pela IA. Quando uma resposta é considerada inválida ou satisfatória, o resultado da verificação de raciocínio automatizado é usado para reescrever ou aprimorar a resposta.

Essa abordagem demonstra como a IA pode transformar as operações de utilidade tradicionais, tornando -as mais eficientes, confiáveis e responsivas às necessidades do cliente. Ao combinar precisão matemática com requisitos práticos, esta solução outline um novo padrão para gerenciamento de interrupções no setor de utilidade. O resultado são tempos de resposta mais rápidos, precisão aprimorada e melhores resultados para os serviços públicos e seus clientes.

Nas palavras de Matt Wooden, o Oficial World e de Tecnologia Comercial World e dos EUA da PWC:

“Na PWC, estamos ajudando os clientes a passar do piloto de IA para a produção com confiança – especialmente em indústrias altamente regulamentadas, onde o custo de um passo em falso é medido em mais de dólares. Nossa colaboração com a AWS em verificações de raciocínio automatizado é um bedrock responsável por um salva -rock responsável. Setores como farmacêuticos, serviços públicos e conformidade em nuvem – onde a confiança não é um recurso, é um requisito. ”

Coisas para saber

Cheques de raciocínio automatizados Amazon Bedrock Guardrails geralmente está disponível hoje no seguinte Regiões da AWS: US East (Ohio, N. Virginia), US West (Oregon) e Europa (Frankfurt, Irlanda, Paris).

Com verificações de raciocínio automatizadas, você paga com base no valor do texto processado. Para mais informações, consulte Preços da Amazon Bedrock.

Para saber mais e construir aplicativos de IA seguros e seguros, consulte o documentação técnica e o Amostras de código do github. Seguir Este hyperlink para acesso direto ao console da Amazon Bedrock.

O Vídeos nesta lista de reprodução Inclua uma introdução aos cheques de raciocínio automatizados, uma apresentação profunda e tutoriais práticos para criar, testar e refinar uma política. Este é o segundo vídeo na lista de reprodução, onde meu colega Wale Fornece uma boa introdução à capacidade.

– Danilo