Os agentes são tão capazes quanto as ferramentas que você lhes dá – e apenas tão confiável quanto a governança por trás dessas ferramentas.

Esta postagem do weblog é a segunda de uma série de blogs de seis partes chamada Fábrica de agentes que compartilharão as melhores práticas, padrões de design e ferramentas para ajudar a guiá -lo através da adoção e criação de IA agêntica.

No weblog anterior, exploramos cinco padrões de design comuns de IA agêntica-do uso e reflexão da ferramenta ao planejamento, colaboração multi-agente e raciocínio adaptativo. Esses padrões mostram como os agentes podem ser estruturados para obter automação confiável e escalável em ambientes do mundo actual.

Em todo o setor, estamos vendo uma mudança clara. Experiências iniciais focadas em avisos de modelo único e fluxos de trabalho estáticos. Agora, a conversa é sobre extensibilidade– Como dar aos agentes um conjunto amplo e em evolução de recursos sem travar um fornecedor ou reescrever integrações para cada nova necessidade. As plataformas estão competindo com a rapidez com que os desenvolvedores podem:

- Integrar -se a centenas de APIs, serviços, fontes de dados e fluxos de trabalho.

- Reutilize essas integrações em diferentes equipes e ambientes de tempo de execução.

- Mantenha o controle da qualidade corporativa sobre quem pode chamar o que, quando e com quais dados.

A lição do ano passado da evolução da IA agêntica é simples: Os agentes são tão capazes quanto as ferramentas que você dá – e apenas tão confiável quanto a governança por trás dessas ferramentas.

Extensibilidade através de padrões abertos

Nos estágios iniciais do desenvolvimento do agente, a integração de ferramentas period frequentemente um esforço sob medida e específico da plataforma. Cada estrutura tinha suas próprias convenções para definir ferramentas, passar dados e manusear a autenticação. Isso criou vários bloqueadores consistentes:

- Duplicação do esforço– A mesma API interna teve que ser embrulhada de maneira diferente para cada tempo de execução.

- Integrações quebradiças– Salte mudanças nos esquemas ou pontos de extremidade podem quebrar vários agentes de uma só vez.

- Reutilização limitada– As ferramentas construídas para uma equipe ou ambiente eram difíceis de compartilhar em projetos ou nuvens.

- Governança fragmentada– Os tempos de execução diferentes aplicaram diferentes modelos de segurança e políticas.

À medida que as organizações começaram a implantar agentes em ambientes híbridos e de várias nuvens, essas ineficiências se tornaram grandes obstáculos. As equipes precisavam de uma maneira de padronize como as ferramentas são descritas, descobertas e invocadas, independentemente do ambiente de hospedagem.

É aí que protocolos abertos entrou na conversa. Assim como o HTTP transformou a Internet criando um idioma comum para clientes e servidores, os protocolos abertos para agentes visam tornar as ferramentas portáteis, interoperáveis e mais fáceis de governar.

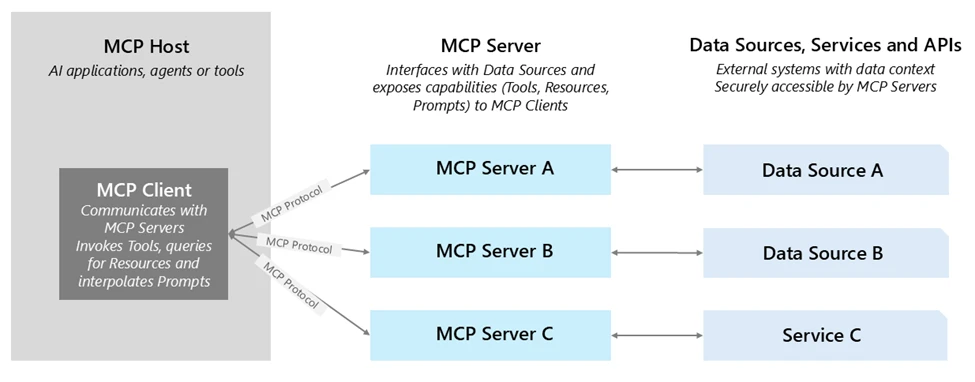

Um dos exemplos mais promissores é o Modelo Protocolo de Contexto (MCP)-Um padrão para definir recursos da ferramenta e esquemas de E/S para que qualquer agente compatível com MCP possa descobri-los dinamicamente e invocá-los. Com MCP:

- Ferramentas são auto-descriçãotornando a descoberta e a integração mais rapidamente.

- Agentes podem Encontre e use ferramentas em tempo de execução sem fiação guide.

- As ferramentas podem ser hospedado em qualquer lugar-Em vez, em uma nuvem de parceiros, ou em outra unidade de negócios-sem perder a governança.

A Azure AI Foundry suporta o MCP, permitindo que você traga servidores MCP existentes diretamente para seus agentes. Isso oferece os benefícios da interoperabilidade aberta mais Segurança, observabilidade e gerenciamento de nível corporativo. Saiba mais sobre o MCP em MCP Dev Days.

Depois de ter um padrão para portabilidade por meio de protocolos abertos como o MCP, a próxima pergunta se torna: Que tipos de ferramentas seus agentes devem ter e como você os organiza para que eles possam agregar valor rapidamente enquanto permanecem adaptáveis?

Na Azure AI Foundry, pensamos nisso como construindo um Chain de ferramentas corporativo– um conjunto de capacidades em camadas que se equilibram velocidade (recebendo algo valioso correndo hoje), diferenciação (captura o que torna sua empresa única) e alcançar (Conectando todos os sistemas onde o trabalho realmente acontece).

1. Ferramentas internas para valor rápido: Azure AI Foundry inclui Ferramentas prontas para uso Para necessidades de empresas comuns: pesquisando no SharePoint e no Knowledge Lake, executando o Python para análise de dados, realizando pesquisas na Internet em várias etapas com o Bing e desencadeando tarefas de automação do navegador. Essas não são apenas conveniências-eles permitem que as equipes se destacem agentes funcionais e de alto valor em dias, em vez de semanas, sem o atrito do trabalho de integração precoce.

2. Ferramentas personalizadas para sua vantagem competitiva: Toda organização possui sistemas e processos proprietários que não podem ser replicados por ferramentas prontas para uso. A Azure AI Foundry torna simples envolvê -las como ferramentas de IA agênticas – se elas são APIs do seu ERP, um sistema de controle de qualidade de fabricação ou serviço de um parceiro. Ao invocá -los através do OpenAPI ou MCP, essas ferramentas se tornam portáteis e descobertas entre equipes, projetos e até nuvens, enquanto ainda se beneficiava da identidade, políticas e camadas de observabilidade de Foundry.

3. Conectores para alcance máximo: Através Aplicativos lógicos do AzureA fundição pode conectar agentes a mais de 1.400 sistemas de SaaS e local-CRM, ERP, ITSM, Knowledge Warehouses e muito mais. Isso reduz drasticamente o elevador de integração, permitindo que você se conecte aos processos corporativos existentes sem criar todos os conectores a partir do zero.

Um exemplo desta cadeia de ferramentas em ação vem de Dados da NTTque construiu agentes na Fundição do Azure AI que integram Microsoft Material Knowledge Agent juntamente com outras ferramentas corporativas. Esses agentes permitem que os funcionários em toda a RH, operações e outras funções interajam naturalmente com dados-revelando insights em tempo actual e permitindo ações-reduzindo o tempo de mercado por 50% e dar aos usuários não técnicos acesso intuitivo e de autoatendimento à inteligência corporativa.

A extensibilidade deve ser combinada com a governança para passar do protótipo para a automação pronta para a empresa. A Foundry Azure AI aborda isso com um Seguro por defesa Abordagem para gerenciamento de ferramentas:

- Autenticação e identidade em conectores embutidos: Os conectores de nível corporativo-como o SharePoint e o Microsoft Material-usam a autenticação no meio de behald-of (OBO). Quando um agente chama essas ferramentas, a fundição garante que a chamada respeite as permissões do usuário ultimate por meio de IDs da ENTRA gerenciada, preservando as regras de autorização existentes. Com ID do agente da Microsoft ENTRAtodo projeto Agentic criado em Azure AI Foundry Aparece automaticamente em uma visualização de aplicativo específica do agente no Microsoft ENTRA Admin Heart. Isso fornece às equipes de segurança uma visão de diretório unificada de todos os agentes e aplicativos de agentes que precisam gerenciar em toda a Microsoft. Essa integração marca o primeiro passo para padronizar a governança para a empresa de agentes de IA em toda a empresa. Enquanto o ID da ENTRA é nativo, o Azure AI Foundry também suporta integrações com sistemas de identidade externos. Através da Federação, os clientes que usam fornecedores como Okta ou Google Id ainda podem autenticar agentes e usuários para chamar as ferramentas com segurança.

- Ferramentas personalizadas com OpenAPI e MCP: As ferramentas especificadas pelo OpenAPI permitem conectividade perfeita usando identidades gerenciadas, chaves da API ou acesso não autenticado. Essas ferramentas podem ser registradas diretamente na fundição e se alinhar com as melhores práticas de design da API padrão. A Foundry também está expandindo a segurança do MCP para incluir credenciais armazenadas, identidades gerenciadas no nível do projeto e fluxos de OAuth de terceiros, juntamente com redes privadas seguras-avançando em direção a um modelo de integração MCP de ponta a ponta e de ponta.

- Governança da API com gerenciamento de API do Azure (APIM): O APIM fornece um poderoso plano de controle para gerenciar chamadas de ferramentas: permite publicação centralizada, aplicação de políticas (autenticação, limites de taxa, validação por carga útil) e monitoramento. Além disso, você pode implantar Gateways auto-hospedados Dentro de VNets ou ambientes no native para aplicar as políticas corporativas próximas aos sistemas de back-end. Complementando isso, Centro de API do Azure Atua como um hub centralizado de inventário de API e descoberta de tempo de design-permitindo que as equipes se registrem, catalogem e gerenciem servidores MCP privados ao lado de outras APIs. Esses recursos fornecem a mesma governança que você espera para as suas APIs – estendidas para as ferramentas Agentic AI sem engenharia adicional.

- Observabilidade e auditabilidade: Toda invocação de ferramentas na fundição – seja interna ou externa – é rastreado com registro de nível de passo. Isso inclui identidade, nome da ferramenta, entradas, saídas e resultados, permitindo monitoramento contínuo de confiabilidade e auditoria simplificada.

O gerenciamento da qualidade corporativa garante que as ferramentas sejam seguras e observáveis-mas o sucesso também depende de como você as projeta e opera desde o primeiro dia. Com base na orientação do Azure AI Foundry e na experiência do cliente, alguns princípios se destacam:

- Comece com o contrato. Trate todas as ferramentas como um produto da API. Defina entradas claras, saídas e comportamentos de erro e mantenha os esquemas consistentes entre as equipes. Evite sobrecarregar uma única ferramenta com várias ações não relacionadas; As ferramentas menores e de fins únicas são mais fáceis de testar, monitorar e reutilizar.

- Escolha a embalagem certa. Para APIs proprietárias, decida cedo se o OpenAPI ou o MCP melhor atende às suas necessidades. As ferramentas OpenAPI são diretas para as APIs de repouso bem documentadas, enquanto as ferramentas do MCP se destacam quando a portabilidade e a reutilização entre o ambiente são prioridades.

- Centralize a governança. Publique ferramentas personalizadas por trás do gerenciamento da API do Azure ou de um gateway auto-hospedado, de modo que a autenticação, a limitação e a inspeção da carga útil são aplicadas de forma consistente. Isso mantém a lógica da política fora do código da ferramenta e facilita o lançamento das alterações.

- Vincular todas as ações à identidade. Sempre saiba qual usuário ou agente está invocando a ferramenta. Para conectores embutidos, alavancam a passagem de identidade ou OBO. Para ferramentas personalizadas, use o ID da ENTRA ou o modelo de chave/credencial da API apropriado e aplique acesso mínimo-privilegiado.

- Instrumento cedo. Adicione os ganchos de rastreamento, log e avaliação antes de passar para a produção. A observabilidade precoce permite rastrear tendências de desempenho, detectar regressões e ajustar ferramentas sem tempo de inatividade.

Seguir essas práticas garante que as ferramentas que você integra hoje permaneçam seguras, portáteis e sustentáveis à medida que o ecossistema do seu agente cresce.

O que vem a seguir

Na parte três do Fábrica de agentes sérievamos nos concentrar em observabilidade para agentes de IA– Como rastrear todas as etapas, avaliar o desempenho da ferramenta e monitorar o comportamento do agente em tempo actual. Abordaremos os recursos internos na Fundição do Azure AI, padrões de integração com o Azure Monitor e as melhores práticas para transformar a telemetria em melhorias contínuas.

Você perdeu o primeiro put up da série? Confira: A nova period de IA agêntica – casos de uso comum e padrões de design.