Um robô Humanóide Tesla Optimus atravessa uma fábrica com as pessoas. O comportamento previsível do robô requer controle prioritário e uma estrutura authorized. Crédito: Tesla

Os robôs estão se tornando mais inteligentes e previsíveis. O Tesla Optimus levanta caixas em uma fábrica, a Figura 01 derrama café e Waymo carrega passageiros sem motorista. Essas tecnologias não são mais demonstrações; Eles estão cada vez mais entrando no mundo actual.

Mas com isso vem a pergunta central: como podemos garantir que um robô tome a decisão certa em uma situação complexa? O que acontece se recebe dois comandos conflitantes de pessoas diferentes ao mesmo tempo? E como podemos ter certeza de que não violará as regras básicas de segurança – mesmo a pedido de seu proprietário?

Por que os sistemas convencionais falham? A maioria dos robôs modernos opera em scripts predefinidos – um conjunto de comandos e um conjunto de reações. Em termos de engenharia, essas são árvores de comportamento, máquinas de estado finito ou, às vezes, aprendizado de máquina. Essas abordagens funcionam bem em condições controladas, mas os comandos no mundo actual podem se contradizer.

Além disso, os ambientes podem mudar mais rápido que o robô pode se adaptar, e não há um “mapa prioritário” claro do que importa aqui e agora. Como resultado, o sistema pode hesitar ou escolher o cenário errado. No caso de um carro autônomo ou a humanóide robô, uma hesitação tão previsível não é mais apenas um erro – é um segurança risco.

Da reatividade ao controle baseado em prioridade

Hoje, a maioria dos sistemas autônomos é reativa – eles respondem a eventos e comandos externos como se fossem igualmente importantes. O robô recebe um sinal, recupera um cenário correspondente da memória e o executa, sem considerar como ele se encaixa em um objetivo maior.

Como resultado, comandos e eventos previsíveis competem no mesmo nível de prioridade. As tarefas de longo prazo são facilmente interrompidas por estímulos imediatos e, em um ambiente complexo, o robô pode agitar, tentando satisfazer todos os sinal de entrada.

Além de tais problemas na operação de rotina, sempre há o risco de falhas técnicas. Por exemplo, durante o primeiro Jogos mundiais de robôs humanóides Em Pequim este mês, o robô H1 de Unitree desviado de seu caminho perfect e derrubou um participante humano no chão.

Um caso semelhante ocorreu no início da China: durante o trabalho de manutenção, um robô começou de repente se debatendo caoticamente, atingindo engenheiros até que fosse desconectado do poder.

https://www.youtube.com/watch?v=rb8plfmbl2s

Ambos os incidentes demonstram claramente que os sistemas autônomos modernos geralmente reagem sem analisar as consequências. Na ausência de priorização contextual, mesmo uma falha técnica trivial pode se transformar em uma situação perigosa.

Arquiteturas sem lógica interna para prioridades de segurança e gerenciamento de interagir com assuntos-como seres humanos, robôs e objetos-não oferecem proteção contra esses cenários.

Minha equipe projetou uma arquitetura para transformar o comportamento de um modo de “resposta a estímulo” em escolha deliberada. Cada evento passa pela primeira vez através de filtros de missão e sujeito, é avaliado no contexto do meio ambiente e das consequências e só depois passa para a execução. Isso permite que os robôs atuem previsivelmente, de forma consistente e segura – mesmo em condições dinâmicas e imprevisíveis.

Duas hierarquias: prioridades em ação

Projetamos uma arquitetura de controle que aborda diretamente a robótica e a reatividade previsíveis. Na sua essência, há duas hierarquias interligadas.

1. Hierarquia da missão – Um sistema estruturado de prioridades de metas:

- Missões estratégicas – basic e imutável: “Não prejudique um humano”, “ajude os seres humanos”, “obedecem às regras”.

- Missões de usuário – tarefas definidas pelo proprietário ou operador

- Missões atuais – tarefas secundárias que podem ser interrompidas para as mais importantes

2. Hierarquia de assuntos de interação – A priorização de comandos e interações, dependendo da fonte:

- Maior prioridade – proprietário, administrador, operador

- Secundário – usuários autorizados, como familiares, funcionários ou robôs designados

- Partes externas – outras pessoas, animais ou robôs que são considerados em análise in situacional, mas não podem controlar o sistema

Como o controle previsível funciona na prática

Caso 1. Robô Humanóide – Um robô está carregando peças em uma linha de montagem. Uma criança de um grupo de turismo visitante pede para entregar uma ferramenta pesada. A solicitação vem de uma parte externa. A missão é potencialmente insegura e não faz parte das tarefas atuais.

- Decisão: ignore o comando e proceed o trabalho.

- Resultado: A criança e o processo de produção permanecem seguros.

Caso 2. Carro autônomo – Um passageiro pede para acelerar para evitar estar atrasado. Sensores detectam gelo na estrada. A solicitação vem de um assunto de alta prioridade. Mas a missão estratégica “garantir a segurança” supera a conveniência.

- Decisão: o carro não aumenta a velocidade e recalcula a rota.

- Resultado: a segurança tem prioridade absoluta, mesmo que inconveniente para o usuário.

Três filtros de tomada de decisão previsível

Todo comando passa por três níveis de verificação:

- Contexto – Meio ambiente, estado de robô, história do evento

- Criticidade – Quão perigoso seria a ação

- Consequências – O que mudará se o comando for executado ou recusado

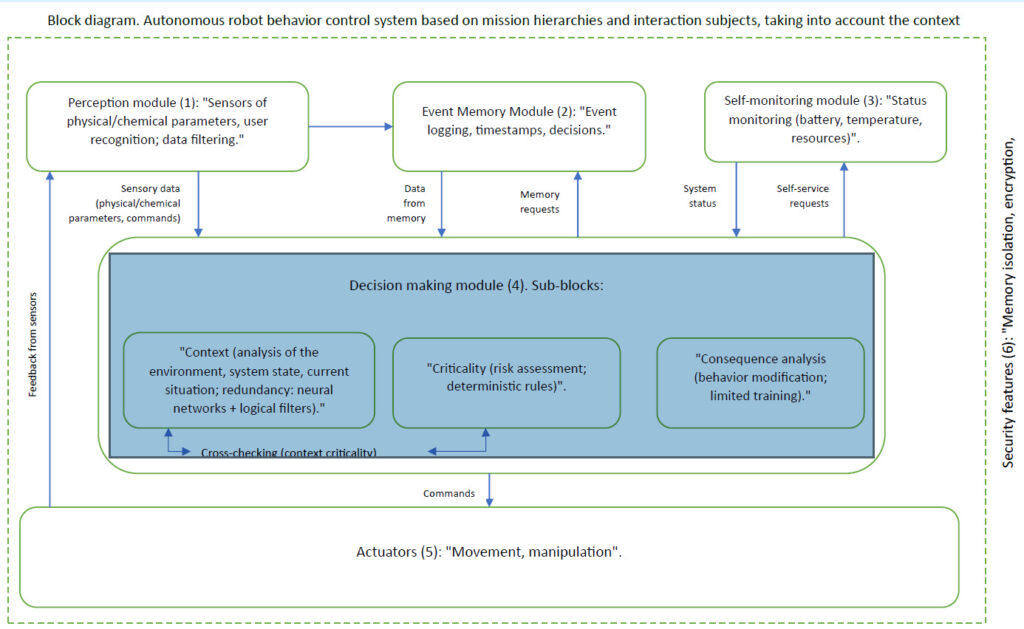

Se algum filtro acertar um alarme, a decisão será reconsiderada. Tecnicamente, a arquitetura é implementada de acordo com o diagrama de blocos abaixo:

Uma arquitetura de controle para abordar a reatividade do robô. (Clique aqui para ampliar.) Fonte: Zhengis Tileubay

Aspecto authorized: standing de autônomo neutro

Fomos além da arquitetura técnica e propomos um novo modelo authorized. Para um entendimento preciso, deve ser descrito na linguagem authorized formal. “Standing-autônomo neutro” de Ai E os sistemas autônomos movidos a IA são uma categoria legalmente reconhecida na qual esses sistemas não são considerados objetos de responsabilidade authorized tradicional, como ferramentas, nem como sujeitos da lei, como pessoas naturais ou legais.

Esse standing apresenta uma nova categoria authorized que elimina a incerteza no regulamento da IA e evita abordagens extremas para definir sua natureza authorized. Os sistemas jurídicos modernos operam com duas categorias principais:

- Assuntos da lei – Pessoas naturais e legais com direitos e obrigações

- Objetos da lei – Coisas, ferramentas, propriedades e ativos intangíveis controlados pelos sujeitos

AI e sistemas autônomos não se encaixam em nenhuma das categorias. Se considerados objetos, toda a responsabilidade cai inteiramente sobre desenvolvedores e proprietários, expondo -os a riscos legais excessivos. Se considerados sujeitos, eles enfrentam um problema basic: falta de capacidade authorized, intenção e capacidade de assumir obrigações.

Assim, é necessária uma terceira categoria para estabelecer uma estrutura equilibrada de responsabilidade e responsabilidade-status autônomo neutro.

Mecanismos legais de standing autônomo neutro

O princípio central é que cada IA ou sistema autônomo deve ser atribuído missões claramente definidas que definem seu objetivo, escopo de autonomia e estrutura authorized de responsabilidade. As missões servem como um limite authorized que limita as ações da IA e determina a distribuição de responsabilidades.

Os tribunais e os reguladores devem avaliar o comportamento de sistemas autônomos com base em suas missões designadas, garantindo a responsabilidade estruturada. Desenvolvedores e proprietários são responsáveis apenas nas missões atribuídas. Se o sistema agir fora deles, a responsabilidade é determinada pelas circunstâncias específicas do desvio.

Os usuários que exploram intencionalmente os sistemas além de suas tarefas designadas podem enfrentar maior responsabilidade.

Nos casos de comportamento imprevisto, quando as ações permanecem dentro das missões atribuídas, um mecanismo de responsabilidade atenuada se aplica. Desenvolvedores e proprietários são protegidos de complete responsabilidade se o sistema operar dentro de seus parâmetros e missões definidas. Os usuários se beneficiam da responsabilidade atenuada se usassem o sistema de boa fé e não contribuíssem para a anomalia.

Exemplo hipotético

Um veículo autônomo atinge um pedestre que de repente corre para a estrada do lado de fora de uma faixa de pedestres. As missões do sistema: “Garanta a entrega segura de passageiros sob leis de trânsito” e “evite colisões dentro das capacidades técnicas do sistema”, detectando a distância suficiente para uma frenagem segura.

Uma parte ferida exige US $ 10 milhões do fabricante de carros autônomos.

Cenário 1: conformidade com missões. O pedestre apareceu 11 m à frente (0,5 segundos a 80 km/h ou 50 mph) – uma distância de frenagem segura de cerca de 40 m (131,2 pés). O carro começou a frear, mas não conseguiu parar a tempo. O tribunal governa que o montadora estava dentro da conformidade da missão, por isso reduziu a responsabilidade para US $ 500.000, com falha parcial atribuída ao pedestre. Poupança: US $ 9,5 milhões.

Cenário 2: Erro de calibração da missão. À noite, devido a um erro de calibração da câmera, o carro classificou incorretamente o pedestre como um objeto estático, atrasando a frenagem em 0,3 segundos. Desta vez, a montadora é responsável por inconfiguração – US $ 5 milhões, mas não US $ 10 milhões, graças à definição de standing.

Cenário 3: violação da missão pelo usuário. O proprietário direcionou o carro para uma zona de construção proibida, ignorando avisos. A responsabilidade complete de US $ 10 milhões cai sobre o proprietário. A empresa autônoma de veículos é protegida desde que as missões foram violadas.

Este exemplo mostra como o standing de autônomo neutro auto-autônomo estrutura a responsabilidade, protegendo desenvolvedores e usuários, dependendo das circunstâncias.

O standing de autônomo neutro oferece negócios, benefícios regulatórios

Com a implementação do standing autônomo neutro, os riscos legais são reduzidos. Os desenvolvedores estão protegidos contra processos injustificados vinculados ao comportamento do sistema, e os usuários podem confiar em estruturas de responsabilidade previsíveis.

Os reguladores ganhariam uma base authorized estruturada, reduzindo a inconsistência nas decisões. As disputas legais envolvendo a IA passariam do precedente arbitrário para uma estrutura unificada. Um novo sistema de classificação para níveis de autonomia da IA e complexidade da missão poderia surgir.

As empresas que adotam standing neutro cedo podem diminuir os riscos legais e gerenciar os sistemas de IA com mais eficiência. Os desenvolvedores ganhariam maior liberdade para testar e implantar sistemas em parâmetros reconhecidos legalmente. As empresas podem se posicionar como líderes éticos, melhorando a reputação e a competitividade.

Além disso, os governos obteriam uma ferramenta regulatória equilibrada, mantendo a inovação e protegendo a sociedade.

https://www.youtube.com/watch?v=lrrtw16gale

Por que o comportamento previsível do robô é importante

Estamos no limiar de implantação em massa de robôs humanóides e veículos autônomos. Se não conseguirmos estabelecer fundações técnicas e legais robustas hoje, amanhã, os riscos poderão superar os benefícios – e a confiança do público na robótica poderá ser prejudicada.

Uma arquitetura construída sobre hierarquias de missão e sujeito, combinada com o standing de autônoma neutro, é a base sobre a qual a próxima etapa da robótica previsível pode ser desenvolvida com segurança.

Essa arquitetura já foi descrita em um pedido de patente. Estamos prontos para colaborações piloto com fabricantes de robôs humanóides, veículos autônomos e outros sistemas autônomos.

Nota do editor: Robobusiness 2025, que será nos dias 15 e 16 de outubro em Santa Clara, Califórnia, contará com faixas de sessão sobre IA física, permitindo tecnologias, humanóides, robôs de campo, design e desenvolvimento e práticas recomendadas de negócios. As inscrições estão agora abertas.

Sobre o autor

Zhengis Tileubay é um pesquisador independente da República do Cazaquistão, trabalhando em questões relacionadas à interação entre humanos, sistemas autônomos e inteligência synthetic. Seu trabalho está focado no desenvolvimento de arquiteturas seguras para o controle de comportamento do robô e propondo novas abordagens legais ao standing das tecnologias autônomas.

No decorrer de sua pesquisa, Tileubay desenvolveu uma arquitetura de controle de comportamento baseada em uma hierarquia de missões e assuntos que interagem. Ele também propôs o conceito de “standing autônomo neutro”.

A Tileubay apresentou um pedido de patente para essa arquitetura intitulada “Sistema de Controle de Comportamento de Robôs Autônomo com base nas hierarquias de missões e assuntos de interação, com conscientização do contexto” com o Escritório de Patentes da República do Cazaquistão.