As organizações gerenciam o conteúdo em vários idiomas à medida que expandem globalmente. Plataformas de comércio eletrônico, sistemas de suporte ao cliente e bases de conhecimento exigem recursos de pesquisa multilíngues eficientes para atender a diversas bases de usuários de maneira eficaz. Essa abordagem de pesquisa unificada ajuda as organizações multinacionais a manter os repositórios centralizados de conteúdo, ao mesmo tempo em que os usuários, independentemente de seu idioma preferido, podem efetivamente encontrar e acessar informações relevantes.

A criação de aplicativos de múltiplas linguagens usando analisadores de idiomas com o OpenSearch geralmente envolve um desafio significativo: os documentos de múltiplas linguagens requerem pré-processamento guide. Isso significa que, em seu aplicativo, para cada documento, você deve primeiro identificar o idioma de cada campo e depois categorizá-lo e rotulá-lo, armazenando conteúdo em campos de linguagem separados e predefinidos (por exemplo, name_en, name_es, e assim por diante) para usar Analisadores de idiomas na pesquisa para melhorar a relevância da pesquisa. Esse esforço do lado do cliente é complexo, adicionando carga de trabalho para detecção de idiomas, potencialmente diminuindo a ingestão de dados e o risco de problemas de precisão se os idiomas forem identificados incorretamente. É uma abordagem trabalhosa. No entanto, Amazon OpenSearch Service 2.15+ apresenta um baseado em IA ML Processador de inferência. Esse novo recurso identifica e tags automaticamente documenta linguagens durante a ingestão, simplificando o processo e removendo a carga do seu aplicativo.

Ao aproveitar o poder da IA e usar a modelagem de dados com conhecimento de contexto e a seleção inteligente de analisadores, esta solução automatizada simplifica o processamento de documentos, minimizando a marcação guide de idiomas e permite a detecção automática de linguagem durante a ingestão, fornecendo às organizações recursos sofisticados de pesquisa multilíngue.

Usando a identificação do idioma no serviço OpenEarch oferece os seguintes benefícios:

- Experiência aprimorada do usuário – Os usuários agora podem encontrar conteúdo relevante, independentemente do idioma em que pesquisam

- Aumento da descoberta de conteúdo – O serviço pode aparecer no conteúdo valioso entre os silos de linguagem

- Precisão de pesquisa aprimorada -Analisadores específicos para o idioma fornecem melhor relevância da pesquisa

- Processamento automatizado – Você pode reduzir a marcação e a classificação manuais de idiomas

Nesta postagem, compartilhamos como implementar uma solução de pesquisa multilíngue escalável usando o OpenEarch Service.

Visão geral da solução

A solução elimina o pré -processamento guide da linguagem, detectando e lidando automaticamente o conteúdo multilíngue durante a ingestão de documentos. Em vez de criar manualmente campos de linguagem separados (en_notes, es_notes and so on.) ou implementar sistemas de detecção de linguagem personalizados, o processador de inferência de ML identifica idiomas e cria mapeamentos de campo apropriados.

Essa abordagem automatizada melhora a precisão em comparação com os métodos manuais tradicionais e reduz a complexidade do desenvolvimento e o processamento da sobrecarga, permitindo que as organizações se concentrem em oferecer melhores experiências de pesquisa a seus usuários globais.

A solução compreende os seguintes componentes principais:

- ML Processador de inferência – Invoca os modelos ML durante a ingestão de documentos para enriquecer o conteúdo com metadados da linguagem

- Integração da Amazon Sagemaker -Hosts Modelos de identificação de idiomas pré-treinados que analisam campos de texto e devolvem previsões de linguagem

- Indexação específica do idioma – Aplica analisadores apropriados com base em idiomas detectados, fornecendo manuseio adequado de Stemming, Cease Phrases e Normalização do personagem

- Estrutura do conector – Permite a comunicação segura entre o OpenEarch Service e Amazon Sagemaker pontos de extremidade através AWS Identification and Entry Administration (IAM) Autenticação baseada em papéis.

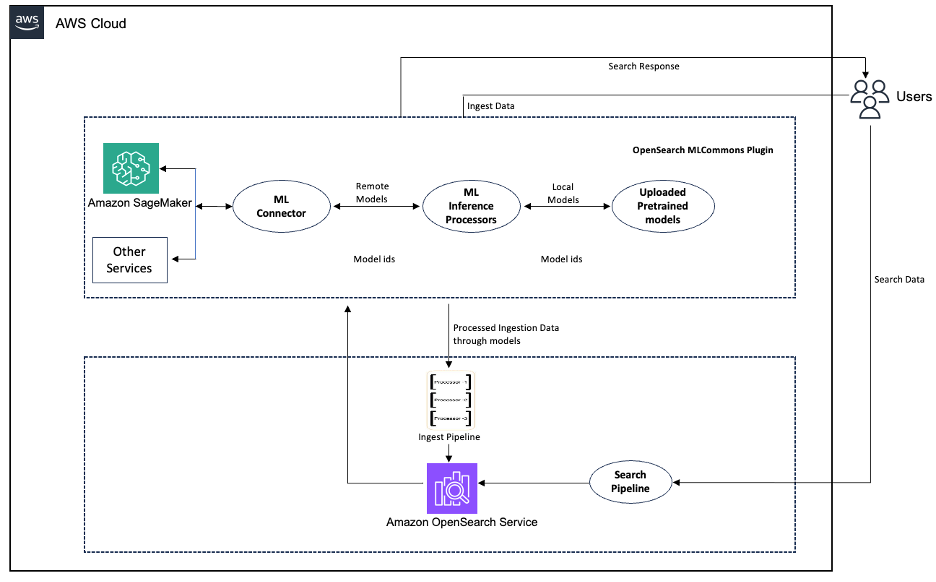

O diagrama a seguir ilustra o fluxo de trabalho do pipeline de detecção de idiomas.

Figura 1: Fluxo de trabalho do pipeline de detecção de idiomas

Este exemplo demonstra classificação de texto usando XLM-ROBERTA-BASE Para detecção de idiomas no Amazon Sagemaker. Você tem flexibilidade na escolha de seus modelos e pode usar alternativamente o Capacidades de detecção de idioma interno de Amazon compreende.

Nas seções a seguir, caminhamos pelas etapas para implantar a solução. Para obter instruções detalhadas de implementação, incluindo exemplos de código e modelos de configuração, consulte o tutorial abrangente no OpenEarch ML Commons Github Repository.

Pré -requisitos

Você deve ter os seguintes pré -requisitos:

Implantar o modelo

Implantar um idioma pré-treinado Modelo de identificação no Amazon Sagemaker. O modelo XLM-Roberta fornece recursos robustos de detecção de linguagem multilíngue adequados para a maioria dos casos de uso.

Configure o conector

Crie um Conector ML Para estabelecer uma conexão segura entre o OpenEarch Service e o Amazon Sagemaker Endpoints, principalmente para tarefas de detecção de idiomas. O processo começa com a criação de autenticação através Papéis e políticas do IAMaplicando permissões adequadas para os dois serviços se comunicarem com segurança.

Depois de configurar o conector com os URLs e credenciais apropriados do ponto de extremidade, o modelo é registrado e implantado no serviço de opensearch e seu ModelId é usado nas etapas subsequentes.

Resposta da amostra:

Depois de configurar o conector, você pode testar é por enviando texto Para o modelo através do serviço OpenEarch e retornará o idioma detectado (por exemplo, enviar “Diga que este é um teste” retorna EN para o inglês).

Configure o pipeline de ingestão

Configure o pipeline de ingestãoque usa os processadores de inferência de ML para detectar automaticamente o idioma do conteúdo no nome e notas campos de documentos recebidos. Após a detecção de idiomas, o pipeline cria novos campos específicos de idiomas, copiando o conteúdo unique para novos campos com sufixos de idiomas (por exemplo, nome_en para conteúdo em inglês).

O pipeline usa um processador ML_Inference para executar os processadores de detecção e copiar de idiomas para criar os novos campos específicos de idiomas, tornando-o direto para lidar com conteúdo multilíngue no seu índice de serviço do OpenEarch.

Configure o índice e os documentos de ingestão

Crie um índice com o pipeline de ingestão Isso detecta automaticamente o idioma dos documentos de entrada e aplica análises apropriadas específicas do idioma. Quando os documentos são ingeridoso sistema identifica a linguagem dos principais campos, cria versões específicas da linguagem desses campos e os indexa usando o analisador de idiomas correto. Isso permite uma pesquisa eficiente e precisa nos documentos em vários idiomas sem a necessidade de especificação de idioma guide para cada documento.

Aqui está uma chamada da API de criação de índice de amostra demonstrando mapeamentos de idiomas diferentes.

Em seguida, ingerir este documento de entrada em alemão

O texto alemão usado no código anterior será processado usando um analisador específico para alemão, apoiando o manuseio adequado de características específicas da linguagem, como palavras compostas e caracteres especiais.

Após a ingestão bem -sucedida no serviço OpenEarch, o documento resultante aparece o seguinte:

Documentos de pesquisa

Esta etapa demonstra o capacidade de pesquisa Após a configuração multilíngue. Ao usar uma consulta multi_match com os campos name_*, ele pesquisa em todos os campos de nomes específicos da linguagem (name_en, name_es, name_de) e encontra com sucesso o documento espanhol ao pesquisar “comprar” porque o conteúdo foi analisado corretamente usando o analisador espanhol. Este exemplo mostra como a indexação específica do idioma permite resultados de pesquisa precisos no idioma correto sem precisar especificar em qual idioma você está pesquisando.

Esta pesquisa encontra corretamente o documento espanhol porque o campo Name_es é analisado usando o analisador espanhol:

Limpar

Para evitar cobranças contínuas e excluir os recursos criados neste tutorial, execute as seguintes etapas de limpeza

- Exclua o Domínio do serviço de opensearch. Isso interrompe os custos de armazenamento para seus dados vetorizados e quaisquer cobranças de computação associadas.

- Exclua o conector ML Isso vincula seu serviço OpenEarch ao seu modelo de aprendizado de máquina.

- Finalmente, exclua o seu Amazon Sagemaker termina e recursos.

Conclusão

A implementação da pesquisa multilíngue com o OpenEarch Service pode ajudar as organizações a quebrar as barreiras do idioma e desbloquear o valor whole de seu conteúdo world. O processador de inferência de ML fornece uma abordagem escalável e automatizada para a detecção de idiomas que melhora a precisão da pesquisa e a experiência do usuário.

Esta solução atende à crescente necessidade de gerenciamento de conteúdo multilíngue à medida que as organizações se expandem globalmente. Ao detectar automaticamente idiomas de documentos e aplicar o processamento lingüístico apropriado, as empresas podem oferecer experiências abrangentes de pesquisa que atendem de maneira diversa de bases de usuários.