Human-in-the-loop é uma maneira de construir modelos de aprendizado de máquina com pessoas envolvidas nos momentos certos. No aprendizado de máquina humano no loop, os especialistas rotulam dados, revisam casos de borda e dão suggestions sobre os resultados. Suas informações moldam as metas, definem barras de qualidade e ensinam modelos a lidar com áreas cinzentas. O resultado é a colaboração humana-AI que mantém os sistemas úteis e seguros para uso actual. Muitas equipes tratam o HITL como uma correção das mãos de última hora. Essa visão perde o ponto.

Hitl funciona melhor como supervisão planejada dentro do fluxo de trabalho. As pessoas orientam a coleta de dados, regras de anotação, verificações de treinamento de modelos, avaliação, portões de implantação e monitoramento ao vivo. A automação lida com a rotina. Os seres humanos intervêm onde o contexto, a ética e o julgamento da questão. Esse equilíbrio transforma o suggestions humano no treinamento de ML em melhorias constantes, e não em patches pontuais.

Aqui está o que este artigo cobre a seguir.

Definimos o HITL em termos claros e mapeamos onde ele se encaixa no pipeline ML. Descrevemos como projetar um sistema de hitl prático e por que ele levanta Dados de treinamento de IA qualidade. Emparelhamos o HITL com a anotação inteligente, mostramos como escalar sem perder a precisão e sinalizar armadilhas comuns. Fechamos com o que o HITL significa à medida que os sistemas de IA ficam mais autônomos.

O que é humano no loop (hitl)?

Human-in-the-loop (hitl) é uma abordagem de desenvolvimento de modelos em que os guias de conhecimento humano, valida e melhora os sistemas de IA/ML para maior precisão e confiabilidade. Em vez de deixar o processamento, o treinamento e a tomada de decisão de dados inteiramente a algoritmos, o HITL integra a experiência humana para melhorar a precisão, a confiabilidade e a segurança.

Na prática, Hitl pode envolver:

- Rotulagem de dados e anotação: Os seres humanos fornecem dados da verdade basic que treina modelos de IA.

- Revisando casos de borda: Especialistas validam ou corrigiram saídas onde o modelo é incerto.

- Suggestions contínuo: As correções humanas refimam o sistema ao longo do tempo, melhorando a adaptabilidade.

Essa colaboração garante que os sistemas de IA permaneçam transparentes, justos e alinhados com as necessidades do mundo actual, especialmente em domínios complexos ou sensíveis, como saúde, finanças ou imóveis. Essencialmente, o HITL combina a eficiência da automação com o julgamento humano para construir soluções de IA mais inteligentes, seguras e confiáveis.

O que é o aprendizado de máquina humano no loop

O aprendizado de máquina humano no loop é um fluxo de trabalho de ML que mantém as pessoas envolvidas nas principais etapas. É mais do que correções manuais. Pense em supervisão humana planejada no trabalho de dados, verificações de modelos e operações ao vivo.

A automação cresceu rapidamente. Passamos de scripts baseados em regras para métodos estatísticos, depois para o aprendizado profundo e os modelos generativos de hoje. Os sistemas agora aprendem padrões em escala. Mesmo assim, os modelos ainda perdem casos raros e mudam com novos dados. Rótulos envelhecem. Mudanças de contexto por região, estação ou política. É por isso que os casos de borda, a deriva de dados e as peculiaridades de domínio continuam aparecendo.

O custo dos erros é actual. O reconhecimento facial pode mostrar viés no tom da pele e no gênero. Os modelos de visão em veículos autônomos podem classificar incorretamente um lado do caminhão como espaço aberto. Na área da saúde, uma pontuação de triagem pode se distorcer contra um subgrupo se os dados de treinamento não tinham cobertura adequada. Esses erros corroem a confiança.

Hitl ajuda a fechar essa lacuna.

Uma arquitetura humano simples no circuito adiciona as pessoas a modelar treinamento e revisão, para que as decisões permaneçam fundamentadas em contexto.

- Especialistas escrevem regras de rotulagem, puxam exemplos difíceis e liquidam disputas.

- Eles estabelecem limiares, revisam saídas de risco e documentam casos raros para que o modelo aprenda.

- Após o lançamento, os revisores auditam alertas, fixam rótulos e alimentam essas mudanças no próximo ciclo de treinamento.

O modelo leva o trabalho de rotina. As pessoas lidam com julgamento, risco e ética. Esse loop constante melhora a precisão, reduz o viés e mantém os sistemas alinhados com o uso actual.

Por que o HITL é essencial para dados de treinamento de alta qualidade

Human-in-the-loop (HITL) é essencial para dados de treinamento de alta qualidade e eficazes Preparação de dados para aprendizado de máquina Porque os modelos de IA são tão bons quanto os dados que aprendem. Sem a experiência humana, os conjuntos de dados de treinamento correm o risco de ser imprecisos, incompletos ou tendenciosos. A rotulagem automatizada atinge um teto quando os dados são barulhentos ou ambíguos. Platôs e erros de precisão espalhados para treinamento e avaliação.

As rechecas de benchmarks populares encontraram erros de etiqueta em torno de 3 a 6 %, o suficiente para lançar as classificações dos modelos, e é aqui que os anotadores treinados entram na foto. Hitl garante:

- Experiência em domínio. Radiologistas para imagem médica. Linguistas para NLP. Eles estabelecem regras, casos de borda spot e corrigem interpreta mal sutis que os scripts perdem.

- Escalada clara. A revisão em camadas com adjudicação impede que os erros de passagem única se tornem verdade na verdade.

- Esforço direcionado. Rotas de aprendizado ativo apenas itens incertos para as pessoas, o que aumenta o sinal sem inchaço custos.

Caixa de qualidade: gigo em ML

- Rótulos melhores levam a melhores modelos.

- O suggestions humano no treinamento de ML quebra a propagação de erros e mantém os conjuntos de dados alinhados com o significado do mundo actual.

Aqui estão evidências de que funciona:

- Imagenet re-rotulado. Quando pesquisadores Rótulos únicos substituídos por conjuntos verificados humanosos ganhos relatados diminuíram e alguns rankings de modelo mudaram. Os rótulos mais limpos produziram um teste mais fiel de desempenho actual.

- Auditorias de referência. As revisões sistemáticas mostram que pequenas frações de exemplos rotulados por mal podem distorcer as opções de avaliação e implantação, reforçando a necessidade de humano no loop em dados de alto impacto.

O aprendizado de máquina humano no loop oferece supervisão planejada que atualiza a qualidade dos dados do treinamento, reduz o viés e estabiliza o comportamento do modelo onde ele conta.

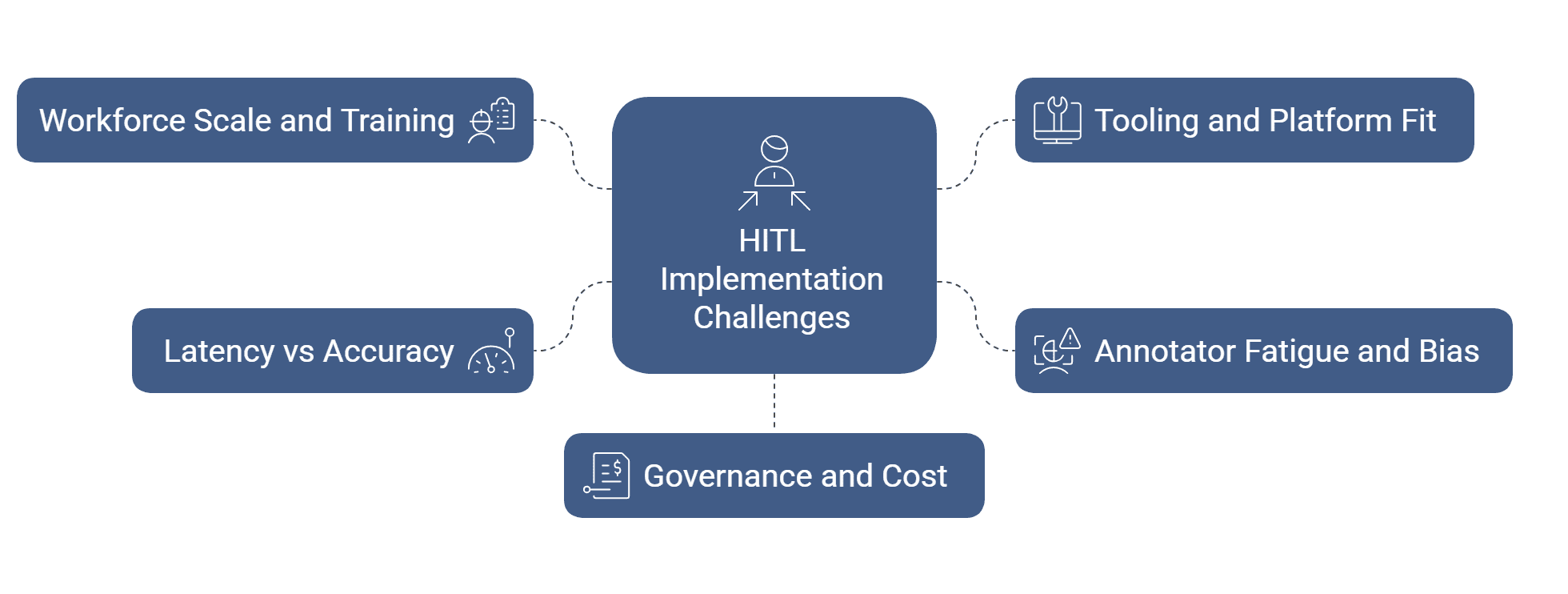

Desafios e considerações na implementação do hitl

A implementação do humano no loop (HITL) vem com desafios como escalar o envolvimento humano, garantir a rotulagem de dados consistente, o gerenciamento de custos e a integração de suggestions com eficiência. As organizações devem equilibrar a automação com a supervisão humana, abordar possíveis vieses e manter a privacidade de dados, enquanto projeta fluxos de trabalho que mantêm o pipeline ML, tanto preciso quanto eficiente.

- Escala de força de trabalho e treinamento:

Você precisa de anotadores treinados o suficiente na hora certa. Crie guias claros, vídeos de treinamento curto e testes rápidos. Acompanhe as taxas de contrato e dê um suggestions rápido para que a qualidade melhore semana a semana. - Ferramentas e ajuste da plataforma:

Verifique se sua ferramenta de rotulagem fala sua pilha. Suporte para esquemas de versão, trilhas de auditoria, RBAC e APIs mantém os dados em movimento. Se você criar ferramentas personalizadas, orçamento para operações, tempo de atividade e suporte ao usuário. - Fadiga e preconceito do anotador:

Filas longas e itens repetitivos com menor precisão. Gire as tarefas, o comprimento da sessão de limpeza e misture fácil com exemplos difíceis. Use revisão cega e resolução de conflitos para reduzir o viés pessoal e o pensamento de grupo. - Latência vs precisão em tempo actual:

Alguns casos de uso precisam de resultados instantâneos. Outros podem esperar pela revisão. Triagem por risco. Rota apenas itens de alto risco ou de baixa confiança para humanos. Decisões de cache e reutilize -as para reduzir o atraso. - Governança e custo:

O aprendizado de máquinas humano no loop precisa de propriedade clara. Defina critérios de aceitação, caminhos de escalação e alertas de orçamento. Meça a qualidade do rótulo, a taxa de transferência e o custo unitário para que os líderes possam negociar a velocidade da precisão com os olhos abertos.

Como projetar um sistema humano eficaz

Comece com decisões, não ferramentas.

Liste os pontos em que o julgamento molda os resultados. Escreva as regras para esses momentos, concorde com metas de qualidade e encaixe o aprendizado de máquina humano no loop nesse caminho. Mantenha o loop simples de executar e fácil de medir.

Use os tipos certos de rotulagem de dados

Use rotulagem apenas de especialista para lessons arriscadas ou raras. Adicione o modelo-Assista, onde o sistema pré-preenchra os rótulos e as pessoas confirmam ou editam. Para itens difíceis, colete duas ou três opiniões e deixe um revisor sênior decidir. Traga regras programáticas leves para casos óbvios, mas mantenha as pessoas responsáveis por casos de borda.

Instalando Hitl em sua empresa

- Escolha uma caixa de uso de alto valor e execute um piloto curto.

- Escreva diretrizes com exemplos claros e contra-exemplos.

- Defina verificações de aceitação, etapas de escalação e um nível de serviço para reviravolta.

- Aprendizagem ativa de fio, para que os itens de baixa confiança cheguem aos revisores primeiro.

- Acordo de rastreamento, latência, custo unitário e temas de erro.

- Quando o loop for constante, expanda -se para o próximo conjunto de dados usando a mesma arquitetura HITL na IA.

Um humano no sistema de loop é escalável?

Sim, se você dirigir por confiança e risco. Veja como você pode tornar o sistema escalável:

- Casos claros de aceitação automática.

- Envie casos médios para revisores treinados.

- Escala apenas os poucos que têm alto impacto ou pouco claro.

- Use modelos de etiquetas, verificações de ontologia e auditorias periódicas para manter a consistência à medida que o quantity cresce.

Melhores pontuações de incerteza direcionarão as revisões com mais precisão. Assista ao modelo acelerará o vídeo e a rotulagem 3D. Os dados sintéticos ajudarão a cobrir eventos raros, mas as pessoas ainda o exibirão. O RLHF se estenderá além do texto para saídas pesadas de políticas em outros domínios.

Para Verificações éticas e de justiça, comece a escrever regras com consciência de preconceitos. Amostra por subgrupo e revise essas fatias em um cronograma. Use diversos swimming pools de anotadores e críticas cegas ocasionais. Mantenha trilhas de auditoria, controles de privacidade e registros de consentimento apertados.

Essas etapas mantêm a colaboração humana-AI segura, rastreável e adequada para uso actual.

Olhando para o futuro: Hitl em um futuro de IA autônoma

Os modelos estão melhorando em auto-verificações e auto-corrigir. Eles ainda precisarão de corrimão. Chamadas de alto risco, padrões de cauda longa e políticas de mudança exigem julgamento humano.

A contribuição humana mudará a forma. Projeto mais rápido e configuração de políticas antecipadamente. Mais curadoria de suggestions e governança do conjunto de dados. Revisão ética como uma prática programada, não uma reflexão tardia. No aprendizado de reforço com suggestions humano, os revisores se concentrarão em casos disputados e limites de segurança, enquanto as ferramentas lidam com classificações de rotina.

Hitl não é um fallback. É um parceiro estratégico nas operações de ML: ele outline padrões, limiares de músicas e resultados de auditorias para que os sistemas permaneçam alinhados com o uso actual.

Integrações mais profundas com ferramentas de rotulagem e MLOPs, análises mais ricas para qualidade no nível da fatia e uma força de trabalho especializada por domínio e tipo de tarefa. O objetivo é simples: mantenha a automação rapidamente, mantenha a supervisão nítida e mantenha os modelos úteis à medida que o mundo muda.

Conclusão

Human in Sure é a base da IA confiável, pois mantém julgamento no fluxo de trabalho onde importa. Ele transforma dados brutos em sinais confiáveis. Com avaliações planejadas, regras claras e aprendizado ativo, os modelos aprendem mais rápido e falham mais seguros.

A qualidade se mantém à medida que você escala, porque as pessoas lidam com casos de borda, verificações de viés e mudanças de política enquanto a automação faz a rotina. É assim que os dados se tornam inteligência com escala e qualidade.

Se você estiver escolhendo um parceiro, escolha um que incorpore a coleta de dados, anotação, controle de qualidade e monitoramento. Peça alvos mensuráveis, painéis de nível de fatia e caminhos reais de escalação. Esse é o nosso modelo no HitechDigital. Construímos e executamos loops de hitl de ponta a ponta, para que seus sistemas permaneçam precisos, responsáveis e prontos para o uso actual.