(Shuttestock IA)

Nos últimos anos, a IA se expandiu mais rapidamente do que qualquer tecnologia na memória moderna. As execuções de treinamento que antes funcionavam silenciosamente nos laboratórios universitários agora abrangem instalações enormes repletas de computadores de alto desempenho, acessando uma rede de GPUs e vastos volumes de dados.

A IA funciona essencialmente com três ingredientes: chips, dados e eletricidade. Entre eles, a eletricidade tem sido a mais difícil de escalar. Sabemos que cada nova geração de modelos é mais poderosa e muitas vezes considerada mais eficiente em termos de energia ao nível do chip, mas a energia whole necessária continua a aumentar.

Conjuntos de dados maiores, execuções de treinamento mais longas e mais parâmetros levam ao uso whole de energia muito mais alto do que period possível com sistemas anteriores. A infinidade de algoritmos deu lugar a um obstáculo de engenharia. A próxima fase do progresso da IA aumentará ou diminuirá dependendo de quem puder garantir o poder, não a computação.

Nesta parte da nossa série Powering Information within the Age of AI, veremos como a energia se tornou a restrição definidora do progresso computacional – desde os megawatts necessários para alimentar clusters de treinamento até os projetos nucleares e inovações de rede que poderiam apoiá-los.

Compreendendo a escala do problema energético

A Agência Internacional de Energia (AIE) calculou que os centros de dados em todo o mundo consumiram cerca de 415 terawatts-hora de eletricidade em 2024. Esse número irá quase duplicar, para cerca de 945 TWh até 2030, à medida que as exigências das cargas de trabalho de IA continuam a aumentar. Tem cresceu 12% ao ano nos últimos cinco anos.

Fatih Birol, diretor executivo da AIE, chamou a IA de “uma das maiores histórias da energia hoje” e disse que a procura de eletricidade dos centros de dados poderá em breve rivalizar com o que os países usam em conjunto.

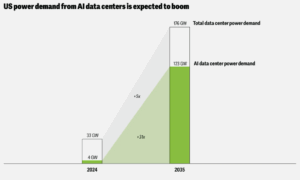

Espera-se que a demanda de energia dos information facilities de IA dos EUA cresça (créditos: deloitte.com)

“A procura de electricidade em todo o mundo a partir de centros de dados está em vias de duplicar nos próximos cinco anos, à medida que a tecnologia da informação se torna mais difundida nas nossas vidas”, disse Birol num comunicado divulgado juntamente com o relatório de Energia e IA de 2024 da IEA.

“O impacto será especialmente forte em alguns países – nos Estados Unidos, prevê-se que os centros de dados sejam responsáveis por quase metade do crescimento da procura de eletricidade; no Japão, mais de metade; e na Malásia, um quinto.”

Essa mudança já está transformando a forma e o native onde a energia é distribuída. Os gigantes da tecnologia não estão apenas construindo information facilities para proximidade ou velocidade de rede. Procuram também redes estáveis, electricidade de baixo custo e espaço para produção de energias renováveis.

De acordo com a pesquisa do Laboratório Nacional Lawrence Berkeley, espera-se que os information facilities consumam cerca de 176 terawatts-hora de eletricidade apenas nos EUA em 2023ou cerca de 4,4% da demanda nacional whole. A construção não está desacelerando. Até ao last da década, novos projetos poderão aumentar o consumo para quase 800 TWh, uma vez que se prevê que mais de 80 gigawatts de capacidade further estejam on-line – desde que sejam concluídos a tempo.

A Deloitte projeta que a demanda de energia dos information facilities de IA subir de cerca de 4 gigawatts em 2024 para cerca de 123 gigawatts em 2035. Tendo em conta estes projectos, não é nenhuma grande surpresa que agora a energia dite onde o próximo cluster será construído, e não as rotas de fibra ou os incentivos fiscais. Em algumas áreas, os planeadores energéticos e as empresas tecnológicas estão mesmo a negociar diretamente para garantir um fornecimento a longo prazo. O que antes period uma questão de computação e escala tornou-se agora uma questão de energia.

Por que os sistemas de IA consomem tanta energia

A dependência da energia deve-se em parte ao facto de todas as camadas da infraestrutura de IA funcionarem com eletricidade. No centro de todo sistema de IA está a computação pura. Os chips que treinam e executam grandes modelos são, de longe, os que mais consomem energia, realizando bilhões de operações matemáticas a cada segundo. O Google publicou uma estimativa de que uma solicitação de texto média do Gemini Apps consome 0,24 watts-hora de eletricidade. Você multiplica isso pelos milhões de mensagens de texto todos os dias e os números são surpreendentes.

As GPUs que treinam e processam esses modelos consomem uma energia tremenda, quase toda ela transformada diretamente em calor (além de perdas na conversão de energia). Esse calor tem que ser dissipado o tempo todo, por meio de sistemas de refrigeração que consomem energia.

Essa estabilidade exige muito funcionamento ininterrupto dos sistemas de refrigeração, bombas e manipuladores de ar. Um único rack de aceleradores modernos pode consumir de 30 a 50 quilowatts – várias vezes o que os servidores mais antigos precisavam. A energia também transporta dados: interconexões de alta velocidade, matrizes de armazenamento e conversões de tensão contribuem para esse fardo.

Ao contrário das cargas de trabalho de mainframe mais antigas, que aumentaram e diminuíram com as mudanças na demanda, os sistemas modernos de IA operam perto da capacidade whole por dias ou até semanas de cada vez. Esta intensidade constante coloca pressão sustentada sobre o fornecimento de energia e os sistemas de refrigeração, transformando a eficiência energética de uma simples consideração de custos na base da computação escalável.

Problema de energia crescendo mais rápido que os chips

Cada salto no desempenho do chip agora traz uma pressão igual e oposta aos sistemas que o alimentam. Cada nova geração da NVIDIA ou AMD aumenta as expectativas de velocidade e eficiência, mas a verdadeira história se desenrola fora do chip – nos information facilities que tentam alimentá-los. Racks que antes consumiam 15 ou 20 quilowatts agora consomem 80 ou mais, às vezes chegando a 120. Unidades de distribuição de energia, transformadores e circuitos de resfriamento precisam evoluir apenas para acompanhar.

O que antes period uma questão de design de processador tornou-se um quebra-cabeça de engenharia em escala. A Associação da Indústria de Semicondutores Relatório sobre o estado da indústria de 2025 descreve isso como um “paradoxo de desempenho por watt”, onde os ganhos de eficiência no nível do chip estão sendo superados pelo crescimento whole de energia entre os sistemas. Cada melhoria convida a modelos maiores, execuções de treinamento mais longas e movimentação de dados mais pesada – eliminando a economia que esses chips deveriam proporcionar.

Para lidar com esta nova procura, os operadores estão a mudar da refrigeração a ar para a refrigeração líquida, a modernizar as subestações e a negociar diretamente com as empresas de serviços públicos para ligações de vários megawatts. A infraestrutura construída para os servidores de ontem está sendo reimaginada em torno do fornecimento de energia e não da densidade computacional. À medida que os chips se tornam mais capazes, o mundo físico ao seu redor – os fios, as bombas e as redes – está lutando para alcançá-los.

A nova métrica que rege a period da IA: velocidade para potência

Dentro dos maiores information facilities do planeta, está ocorrendo uma mudança silenciosa. A velha corrida pela velocidade pura deu lugar a algo mais basic: quanto desempenho pode ser extraído por unidade de potência. Este equilíbrio, por vezes chamado de equilíbrio entre velocidade e potência, tornou-se a equação definidora da IA moderna.

Não é uma referência como o FLOPS, mas agora influencia quase todas as decisões de design. Os fabricantes de chips promovem o desempenho por watt como sua vantagem competitiva mais importante, porque a velocidade não importa se a rede não puder lidar com isso. A próxima GPU H200 da NVIDIA, por exemplo, oferece cerca de 1,4 vezes o desempenho por watt do H100enquanto a família MI300 da AMD se concentra fortemente na eficiência para clusters de treinamento em grande escala. No entanto, à medida que os chips ficam mais avançados, aumenta também a demanda por mais energia.

Essa dinâmica também está a remodelar a economia da IA. Os provedores de nuvem estão começando a cobrar pelas cargas de trabalho com base não apenas no tempo de execução, mas também na energia que consomem, forçando os desenvolvedores a otimizar o rendimento de energia em vez da latência. Os arquitetos de information facilities agora projetam orçamentos de megawatts em vez de metros quadrados, enquanto governos dos EUA ao Japão estão emitindo novas regras para sistemas de IA com eficiência energética.

Essa dinâmica também está a remodelar a economia da IA. Os provedores de nuvem estão começando a cobrar pelas cargas de trabalho com base não apenas no tempo de execução, mas também na energia que consomem, forçando os desenvolvedores a otimizar o rendimento de energia em vez da latência. Os arquitetos de information facilities agora projetam orçamentos de megawatts em vez de metros quadrados, enquanto governos dos EUA ao Japão estão emitindo novas regras para sistemas de IA com eficiência energética.

Pode nunca aparecer em uma folha de especificações, mas a velocidade de potência outline silenciosamente quem pode construir em escala. Quando um modelo pode consumir tanta eletricidade como uma pequena cidade, a eficiência é importante – e mostra como todo o ecossistema se está a reorganizar em torno dele.

A corrida pela supremacia da IA

À medida que a energia se torna o novo epicentro da vantagem computacional, os governos e as empresas que conseguem produzir energia fiável em grande escala avançarão não só na IA, mas em toda a economia digital mais ampla. Os analistas descrevem isso como o surgimento de uma “vantagem estratégica da eletricidade”. O conceito é simples e abrangente: à medida que aumentam as cargas de trabalho da IA, os países capazes de fornecer energia abundante e de baixo custo liderarão a próxima onda de crescimento industrial e tecnológico.

Sem um investimento mais rápido na energia nuclear e na expansão da rede, os EUA poderão enfrentar riscos de fiabilidade no início da década de 2030. É por isso que a conversa está mudando das regiões de nuvem para as regiões de energia.

Vários governos já estão a investir em centros de computação nuclear – zonas que combinam pequenos reatores modulares com centros de dados em hiperescala. Outros estão a utilizar terras federais para projectos híbridos que combinam energia nuclear com gás e energias renováveis para satisfazer a crescente procura de electricidade da IA. Este é apenas o começo da história. A verdadeira questão não é se podemos alimentar a IA, mas se o nosso mundo consegue acompanhar as máquinas que criou.

Nas próximas partes da nossa série Powering Information within the Age of AI, exploraremos como as empresas estão recorrendo a novas fontes de energia para sustentar suas ambições de IA, como a própria rede elétrica está sendo reinventada para pensar e se adaptar como os sistemas que alimenta, e como os information facilities estão evoluindo para laboratórios da ciência moderna. Também olharemos para fora, para a corrida que se desenrola entre os EUA, a China e outros países para obter o controlo sobre a electricidade e as infra-estruturas que impulsionarão a próxima period da inteligência.

Itens Relacionados

Nosso futuro compartilhado em IA: indústria, academia e governo se unem na TPC25