Ao encerrarmos 2025, pensei que seria bom relembrar os modelos de IA que deixaram um impacto duradouro ao longo do ano. Este ano trouxe novos modelos de IA para o centro das atenções, enquanto alguns dos modelos mais antigos também ganharam popularidade. Do Processamento de Linguagem Pure à Visão Computacional, esses modelos influenciaram uma infinidade de IA domínios. Este artigo apresentará os modelos que mais impactaram no ano de 2025.

Critérios de seleção de modelos

Os modelos de IA listados neste artigo foram selecionados nas tabelas de classificação do HuggingFace com base nos seguintes critérios:

- O número de downloads

- Ter uma licença de código aberto Apache 2.0 ou MIT

Isso inclui uma mistura de modelos lançados este ano ou do ano anterior que tiveram um aumento de popularidade. Você pode ver a lista completa na tabela de classificação HuggingFace aqui: https://huggingface.co/fashions?license=license:apache-2.0&type=downloads

1. Transformador de frases MiniLM

Categoria: Processamento de Linguagem Pure

Um modelo compacto de incorporação de frases em inglês otimizado para similaridade semântica, agrupamento e recuperação. Ele destila o MiniLM em um transformador de 6 camadas (incorporação de 384 dimensões) treinado em milhões de pares de frases. Apesar de seu tamanho, ele oferece forte desempenho em tarefas de pesquisa semântica e modelagem de tópicos, rivalizando com modelos maiores.

Licença: Apache 2.0

AbraçosFace Hyperlink: https://huggingface.co/sentence-transformers/all-MiniLM-L6-v2

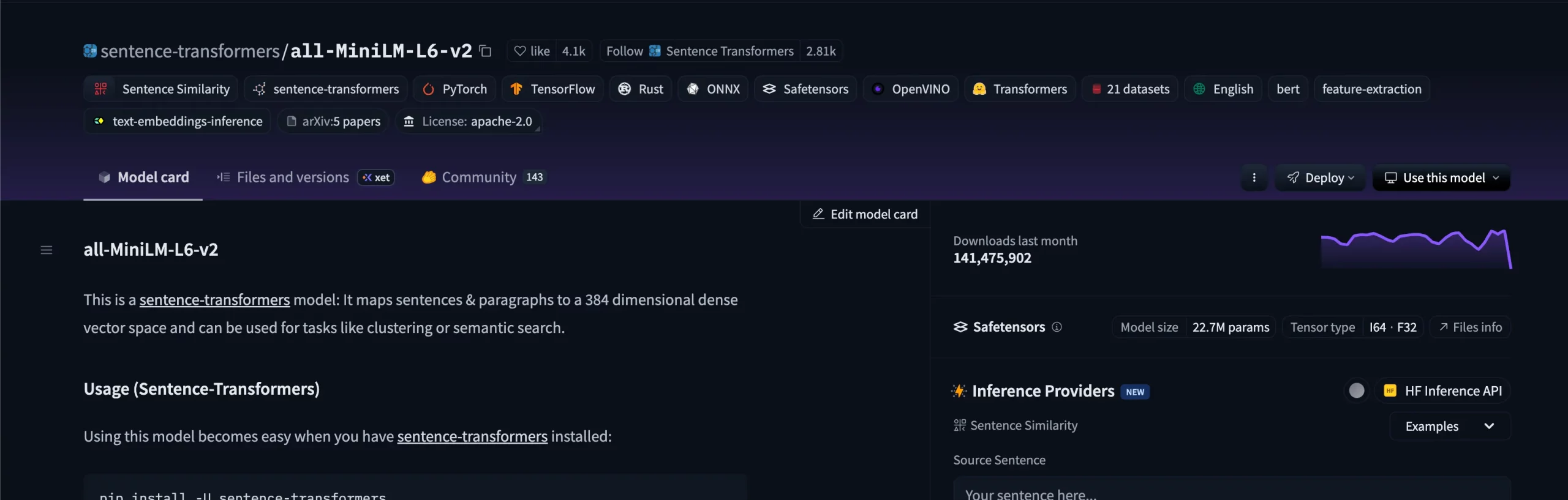

2. Discriminador de base Google Electra

Categoria: Processamento de Linguagem Pure

ELECTRA redefine a modelagem de linguagem mascarada treinando modelos para detectar tokens substituídos em vez de predizê-los. A versão base (parâmetros 110M) atinge desempenho comparável ao BERT-base, exigindo muito menos computação. É amplamente utilizado para extração de recursos e ajuste fino em classificação e pipelines de controle de qualidade.

Licença: Apache 2.0

AbraçosFace Hyperlink: https://huggingface.co/google/electra-base-discriminator

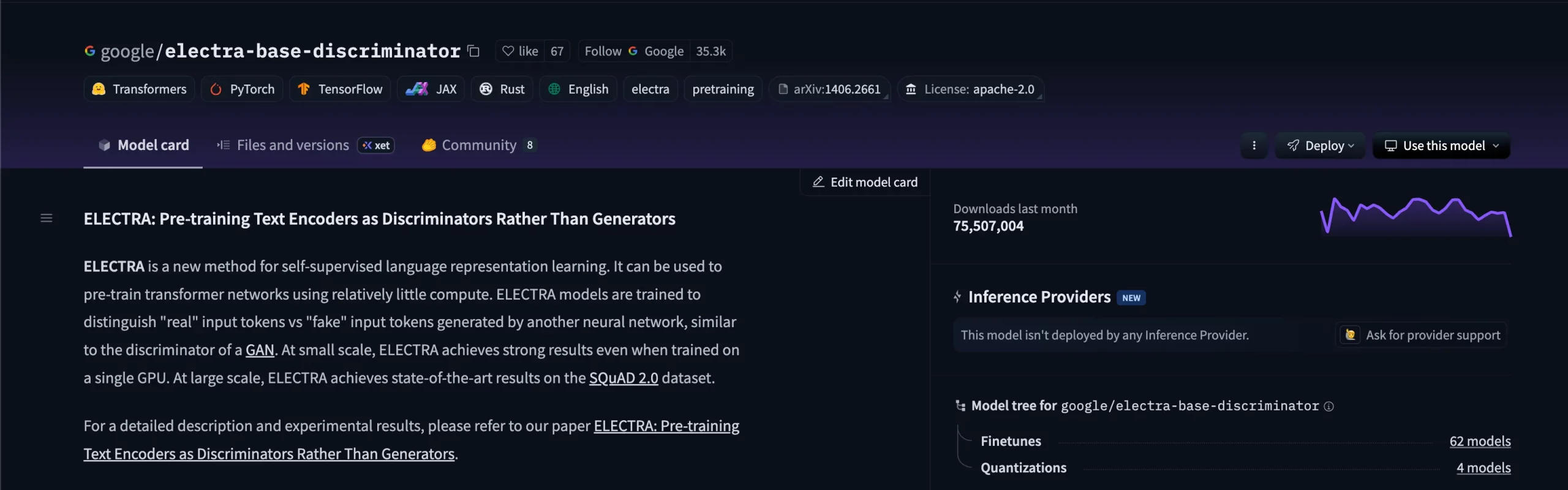

3. Detecção de imagem FalconsAI NSFW

Categoria: Visão Computacional

UM CNNmodelo baseado em NSFW projetado para detectar NSFW ou conteúdo inseguro em imagens. Pessoas que usam websites como o Reddit estariam cientes de um infame “NSFW Blocker”. Construído em arquiteturas como EfficientNet ou MobileNet, ele gera probabilidades para categorias “seguras” versus “inseguras”, tornando-o um componente chave de moderação para recursos visuais gerados por IA ou carregados por usuários.

Licença: Apache 2.0

AbraçoFace Hyperlink: https://huggingface.co/Falconsai/nsfw_image_detection

4. BERT sem caixa do Google

Categoria: Processamento de Linguagem Pure

O modelo unique baseado em BERT do Google Analysis, treinado no BooksCorpus e na Wikipedia em inglês. Com 12 camadas e parâmetros de 110M, ele lançou as bases para arquiteturas modernas de transformadores e continua sendo uma base sólida para classificação, NER e resposta a perguntas.

Licença: Apache 2.0

AbraçoFace Hyperlink: https://huggingface.co/google-bert/bert-base-uncased

5. Detecção de idade da imagem Fairface

Categoria: Visão Computacional

Um modelo de previsão de idade facial treinado no conjunto de dados FairFace, enfatizando a representação equilibrada entre etnias e gêneros. Ele prioriza a justiça e a consistência demográfica, tornando-o adequado para análises e pipelines de pesquisa envolvendo atributos faciais.

Licença: Apache 2.0

AbraçosFace Hyperlink: https://huggingface.co/dima806/fairface_age_image_detection

6. Modelo de classificação de imagens MobileNet

Categoria: Visão Computacional

Um classificador de imagens convolucionais leve da biblioteca timm, projetado para implantação eficiente em dispositivos com recursos limitados. MobileNetV3 Small, treinado em ImageNet-1k usando o otimizador LAMB, alcança precisão sólida com baixa latência, tornando-o preferrred para inferência móvel e de borda.

Licença: Apache 2.0

AbraçosFace Hyperlink: https://huggingface.co/timm/mobilenetv3_small_100.lamb_in1k

7. Laion CLAP

Categoria: Multimodal (Áudio para Idioma)

Uma fusão de CLAP (Contrastive Language – Audio Pretraining) e HTS-AT (Hierarchical Token-Semantic Audio Transformador) que mapeia áudio e texto em um espaço de incorporação compartilhado. Ele suporta recuperação de áudio, marcação e legendagem de disparo zero, unindo a compreensão do som e a linguagem pure.

Licença: Apache 2.0

AbraçosFace Hyperlink: https://huggingface.co/laion/clap-htsat-fused

8. DestilBERT

Categoria: Processamento de Linguagem Pure

Uma versão destilada da base BERT desenvolvida pela Hugging Face para equilibrar desempenho e eficiência. Mantendo cerca de 97% da precisão do BERT, sendo 40% menor e 60% mais rápido, é preferrred para tarefas leves de PNL, como classificação, incorporação e pesquisa semântica.

Licença: Apache 2.0

AbraçosFace Hyperlink: https://huggingface.co/distilbert/distilbert-base-uncased

9. Segmentação Pyannote 3

Categoria: Processamento de fala

Um componente central do pipeline Pyannote Audio para detectar e segmentar atividades de fala. Ele identifica regiões de silêncio, alto-falante único e fala sobreposta, com desempenho confiável mesmo em ambientes barulhentos. Normalmente usado como base para sistemas de alto-falantes.

Licença: MIT

AbraçosFace Hyperlink: https://huggingface.co/pyannote/segmentation-3.0

10. FacebookAI Roberta Grande

Categoria: Processamento de Linguagem Pure

Um sistema robustamente otimizado BERTO variante treinada em 160 GB de texto em inglês com máscara dinâmica e sem previsão da próxima frase. Com 24 camadas e 355M de parâmetros, o RoBERTa-large supera consistentemente o BERT-base em GLUE e outros benchmarks, proporcionando alta precisão PNL aplicações.

Licença: MIT

AbraçoFace Hyperlink: https://huggingface.co/FacebookAI/roberta-large

Conclusão

Esta lista não é exaustiva e existem vários modelos que tiveram um impacto tremendo, mas não entraram na lista. Alguns que tiveram o mesmo impacto, mas não possuíam licença de código aberto. E outros simplesmente não tinham os números. Mas o que todos fizeram foi contribuir para resolver parte de um problema maior. Os modelos compartilhados nesta lista podem não ter o burburinho que segue modelos como Gêmeos, Bate-papoGPT, Cláudiomas o que eles oferecem é uma carta aberta aos entusiastas da ciência de dados que buscam criar coisas do zero, sem abrigar um knowledge heart.

Perguntas frequentes

UM. Os modelos foram escolhidos com base em dois fatores principais: whole de downloads no Hugging Face e ter uma licença de código aberto permissiva (Apache 2.0 ou MIT), garantindo que sejam populares e de uso gratuito.

UM. A maioria é, mas alguns – como Falconsai/nsfw_image_detection ou modelos baseados em FairFace – podem ter restrições de uso. Sempre verifique o cartão do modelo e a licença antes de implantar em produção.

UM. Os modelos de código aberto dão aos pesquisadores e desenvolvedores liberdade para experimentar, ajustar e implantar sem dependência de fornecedores ou necessidades pesadas de infraestrutura, tornando a inovação mais acessível.

R. A maioria deles é lançada sob licenças permissivas como Apache 2.0 ou MIT, o que significa que você pode usá-los tanto para pesquisa quanto para projetos comerciais.

R. Sim. Muitos sistemas de produção encadeiam modelos de diferentes domínios – por exemplo, usando um modelo de segmentação de fala como Pyannote para isolar o diálogo, depois um modelo de linguagem como RoBERTa para analisar sentimento ou intenção e, finalmente, um modelo de visão para moderar as imagens que o acompanham.

Faça login para continuar lendo e desfrutar de conteúdo com curadoria de especialistas.