O método ReWiND, que consiste em três fases: aprender uma função de recompensa, pré-treinamento e usar a função de recompensa e política pré-treinada para aprender on-line uma nova tarefa específica do idioma.

O método ReWiND, que consiste em três fases: aprender uma função de recompensa, pré-treinamento e usar a função de recompensa e política pré-treinada para aprender on-line uma nova tarefa específica do idioma.

Em seu papel ReWiND: recompensas guiadas por idioma ensinam políticas para robôs sem novas demonstraçõesque foi apresentado no CoRL 2025, Jiahui Zhang, Yusen Luo, Abrar Anwar, Sumedh A. Sontakke, Joseph J. Lim, Jesse Thomason, Erdem Bıyık e Jessé Zhang introduzir uma estrutura para aprender tarefas de manipulação de robôs apenas a partir de instruções de linguagem, sem demonstrações por tarefa. Pedimos a Jiahui Zhang e Jesse Zhang que nos contassem mais.

Qual é o tema da pesquisa em seu artigo e que problema você pretendia resolver?

Nossa pesquisa aborda o problema de permitir que políticas de manipulação de robôs resolvam tarefas novas e condicionadas à linguagem sem coletar novas demonstrações para cada tarefa. Começamos com um pequeno conjunto de demonstrações no ambiente de implantação, treinamos nelas um modelo de recompensa condicionado pela linguagem e, em seguida, usamos essa função de recompensa aprendida para ajustar a política em tarefas invisíveis, sem a necessidade de demonstrações adicionais.

Conte-nos sobre o ReWiND – quais são as principais características e contribuições deste framework?

ReWiND é uma estrutura simples e eficaz de três estágios projetada para adaptar políticas de robôs a novas tarefas condicionadas por linguagem sem coletar novas demonstrações. Suas principais características e contribuições são:

- Recompense o aprendizado da função no ambiente de implantação

Primeiro aprendemos uma função de recompensa usando apenas cinco demonstrações por tarefa no ambiente de implantação.- O modelo de recompensa pega uma sequência de imagens e uma instrução de idioma e prevê o progresso por quadro de 0 a 1, dando-nos um sinal de recompensa denso em vez de sucesso/fracasso esparso.

- Para expor o modelo a comportamentos bem-sucedidos e fracassados sem ter que coletar demonstrações de comportamento fracassadasintroduzimos um aumento de retrocesso de vídeo: Para uma segmentação de vídeo V(1:t), escolhemos um ponto intermediário t1. Invertemos o segmento V(t1:t) para criar V(t:t1) e anexá-lo de volta à sequência unique. Isso gera uma sequência sintética que lembra “fazer progresso e depois desfazer progresso”, simulando efetivamente tentativas fracassadas.

- Isto permite que o modelo de recompensa aprenda um sinal de recompensa denso mais suave e preciso, melhorando a generalização e a estabilidade durante a aprendizagem de políticas.

- Pré-treinamento de política com RL offline

Depois de aprendermos a função de recompensa, nós a usamos para renomear o pequeno conjunto de dados de demonstração com densas recompensas de progresso. Em seguida, treinamos uma política off-line usando essas trajetórias renomeadas. - Ajuste fino de políticas no ambiente de implantação

Por fim, adaptamos a política pré-treinada a tarefas novas e invisíveis no ambiente de implantação. Congelamos a função de recompensa e a usamos como suggestions para aprendizagem por reforço on-line. Após cada episódio, a trajetória recém-coletada é renomeada com recompensas densas do modelo de recompensa e adicionada ao buffer de repetição. Este ciclo iterativo permite que a política melhore continuamente e se adapte a novas tarefas sem exigir quaisquer demonstrações adicionais.

Você poderia falar sobre os experimentos que realizou para testar o framework?

Avaliamos o ReWiND tanto no ambiente de simulação MetaWorld quanto na configuração do mundo actual Koch. A nossa análise centra-se em dois aspectos: a capacidade de generalização do modelo de recompensa e a eficácia da aprendizagem política. Também comparamos a forma como diferentes políticas se adaptam às novas tarefas no âmbito do nosso enquadramento, demonstrando melhorias significativas em relação aos métodos mais avançados.

(Q1) Generalização de recompensas – análise MetaWorld

Coletamos um conjunto de dados de metamundo em 20 tarefas de treinamento, cada tarefa inclui 5 demonstrações e 17 tarefas relacionadas, mas não vistas, para avaliação. Treinamos a função de recompensa com o conjunto de dados metaworld e um subconjunto do conjunto de dados OpenX.

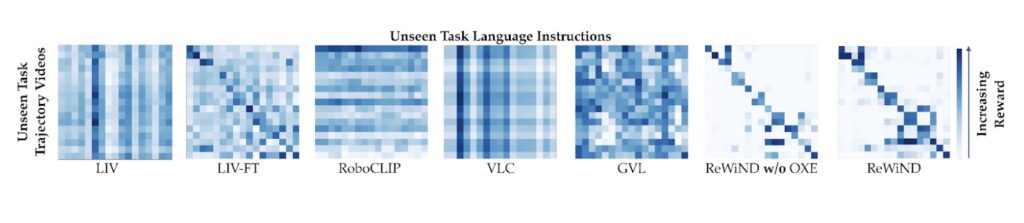

Comparamos ReWiND com LIV(1), LIV-FT, RoboCLIP(2), VLC(3) e GVL(4). Para generalização para tarefas invisíveis, usamos matrizes de confusão vídeo-linguagem. Alimentamos as sequências de vídeo do modelo de recompensa emparelhadas com instruções de idiomas diferentes e esperamos que os pares de instruções de vídeo correspondentes corretamente recebam as recompensas previstas mais altas. Na matriz de confusão, isto corresponde às entradas diagonais com os valores mais fortes (mais escuros), indicando que a função de recompensa identifica de forma confiável a descrição correta da tarefa, mesmo para tarefas não vistas.

Matriz de confusão de recompensa em linguagem de vídeo. Ver o papel para mais informações.

Matriz de confusão de recompensa em linguagem de vídeo. Ver o papel para mais informações.

Para o alinhamento de demonstração, medimos a correlação entre o progresso previsto do modelo de recompensa e os passos de tempo reais em trajetórias bem-sucedidas usando Pearson R e lanceiro ρ. Para a classificação da implementação de políticas, avaliamos se a função de recompensa classifica corretamente as implementações com falha, quase-sucesso e bem-sucedidas. Nessas métricas, o ReWiND supera significativamente todas as linhas de base – por exemplo, atinge uma correlação de Pearson 30% maior e uma correlação de Spearman 27% maior do que o VLC no alinhamento de demonstração e oferece cerca de 74% de melhoria relativa na separação de recompensas entre categorias de sucesso em comparação com a linha de base mais forte LIV-FT.

(Q2) Aprendizagem de políticas em simulação (MetaWorld)

Pré-treinamos nas mesmas 20 tarefas e, em seguida, avaliamos RL em 8 tarefas MetaWorld invisíveis para 100 mil etapas de ambiente.

Usando recompensas ReWiND, a política atinge uma taxa de sucesso média interquartil (IQM) de aproximadamente 79%, representando uma melhoria de aproximadamente 97,5% em relação à melhor linha de base. Também demonstra uma eficiência de amostra substancialmente melhor, alcançando taxas de sucesso mais elevadas muito mais cedo no treinamento.

(Q3) Aprendizagem de políticas em robô actual (braços bimanuais Koch)

Configuração: um sistema Koch v1.1 bimanual de mesa do mundo actual com cinco tarefas, incluindo tarefas de distribuição, visualmente desordenadas e de generalização de linguagem espacial.

Usamos 5 demonstrações para o modelo de recompensa e 10 demonstrações para a política neste cenário mais desafiador. Com cerca de 1 hora de RL do mundo actual (~50k etapas de ambiente), o ReWiND melhora o sucesso médio de 12% → 68% (≈5× melhoria), enquanto o VLC vai apenas de 8% → 10%.

Você está planejando trabalhos futuros para melhorar ainda mais a estrutura ReWiND?

Sim, planejamos estender o ReWiND para modelos maiores e melhorar ainda mais a precisão e generalização da função de recompensa em uma gama mais ampla de tarefas. Na verdade, já temos um documento de oficina estendendo o ReWiND para modelos de maior escala.

Além disso, pretendemos tornar o modelo de recompensas capaz de prever diretamente o sucesso ou o fracasso, sem depender do sinal de sucesso do ambiente durante o ajuste fino das políticas. Atualmente, embora o ReWiND ofereça recompensas densas, ainda confiamos no ambiente para indicar se um episódio foi bem-sucedido. Nosso objetivo é desenvolver um modelo de recompensa totalmente generalizável que possa fornecer recompensas densas e precisas e detecção confiável de sucesso por si só.

Referências

(1) Yecheng Jason Ma e outros. “Liv: Representações de linguagem-imagem e recompensas para controle robótico.” Conferência Internacional sobre Aprendizado de Máquina. PMLR, 2023.

(2) Sumedh Sontakke e outros. “Roboclip: Uma demonstração é suficiente para aprender as políticas dos robôs.” Avanços em sistemas de processamento de informações neurais 36 (2023): 55681-55693.

(3) Mintu Alakuijala e outros. “Crítico da linguagem de vídeo: funções de recompensa transferíveis para robótica condicionada à linguagem.” arXiv:2405.19988 (2024).

(4) Yecheng Jason Ma e outros. “Os modelos de linguagem de visão são aprendizes de valor no contexto.” A Décima Terceira Conferência Internacional sobre Representações de Aprendizagem. 2024.

Sobre os autores

| JiahuiZhang é um Ph.D. estudante de Ciência da Computação na Universidade do Texas em Dallas, orientado pelo Prof. Yu Xiang. Ele recebeu seu mestrado pela College of Southern California, onde trabalhou com o Prof. Joseph Lim e o Prof. |

| Jessé Zhang é pesquisador de pós-doutorado na Universidade de Washington, orientado pelo Prof. Dieter Fox e Prof. Ele completou seu doutorado. na College of Southern California, orientado pelo Prof. Jesse Thomason e Prof. Erdem Bıyık da USC, e Prof. |

Lucy Smith

é editor-chefe sênior da Robohub e AIhub.

Lucy Smith é editora-gerente sênior da Robohub e AIhub.