Com a crescente adoção de formatos de tabelas abertas como Iceberg Apache, Redshift da Amazon continua a aprimorar seus recursos para knowledge lakes de formato aberto. Em 2025, o Amazon Redshift forneceu diversas otimizações de desempenho que duplicaram o desempenho das consultas para cargas de trabalho Iceberg em Amazon Redshift sem servidorproporcionando desempenho e economia excepcionais para suas cargas de trabalho de knowledge lake.

Neste submit, descrevemos algumas das otimizações que levaram a esses ganhos de desempenho. Os knowledge lakes se tornaram a base da análise moderna, ajudando as organizações a armazenar grandes quantidades de dados estruturados e semiestruturados em formatos de dados econômicos, como Parquet Apache mantendo a flexibilidade através de formatos de tabela abertos. Essa arquitetura cria oportunidades únicas de otimização de desempenho em todo o pipeline de processamento de consultas.

Melhorias de desempenho

Nossos aprimoramentos mais recentes abrangem diversas áreas do mecanismo de processamento de consultas SQL do Amazon Redshift, incluindo scanners vetorizados que aceleram a execução, planos de consulta ideais alimentados por estatísticas de tempo de execução just-in-time (JIT), filtros Bloom distribuídos e novas regras de decorrelação.

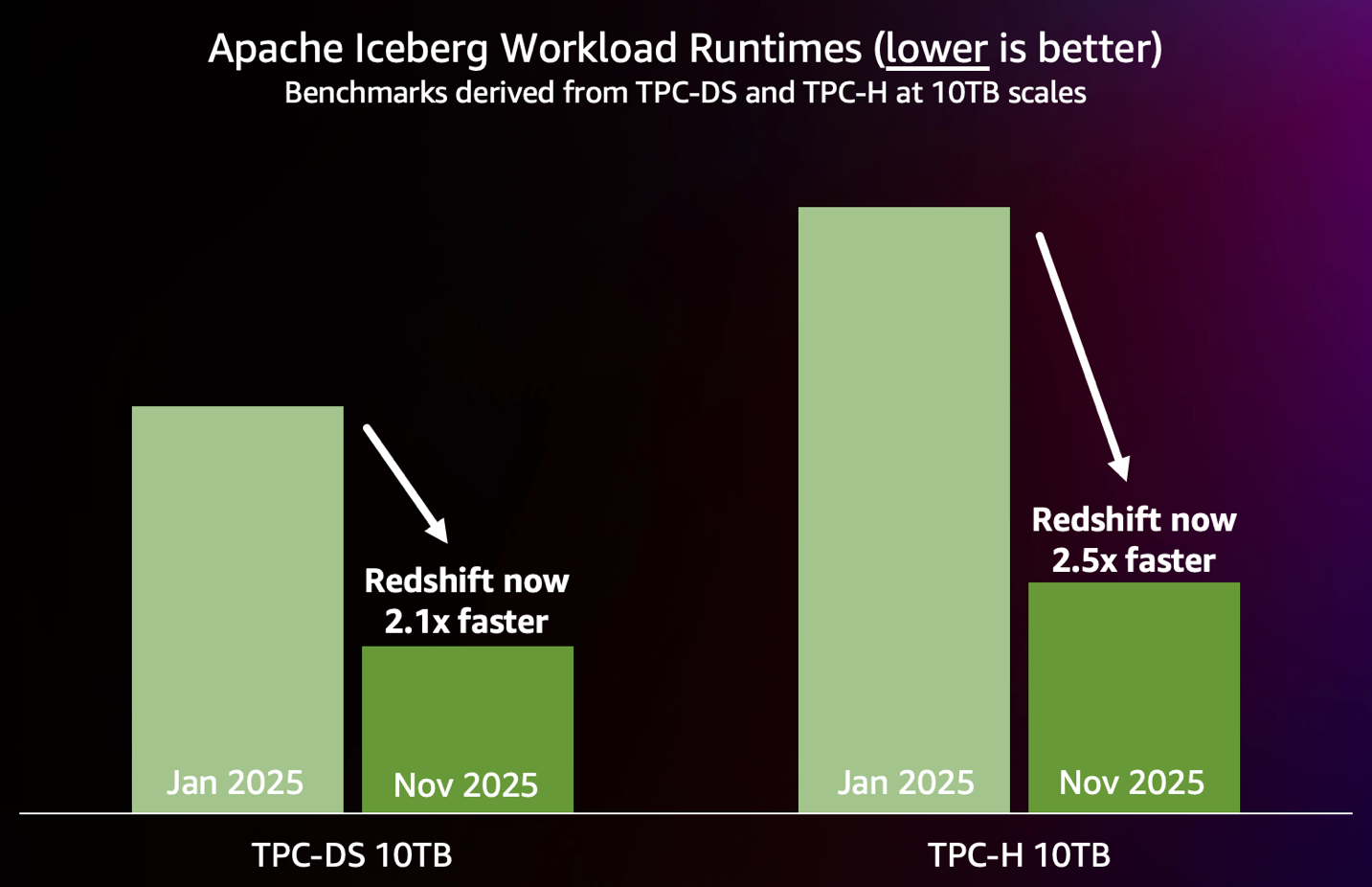

O gráfico a seguir resume as melhorias de desempenho alcançadas até agora em 2025, conforme medido pelos benchmarks TPC-DS e TPC-H padrão do setor de 10 TB executados em tabelas Iceberg em um endpoint Redshift Serverless de 88 RPU.

Encontre o melhor desempenho para suas cargas de trabalho

Os resultados de desempenho apresentados nesta postagem são baseados em benchmarks derivados dos benchmarks TPC-DS e TPC-H padrão da indústria e possuem as seguintes características:

- O esquema e os dados das tabelas Iceberg são usados sem modificações no TPC-DS. As tabelas são particionadas para refletir padrões de organização de dados reais.

- As consultas são geradas usando os kits oficiais TPC-DS e TPC-H com parâmetros de consulta gerados usando a semente aleatória padrão dos kits.

- O teste TPC-DS inclui todas as 99 consultas SELECT do TPC-DS. Não inclui etapas de manutenção e rendimento. O teste TPC-H inclui todas as 22 consultas SELECT do TPC-H.

- Os benchmarks são executados imediatamente: nenhum ajuste guide ou coleta de estatísticas é feito para as cargas de trabalho.

Nas seções a seguir, discutimos as principais melhorias de desempenho realizadas em 2025.

Varreduras de knowledge lake mais rápidas

Para melhorar o desempenho de leitura do knowledge lake, a equipe do Amazon Redshift criou uma camada de varredura completamente nova, projetada desde o início para knowledge lakes. Essa nova camada de varredura inclui um subsistema de E/S especialmente desenvolvido, incorporando recursos de pré-busca inteligente para reduzir a latência dos dados. Além disso, a nova camada de varredura é otimizada para processar arquivos Apache Parquet, o formato de arquivo mais comumente usado para Iceberg, por meio de varreduras vetorizadas rápidas.

Essa nova camada de varredura também inclui mecanismos sofisticados de remoção de dados que operam tanto em nível de partição quanto de arquivo, reduzindo drasticamente o quantity de dados que precisam ser varridos. Esse recurso de remoção funciona em harmonia com o sistema de pré-busca inteligente, criando uma abordagem coordenada que maximiza a eficiência durante todo o processo de recuperação de dados.

JIT ANALYZE para tabelas Iceberg

Ao contrário dos armazéns de dados tradicionais, os knowledge lakes muitas vezes carecem de estatísticas abrangentes em nível de tabela e coluna sobre os dados subjacentes, tornando um desafio para o planejador e otimizador no mecanismo de consulta escolher antecipadamente qual plano de execução será o mais splendid. Planos abaixo do splendid podem levar a um desempenho mais lento e menos previsível.

JIT ANALYZE é um novo recurso do Amazon Redshift que coleta e usa automaticamente estatísticas para tabelas Iceberg durante a execução de consultas, minimizando a coleta guide de estatísticas e fornecendo ao planejador e ao otimizador no mecanismo de consulta as informações necessárias para gerar planos de consulta ideais. O sistema usa heurística inteligente para identificar consultas que se beneficiarão das estatísticas, realiza amostragem rápida em nível de arquivo usando metadados Iceberg e extrapola estatísticas populacionais usando técnicas avançadas.

O JIT ANALYZE oferece desempenho pronto para uso quase igual ao de consultas que possuem estatísticas pré-calculadas, ao mesmo tempo que fornece a base para muitas outras otimizações de desempenho. Algumas consultas TPC-DS melhoraram 50 vezes mais rápido com essas estatísticas.

Otimizações de consulta

Para subconsultas correlacionadas, como aquelas que contêm cláusulas EXISTS/IN, o Amazon Redshift usa regras de decorrelação para reescrever as consultas. Em muitos casos, essas regras de decorrelação não produziam planos ideais, resultando em regressões de desempenho de execução de consultas. Para resolver isso, introduzimos um novo tipo de junção interna, SEMI JOIN, e uma nova regra de decorrelação baseada nesse tipo de junção. Esta regra de decorrelação ajuda a produzir os planos mais ideais, melhorando assim o desempenho de execução. Por exemplo, uma das consultas TPC-DS que contém a cláusula EXIST foi executada 7 vezes mais rápido com esta otimização.

Introduzimos a otimização distribuída do filtro Bloom para cargas de trabalho de knowledge lake. Os filtros Bloom distribuídos criam filtros Bloom localmente em cada nó de computação e depois os distribuem para todos os outros nós. A distribuição de filtros Bloom pode reduzir significativamente a quantidade de dados que precisam ser enviados pela rede para a junção, filtrando as tuplas mais cedo. Isso proporciona bons ganhos de desempenho para consultas grandes e complexas em knowledge lakes que processam e unem grandes quantidades de dados.

Conclusão

Essas melhorias de desempenho para cargas de trabalho Iceberg representam um grande avanço nos recursos de knowledge lake do Redshift. Ao nos concentrarmos no desempenho pronto para uso, simplificamos a obtenção de um desempenho de consulta excepcional sem ajustes ou otimizações complexas.

Estas melhorias demonstram o poder da inovação técnica profunda combinada com o foco prático no cliente. O JIT ANALYZE reduz a carga operacional do gerenciamento de estatísticas, ao mesmo tempo que fornece informações ideais de planejamento de consultas. O novo mecanismo de consulta de knowledge lake do Redshift no Redshift Serverless foi reescrito do zero para oferecer o melhor desempenho de verificação da categoria e estabelece as bases para otimizações de desempenho mais avançadas. As otimizações de semi-junção abordam alguns dos padrões de consulta mais desafiadores em cargas de trabalho analíticas. Você pode executar cargas de trabalho analíticas complexas em seus dados Iceberg e obter desempenho de consulta rápido e previsível.

O Amazon Redshift tem o compromisso de ser o melhor mecanismo de análise para cargas de trabalho de knowledge lake, e essas otimizações de desempenho representam nosso investimento contínuo nesse objetivo.

Para saber mais sobre o Amazon Redshift e seus recursos de desempenho, visite o Página do produto Amazon Redshift. Para começar com o Redshift, você pode tentar Amazon Redshift sem servidor e comece a consultar dados em minutos, sem precisar configurar e gerenciar a infraestrutura de knowledge warehouse. Para obter mais detalhes sobre as práticas recomendadas de desempenho, consulte o Guia do desenvolvedor de banco de dados Amazon Redshift. Para manter-se atualizado com os desenvolvimentos mais recentes no Amazon Redshift, assine o O que há de novo no Amazon Redshift Alimentação RSS.

Agradecimentos especiais aos colaboradores desta postagem: Martin Milenkoski, Gerard Louw, Konrad Werblinski, Mengchu Cai, Mehmet Bulut, Mohammed Alkateb e Sanket Hase