Gradiente descendente: visualizando os fundamentos do aprendizado de máquina

Imagem do Autor

Nota do editor: Este artigo faz parte de nossa série sobre como visualizar os fundamentos do aprendizado de máquina.

Bem-vindo à primeira entrada de nossa série sobre como visualizar os fundamentos do aprendizado de máquina. Nesta série, nosso objetivo será dividir conceitos técnicos importantes e muitas vezes complexos em guias visuais intuitivos para ajudá-lo a dominar os princípios básicos da área. Nossa primeira entrada se concentra no mecanismo de otimização do aprendizado de máquina: gradiente descendente.

O mecanismo de otimização

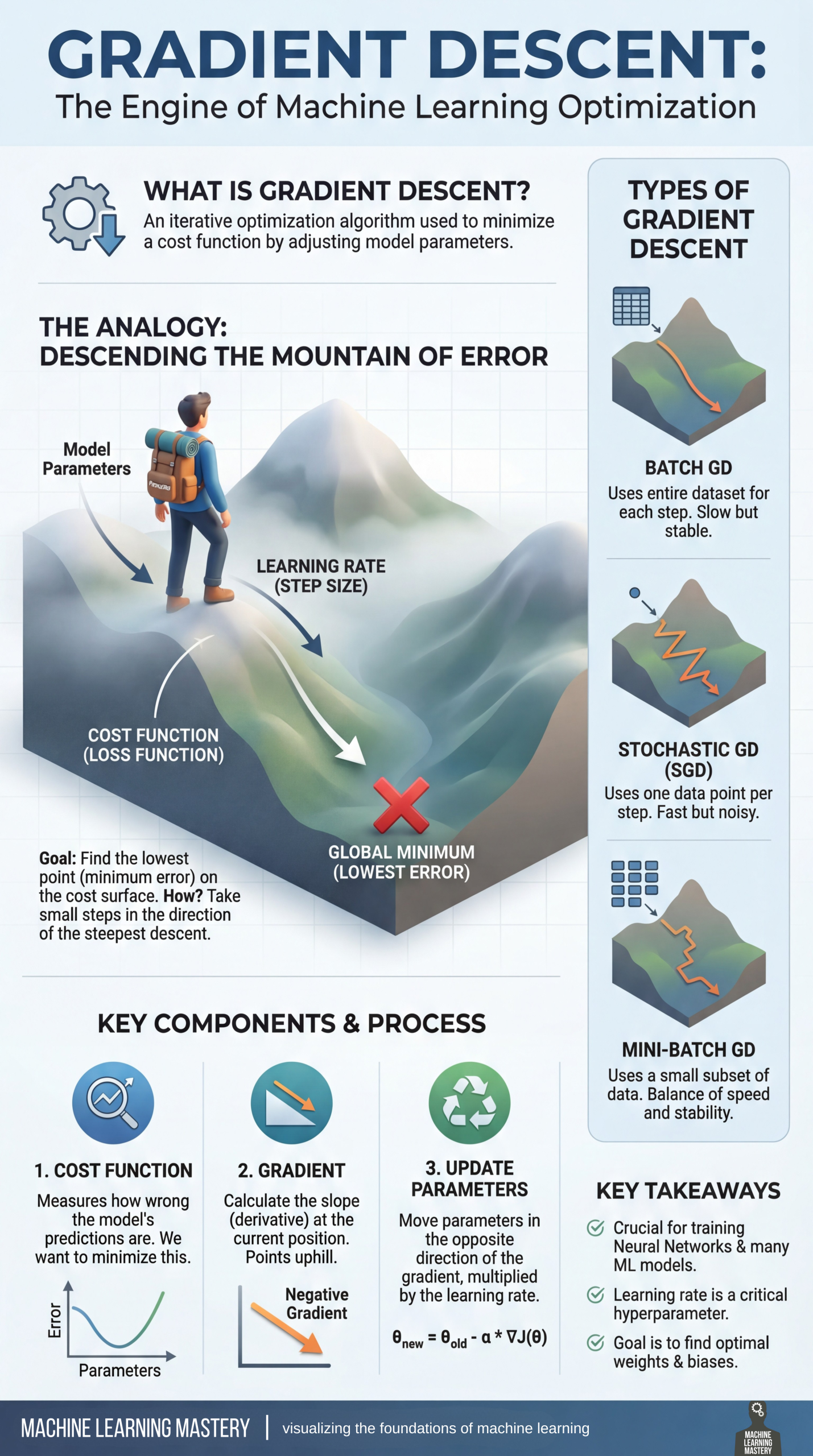

Descida gradiente é frequentemente considerado o mecanismo de otimização do aprendizado de máquina. Em sua essência, é um algoritmo de otimização iterativo usado para minimizar uma função de custo (ou perda) ajustando estrategicamente os parâmetros do modelo. Ao refinar esses parâmetros, o algoritmo ajuda os modelos a aprender com os dados e a melhorar seu desempenho ao longo do tempo.

Para entender como isso funciona, think about o processo de descendo a montanha do erro. O objetivo é encontrar o mínimo international, que é o ponto de erro mais baixo na superfície de custos. Para chegar a este nadir, é necessário dar pequenos passos na direção da descida mais íngreme. Esta jornada é guiada por três fatores principais: o modelo parâmetroso função de custo (ou perda)e o taxa de aprendizagemque determina o tamanho do passo.

Nosso visualizador destaca o ciclo generalizado de três etapas para otimização:

- Função de custo: Este componente mede o quão “erradas” estão as previsões do modelo; o objetivo é minimizar esse valor

- Gradiente: Esta etapa envolve o cálculo da inclinação (a derivada) na posição atual, que aponta para cima

- Parâmetros de atualização: Finalmente, os parâmetros do modelo são movidos na direção oposta do gradiente, multiplicados pela taxa de aprendizagem, para se aproximarem do mínimo

Dependendo dos seus dados e necessidades computacionais, existem três tipos principais de descida gradiente a serem considerados. Lote GD usa todo o conjunto de dados para cada etapa, que é lento, mas estável. No outro extremo do espectro, GD estocástico (SGD) usa apenas um ponto de dados por etapa, tornando-o rápido, mas barulhento. Para muitos, minilote GD oferece o melhor dos dois mundos, usando um pequeno subconjunto de dados para alcançar um equilíbrio entre velocidade e estabilidade.

A descida gradiente é essential para treinar redes neurais e muitos outros modelos de aprendizado de máquina. Tenha em mente que a taxa de aprendizagem é um hiperparâmetro crítico que determina o sucesso da otimização. A base matemática segue a fórmula

(

theta_{novo} = theta_{antigo} – a cdot nabla J(theta),

)

onde o objetivo closing é encontrar os pesos e vieses ideais para minimizar o erro.

O visualizador abaixo fornece um resumo conciso dessas informações para referência rápida.

Gradiente descendente: visualizando os fundamentos do aprendizado de máquina (clique para ampliar)

Imagem do Autor

Você pode Clique aqui para baixar um PDF do infográfico em alta resolução.

Recursos de domínio de aprendizado de máquina

Estes são alguns recursos selecionados para aprender mais sobre descida gradiente:

- Descida gradiente para aprendizado de máquina – Este artigo para iniciantes fornece uma introdução prática à descida gradiente, explicando seu procedimento elementary e variações como descida gradiente estocástica para ajudar os alunos a otimizar efetivamente os coeficientes do modelo de aprendizado de máquina.

Conclusão principal: Compreender a diferença entre descida gradiente em lote e estocástica. - Como implementar a otimização de gradiente descendente do zero – Este tutorial prático para iniciantes fornece um guia passo a passo para implementar o algoritmo de otimização gradiente descendente do zero em Python, ilustrando como navegar na derivada de uma função para localizar seu mínimo por meio de exemplos trabalhados e visualizações.

Conclusão principal: Como traduzir a lógica em um algoritmo funcional e como os hiperparâmetros afetam os resultados. - Uma introdução suave ao procedimento de gradiente descendente – Este artigo de nível intermediário fornece uma introdução prática ao procedimento de descida gradiente, detalhando a notação matemática e fornecendo um exemplo passo a passo resolvido de minimização de uma função multivariada para aplicações de aprendizado de máquina.

Conclusão principal: Dominar a notação matemática e lidar com problemas complexos e multivariáveis.

Fique atento a entradas adicionais em nossa série sobre como visualizar os fundamentos do aprendizado de máquina.