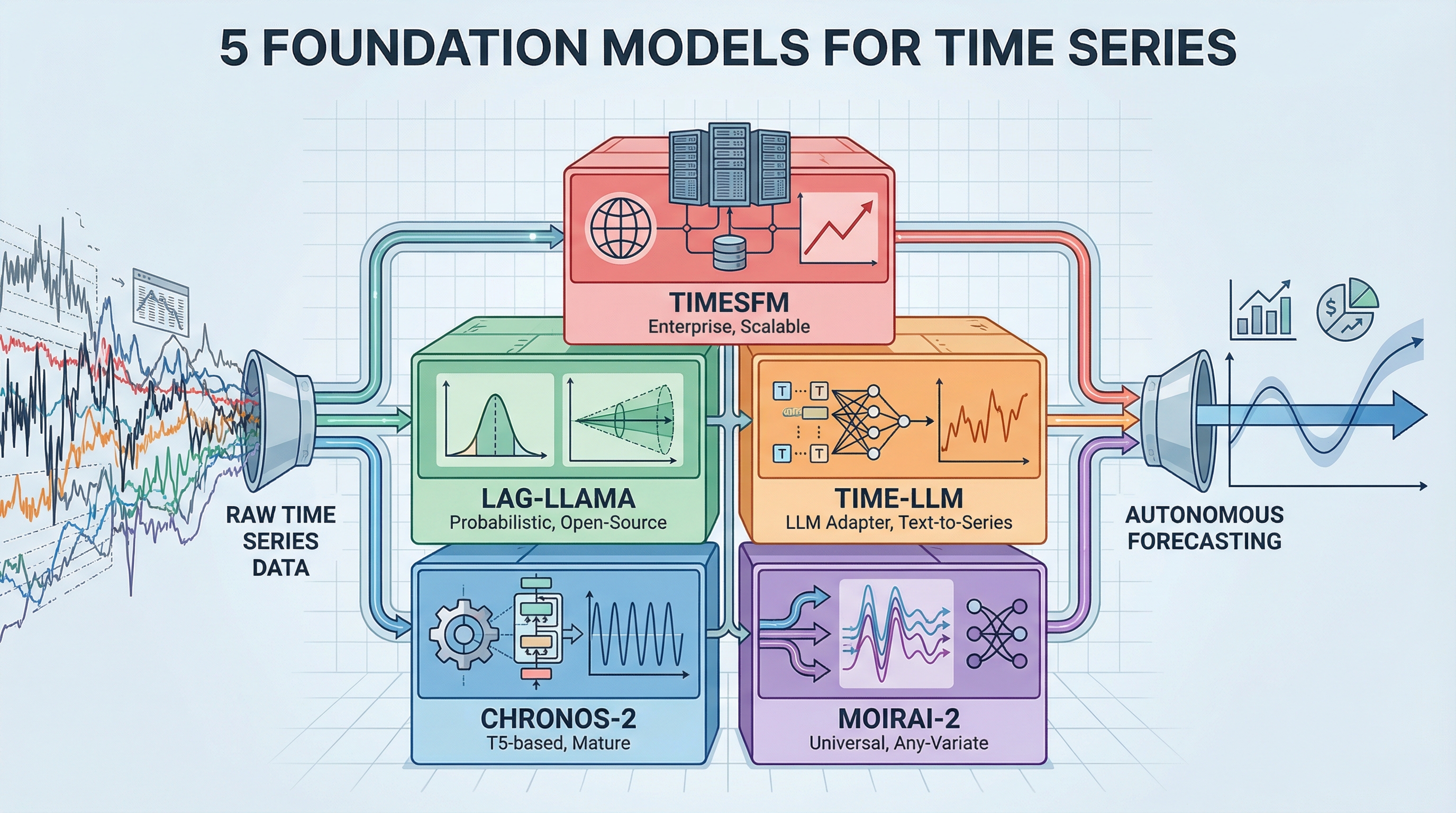

O equipment de ferramentas de série temporal de 2026: cinco modelos básicos para previsão autônoma

Imagem do autor

Introdução

A maior parte do trabalho de previsão envolve a construção de modelos personalizados para cada conjunto de dados – ajuste um ARIMA aqui, ajuste um LSTM ali, lute com Profetados hiperparâmetros. Os modelos de fundação invertem isso. Eles são pré-treinados em grandes quantidades de dados de séries temporais e podem prever novos padrões sem treinamento adicional, semelhante à forma como o GPT pode escrever sobre tópicos que nunca foram vistos explicitamente. Esta lista cobre os cinco modelos básicos essenciais que você precisa conhecer para construir sistemas de previsão de produção em 2026.

A mudança de modelos específicos de tarefas para a orquestração de modelos básicos muda a forma como as equipes abordam as previsões. Em vez de passar semanas ajustando parâmetros e discutindo conhecimentos de domínio para cada novo conjunto de dados, os modelos pré-treinados já entendem padrões temporais universais. As equipes obtêm implantação mais rápida, melhor generalização entre domínios e custos computacionais mais baixos sem uma extensa infraestrutura de aprendizado de máquina.

1. Amazon Chronos-2 (Fundação Preparada para Produção)

Amazon Chronos-2 é a opção mais madura para equipes que estão migrando para a previsão do modelo básico. Esta família de modelos de transformadores pré-treinados, baseados na arquitetura T5, tokeniza valores de séries temporais por meio de escalonamento e quantização — tratando a previsão como uma tarefa de modelagem de linguagem. A versão de outubro de 2025 expandiu os recursos para oferecer suporte à previsão informada univariada, multivariada e covariável.

O modelo oferece previsão zero-shot de última geração que supera consistentemente os modelos estatísticos ajustados, processando mais de 300 previsões por segundo em uma única GPU. Com milhões de downloads em Abraçando o rosto e integração nativa com ferramentas AWS como SageMaker e AutoGlúonChronos-2 tem a documentação e o suporte da comunidade mais fortes entre os modelos de fundação. A arquitetura vem em cinco tamanhos, de 9 milhões a 710 milhões de parâmetros, para que as equipes possam equilibrar o desempenho com as restrições computacionais. Confira a implementação em GitHubrevise a abordagem técnica no artigo de pesquisaou pegue modelos pré-treinados em Hugging Face.

2. Salesforce MOIRAI-2 (O Previsor Common)

Salesforce MOIRAI-2 aborda o desafio prático de lidar com dados confusos de séries temporais do mundo actual por meio de sua arquitetura common de previsão. Este modelo de base de transformador somente decodificador se adapta a qualquer frequência de dados, qualquer número de variáveis e qualquer comprimento de previsão dentro de uma única estrutura. O mecanismo de “Atenção Qualquer Variável” do modelo se ajusta dinamicamente a séries temporais multivariadas sem exigir dimensões de entrada fixas, diferenciando-o dos modelos projetados para estruturas de dados específicas.

MOIRAI-2 ocupa uma posição elevada na tabela de classificação GIFT-Eval entre os modelos sem vazamento de dados, com forte desempenho em tarefas de distribuição e de disparo zero. O treinamento no conjunto de dados LOTSA – 27 bilhões de observações em nove domínios – dá ao modelo uma generalização robusta para novos cenários de previsão. As equipes se beneficiam do desenvolvimento totalmente de código aberto com manutenção ativa, tornando-o valioso para aplicações complexas do mundo actual que envolvem múltiplas variáveis e frequências irregulares. O projeto Repositório GitHub inclui detalhes de implementação, enquanto o artigo técnico e Postagem no weblog do Salesforce explicar a abordagem de previsão common. Os modelos pré-treinados estão ativados Abraçando o rosto.

3. Lag-Llama (a espinha dorsal de código aberto)

Lag-Lhama traz recursos de previsão probabilística para modelos básicos por meio de um transformador somente decodificador inspirado na arquitetura LLaMA da Meta. Ao contrário dos modelos que produzem apenas previsões pontuais, o Lag-Llama gera distribuições de probabilidade completas com intervalos de incerteza para cada etapa de previsão — a incerteza quantificada que os processos de tomada de decisão precisam. O modelo usa recursos defasados como covariáveis e mostra um forte aprendizado em poucas tentativas quando ajustado em pequenos conjuntos de dados.

A natureza totalmente de código aberto com licenciamento permissivo torna o Lag-Llama acessível a equipes de qualquer tamanho, enquanto sua capacidade de rodar em CPU ou GPU take away barreiras de infraestrutura. O apoio acadêmico por meio de publicações nas principais conferências de aprendizado de máquina acrescenta validação. Para equipes que priorizam transparência, reprodutibilidade e resultados probabilísticos em vez de métricas brutas de desempenho, o Lag-Llama oferece um spine de modelo de base confiável. O Repositório GitHub contém código de implementação e o artigo de pesquisa detalha a metodologia de previsão probabilística.

4. Time-LLM (o adaptador LLM)

Tempo-LLM adota uma abordagem diferente, convertendo grandes modelos de linguagem existentes em sistemas de previsão sem modificar os pesos do modelo unique. Essa estrutura de reprogramação traduz patches de séries temporais em protótipos de texto, permitindo que LLMs congelados como GPT-2, LLaMA ou BERT entendam padrões temporais. A técnica “Immediate-as-Prefix” injeta conhecimento de domínio por meio de linguagem pure, para que as equipes possam usar sua infraestrutura de modelo de linguagem existente para tarefas de previsão.

Essa abordagem de adaptador funciona bem para organizações que já executam LLMs em produção, pois elimina a necessidade de implantar e manter modelos de previsão separados. A estrutura oferece suporte a vários modelos de spine, facilitando a alternância entre diferentes LLMs à medida que versões mais recentes são disponibilizadas. O Time-LLM representa a abordagem de “IA agente” para previsão, onde os recursos de compreensão de linguagem de uso geral são transferidos para o reconhecimento de padrões temporais. Acesse a implementação através do Repositório GitHubou revise a metodologia no artigo de pesquisa.

5. Google TimesFM (o grande padrão tecnológico)

Google Instances FM fornece previsão de modelo básico de nível empresarial, apoiada por uma das maiores organizações de pesquisa tecnológica. Esse modelo somente de decodificador baseado em patch, pré-treinado em 100 bilhões de pontos no tempo do mundo actual a partir de conjuntos de dados internos do Google, oferece forte desempenho de disparo zero em vários domínios com configuração mínima. O design do modelo prioriza a implantação da produção em escala, refletindo suas origens nas cargas de trabalho de previsão internas do Google.

O TimesFM é testado em batalha por meio de uso extensivo nos ambientes de produção do Google, o que aumenta a confiança das equipes que implantam modelos básicos em cenários de negócios. O modelo equilibra desempenho e eficiência, evitando a sobrecarga computacional de alternativas maiores e mantendo a precisão competitiva. O suporte contínuo do Google Analysis significa desenvolvimento e manutenção contínuos, tornando o TimesFM uma escolha confiável para equipes que buscam recursos de modelo básico de nível empresarial. Acesse o modelo através do Repositório GitHubrevise a arquitetura no artigo técnicoou leia os detalhes da implementação no Postagem do weblog de pesquisa do Google.

Conclusão

Os modelos básicos transformam a previsão de séries temporais de um problema de treinamento de modelo em um desafio de seleção de modelo. Chronos-2 oferece maturidade de produção, MOIRAI-2 lida com dados multivariados complexos, Lag-Llama fornece resultados probabilísticos, Time-LLM aproveita a infraestrutura LLM existente e TimesFM oferece confiabilidade empresarial. Avalie modelos com base em suas necessidades específicas em relação à quantificação de incertezas, suporte multivariado, restrições de infraestrutura e escala de implantação. Comece com uma avaliação zero-shot em conjuntos de dados representativos para identificar qual modelo básico atende às suas necessidades de previsão antes de investir em ajuste fino ou desenvolvimento personalizado.