Os modelos de linguagem grande (LLMs) avançaram além do simples preenchimento automático, prevendo a próxima palavra ou frase. Desenvolvimentos recentes permitem que os LLMs entendam e sigam instruções humanas, executem tarefas complexas e até mesmo participem de conversas. Esses avanços são impulsionados pelo ajuste fino de LLMs com conjuntos de dados especializados e aprendizagem por reforço com suggestions humano (RLHF). A RLHF está redefinindo a forma como as máquinas aprendem e interagem com as informações humanas.

O que é RLHF?

RLHF é uma técnica que treina um grande modelo de linguagem para alinhar seus resultados com as preferências e expectativas humanas usando suggestions humano. Os humanos avaliam as respostas do modelo e fornecem classificações, que o modelo utiliza para melhorar seu desempenho. Este processo iterativo ajuda os LLMs a refinar a sua compreensão das instruções humanas e a gerar resultados mais precisos e relevantes. A RLHF desempenhou um papel crítico na melhoria do desempenho de InstruirGPTSparrow, Claude e outros, permitindo-lhes superar os LLMs tradicionais, como o GPT-3.

Vamos entender como funciona o RLHF.

RLHF vs Não-RLHF

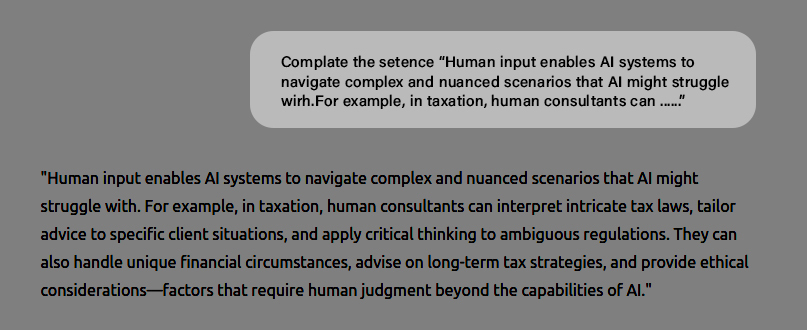

Grandes modelos de linguagem foram originalmente projetados para prever a próxima palavra ou token para completar uma frase com base na entrada conhecida como ‘immediate’. Por exemplo, para completar uma instrução, você solicita ao GPT-3 a seguinte entrada:

Incitar: Full a frase “A contribuição humana permite IA sistemas para navegar em cenários complexos e cheios de nuances que IA pode ter dificuldades. Por exemplo, na tributação, os consultores humanos podem …….”

O modelo então completa com sucesso a instrução da seguinte forma:

“A contribuição humana permite IA sistemas para navegar em cenários complexos e cheios de nuances que IA pode ter dificuldades. Por exemplo, na fiscalidade, os consultores humanos podem interpretar leis fiscais complexas, adaptar o aconselhamento a situações específicas dos clientes e aplicar o pensamento crítico a regulamentações ambíguas.”

Perguntando LLM para continuar um immediate

No entanto, espera-se que grandes modelos de linguagem façam mais do que apenas preencher um immediate. Os LLMs são obrigados a escrever histórias, e-mails, poemas, códigos e muito mais.

Exemplos RLHF vs não RLHF

Aqui estão alguns exemplos que mostram a diferença entre não-RLHF LLM (Próximo preditor de token) e RLHF LLM (treinado em suggestions humano).

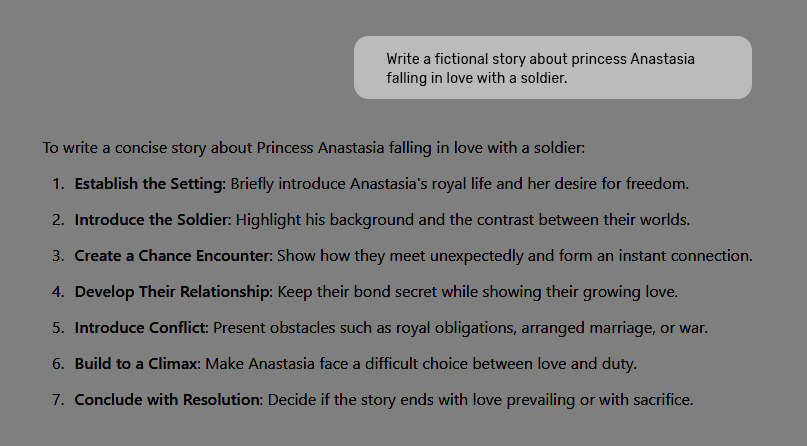

Saída não RLHF – História

Quando você diz ao GPT-3 para ‘escrever uma história fictícia sobre a princesa Anastasia se apaixonando por um soldado’, um modelo não RLHF gera resultados como:

Incitar: Escreva uma história fictícia sobre a Princesa Anastasia se apaixonando por um soldado.

No entanto, espera-se que grandes modelos de linguagem façam mais do que apenas preencher um immediate. Os LLMs são obrigados a escrever histórias, e-mails, poemas, códigos e muito mais.

Exemplos RLHF vs não RLHF

Aqui estão alguns exemplos que mostram a diferença entre não-RLHF LLM (Próximo preditor de token) e RLHF LLM (treinado em suggestions humano).

Saída não RLHF – História

Quando você diz ao GPT-3 para ‘escrever uma história fictícia sobre a princesa Anastasia se apaixonando por um soldado’, um modelo não RLHF gera resultados como:

Incitar: Escreva uma história fictícia sobre a Princesa Anastasia se apaixonando por um soldado.

O modelo sabe escrever histórias, mas não consegue entender a solicitação porque os LLMs são treinados em scraps de web que estão menos familiarizados com comandos como ‘escrever uma história/e-mail’, seguidos de uma história ou do próprio e-mail. Prever a próxima palavra é fundamentalmente diferente de seguir instruções de forma inteligente.

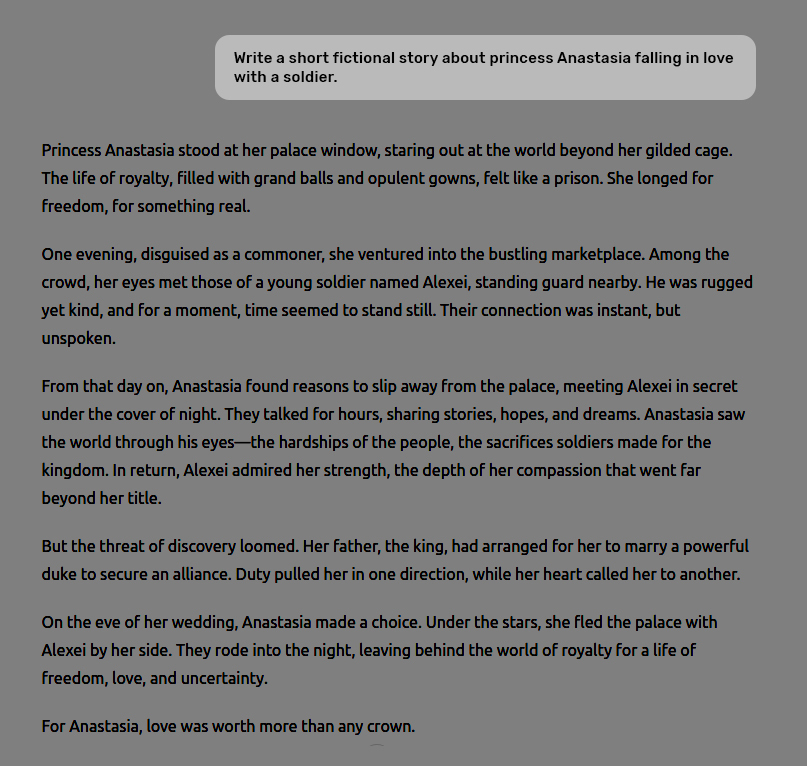

Saída RLHF – História

Aqui está o que você obtém quando o mesmo immediate é fornecido a um Modelo RLHF treinado no suggestions humano.

Incitar: Escreva uma história fictícia sobre a Princesa Anastasia se apaixonando por um soldado.

Agora, o LLM gerou a resposta desejada.

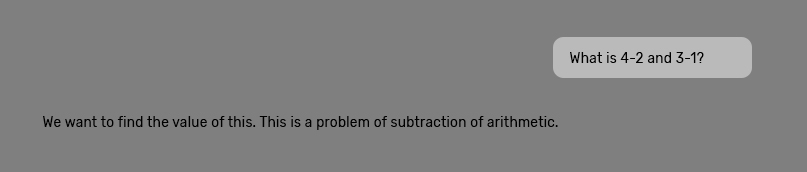

Saída não RLHF – Matemática

Incitar: O que é 4-2 e 3-1?

O modelo não-RLHF não responde à pergunta e a considera parte de um diálogo de história.

Saída RLHF – Matemática

Dica: O que é 4-2 e 3-1?

O modelo RLHF entende o immediate e gera a resposta corretamente.

Como funciona o RLHF?

Vamos entender como um grande modelo de linguagem é treinado com base no suggestions humano para responder adequadamente.

Etapa 1: começando com modelos pré-treinados

O processo de RLHF começa com um modo de linguagem pré-treinado ou um preditor de próximo token.

Etapa 2: ajuste fino do modelo supervisionado

São criados vários prompts de entrada sobre as tarefas que você deseja que o modelo conclua e uma resposta perfect escrita por humanos para cada immediate. Em outras palavras, um conjunto de dados de treinamento que consiste em pares

Etapa 3: Criando um modelo de recompensa por suggestions humano

Esta etapa envolve a criação de um modelo de recompensa para avaliar quão bem o LLM a produção atende às expectativas de qualidade. Como um LLMum modelo de recompensa é treinado em um conjunto de dados de respostas avaliadas por humanos, que servem como a “verdade básica” para avaliar a qualidade da resposta. Com certas camadas removidas para otimizá-lo para pontuação em vez de geração, ele se torna uma versão menor do LLM. O modelo de recompensa recebe a entrada e LLM-gerada como entrada e, em seguida, atribui uma pontuação numérica (uma recompensa escalar) à resposta.

Assim, os anotadores humanos avaliam o LLMresultados gerados classificando sua qualidade com base na relevância, precisão e clareza.

Etapa 4: Otimizando com base na recompensa Aprendizagem por Reforço Política

A etapa ultimate no processo RLHF é treinar uma política RL (essencialmente um algoritmo que resolve qual palavra ou token gerar em seguida na sequência de texto) que aprende a gerar o texto que o modelo de recompensa prevê que os humanos prefeririam.

Em outras palavras, a política de RL aprende a pensar como um ser humano, maximizando o suggestions do modelo de recompensa.

É assim que um modelo sofisticado de linguagem grande como o ChatGPT é criado e ajustado.

Palavras Finais

Os grandes modelos linguísticos fizeram progressos consideráveis nos últimos anos e continuam a fazê-lo. Técnicas como RLHF levaram a modelos inovadores como ChaGPT e Gemini, revolucionando IA respostas em diferentes tarefas. Notavelmente, ao incorporar o suggestions humano no processo de ajuste fino, os LLMs não só são melhores a seguir instruções, mas também estão mais alinhados com os valores e preferências humanas, o que os ajuda a compreender melhor os limites e os propósitos para os quais foram concebidos.

O RLHF está transformando grandes modelos de linguagem (LLMs), melhorando a precisão de seus resultados e a capacidade de seguir instruções humanas. Ao contrário dos LLMs tradicionais, que foram originalmente projetados para prever a próxima palavra ou token, os modelos treinados em RLHF usam suggestions humano para ajustar as respostas, alinhando as respostas com as preferências do usuário.

Resumo: O RLHF está transformando grandes modelos de linguagem (LLMs), melhorando a precisão de seus resultados e a capacidade de seguir instruções humanas. Ao contrário dos LLMs tradicionais, que foram originalmente projetados para prever a próxima palavra ou token, os modelos treinados em RLHF usam suggestions humano para ajustar as respostas, alinhando as respostas com as preferências do usuário.

A postagem Como a RLHF está transformando a precisão e a eficácia da resposta do LLM apareceu primeiro em Datafloq.