A AWS revelou hoje uma série de novas atualizações para suas ferramentas de IA durante sua conferência re:Invent, incluindo melhorias em seu ambiente de treinamento de modelo de IA SageMaker HyperPod, bem como em Bedrock, seu ambiente para construção de aplicativos generativos de IA usando modelos básicos.

A revolução GenAI entrou oficialmente em seu terceiro ano durante o re:Invent 2024, que espalhou 65.000 AWS clientes, fornecedores e imprensa em grande parte da Las Vegas Strip. OpenAI desencadeou a tempestade GenAI com o lançamento do ChatGPT em 30 de novembro de 2022, e ela vem aumentando desde então.

A AWS já trouxe muitos recursos GenAI para sua nuvem e o lançamento continuou esta semana. A empresa revelou várias melhorias no SageMaker HyperPod, lançado há um ano para acelerar o treinamento de modelos de base.

Diferentes equipes de IA têm diferentes necessidades de treinamento. Algumas equipes podem precisar de uma grande quantidade de computação acelerada por um curto período de tempo, enquanto outras podem precisar de quantidades menores durante um longo período de tempo. Com o nova capacidade de governança de tarefas revelado hoje, as equipes de desenvolvimento de IA podem criar planos de treinamento flexíveis que o SageMaker Hyperpod executará usando blocos de capacidade EC2.

A nova capacidade alocará dinamicamente a carga de trabalho para permitir que os clientes obtenham trabalho mais útil de seus grandes clusters em determinados momentos, como quando cientistas de dados e engenheiros de IA vão dormir, disse Rahul Pathak, vice-presidente de dados e IA da AWS. “Normalmente você não quer que esses sistemas caros fiquem ociosos”, disse ele durante uma coletiva de imprensa no re:Invent Tuesday.

A AWS criou governança de tarefas para melhorar a utilização da computação e decidiu disponibilizá-la aos clientes, disse Pathak. A capacidade pode aumentar a utilização da computação em até 90%, disse ele.

A empresa também revelou novas “receitas” que ajudam os clientes a começar a treinar diferentes modelos, como Llama ou Mistral, com mais rapidez. A AWS agora tem mais de 30 receitas de treinamento de modelos selecionadas.

É mais fácil mudar o SageMaker HyperPod para usar diferentes tipos de processadores, como GPUs Nvidia ou os próprios chips Trainium da AWS, graças aos novos planos de treinamento flexíveis que a AWS revelou hoje.

“Com apenas alguns cliques, os clientes podem especificar seu orçamento, an information de conclusão desejada e a quantidade máxima de recursos computacionais necessários”, disse a AWS em um comunicado à imprensa. “O SageMaker HyperPod reserva capacidade automaticamente, configura clusters e cria trabalhos de treinamento de modelo, economizando semanas de tempo de treinamento de modelo para as equipes.”

A AWS também fez vários anúncios sobre Bedrock, a coleção de ferramentas foi lançado em abril de 2023 para construir aplicativos generativos de IA usando seus próprios modelos básicos pré-treinados, sugar Titan, bem como modelos de terceiros do AI21 Labs, Anthropic e Stability AI, entre outros.

Os clientes da Bedrock podem usar a nova família de modelos Nova que a AWS anunciado na terça-feiraincluindo Nova Micro, Nova Lite, Nova Professional, Nova Premier, Nova Canvas e Amazon Nova Reel. Os clientes também podem usar modelos de fundação de À beira da piscina, IA de estabilidadee Luma IAe dezenas de outros por meio do Bedrock Market, que a AWS também lançou hoje. A AWS afirma que o Bedrock Market tem atualmente mais de 100 modelos.

Os prompts de IA podem ser repetitivos. Para ajudar a economizar dinheiro dos clientes ao enviar a mesma solicitação repetidamente, a AWS revelou um novo recurso Bedrock chamado cache de immediate. De acordo com Pathak, ao armazenar automaticamente prompts repetitivos em cache, a AWS pode não apenas reduzir os custos em até 90% para os usuários do Bedrock, mas também reduzir a latência em até 85%.

Os modelos de IA podem ser imprevisíveis; essa é a natureza dos sistemas probabilísticos. Para evitar alguns dos piores comportamentos, a AWS oferece suporte a proteções no Bedrock, mas apenas para modelos de linguagem. Hoje, atualizou os guarda-corpos para suportar detecção de toxicidade multimodal em imagens geradas com modelos de fundação Bedrock.

Bedrock Knowledge Automation (BDA) é outro recurso revelado hoje que permite que a Bedrock Information Base suporte dados não estruturados, como documentos, imagens e dados mantidos em tabelas, em seus aplicativos GenAI. O novo recurso Bedrock deve tornar mais fácil para os desenvolvedores construir processamento inteligente de documentos, análise de mídia e outras soluções de automação multimodais centradas em dados, disse a AWS.

“Colocar esses dados em um formato que possa ser usado… não é simples”, disse Pathak. Bedrock Knowledge Automation é essencialmente “ETL desenvolvido por LLM para dados não estruturados”, acrescentou. “É realmente sofisticado e oferece aos clientes a capacidade de desbloquear os dados para inferência com uma única API.”

O BDA está integrado às Bases de Conhecimento Bedrock, o que deve facilitar a incorporação das informações do conteúdo multimodal para aplicativos GenAI usando técnicas de geração aumentada de recuperação (RAG).

A IA é baseada principalmente em dados não estruturados, como texto e imagens. Mas os clientes têm uma tonelada de dados estruturados armazenados em aplicativos de negócios, bem como em knowledge warehouses, knowledge lakes e lakehouses. Para ajudar os clientes a utilizar essas informações em seus aplicativos GenAI, AWS anunciou suporte para dados estruturados (ou multimodais) na Base de Conhecimento Bedrock.

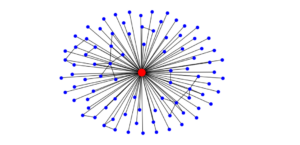

AWS também anunciou GraphRAG suporte na Base de Conhecimento Bedrock. GraphRAG é uma abordagem cada vez mais widespread para o desenvolvimento de aplicativos GenAI que utiliza um banco de dados gráfico para encontrar os dados mais contextualmente relevantes e alimentá-los em um fluxo de trabalho RAG. A AWS afirma que o GraphRAG ajuda a melhorar a qualidade da saída e a reduzir as alucinações ainda mais do que o RAG por si só.

Itens relacionados:

AWS assume o Google Spanner com bancos de dados distribuídos alimentados por relógio atômico

AWS lança serviço hospedado Apache Iceberg no S3, nova camada de gerenciamento de metadados

Novo serviço da AWS permite que empresas carreguem dados para a nuvem a partir de terminais seguros