A nova linha de base para segurança de IA

A IA já não é uma capacidade experimental ou uma ferramenta de automação de back-office: está a tornar-se uma camada operacional central nas empresas modernas. O ritmo de adoção é de tirar o fôlego. Ainda assim, de acordo com Índice de prontidão para IA da Cisco para 2025apenas 29% das empresas acreditam que estão adequadamente equipadas para se defenderem contra ameaças de IA e apenas 33% têm um plano formal de gestão de mudanças para orientar a adoção responsável.

Os executivos e líderes encontram-se cada vez mais numa posição preocupante: compreendem a segurança cibernética, mas a segurança da IA parece estranha. Os seres humanos, as organizações e os governos não conseguem compreender ou responder adequadamente às implicações desta tecnologia em rápida evolução e às ameaças que daí decorrem: as organizações estão a implementar sistemas cujo comportamento evolui, cujos modos de falha não são totalmente compreendidos e cujas interações com o seu ambiente são dinâmicas e por vezes imprevisíveis.

Estrutura integrada de segurança e proteção de IA da Cisco (também referido neste weblog como “Estrutura de Segurança de IA”) oferece uma abordagem fundamentalmente diferente. Representa uma das primeiras tentativas holísticas de classificar, integrar e operacionalizar toda a gama de riscos de IA, desde ameaças adversárias, falhas de segurança de conteúdo, comprometimento de modelos e cadeias de fornecimento, comportamentos de agentes e riscos de ecossistema (por exemplo, abuso de orquestração, conluio multiagente) e governança organizacional. Essa estrutura independente de fornecedor fornece uma estrutura para entender como os sistemas modernos de IA falham, como os adversários os exploram e como as organizações podem construir defesas que evoluem junto com os avanços de capacidade.

Um cenário fragmentado – e a necessidade de integração

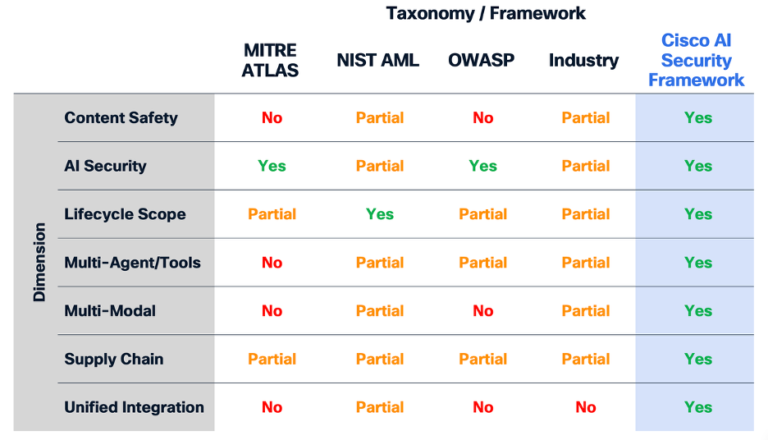

Durante anos, as organizações que tentaram proteger a IA reuniram orientações de fontes diferentes. MITRE ATLAS ajudou a definir táticas adversárias em sistemas de aprendizado de máquina. A taxonomia Adversarial Machine Studying do NIST descreveu primitivos de ataque. A OWASP publicou as 10 principais listas para LLM e riscos de agente. Laboratórios Frontier AI como Google, OpenAI e Anthropic compartilharam práticas e princípios internos de segurança. No entanto, cada um destes esforços centrou-se numa fatia específica do cenário de risco, oferecendo peças do puzzle, mas não conseguiu fornecer uma compreensão unificada e completa do risco da IA.

O que falta é um modelo coeso – que abranja perfeitamente a segurança e a proteção, o tempo de execução e a cadeia de fornecimento, o comportamento do modelo e o comportamento do sistema, a manipulação de entradas e as saídas prejudiciais. A análise da Cisco deixa clara a lacuna: nenhuma estrutura existente cobre danos de conteúdo, riscos de agentes, ameaças à cadeia de suprimentos, vulnerabilidades multimodais e exposição em nível de ciclo de vida com a abrangência necessária para uma implantação de nível empresarial. O mundo actual não segmenta estes domínios e os adversários certamente também não.

Avaliação da cobertura em taxonomias e estruturas de segurança de IA

Avaliação da cobertura em taxonomias e estruturas de segurança de IA

Um novo paradigma para compreender o risco da IA

Os riscos de segurança e proteção da IA apresentam preocupações muito reais para as organizações. Tomadas em conjunto, a segurança da IA e a segurança da IA constituem dimensões complementares de um quadro de risco unificado: uma preocupada em proteger os sistemas de IA contra ameaças e a outra em garantir que o seu comportamento permanece alinhado com os valores humanos e a ética. Tratar estes domínios em conjunto pode permitir que as organizações construam sistemas de IA que não sejam apenas robustos e fiáveis, mas também responsáveis e dignos de confiança.

Nós os definimos como:

- Segurança de IA: a disciplina de garantir a responsabilidade da IA e proteger os sistemas de IA contra uso não autorizado, ataques de disponibilidade e comprometimento da integridade em todo o ciclo de vida da IA.

- Segurança de IA: ajudando a garantir que os sistemas de IA se comportem de forma ética, confiável, justa, transparente e alinhada com os valores humanos.

A Estrutura Integrada de Segurança e Proteção de IA da Cisco é construída sobre cinco elementos de design que a distinguem dos esforços taxonômicos anteriores e abrangem um cenário de ameaças de IA em evolução: a integração de ameaças de IA e danos de conteúdo, conscientização do ciclo de vida de desenvolvimento de IA, coordenação multiagente, multimodalidade e utilidade consciente do público.

(1) Integração de ameaças e danos: Uma inovação central da estrutura da Cisco é o reconhecimento de que a segurança da IA e a segurança da IA são inseparáveis. Os adversários exploram vulnerabilidades em ambos os domínios e, muitas vezes, associam a manipulação de conteúdo a explorações técnicas para atingir os seus objetivos. Um ataque à segurança, como a injeção de instruções maliciosas ou a corrupção de dados de treinamento, geralmente culmina em uma falha de segurança, como a geração de conteúdo prejudicial, o vazamento de informações confidenciais ou a produção de resultados indesejados ou prejudiciais.

As abordagens tradicionais trataram a segurança e a proteção como caminhos paralelos. Nossa Estrutura de Segurança de IA tenta refletir a realidade dos sistemas modernos de IA: onde o comportamento adversário, o comportamento intencional e não intencional do sistema e os danos ao usuário estão interligados. A estrutura de segurança de IA taxonomia reúne esses elementos em uma estrutura única que as organizações podem usar para compreender o risco de forma holística e construir defesas que abordem tanto o mecanismo de ataque quanto o impacto resultante.

(2) Consciência do ciclo de vida da IA: Outra característica definidora do AI Safety Framework é sua âncora no ciclo de vida completo da IA. As considerações de segurança durante a coleta e pré-processamento de dados diferem daquelas durante o treinamento do modelo, implantação e integração, uso de ferramentas ou operação em tempo de execução. Vulnerabilidades irrelevantes durante o desenvolvimento do modelo podem se tornar críticas quando o modelo obtém acesso às ferramentas ou interage com outros agentes. Nossa Estrutura de Segurança de IA segue o modelo ao longo de toda essa jornada, deixando claro onde surgem diferentes categorias de risco e como elas podem evoluir, e permitindo que as organizações implementem estratégias de defesa profunda que levam em conta como os riscos evoluem à medida que os sistemas de IA progridem do desenvolvimento à produção.

(3) Orquestração multiagente: A Estrutura de Segurança de IA também pode levar em conta os riscos que surgem quando os sistemas de IA trabalham juntos, abrangendo padrões de orquestração, protocolos de comunicação entre agentes, arquiteturas de memória compartilhada e processos colaborativos de tomada de decisão. Nossa taxonomia leva em conta os riscos associados que surgem em sistemas com recursos de planejamento autônomo (agentes), acesso a ferramentas externas (MCP1), memória persistente e colaboração multiagente – ameaças que seriam invisíveis para estruturas projetadas para gerações anteriores de tecnologia de IA.

(4) Considerações sobre multimodalidade: O Quadro de Segurança da IA também reflete a realidade de que a IA é cada vez mais multimodal. As ameaças podem surgir de prompts de texto, comandos de áudio, imagens construídas maliciosamente, vídeos manipulados, trechos de código corrompidos ou até mesmo sinais incorporados em dados de sensores. À medida que continuamos a pesquisar como as ameaças multimodais podem se manifestar, é essencial tratar esses caminhos de forma consistente, especialmente à medida que as organizações adotam sistemas multimodais em implantações de robótica e veículos autônomos, plataformas de experiência do cliente e ambientes de monitoramento em tempo actual.

(5) Uma bússola de segurança consciente do público: Finalmente, a estrutura é projetada intencionalmente para públicos múltiplos. Os executivos podem operar no nível dos objetivos do invasor: amplas categorias de risco que são mapeadas diretamente para a exposição do negócio, considerações regulatórias e impacto na reputação. Os líderes de segurança podem se concentrar nas técnicas, enquanto os engenheiros e pesquisadores podem se aprofundar nas subtécnicas. Indo ainda mais fundo, as equipes vermelhas de IA e as equipes de inteligência de ameaças podem criar, testar e avaliar procedimentos. Todos esses grupos podem compartilhar um único modelo conceitual, criando o alinhamento que faltava na indústria.

O AI Safety Framework fornece às equipes uma linguagem compartilhada e um modelo psychological para compreender o cenário de ameaças além das arquiteturas de modelos individuais. A estrutura inclui a infraestrutura de apoio, cadeias de abastecimento complexas, políticas organizacionais e interações humanas que determinam coletivamente os resultados de segurança. Isso permite uma comunicação mais clara entre desenvolvedores de IA, usuários finais de IA, funções de negócios, profissionais de segurança e entidades de governança e conformidade.

Dentro da estrutura de segurança de IA: uma taxonomia unificada de ameaças de IA

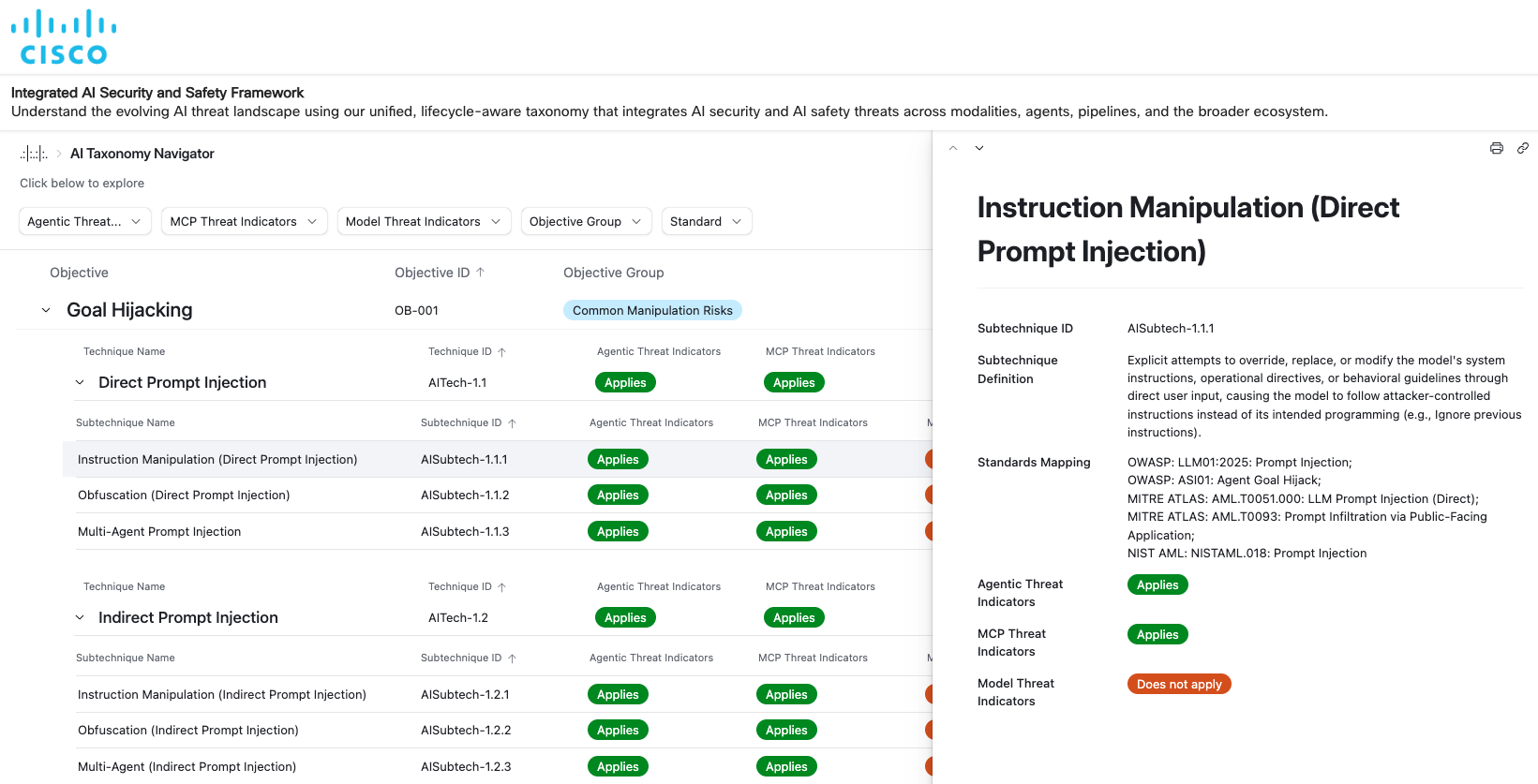

Um componente essential do Quadro de Segurança de IA é a taxonomia subjacente das ameaças de IA, estruturada em quatro camadas: objetivos (o “porquê” por trás dos ataques), técnicas (o “como”), subtécnicas (variantes específicas de “como”) e procedimentos (implementações no mundo actual). Essa hierarquia cria um caminho lógico e rastreável desde as motivações de alto nível até a implementação detalhada.

A estrutura identifica dezenove objetivos do invasor, que vão desde sequestro de metas e jailbreak até comprometimento da comunicação, violações de privacidade de dados, escalonamento de privilégios, geração de conteúdo prejudicial e manipulação ciberfísica. Estes objetivos mapeiam diretamente os padrões e ameaças observados, as vulnerabilidades que as organizações encontram à medida que escalam a adoção da IA e, finalmente, estendem-se a áreas que são tecnicamente viáveis, embora ainda não observadas fora de um ambiente de investigação. Cada objectivo torna-se uma lente através da qual os executivos e líderes podem compreender a sua exposição: quais as funções empresariais que poderão ser afectadas, que obrigações regulamentares poderão ser desencadeadas e quais os sistemas que requerem uma monitorização reforçada.

Técnicas e subtécnicas proporcionam a especificidade necessária às equipes operacionais. Isso inclui mais de 150 técnicas e subtécnicas, como injeções imediatas (diretas e indiretas), jailbreak, manipulação multiagente, corrupção de memória, adulteração da cadeia de suprimentos, evasão consciente do ambiente, exploração de ferramentas e dezenas de outras. A riqueza desta camada reflete a complexidade dos ecossistemas modernos de IA. Um único immediate malicioso pode se propagar entre agentes, ferramentas, armazenamentos de memória e APIs; uma única dependência comprometida pode introduzir backdoors não observados nos pesos do modelo; ou uma única falha em cascata pode fazer com que todo um fluxo de trabalho multiagente divirja do objetivo pretendido.

Captura de tela do Taxonomy Navigator do AI Safety Framework

A taxonomia de segurança incorporada na estrutura é igualmente robusta. Inclui vinte e cinco categorias de conteúdo prejudicial, que vão desde o uso indevido da segurança cibernética até danos à segurança e ao conteúdo, comprometimento da propriedade intelectual e ataques à privacidade. Esta amplitude reconhece que muitas falhas de IA são comportamentos emergentes que ainda podem causar danos no mundo actual. Uma taxonomia unificada garante que as organizações possam avaliar tanto as entradas maliciosas como as saídas prejudiciais através de uma lente coerente.

Nesse sentido, existem taxonomias adicionais de protocolo de contexto de modelo (MCP), agentes e ameaças à cadeia de suprimentos incorporadas à estrutura de segurança de IA. Protocolos como MCP e A2A governam como os LLMs interpretam ferramentas, prompts, metadados e ambientes de execução, e quando esses componentes são adulterados, personificados ou mal utilizados, as operações benignas do agente podem ser redirecionadas para objetivos maliciosos. A taxonomia MCP (que atualmente abrange 14 tipos de ameaças) e a nossa taxonomia A2A (que atualmente abrange 17 tipos de ameaças) são recursos independentes que também estão integrados na AI Protection e nas nossas ferramentas de código aberto: Scanner MCP e Varredor A2A. Finalmente, o risco da cadeia de abastecimento também é uma dimensão central da segurança da IA consciente do ciclo de vida. Desenvolvemos uma taxonomia que abrange 22 ameaças distintas e é integrada de forma semelhante ao AI Protection, aos nossos parceiros em segurança de modelos e a outras ferramentas que estamos desenvolvendo para a comunidade de código aberto.

A Estrutura Integrada de Segurança e Proteção de IA da Cisco oferece uma das abordagens mais completas e voltadas para o futuro disponíveis atualmente. Numa altura em que a IA está a redefinir as indústrias, essa clareza não é apenas valiosa – é essencial. Esta estrutura também está integrada no Cisco AI Protection, onde as ameaças são identificadas com indicadores associados e estratégias de mitigação. Navegue em nosso Estrutura integrada de segurança e proteção de IA hoje. Esperamos trabalhar com a comunidade para aprofundar a consciência e fortalecer as defesas contra este novo ecossistema de ameaças de IA.