O acesso a dados de alta qualidade e no mundo actual é essential para o desenvolvimento de modelos eficazes de aprendizado de máquina. No entanto, quando esses dados contêm informações confidenciais, as organizações enfrentam um obstáculo significativo ao permitir que as equipes de ciência de dados trabalhem com ativos de dados valiosos sem comprometer a privacidade ou a segurança. As abordagens tradicionais geralmente envolvem processos de anonimato de dados demorados ou controles de acesso restritivos, o que pode prejudicar a produtividade e limitar as idéias potenciais obtidas dos dados.

Databricks Limpe Rooms reimagina esse paradigma. Ao oferecer um ambiente seguro e colaborativo, as salas limpas permitem que as equipes de ciência de dados treinem ou ajustem modelos de ML em dados confidenciais sem acessar diretamente ou expor as informações subjacentes. Essa abordagem inovadora não apenas aprimora a proteção de dados, mas também acelera o desenvolvimento de modelos poderosos e orientados a dados.

O aprendizado de máquina em dados confidenciais possui diversas aplicações entre as indústrias. Nos cuidados de saúde, os modelos podem prever resultados do paciente ou classificar os tipos de células usando informações de saúde protegidas sem expor registros individuais. As instituições financeiras podem desenvolver modelos sofisticados de pontuação de crédito e detecção de fraude usando dados confidenciais de transação. Na publicidade, as empresas podem aproveitar o aprendizado de máquina para melhorar a segmentação e a personalização do anúncio, preservando a privacidade do usuário.

Este weblog o leva ao processo e configura que os clientes do Databricks podem usar para treinar e entregar modelos de ML de maneira centrada na privacidade. Usaremos o exemplo de um provedor de saúde que deseja criar um modelo para prever o risco de readmissão do paciente usando dados confidenciais de registros eletrônicos de saúde (EHR).

Cenário e atores

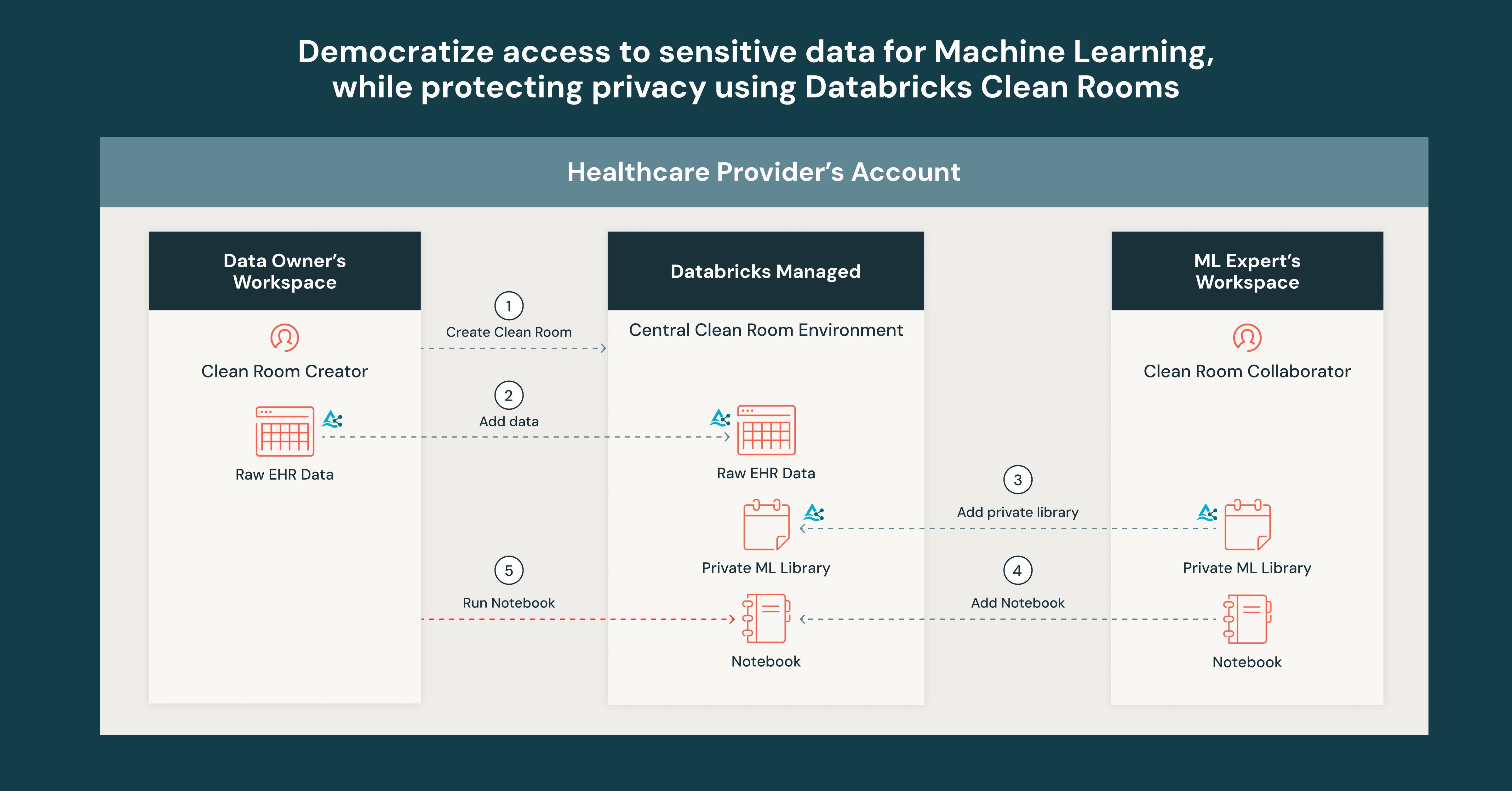

Em uma organização típica, o gerenciamento e a análise de dados são separados pelos departamentos. Por exemplo, para um médico, os dados geralmente são governados e gerenciados centralmente pelos proprietários de dados. Os indivíduos que analisam os dados são tipicamente assuntos ou especialistas técnicos que entendem o domínio. Para o nosso exemplo, vamos supor que há dois atores:

- Proprietário de dados – Responsável pela governança, qualidade e segurança dos dados de EHR dentro da organização. Eles estabelecem políticas para acesso a dados, uso e conformidade.

- ML Skilled – Um cientista de dados responsável pelo desenvolvimento e avaliação de modelos de ML usando dados de saúde. Eles trabalham com especialistas clínicos para enquadrar questões relevantes e criar modelos de acordo com os requisitos.

Meta: O proprietário de dados deseja capacitar o especialista em ML a criar um modelo e restringir o acesso direto aos dados sensíveis de EHR. Ao mesmo tempo, o especialista em ML deseja iterar no código de treinamento e aprimorar o modelo conforme necessário. O resultado dessa colaboração geraria uma saída de modelo usada para prever a readmissão.

Requisitos de banco de dados

- Uma conta ativada para computação sem servidor. Ver este guia Para ativar a computação sem servidor.

- Espaço de trabalho (s) ativado para o catálogo de unidades. Confira este guia Para ativar o catálogo da unidade.

- O compartilhamento delta habilitado para o Catálogo da Unidade Metastore. Seguir este guia Para permitir o compartilhamento da Delta em uma metase.

- Tanto o proprietário dos dados quanto o especialista em ML têm o privilégio de criar uma sala limpa. Usar este guia gerenciar privilégios no catálogo da unidade.

A configuração

Etapa 1: O proprietário de dados (ou usuário com a permissão Create Clear Room) cria uma sala limpa com acesso restrito à Web e convida o especialista em ML a colaborar usando seu Identificador de compartilhamento de quarto limpo.

Etapa 2: O proprietário de dados adiciona os dados brutos de EHR à sala limpa. Nos bastidores, esses dados são compartilhados delta no ambiente central da sala limpa. O especialista em ML pode ver apenas os metadados da tabela, não os dados subjacentes.

Etapa 3: O especialista em ML desenvolve uma biblioteca privada que contém código que cria um modelo usando os dados RAW EHR e prevê o risco de readmissão. O especialista em ML empacota sua biblioteca privada em uma roda Python, adiciona -a a um quantity e adiciona o quantity à sala limpa. Nos bastidores, o quantity é compartilhado delta na sala limpa. O proprietário de dados não pode inspecionar diretamente o conteúdo do quantity, portanto o código de treinamento permanece seguro e oculto.

Etapa 4: O especialista em ML também adiciona um pocket book que usa a biblioteca privada e produz um modelo.

Etapa 5: O proprietário de dados executa o pocket book e recebe o modelo de saída dentro da sala limpa. Ao fazer com que o proprietário de dados execute o pocket book, eles podem garantir que a biblioteca privada não exfileme ou revele os dados subjacentes ao especialista em ML. Além disso, o especialista em ML pode atualizar o código de treinamento na biblioteca privada a qualquer momento para melhorar ainda mais. O modelo também pode ser usado para inferir ou compartilhar com as partes interessadas para análises posteriores.

E é isso! Em apenas algumas etapas, o prestador de serviços de saúde pode proteger dados sensíveis de EHR, permitindo que a equipe de ciências de dados desenvolva modelos de ML para uma variedade de casos de uso.

Os quartos limpos do Databricks agora estão geralmente disponíveis na AWS e no Azure! Esteja você colaborando em sua organização ou com parceiros externos, as salas limpas oferecem um ambiente seguro para compartilhamento de dados e análises. Comece a usá -lo hoje para aprimorar a construção de modelos internos, simplificar os fluxos de trabalho e desbloquear informações valiosas.