A indústria de petróleo e gás depende muito de dados sísmicos para explorar e extrair hidrocarbonetos com segurança e eficiência. No entanto, o processamento e a análise de grandes quantidades de dados sísmicos podem ser uma tarefa assustadora, exigindo recursos e conhecimentos computacionais significativos.

A Equinor, uma empresa líder de energia, usou a plataforma de inteligência de dados do Databricks para otimizar um de seus fluxos de trabalho de transformação de dados sísmicos exploratórios, alcançando uma economia significativa de tempo e custos, melhorando a observabilidade dos dados.

O objetivo da Equinor period aprimorar um de seus fluxos de trabalho de interpretação sísmica em 4D, concentrando -se em automatizar e otimizar a detecção e classificação das mudanças no reservatório ao longo do tempo. Esse processo suporta a identificação de metas de perfuração, reduzindo o risco de poços secos dispendiosos e promover práticas de perfuração ambientalmente responsáveis. As principais expectativas de negócios incluídas:

- Alvos ideais de perfuração: Melhore a identificação do alvo para perfurar um grande número de novos poços nas próximas décadas.

- Análise mais rápida e econômica: Reduza o tempo e o custo da análise sísmica 4D por meio da automação.

- Insights de reservatório mais profundos: Integre mais dados subterrâneos para desbloquear interpretações e tomada de decisão aprimoradas.

Compreensão de dados sísmicos

Cubo sísmico: modelos 3D da subsuperfície

A aquisição de dados sísmicos envolve a implantação de armas de ar para gerar ondas sonoras, que refletem estruturas de subsuperfície e são capturadas por hidrofones. Esses sensores, localizados em streamers rebocados por embarcações sísmicas ou colocadas no fundo do mar, coletam dados brutos que são processados posteriormente para criar imagens 3D detalhadas da geologia do subsolo.

- Formato de arquivo: SEG-Y (Sociedade de Exploração Geofísica)-Formato de arquivo proprietário para armazenar dados sísmicos, desenvolvidos na década de 1970, otimizados para armazenamento de fitas

- Representação de dados: Os dados processados são armazenados como cubos 3D, oferecendo uma visão abrangente das estruturas subterrâneas.

Horizontes sísmicos: mapeamento de limites geológicos

Os horizontes sísmicos são interpretações de dados sísmicos, representando superfícies contínuas dentro da subsuperfície. Esses horizontes indicam limites geológicos, ligados a mudanças nas propriedades da rocha ou mesmo no teor de fluidos. Ao analisar as reflexões das ondas sísmicas nesses limites, os geólogos podem identificar os principais recursos do subsolo.

- Formato de arquivo: CSV – comumente usado para armazenar dados de horizonte sísmico interpretado.

- Representação de dados: Os horizontes são armazenados como superfícies 2D.

Desafios com o oleoduto existente

Os dados sísmicos atuais processa dados para gerar as seguintes saídas -chave:

- Cubo de diferença sísmica 4D: O rastreia as mudanças ao longo do tempo comparando dois cubos sísmicos da mesma área física, normalmente adquiridos meses ou anos de diferença.

- Mapas de diferença sísmica 4D: Esses mapas contêm atributos ou recursos dos cubos sísmicos 4D para destacar alterações específicas nos dados sísmicos, ajudando a análise do reservatório.

No entanto, vários desafios limitam a eficiência e a escalabilidade do pipeline existente:

- Processamento distribuído abaixo do perfect: Baseia-se em vários trabalhos de Python independentes em paralelo em clusters de nó único, levando a ineficiências.

- Resiliência limitada: Propenso a falhas e carece de mecanismos para tolerância a erros ou recuperação automatizada.

- Falta de escalabilidade horizontal: Requer nós de alta configuração com memória substancial (por exemplo, 112 GB), aumentando os custos.

- Alto esforço de desenvolvimento e manutenção: Gerenciar e solucionar problemas do pipeline exige recursos de engenharia significativos.

Arquitetura de solução proposta

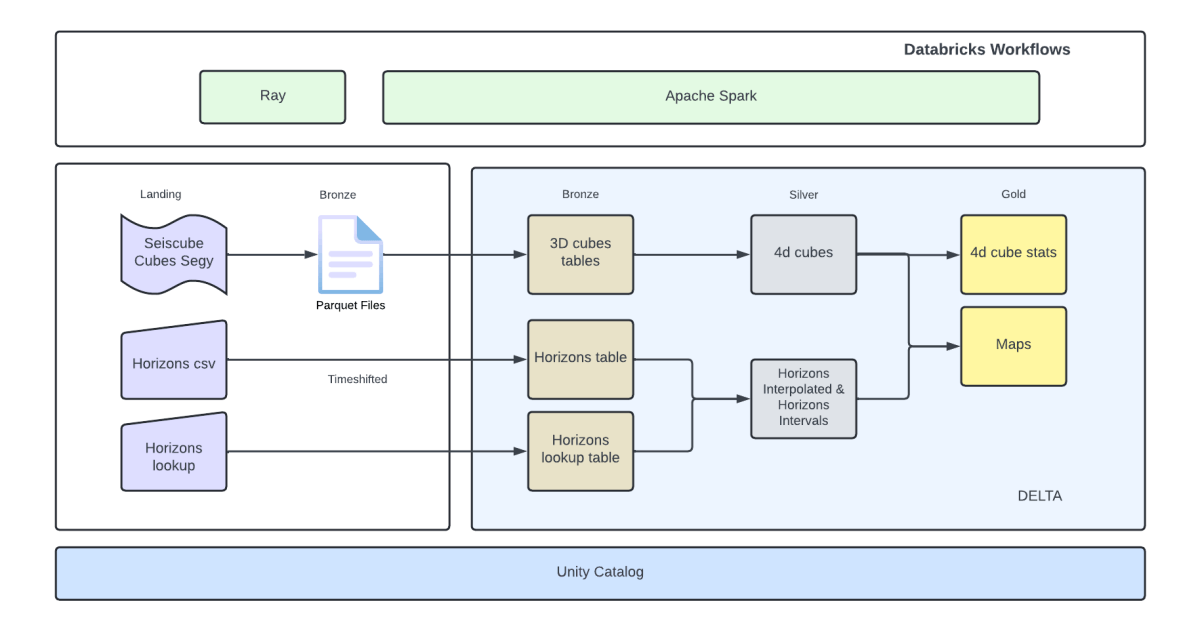

Para enfrentar esses desafios, re-arquitamos o oleoduto como uma solução distribuída usando Raio e Apache Spark ™ governado pelo catálogo da Unity na plataforma Databricks. Essa abordagem melhorou significativamente a escalabilidade, a resiliência e a eficiência dos custos.

Utilizamos as seguintes tecnologias na plataforma Databricks para implementar a solução:

- Apache Spark ™: Uma estrutura de código aberto para processamento e análise de dados em larga escala, garantindo computação eficiente e escalável.

- Databricks Fluxos de trabalho: Para orquestrar tarefas de engenharia de dados, ciência de dados e análise.

- Lago Delta: Uma camada de armazenamento de código aberto que garante confiabilidade através de transações ácidas, manuseio de metadados escaláveis e lote unificado e processamento de dados de streaming. Ele serve como o formato de armazenamento padrão nos Databricks.

- Raio: Uma estrutura de computação distribuída de alto desempenho, usada para dimensionar aplicativos Python e permitir o processamento distribuído de arquivos SEG-Y, alavancando o Segyio e a lógica de processamento existente.

- Segyio: Uma biblioteca Python para processar arquivos SEG-Y, permitindo o manuseio contínuo de dados sísmicos.

Principais benefícios:

Esse pipeline de dados sísmicos re-arquitetados abordou ineficiências no pipeline existente ao introduzir escalabilidade, resiliência e otimização de custos. A seguir, são apresentados os principais benefícios realizados:

- Economia de tempo significativa: Eliminou o processamento de dados duplicados, persistindo os resultados intermediários (por exemplo, cubos 3D e 4D), permitindo o reprocessamento apenas dos conjuntos de dados necessários.

- Eficiência de custos: Custos reduzidos em até 96% em etapas específicas de cálculo, como a geração de mapas.

- Design de falha resiliente: Aprovou a estrutura de processamento distribuída da Apache Spark para introduzir tolerância a falhas e recuperação automática de tarefas.

- Escalabilidade horizontal: Escalabilidade horizontal alcançada para superar as limitações da solução existente, garantindo a escala eficiente à medida que o quantity de dados cresce.

- Formato de dados padronizado: Adotou um formato de dados aberto e padronizado para otimizar o processamento a jusante, simplificar a análise, melhorar o compartilhamento de dados e aprimorar a governança e a qualidade.

Conclusão

Este projeto destaca o grande potencial de plataformas de dados modernas, como o Databricks, na transformação dos fluxos de trabalho tradicionais de processamento de dados sísmicos. Ao integrar ferramentas como Ray, Apache Spark e Delta e alavancar a plataforma dos Databricks, alcançamos uma solução que oferece benefícios mensuráveis:

- Ganhos de eficiência: Processamento de dados mais rápido e tolerância a falhas.

- Reduções de custos: Uma abordagem mais econômica para a análise de dados sísmicos.

- Melhor manutenção aprimorada: A arquitetura simplificada da tubulação e as pilhas de tecnologia padronizadas reduziram a complexidade do código e a sobrecarga de desenvolvimento.

O pipeline reprojetado não apenas otimizou os fluxos de trabalho sísmicos, mas também estabelecem uma base escalável e robusta para aprimoramentos futuros. Isso serve como um modelo valioso para outras organizações com o objetivo de modernizar seu processamento de dados sísmicos enquanto impulsionam resultados de negócios semelhantes.

Agradecimentos

Agradecimentos especiais às equipes de engenharia de dados, dados de dados e análises de dados e equipes de pesquisa e desenvolvimento por suas contribuições para essa iniciativa.

“Excelente experiência em trabalhar com serviços profissionais – habilidades técnicas e de comunicação muito altas. Realizações significativas em pouco tempo”

– Anton Eskov

https://www.databricks.com/weblog/class/industries/vitality?classes=vitality