Como você deve ter ouvido, Deepseek-r1 está fazendo ondas. Está em todo o feed de notícias da IA, aclamado como o primeiro modelo de raciocínio de código aberto desse tipo.

O zumbido? Bem merecido.

O modelo? Poderoso.

Deepseek-R1 representa a fronteira atual nos modelos de raciocínio, empurrando os limites do que a IA de código aberto pode alcançar. Mas aqui está a parte que você não verá nas manchetes: trabalhar com ela não é exatamente direto.

A prototipagem pode ser desajeitada. Implantando para a produção? Ainda mais complicado.

É aí que entra o DataROBOT. Facilitamos o desenvolvimento e a implantação do Deepseek-R1, para que você possa gastar menos tempo lutando com complexidade e mais tempo construindo soluções reais e prontas para empresas.

Prototipando Deepseek-R1 e trazer aplicativos para produção são críticos para aproveitar todo o seu potencial e entregar Experiências generativas de IA de alta qualidade.

Então, o que exatamente torna o DeepSeek-R1 tão atraente-e por que está provocando toda essa atenção? Vamos dar uma olhada mais de perto para ver se todo o hype é justificado.

Esse poderia ser o modelo que supera o melhor e o melhor do OpenAI?

Além do hype: por que Deepseek-R1 vale sua atenção

Deepseek-R1 não é apenas mais um modelo generativo de IA. É sem dúvida o primeiro modelo de “raciocínio” de código aberto-um modelo de texto generativo reforçado especificamente para gerar texto que se aproxima de seus processos de raciocínio e tomada de decisão.

Para os profissionais de IA, isso abre novas possibilidades para aplicativos que requerem saídas estruturadas e orientadas por lógica.

O que também se destaca é sua eficiência. Treinar Deepseek-R1 custou uma fração do que foi necessário para desenvolver modelos como o GPT-4O, graças às técnicas de aprendizado de reforço publicadas pela Deepseek AI. E como é totalmente de código aberto, oferece maior flexibilidade, permitindo que você mantenha o controle sobre seus dados.

Obviamente, trabalhar com um modelo de código aberto como o Deepseek-R1 vem com seu próprio conjunto de desafios, desde obstáculos de integração até variabilidade de desempenho. Mas entender seu potencial é o primeiro passo para fazê -lo funcionar efetivamente em Aplicações do mundo actual e oferecer experiências mais relevantes e significativas aos usuários finais.

Usando Deepseek-R1 em DataRobot

Obviamente, o potencial nem sempre é igual. É aí que entra o DataRobot.

Com o DataROBOT, você pode hospedar DeepSeek-R1 usando o NVIDIA GPUS para inferência de alto desempenho ou acessá-las através de previsões sem servidor para prototipagem, experimentação e implantação rápidas e flexíveis.

Não importa onde o Deepseek-R1 esteja hospedado, você pode integrá-lo perfeitamente aos seus fluxos de trabalho.

Na prática, isso significa que você pode:

- Examine o desempenho entre os modelos sem o aborrecimento, usando ferramentas de benchmarking embutidas para ver como o DeepSeek-R1 se compara a outros.

- Implante Deepseek-R1 na produção com confiança, apoiada por recursos de segurança, observabilidade e governança de grau corporativo.

- Construir Aplicações AI Isso oferece resultados relevantes e confiáveis, sem ficar atolado pela complexidade da infraestrutura.

LLMs como Deepseek-R1 raramente são usados isoladamente. Em aplicativos de produção do mundo actual, eles funcionam como parte de fluxos de trabalho sofisticados, em vez de modelos independentes. Com isso em mente, avaliamos o Deepseek-R1 dentro de vários pipelines de geração de recuperação de recuperação (RAG) sobre o conhecido Conjunto de dados do Financebench e comparou seu desempenho ao GPT-4O Mini.

Então, como o DeepSeek-R1 se compara nos fluxos de trabalho da IA do mundo actual? Aqui está o que encontramos:

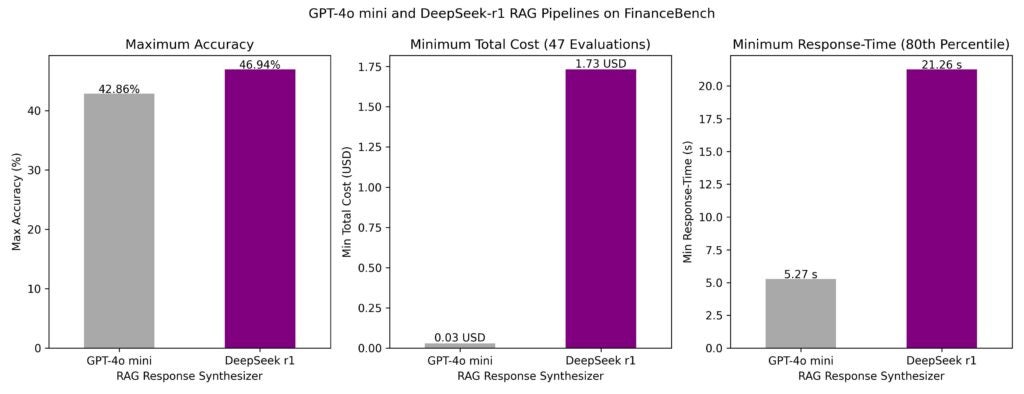

- Tempo de resposta: A latência foi notavelmente menor para o GPT-4O Mini. O tempo de resposta do 80º percentil para os pipelines mais rápidos foi de 5 segundos para o Mini GPT-4O e 21 segundos para Deepseek-R1.

- Precisão: O melhor pipeline de IA generativo usando DeepSeek-R1 como o Synthesizer LLM alcançou 47% de precisão, superando o melhor pipeline usando o GPT-4O Mini (precisão de 43%).

- Custo: Embora o Deepseek-R1 tenha maior precisão, seu custo por chamada foi significativamente maior-cerca de US $ 1,73 por solicitação em comparação com US $ 0,03 para o GPT-4o Mini. As opções de hospedagem afetam significativamente esses custos.

Embora o Deepseek-R1 demonstre precisão impressionante, seus custos mais altos e tempos de resposta mais lentos podem tornar o GPT-4O Mini a escolha mais eficiente para muitas aplicações, especialmente quando o custo e a latência são críticos.

Esta análise destaca a importância da avaliação de modelos não apenas isoladamente, mas também dentro dos fluxos de trabalho de IA de ponta a ponta.

Somente as métricas de desempenho bruto não contam a história completa. Avaliando modelos dentro de pipelines rag agênticos e não agentes sofisticados oferece uma imagem mais clara de sua viabilidade do mundo actual.

Usando o raciocínio de Deepseek-R1 em agentes

A força de Deepseek-R1 não é apenas na geração de respostas-é como ele argumenta através de cenários complexos. Isso o torna particularmente valioso para sistemas baseados em agentes que precisam lidar com casos de uso dinâmicos e de várias camadas.

Para as empresas, essa capacidade de raciocínio vai além de simplesmente responder a perguntas. Pode:

- Apresente uma variedade de opções Em vez de uma única resposta “melhor”, ajudar os usuários a explorar resultados diferentes.

- Reunir proativamente informações Antes das interações do usuário, permitindo experiências mais responsivas e com reconhecimento de contexto.

Aqui está um exemplo:

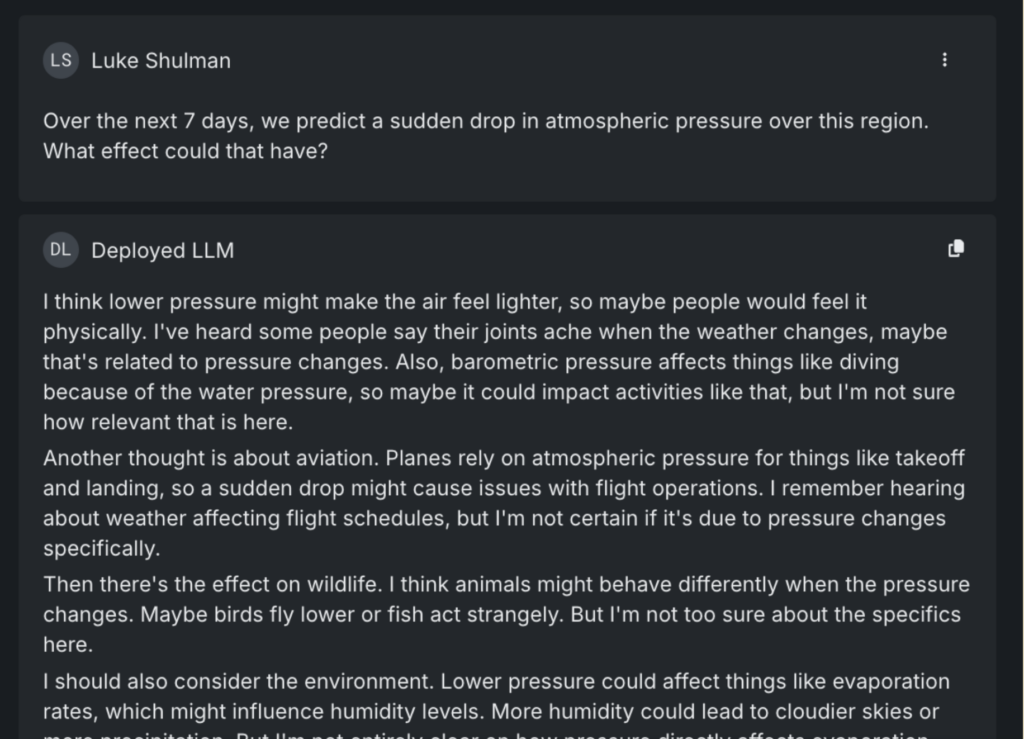

Quando perguntado sobre os efeitos de uma queda repentina na pressão atmosférica, o Deepseek-R1 não apenas fornece uma resposta de livro. Ele identifica várias maneiras pelas quais a questão pode ser interpretada – considerando os impactos na vida selvagem, na aviação e na saúde da população. Ele até observa consequências menos óbvias, como o potencial de cancelamentos de eventos ao ar livre devido a tempestades.

Em um sistema baseado em agente, esse tipo de raciocínio pode ser aplicado a cenários do mundo actual, como verificar proativamente atrasos de voo ou eventos futuros que podem ser interrompidos pelas mudanças climáticas.

Curiosamente, quando a mesma pergunta foi feita a outros LLMs líderes, incluindo Gemini e GPT-4O, nenhum sinalizou cancelamentos de eventos como um risco potencial.

Deepseek-R1 se destaca em aplicativos orientados a agentes para sua capacidade de antecipar, não apenas reagir.

Examine Deepseek-R1 com GPT 4O-Mini: O que os dados nos dizem

Com muita frequência, os praticantes de IA confiam apenas nas respostas de um LLM para determinar se está pronto para a implantação. Se as respostas parecem convincentes, é fácil assumir que o modelo está pronto para produção. Mas, sem avaliação mais profunda, essa confiança pode ser enganosa, pois os modelos que têm um bom desempenho nos testes geralmente lutam em aplicativos do mundo actual.

É por isso que a combinação de revisão de especialistas com avaliações quantitativas é basic. Não se trata apenas do que o modelo diz, mas como chega lá – e se esse raciocínio se mantém sob escrutínio.

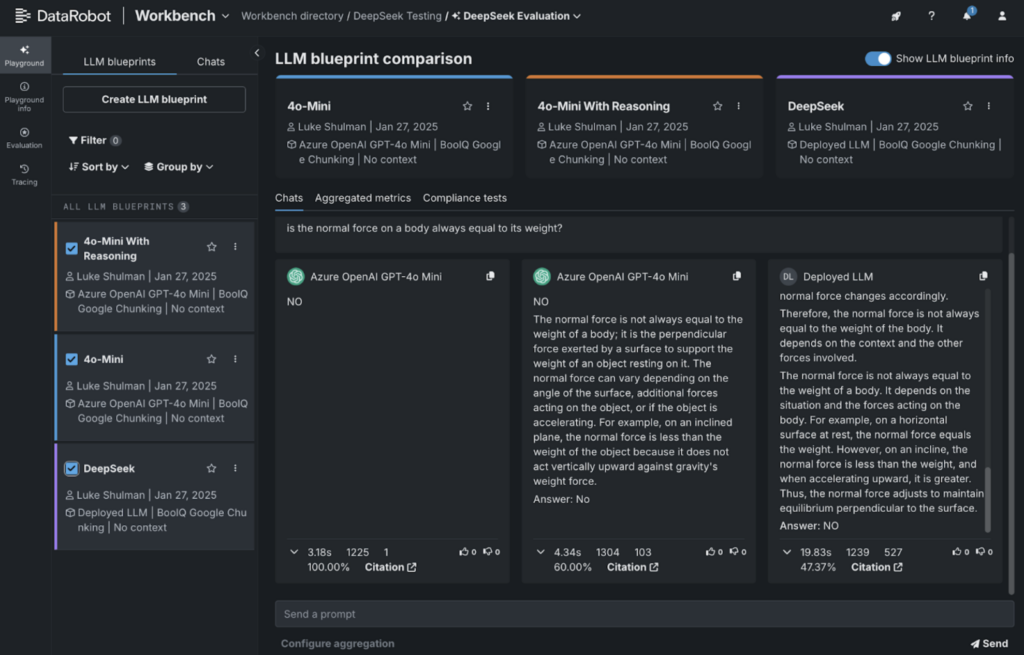

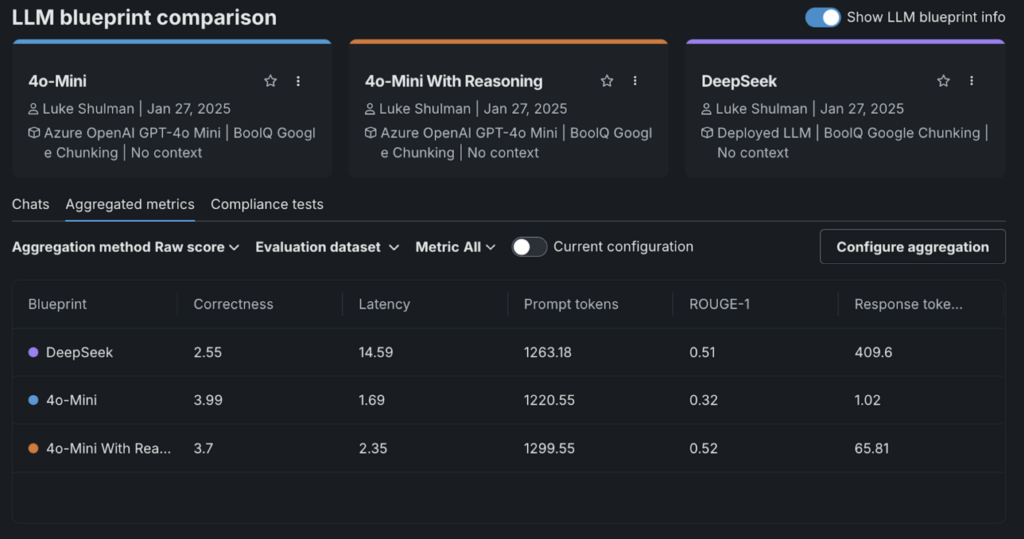

Para ilustrar isso, realizamos uma avaliação rápida usando o conjunto de dados de compreensão de leitura do Google Boolq. Este conjunto de dados apresenta passagens curtas, seguidas de perguntas sim/não para testar a compreensão de um modelo.

Para o GPT-4O-Mini, usamos o seguinte immediate do sistema:

Tente responder com um claro sim ou não. Você também pode dizer verdadeiro ou falso, mas seja claro em sua resposta.

Além da sua resposta, inclua seu raciocínio por trás desta resposta. Coloque esse raciocínio com a tag

Por exemplo, se o usuário perguntar “que cor é uma lata de coca”, você diria:

Resposta: Vermelho

Aqui está o que encontramos:

- Certo: Saída do Deepseek-R1.

- Na extrema esquerda: GPT-4O-Mini respondendo com um simples sim/não.

- Centro: GPT-4O-Mini com raciocínio incluído.

Utilizamos a integração do DataRobot com o avaliador de correção da Llandex para classificar as respostas. Curiosamente, o Deepseek-R1 marcou o mais baixo nesta avaliação.

O que se destacou foi como a adição de “raciocínio” causou a correção da correção.

Isso destaca um argumento importante: embora o Deepseek-R1 tenha um bom desempenho em alguns benchmarks, nem sempre é o mais adequado para cada caso de uso. É por isso que é basic comparar os modelos lado a lado para encontrar a ferramenta certa para o trabalho.

Hospedando Deepseek-R1 em DataRobot: um guia passo a passo

Ficar Deepseek-R1 em funcionamento não precisa ser complicado. Esteja você trabalhando com um dos modelos básicos (mais de 600 bilhões de parâmetros) ou com uma versão destilada ajustada em modelos menores como LLAMA-70B ou LLAMA-8B, o processo é direto. Você pode hospedar qualquer uma dessas variantes no DataRobot com apenas algumas etapas de configuração.

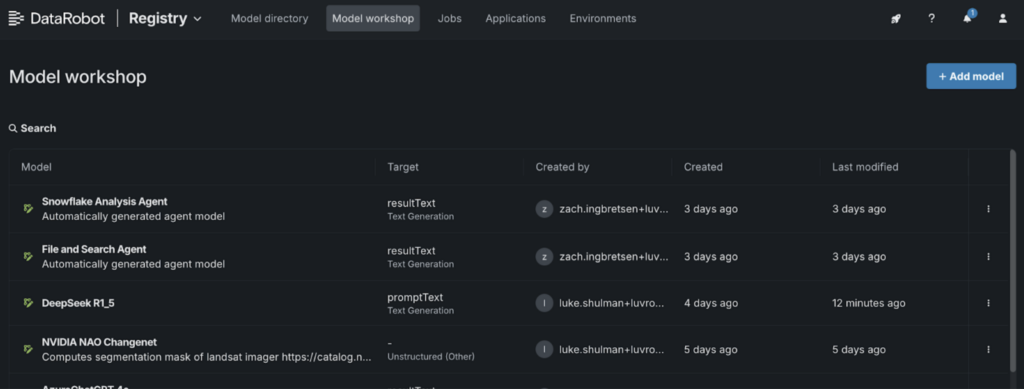

1. Vá para o Workshop de modelo:

- Navegue até o “Registro” e selecione a guia “Modelo Workshop”.

2. Adicione um novo modelo:

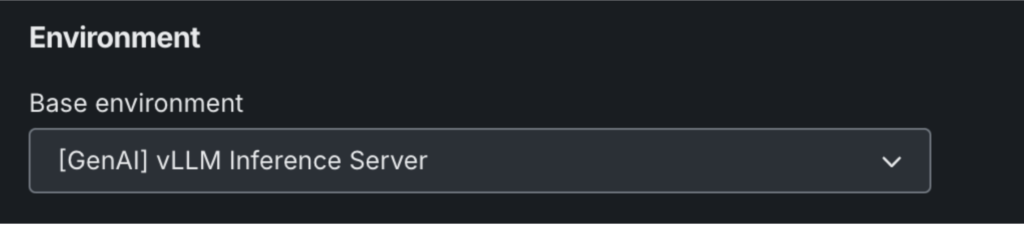

- Nomeie seu modelo e escolha “(Genai) Vllm Inference Server” nas configurações do ambiente.

- Clique em “+ Adicionar modelo” para abrir o workshop de modelo personalizado.

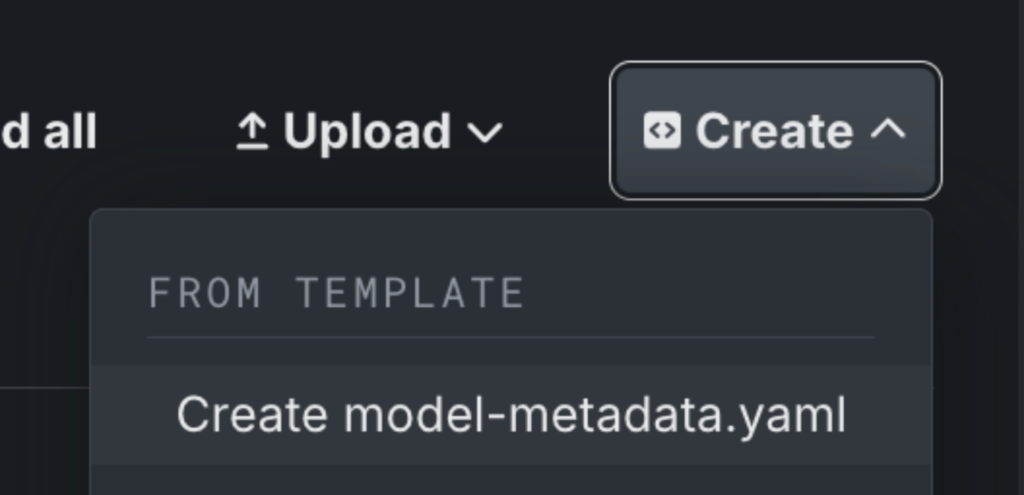

3. Configure seus metadados do modelo:

- Clique em “Criar” para adicionar um arquivo modelo-metadata.yaml.

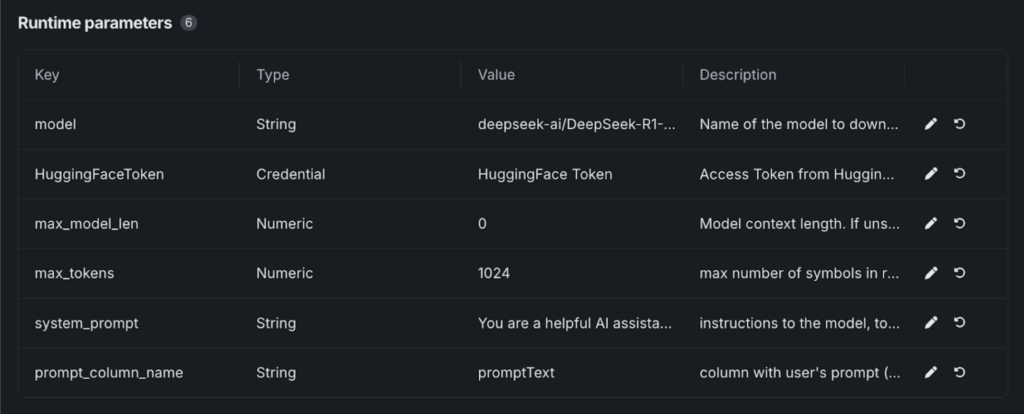

4. Edite o arquivo de metadados:

- Salvar o arquivo e os “parâmetros de tempo de execução” aparecerão.

- Cole os valores necessários de Nosso modelo GitHubque inclui todos os parâmetros necessários para iniciar o modelo de abraçar o rosto.

5. Configure detalhes do modelo:

- Selecione seu token de rosto abraçado na loja de credenciais DataRobot.

- Em “Modelo”, insira a variante que você está usando. Por exemplo: Deepseek-AI/Deepseek-R1-Distill-Llama-8b.

6. Lançar e implantar:

- Uma vez salvo, seu modelo Deepseek-R1 estará em execução.

- A partir daqui, você pode testar o modelo, implantá -lo em um terminal ou integrá -lo em playgrounds e aplicativos.

De Deepseek-R1 a IA pronta para a empresa

O acesso às ferramentas de IA generativa de ponta é apenas o começo. O verdadeiro desafio é avaliar quais modelos se encaixam no seu caso de uso específico – e trazendo -os com segurança em produção Para oferecer valor actual aos seus usuários finais.

Deepseek-R1 é apenas um exemplo do que é possível quando você tem a flexibilidade de trabalhar em modelos, comparar seu desempenho e implantá-los com confiança.

As mesmas ferramentas e processos que simplificam o trabalho da Deepseek podem ajudá -lo a tirar o máximo proveito de outros modelos e aplicações de IA de alimentação que proporcionam impacto actual.

Veja como o DeepSeek-R1 se compara a outros modelos de IA e implantá-lo em produção com um teste gratuito.

Sobre o autor

Nathaniel Daly é gerente sênior de produtos da DataROBOT, com foco em produtos de automl e séries temporais. Ele está focado em trazer avanços na ciência de dados para os usuários, de modo que eles possam alavancar esse valor para resolver problemas de negócios do mundo actual. Ele é formado em matemática pela Universidade da Califórnia, Berkeley.

Luke Shulman, diretor de campo técnico: Luke tem mais de 15 anos de experiência em análise de dados e ciência de dados. Antes de ingressar na DataRobot, Luke liderou as implementações e foi diretor da equipe de gerenciamento de produtos da Arcadia.io, a principal plataforma de análise SaaS SaaS. Ele continuou esse papel na N1Health. No DataRobot, Luke lidera integrações no ecossistema AI/ML. Ele também é um colaborador ativo das extensões DRX para o cliente da API DataRobot e a integração MLFlow. Um ávido campeão da ciência de dados, Luke também contribuiu para projetos em todo o ecossistema de ciências de dados, incluindo Bokeh, Altair e Zebras.js.