Um novo paradigma está remodelando a infraestrutura em nuvem: as neonuvens. Esses provedores de nuvem de última geração com IA estão construindo plataformas densas em GPU, projetadas para a escala implacável e as demandas de desempenho do aprendizado de máquina moderno. Ao contrário dos provedores de nuvem tradicionais que modernizam a infraestrutura existente, as neoclouds são estruturas nativas de IA criadas a partir do zero, onde cada ciclo de GPU conta e cada pacote é importante.

Nestes ambientes nativos de IA, a rede não é mais um canal passivo. É a força de sincronização que mantém aglomerados colossais de GPUs funcionando a todo vapor, a cada segundo do dia. Alcançar isso requer mais do que apenas largura de banda: exige operação determinística e sem perdas, observabilidade profunda e agilidade para evoluir à medida que as cargas de trabalho e as arquiteturas de IA mudam.

O modelo da Neocloud: aberto, escalável e otimizado para IA com Cisco 8000

É aqui que Série Cisco 8000 com SONiC entra em cena – não como um change tradicional, mas como a espinha dorsal inteligente para neoclouds. Projetado para uma abordagem de rede aberta e desagregada, o Cisco 8000 Collection com SONiC atende diretamente às necessidades exclusivas das nuvens nativas de IA de quatro maneiras fundamentais:

1. Agilidade operacional por meio da desagregação

A série Cisco 8000 oferece uma plataforma aberta e flexível, supreme para neoclouds que buscam inovação rápida. Com SONiC totalmente suportado e validado pela Cisco e recursos importantes de IA, a plataforma permite uma pilha verdadeiramente desagregada. Isso permite atualizações independentes de {hardware} e software program, fácil integração de recursos de código aberto e observabilidade avançada de IA e engenharia de tráfego. Para construções de back-end, as plataformas Cisco 8122-64EH-O (64x800G QDD) e 8122-64EHF-O (64x800G OSFP) — ambas alimentadas pelo Cisco Silicon One G200 ASIC — oferecem taxa de transferência de 800G de alto desempenho para atender às necessidades de cargas de trabalho exigentes de IA e knowledge middle. Essas plataformas combinam {hardware} confiável e específico com software program ágil e nativo da nuvem, garantindo uma base escalável para necessidades de infraestrutura em evolução.

2. Estrutura determinística e sem perdas para treinamento distribuído

Os clusters de IA dependem de redes sincronizadas, de alta largura de banda e sem perdas para manter milhares de GPUs totalmente utilizadas. As plataformas Cisco 8122, construídas com ASICs G200, oferecem buffer de pacotes on-die grande e totalmente compartilhado, jitter ultrabaixo e gerenciamento de congestionamento adaptativo – todos essenciais para cargas de trabalho e operações coletivas baseadas em RDMA. Com suporte para 800G hoje e velocidades de 1,6T amanhã, a estrutura pode ser dimensionada tão rapidamente quanto a ambição da IA cresce.

3. Inteligência integrada: recursos avançados de rede de IA

A oferta da Cisco é ancorada em seus recursos avançados de rede de IA – um rico conjunto de ferramentas projetadas para fornecer insights de rede em tempo actual, agendamento com reconhecimento de carga de trabalho e isolamento dinâmico de congestionamento. Esses recursos permitem que a estrutura implemente direcionamento de tráfego preditivo, alinhando o comportamento da rede com padrões de carga de trabalho de IA para maximizar a eficiência e o rendimento do cluster.

4. Aberto, programável e preparado para o futuro

Com NOS abertos como o SONiC, a rede se torna tão programável quanto as cargas de trabalho de IA que ela suporta. As operadoras podem implantar rapidamente novos recursos, integrar-se aos programadores de GPU e estender o pipeline de telemetria para atender às necessidades em evolução. Além disso, as plataformas Cisco 8122 estão prontas para UEC, alinhando-se com os padrões emergentes Extremely Ethernet Consortium 1.0 para garantir que sua rede esteja preparada para futuras demandas de IA.

Dimensionando a supernuvem de IA: por toda parte

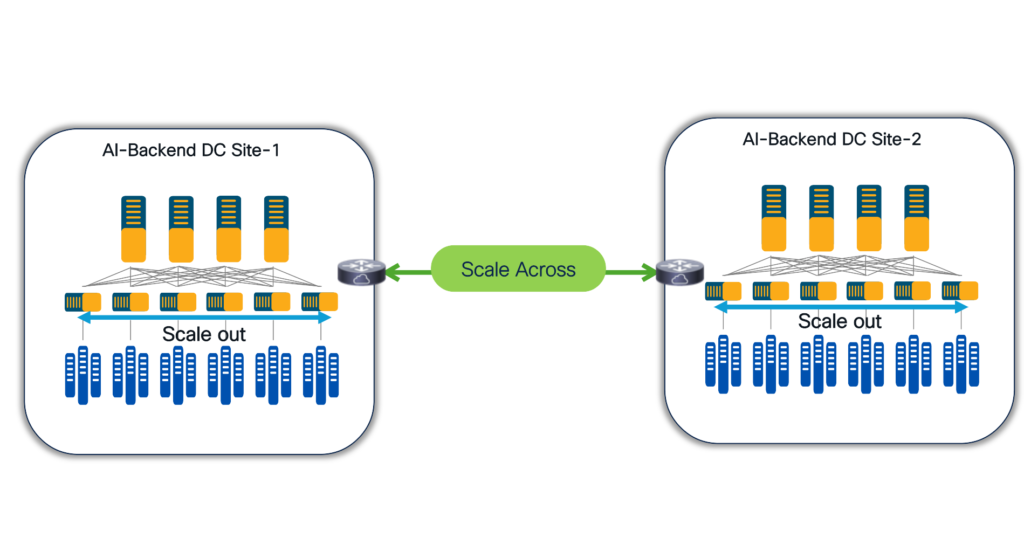

Figura 1: Expandir e dimensionar horizontalmente

Escalabilidade horizontal: criação de malhas de IA de back-end multicamadas com recursos de malha inteligente

À medida que as cargas de trabalho de IA aumentam, é essential que a rede subjacente avance tanto em largura de banda quanto em inteligência. As topologias Clos multiestágio da Cisco, construídas com plataformas Cisco 8122, oferecem malhas verdadeiramente sem bloqueio otimizadas para clusters de GPU em grande escala. No centro desta solução está o conjunto abrangente de recursos de rede nativos de IA, projetado para maximizar o desempenho e a eficiência dos clusters de IA.

Os principais recursos incluem:

- Gerenciamento avançado de congestionamento:

O Controle de Fluxo Prioritário (PFC) e a Notificação de Congestionamento Explícito (ECN) funcionam em conjunto para garantir o maior rendimento e a latência mínima durante o congestionamento, mantendo os clusters sincronizados e funcionando perfeitamente. - Roteamento e comutação adaptativos (ARS):

Orienta o tráfego dinamicamente de acordo com os padrões de congestionamento e fluxo em tempo actual, maximizando a eficiência em toda a estrutura da rede. ARS oferece dois submodos:- Balanceamento de carga de fluxo: divide o tráfego em micro-bursts (fluxos) e roteia cada um ao longo do caminho supreme, melhorando a utilização e preservando a ordem dos pacotes, essencial para cargas de trabalho de GPU baseadas em RDMA.

- Pulverização de pacotes: Distribui pacotes por todos os caminhos disponíveis para obter rendimento máximo, supreme para operações coletivas de IA que toleram reordenação de pacotes.

- ECMP ponderado:

O tráfego é distribuído de forma desigual em vários caminhos de custo igual, de acordo com pesos predefinidos. Isso garante que hyperlinks de maior capacidade ou menos congestionados transportem mais tráfego, melhorando a utilização geral e o desempenho em implantações em larga escala. - Hash QPID:

Emprega técnicas avançadas de hashing para distribuir uniformemente o tráfego, minimizando colisões de fluxo e evitando excesso de assinaturas de caminho único. - Corte de pacotes:

Durante congestionamentos extremos, as cargas úteis de pacotes não essenciais são removidas para aliviar os pontos de acesso, enquanto as informações críticas do cabeçalho são retidas para roteamento contínuo sem descartar pacotes inteiros. - Suporte flexível à topologia:

Compatível com uma variedade de arquiteturas de rede, incluindo topologias apenas ferroviárias, otimizadas para trilhos e topologias leaf/backbone tradicionais. O sistema suporta underlays IPv4 e IPv6 e integra-se com estruturas baseadas em IP/BGP e EVPN, permitindo que as operadoras adaptem as redes às necessidades específicas do cluster de IA. - Interoperabilidade SmartNIC de vários fornecedores:

Projetado para integração perfeita com um ecossistema diversificado de SmartNICs de vários fornecedores, garantindo flexibilidade, proteção de investimento e infraestrutura preparada para o futuro. - Observabilidade orientada por IA com porta PIE:

Fornece visibilidade profunda e em tempo actual nos níveis por porta e por fluxo, incluindo tráfego de GPU para GPU e pontos de acesso de congestionamento, usando telemetria em nível ASIC, rastreamento de pacotes INT em banda e integração SONiC. Isso permite que as operadoras monitorem, ajustem e solucionem problemas de redes de forma proativa para otimizar os resultados do treinamento de IA.

Juntos, esses recursos criam uma estrutura que não é apenas altamente escalável, mas também verdadeiramente otimizada para IA. Os recursos de rede inteligente das plataformas Cisco 8122 permitem que a rede absorva picos de tráfego sincronizados, evite o colapso do congestionamento e mantenha cada GPU operando com eficiência máxima, capacitando cargas de trabalho de IA de próxima geração com desempenho e confiabilidade incomparáveis.

Escalabilidade: Federando pods de IA globalmente

À medida que a infraestrutura de IA se expande para além dos knowledge facilities únicos, abrangendo regiões e continentes, a escalabilidade entre redes torna-se crítica. As neoclouds precisam federar clusters de GPU distribuídos, mantendo ao mesmo tempo o desempenho de baixa latência e alta largura de banda que as cargas de trabalho de IA exigem.

O Cisco 8223, equipado com Silicon One P200 – o primeiro roteador de buffer profundo de 51,2T do setor – enfrenta esse desafio de frente. Com segurança MACsec integrada, interfaces 800GE com suporte para óptica OSFP e QSFP-DD e capacidade óptica coerente, o 8223 oferece a flexibilidade e a eficiência que as cargas de trabalho de IA distribuída de próxima geração exigem.

O suporte nativo SONiC permite integração perfeita entre back-ends de IA e conectividade WAN, permitindo que as operadoras construam redes abertas e programáveis que podem ser dimensionadas globalmente sem sacrificar as características de desempenho dos clusters locais.

Acelerando redes de IA neocloud com Cisco série 8000

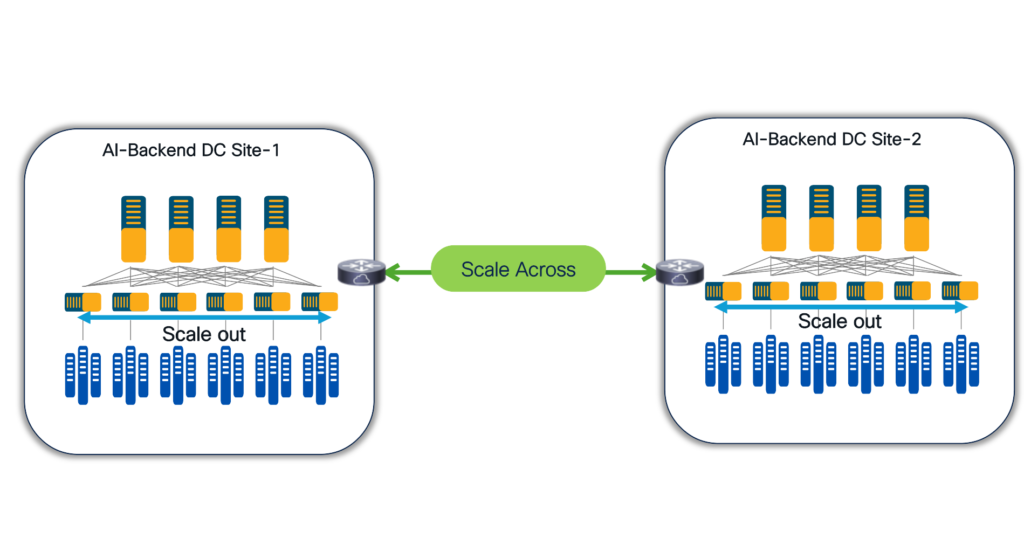

Figura 2: Cisco série 8000 para escalabilidade horizontal e horizontal

Na period da IA, as redes evoluíram de centros de custos de infraestrutura para diferenciadores competitivos. Para neoclouds, o desempenho da rede impacta diretamente a utilização da GPU, a eficiência do treinamento e, em última análise, o sucesso do cliente.

Ao combinar as plataformas Cisco série 8000, os recursos avançados de rede de IA e a abertura do SONiC, as neoclouds podem construir uma infraestrutura que se adapta perfeitamente, opera com eficiência e se adapta à medida que as cargas de trabalho de IA evoluem. Não se trata apenas de acompanhar a inovação em IA – trata-se de habilitá-la.

Recursos adicionais: