Experimente tirar uma foto de cada um dos países da América do Norte aproximadamente 11.000 espécies de árvores e você terá apenas uma fração dos milhões de fotos dos conjuntos de dados de imagens da natureza. Essas enormes coleções de instantâneos — que vão desde borboletas para baleias jubarte — são uma excelente ferramenta de investigação para ecologistas porque fornecem evidências de comportamentos únicos dos organismos, condições raras, padrões de migração e respostas à poluição e outras formas de alterações climáticas.

Embora abrangentes, os conjuntos de dados de imagens da natureza ainda não são tão úteis quanto poderiam ser. É demorado pesquisar nesses bancos de dados e recuperar as imagens mais relevantes para sua hipótese. Você estaria melhor com um assistente de pesquisa automatizado – ou talvez sistemas de inteligência synthetic chamados modelos de linguagem de visão multimodal (VLMs). Eles são treinados em texto e imagens, tornando mais fácil identificar detalhes mais sutis, como as árvores específicas no fundo de uma foto.

Mas até que ponto os VLMs podem ajudar os pesquisadores da natureza na recuperação de imagens? Uma equipe do Laboratório de Ciência da Computação e Inteligência Synthetic (CSAIL) do MIT, da College School London, do iNaturalist e de outros lugares desenvolveu um teste de desempenho para descobrir. A tarefa de cada VLM: localizar e reorganizar os resultados mais relevantes dentro do conjunto de dados “INQUIRE” da equipe, composto por 5 milhões de imagens de vida selvagem e 250 solicitações de pesquisa de ecologistas e outros especialistas em biodiversidade.

Procurando aquele sapo especial

Nessas avaliações, os pesquisadores descobriram que VLMs maiores e mais avançados, treinados com muito mais dados, às vezes podem fornecer aos pesquisadores os resultados que desejam ver. Os modelos tiveram um desempenho razoavelmente bom em consultas simples sobre conteúdo visible, como a identificação de detritos em um recife, mas tiveram dificuldades significativas com consultas que exigiam conhecimento especializado, como a identificação de condições ou comportamentos biológicos específicos. Por exemplo, os VLMs descobriram facilmente exemplos de águas-vivas na praia, mas tiveram dificuldades com instruções mais técnicas, como “axantismo em um sapo verde”, uma condição que limita sua capacidade de tornar a pele amarela.

Suas descobertas indicam que os modelos precisam de muito mais dados de treinamento específicos de domínio para processar consultas difíceis. O estudante de doutorado do MIT, Edward Vendrow, afiliado do CSAIL que co-liderou o trabalho no conjunto de dados em um novo papelacredita que ao se familiarizarem com dados mais informativos, os VLMs poderão um dia ser grandes auxiliares de pesquisa. “Queremos construir sistemas de recuperação que encontrem os resultados exactos que os cientistas procuram quando monitorizam a biodiversidade e analisam as alterações climáticas”, diz Vendrow. “Os modelos multimodais ainda não compreendem uma linguagem científica mais complexa, mas acreditamos que o INQUIRE será uma referência importante para acompanhar como melhoram a compreensão da terminologia científica e, em última análise, ajudar os investigadores a encontrar automaticamente as imagens exatas de que necessitam.”

Os experimentos da equipe ilustraram que modelos maiores tendiam a ser mais eficazes tanto para pesquisas mais simples quanto para pesquisas mais complexas devido aos seus extensos dados de treinamento. Eles primeiro usaram o conjunto de dados INQUIRE para testar se os VLMs poderiam restringir um conjunto de 5 milhões de imagens aos 100 resultados mais relevantes (também conhecidos como “classificação”). Para consultas de pesquisa simples, como “um recife com estruturas e detritos artificiais”, modelos relativamente grandes como “SigLIP”encontrou imagens correspondentes, enquanto os modelos CLIP de tamanho menor tiveram dificuldades. De acordo com Vendrow, VLMs maiores estão “apenas começando a ser úteis” na classificação de consultas mais difíceis.

Vendrow e seus colegas também avaliaram até que ponto os modelos multimodais poderiam reclassificar esses 100 resultados, reorganizando quais imagens eram mais pertinentes para uma pesquisa. Nesses testes, mesmo grandes LLMs treinados em dados mais selecionados, como o GPT-4o, tiveram dificuldades: sua pontuação de precisão foi de apenas 59,6%, a pontuação mais alta alcançada por qualquer modelo.

Os pesquisadores apresentaram esses resultados na Conferência sobre Sistemas de Processamento de Informações Neurais (NeurIPS) no início deste mês.

Consultando para INQUIRE

O conjunto de dados INQUIRE inclui consultas de pesquisa baseadas em discussões com ecologistas, biólogos, oceanógrafos e outros especialistas sobre os tipos de imagens que procuram, incluindo as condições físicas e comportamentos únicos dos animais. Uma equipe de anotadores passou então 180 horas pesquisando o conjunto de dados do iNaturalist com esses prompts, analisando cuidadosamente cerca de 200 mil resultados para rotular 33 mil correspondências que se ajustavam aos prompts.

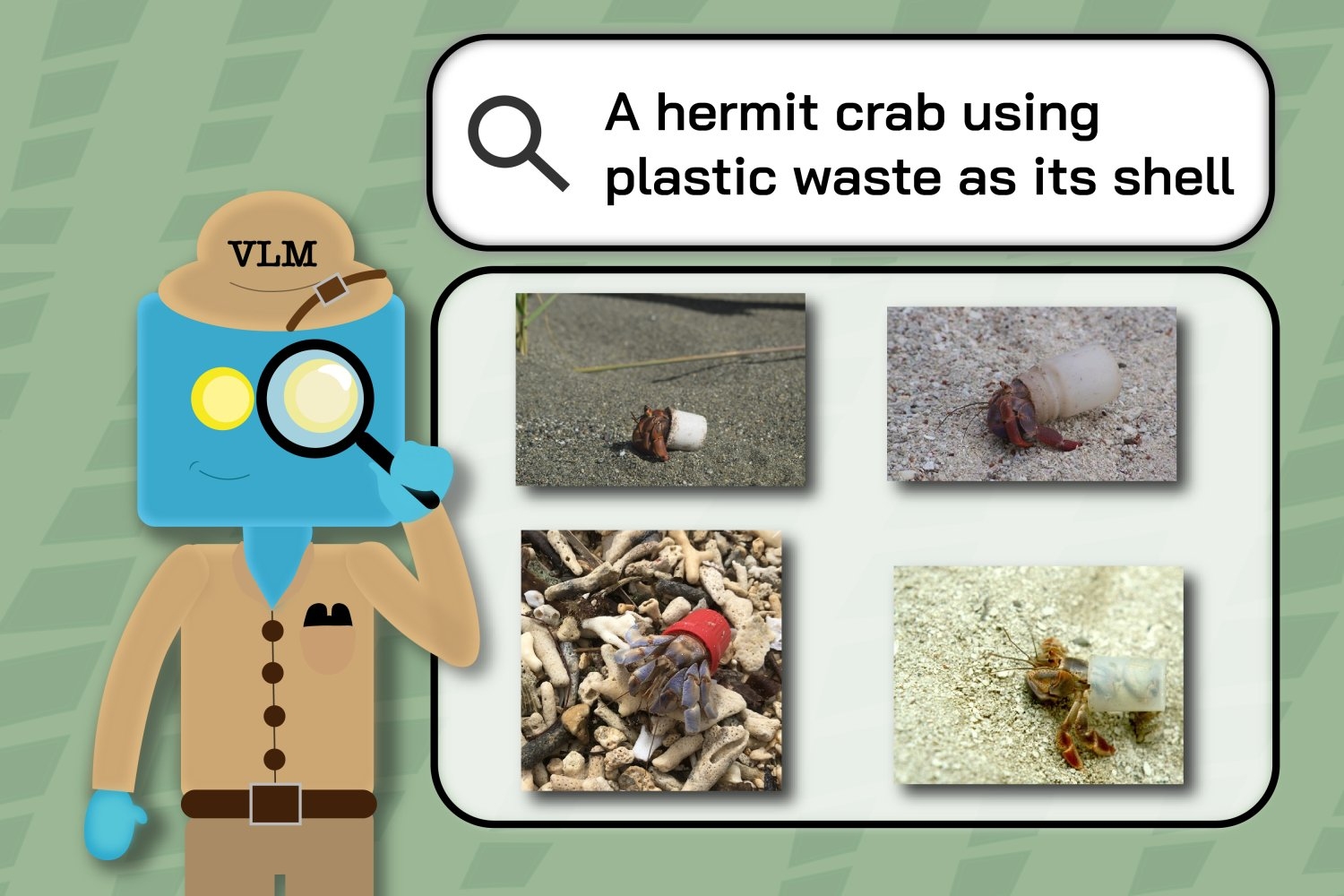

Por exemplo, os anotadores usaram consultas como “um caranguejo eremita usando resíduos de plástico como concha” e “um condor da Califórnia marcado com um ’26’ verde” para identificar os subconjuntos do conjunto de dados de imagens maior que retratam esses eventos raros e específicos.

Em seguida, os pesquisadores usaram as mesmas consultas de pesquisa para ver até que ponto os VLMs poderiam recuperar imagens iNaturalist. Os rótulos dos anotadores revelaram quando os modelos tiveram dificuldade para entender as palavras-chave dos cientistas, pois seus resultados incluíam imagens previamente marcadas como irrelevantes para a pesquisa. Por exemplo, os resultados dos VLMs para “sequóias com cicatrizes de fogo” às vezes incluíam imagens de árvores sem qualquer marcação.

“Esta é uma curadoria cuidadosa de dados, com foco na captura de exemplos reais de investigações científicas em áreas de pesquisa em ecologia e ciências ambientais”, diz Sara Beery, professora assistente de desenvolvimento de carreira Homer A. Burnell no MIT, investigadora principal do CSAIL e co -autor sênior do trabalho. “Isso provou ser very important para expandir nossa compreensão das capacidades atuais dos VLMs nesses ambientes científicos potencialmente impactantes. Também delineou lacunas na investigação precise que podemos agora trabalhar para resolver, particularmente para questões complexas de composição, terminologia técnica, e as diferenças subtis e refinadas que delineiam categorias de interesse para os nossos colaboradores.”

“As nossas descobertas implicam que alguns modelos de visão já são suficientemente precisos para ajudar os cientistas da vida selvagem a recuperar algumas imagens, mas muitas tarefas ainda são demasiado difíceis mesmo para os modelos maiores e de melhor desempenho”, diz Vendrow. “Embora o INQUIRE esteja focado no monitoramento da ecologia e da biodiversidade, a grande variedade de suas consultas significa que os VLMs que funcionam bem no INQUIRE provavelmente se destacarão na análise de grandes coleções de imagens em outros campos de observação intensiva.”

Mentes questionadoras querem ver

Levando o projeto adiante, os pesquisadores estão trabalhando com o iNaturalist para desenvolver um sistema de consulta para ajudar melhor os cientistas e outras mentes curiosas a encontrar as imagens que realmente desejam ver. Seu trabalho demonstração permite que os usuários filtrem as pesquisas por espécie, possibilitando a descoberta mais rápida de resultados relevantes como, por exemplo, as diversas cores dos olhos dos gatos. Vendrow e o co-autor Omiros Pantazis, que recentemente recebeu seu doutorado pela College School London, também pretendem melhorar o sistema de reclassificação, aumentando os modelos atuais para fornecer melhores resultados.

O professor associado da Universidade de Pittsburgh, Justin Kitzes, destaca a capacidade do INQUIRE de descobrir dados secundários. “Os conjuntos de dados sobre biodiversidade estão rapidamente a tornar-se demasiado grandes para serem analisados por qualquer cientista particular person”, diz Kitzes, que não esteve envolvido na investigação. “Este artigo chama a atenção para um problema difícil e não resolvido, que é como pesquisar eficazmente esses dados com perguntas que vão além de simplesmente ‘quem está aqui’ para perguntar sobre características individuais, comportamento e interações entre espécies. Ser capaz de descobrir com eficiência e precisão esses fenômenos mais complexos em dados de imagens de biodiversidade será basic para a ciência basic e para os impactos do mundo actual na ecologia e na conservação.”

Vendrow, Pantazis e Beery escreveram o artigo com o engenheiro de software program iNaturalist Alexander Shepard, os professores da College School London Gabriel Brostow e Kate Jones, o professor associado e co-autor sênior da Universidade de Edimburgo Oisin Mac Aodha e o professor assistente Grant Van da Universidade de Massachusetts em Amherst. Horn, que atuou como co-autor sênior. Seu trabalho foi apoiado, em parte, pelo Laboratório de IA Generativa da Universidade de Edimburgo, pela Fundação Nacional de Ciência dos EUA/Conselho de Pesquisa em Ciências Naturais e Engenharia do Centro International do Canadá sobre IA e Mudança da Biodiversidade, uma bolsa de pesquisa da Royal Society e o Biome Projeto de Saúde financiado pelo World Wildlife Fund Reino Unido.