Neste artigo, você aprenderá padrões práticos de engenharia imediata que tornam grandes modelos de linguagem úteis e confiáveis para análise e previsão de séries temporais.

Os tópicos que cobriremos incluem:

- Como enquadrar o contexto temporal e extrair sinais úteis

- Como combinar o raciocínio LLM com modelos estatísticos clássicos

- Como estruturar dados e prompts para previsões, anomalias e restrições de domínio

Sem mais delongas, vamos começar.

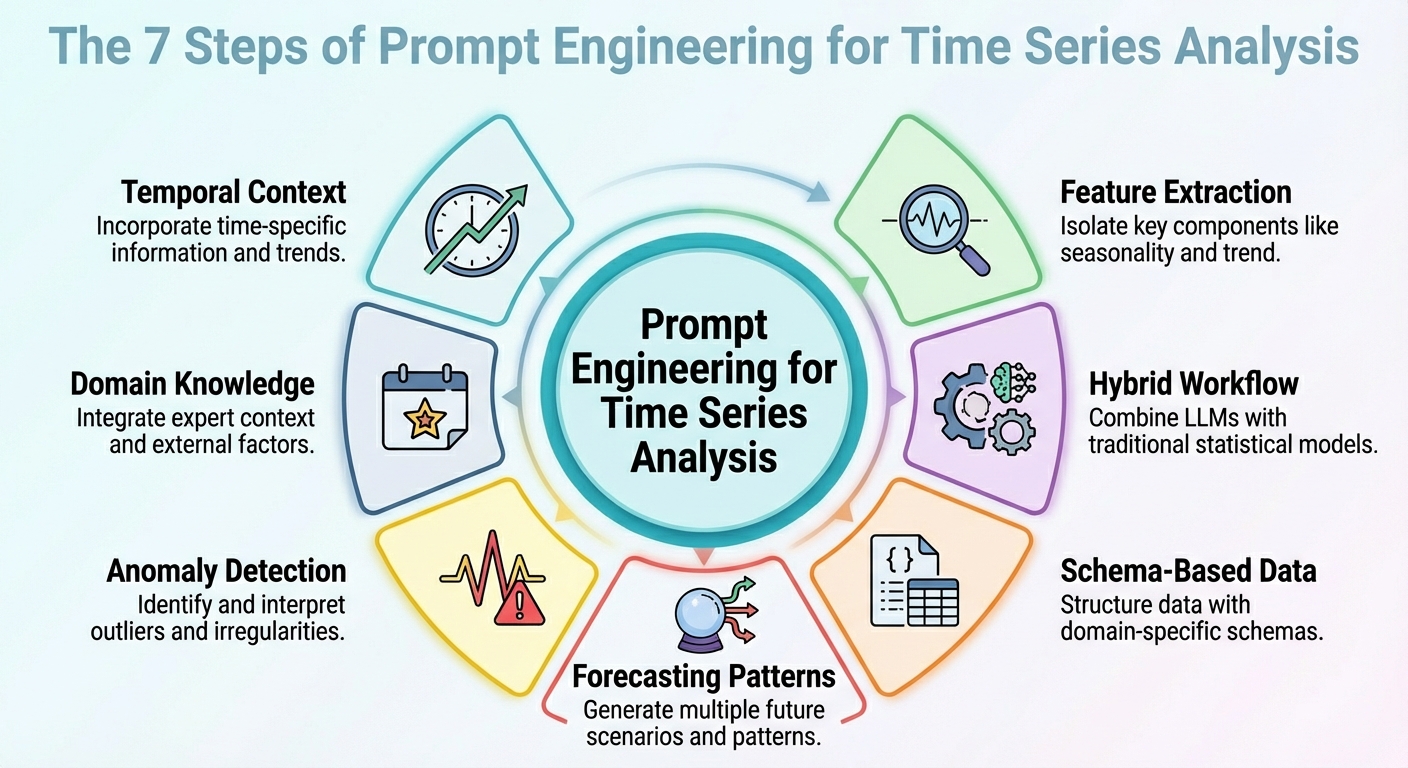

Engenharia imediata para análise de séries temporais

Imagem por Editor

Introdução

Por mais estranho que possa parecer, grandes modelos de linguagem (LLMs) podem ser aproveitados para tarefas de análise de dados, incluindo cenários específicos, como análise de séries temporais. A chave é traduzir corretamente suas habilidades imediatas de engenharia no cenário de análise específico.

Este artigo descreve sete estratégias de engenharia imediatas que pode ser usado para alavancar análise de série temporal tarefas com LLMs.

Salvo indicação em contrário, as descrições destas estratégias são acompanhadas de exemplos ilustrativos que giram em torno de um cenário de dados de vendas no retalho, concretamente, considerando para a sua análise um conjunto de dados de séries temporais constituídos por vendas diárias ao longo do tempo.

1. Contextualizando a Estrutura Temporal

Primeiro, um immediate eficaz para obter um resultado útil do modelo deve ser aquele que o ajude a compreender a estrutura temporal do conjunto de dados da série temporal. Isso inclui possíveis menções a tendências ascendentes/descendentes, sazonalidade, ciclos conhecidos, como promoções ou feriados, e assim por diante. Essas informações de contexto ajudarão seu LLM a interpretar, por exemplo, flutuações temporais como – bem, apenas isso: flutuações, em vez de ruído. Em suma, descrever claramente a estrutura do conjunto de dados no contexto que acompanha seus prompts geralmente vai além de instruções de raciocínio intrincadas nos prompts.

Exemplo de solicitação:

“Aqui estão as vendas diárias (em unidades) dos últimos 365 dias. Os dados mostram uma sazonalidade semanal (vendas mais altas nos finais de semana), uma tendência de aumento gradual de longo prazo e picos mensais no remaining de cada mês devido a promoções nos dias de pagamento.. Use esse conhecimento ao prever os próximos 30 dias.”

2. Extração de recursos e sinais

Em vez de pedir ao seu modelo para realizar previsões diretas a partir de números brutos, por que não solicitar que ele extraia primeiro alguns recursos principais? Isso pode incluir padrões latentes, anomalias e correlações. Pedir ao LLM para extrair características e sinais e incorporá-los no immediate (por exemplo, através de estatísticas resumidas ou decomposição) ajuda a revelar as razões por trás de previsões ou flutuações futuras.

Exemplo de solicitação:

“A partir dos últimos 365 dias de dados de vendas, calcule a média diária de vendas, o desvio padrão, identifique quaisquer dias em que as vendas excederam a média mais duas vezes o desvio padrão (ou seja, possíveis discrepâncias) e observe quaisquer padrões semanais ou mensais recorrentes. Em seguida, interprete quais fatores podem explicar dias de vendas altas ou quedas e sinalize quaisquer anomalias incomuns.”

3. LLM híbrido + fluxo de trabalho estatístico

Sejamos realistas: os LLMs isolados muitas vezes terão dificuldades com tarefas que exigem precisão numérica e captura de dependências temporais em séries temporais. Por esta razão, simplesmente combinar a sua utilização com modelos estatísticos clássicos é uma fórmula para produzir melhores resultados. Como um fluxo de trabalho híbrido como esse poderia ser definido? O truque é injetar raciocínio LLM – interpretação de alto nível, formulação de hipóteses e compreensão de contexto – junto com modelos quantitativos como ARIMA, ETS ou outros.

Por exemplo, LeMoLE (Mistura aprimorada de especialistas lineares LLM) é um exemplo de abordagem híbrida que enriquece modelos lineares com recursos derivados de immediate.

O resultado combina raciocínio contextual e rigor estatístico: o melhor de dois mundos.

4. Representação de dados baseada em esquema

Embora os conjuntos de dados brutos de séries temporais geralmente sejam formatos pouco adequados para passar como entradas do LLM, o uso de esquemas estruturados como JSON ou tabelas compactas pode ser a chave que permite ao LLM interpretar esses dados de maneira muito mais confiável, conforme demonstrado em vários estudos.

Exemplo de snippet JSON a ser passado junto com um immediate:

{ “vendas”: ( {“information”: “01/12/2024”, “unidades”: 120}, {“information”: “02/12/2024”, “unidades”: 135}, ..., {“information”: “30/11/2025”, “unidades”: 210} ), “metadados”: { “freqüência”: “diário”, “sazonalidade”: (“semanalmente”, “fim_mensal”), “domínio”: “vendas_varejo” } } |

Solicitação para acompanhar os dados JSON com:

“Considerando os dados e metadados JSON acima, analise a série temporal e preveja os próximos 30 dias de vendas.”

5. Padrões de previsão solicitados

Projetar e estruturar adequadamente padrões de previsão dentro do immediate – como horizontes de curto prazo versus horizontes de longo prazo ou simular cenários “e se” específicos – pode ajudar a orientar o modelo para produzir respostas mais utilizáveis. Essa abordagem é eficaz para gerar insights altamente acionáveis para a análise solicitada.

Exemplo:

Tarefa UM – Curto–prazo (próximo 7 dias): Previsão esperado vendas. Tarefa B – Longo–prazo (próximo 30 dias): Fornecer um linha de base previsão mais dois cenários: – Cenário 1 (regular condições) – Cenário 2 (com um planejado promoção sobre dias 10–15)

Em adição, fornecer um 95% confiança intervalo para ambos cenários. |

6. Solicitações de detecção de anomalias

Este é mais específico para a tarefa e se concentra na elaboração adequada de prompts que podem ajudar não apenas a fazer previsões com LLMs, mas também a detectar anomalias – em combinação com métodos estatísticos – e raciocinar sobre suas prováveis causas, ou até mesmo sugerir o que investigar. A chave é, mais uma vez, primeiro pré-processar com ferramentas tradicionais de séries temporais e depois solicitar o modelo para interpretação dos resultados.

Exemplo de solicitação:

“Usando o JSON de dados de vendas, primeiro sinalize qualquer dia em que as vendas se desviem mais de 2x o desvio padrão semanal da média semanal. Em seguida, para cada dia sinalizado, explique as possíveis causas (por exemplo, falta de estoque, promoção, eventos externos) e recomende se deve investigar (por exemplo, verificar registros de estoque, campanha de advertising and marketing, tráfego de lojas).”

7. Raciocínio Infundido por Domínio

O conhecimento do domínio, como padrões de sazonalidade do varejo, efeitos de feriados, and many others., revela insights valiosos, e incorporá-los em prompts ajuda os LLMs a realizar análises e previsões que são mais significativas e também interpretáveis. Isto se resume a aproveitar a relevância do “contexto do conjunto de dados”, tanto semanticamente quanto específico do domínio, como o farol que orienta o raciocínio do modelo.

Um immediate como este pode ajudar o LLM a antecipar melhor os picos de remaining de mês ou quedas nas vendas devido a descontos de feriados:

“Estes são os dados diários de vendas de uma rede de varejo. As vendas tendem a aumentar no remaining de cada mês (os clientes recebem salários), cair nos feriados e aumentar durante eventos promocionais. Há também uma escassez ocasional de estoque, resultando em quedas para determinados SKUs. Use esse conhecimento de domínio ao analisar as séries e fazer previsões.”

Concluindo

Este artigo descreveu sete estratégias diferentes, amplamente fundamentadas e apoiadas por estudos recentes, para tornar mais eficazes as solicitações de análise de séries temporais e tarefas de previsão auxiliadas por LLMs.