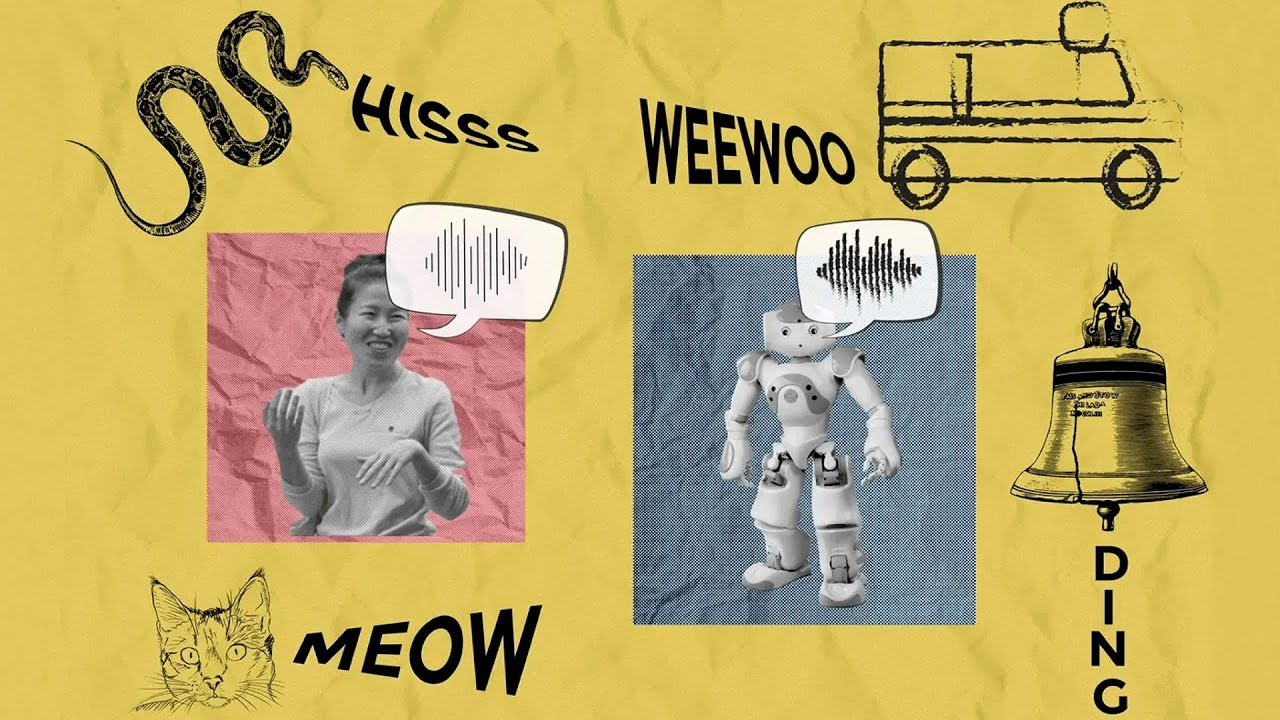

Esteja você descrevendo o som do motor do seu carro com defeito ou miando como o gato do seu vizinho, imitar sons com sua voz pode ser uma maneira útil de transmitir um conceito quando as palavras não funcionam.

A imitação vocal é o equivalente sonoro de rabiscar uma imagem rápida para comunicar algo que você viu – exceto que, em vez de usar um lápis para ilustrar uma imagem, você usa seu trato vocal para expressar um som. Isso pode parecer difícil, mas é algo que todos nós fazemos intuitivamente: para experimentar por si mesmo, tente usar sua voz para espelhar o som da sirene de uma ambulância, de um corvo ou de um sino sendo tocado.

Inspirados pela ciência cognitiva de como nos comunicamos, os pesquisadores do Laboratório de Ciência da Computação e Inteligência Synthetic do MIT (CSAIL) desenvolveram um sistema de IA que pode produzir imitações vocais semelhantes às humanas, sem treinamento e sem nunca ter “ouvido” uma impressão vocal humana antes. .

Para conseguir isso, os pesquisadores projetaram seu sistema para produzir e interpretar sons de maneira muito semelhante à nossa. Eles começaram construindo um modelo do trato vocal humano que simula como as vibrações da caixa vocal são moldadas pela garganta, língua e lábios. Em seguida, eles usaram um algoritmo de IA de inspiração cognitiva para controlar esse modelo de trato vocal e fazê-lo produzir imitações, levando em consideração as formas específicas do contexto que os humanos escolhem para comunicar o som.

O modelo pode efetivamente pegar muitos sons do mundo e gerar uma imitação humana deles – incluindo ruídos como o farfalhar de folhas, o silvo de uma cobra e a sirene de uma ambulância se aproximando. Seu modelo também pode ser executado ao contrário para adivinhar sons do mundo actual a partir de imitações vocais humanas, semelhante à forma como alguns sistemas de visão computacional podem recuperar imagens de alta qualidade com base em esboços. Por exemplo, o modelo pode distinguir corretamente o som de um humano imitando o “miau” de um gato e o seu “assobio”.

No futuro, este modelo poderá potencialmente levar a interfaces “baseadas em imitação” mais intuitivas para designers de som, personagens de IA mais semelhantes aos humanos em realidade digital e até métodos para ajudar os alunos a aprender novas línguas.

Os co-autores principais – os alunos de doutorado do MIT CSAIL, Kartik Chandra SM ’23 e Karima Ma, e o pesquisador de graduação Matthew Caren – observam que os pesquisadores de computação gráfica há muito reconhecem que o realismo raramente é o objetivo ultimate da expressão visible. Por exemplo, uma pintura abstrata ou um rabisco de giz de cera infantil podem ser tão expressivos quanto uma fotografia.

“Nas últimas décadas, os avanços nos algoritmos de esboço levaram a novas ferramentas para artistas, avanços na IA e na visão computacional e até mesmo uma compreensão mais profunda da cognição humana”, observa Chandra. “Da mesma forma que um esboço é uma representação abstrata e não fotorrealista de uma imagem, nosso método captura o abstrato, não fonográfico.–maneiras realistas pelas quais os humanos expressam os sons que ouvem. Isso nos ensina sobre o processo de abstração auditiva.”

“O objetivo deste projeto tem sido compreender e modelar computacionalmente a imitação vocal, que consideramos ser uma espécie de equivalente auditivo do esboço no domínio visible”, diz Caren.

A arte da imitação, em três partes

A equipe desenvolveu três versões cada vez mais diferenciadas do modelo para compará-las às imitações vocais humanas. Primeiro, eles criaram um modelo básico que visava simplesmente gerar imitações tão semelhantes quanto possível aos sons do mundo actual – mas esse modelo não combinava muito bem com o comportamento humano.

Os pesquisadores então projetaram um segundo modelo “comunicativo”. De acordo com Caren, esse modelo considera o que há de distintivo em um som para o ouvinte. Por exemplo, você provavelmente imitaria o som de um barco a motor imitando o ronco de seu motor, já que essa é sua característica auditiva mais distintiva, mesmo que não seja o aspecto mais alto do som (em comparação com, digamos, o respingo de água). Este segundo modelo criou imitações melhores que a linha de base, mas a equipe queria melhorá-lo ainda mais.

Para levar o seu método um passo adiante, os pesquisadores adicionaram uma camada ultimate de raciocínio ao modelo. “As imitações vocais podem soar diferentes com base na quantidade de esforço que você coloca nelas. Custa tempo e energia produzir sons perfeitamente precisos”, diz Chandra. O modelo completo dos pesquisadores explica isso, tentando evitar expressões muito rápidas, altas ou de tom alto ou baixo, que as pessoas têm menos probabilidade de usar em uma conversa. O resultado: imitações mais humanas que se aproximam de muitas das decisões que os humanos tomam ao imitar os mesmos sons.

Depois de construir este modelo, a equipe conduziu um experimento comportamental para ver se as imitações vocais geradas por IA ou por humanos eram percebidas como melhores pelos juízes humanos. Notavelmente, os participantes da experiência favoreceram o modelo de IA 25% das vezes em geral, e até 75% para uma imitação de um barco a motor e 50% para uma imitação de um tiro.

Rumo a uma tecnologia de som mais expressiva

Apaixonada por tecnologia para música e arte, Caren prevê que este modelo poderia ajudar os artistas a comunicar melhor os sons aos sistemas computacionais e ajudar os cineastas e outros criadores de conteúdo a gerar sons de IA com mais nuances para um contexto específico. Também poderia permitir que um músico pesquise rapidamente um banco de dados de sons, imitando um ruído que é difícil de descrever, por exemplo, em um immediate de texto.

Entretanto, Caren, Chandra e Ma estão a analisar as implicações do seu modelo noutros domínios, incluindo o desenvolvimento da linguagem, a forma como as crianças aprendem a falar e até mesmo comportamentos de imitação em aves como papagaios e pássaros canoros.

A equipe ainda tem trabalho a fazer com a iteração atual de seu modelo: ele luta com algumas consoantes, como “z”, o que levou a impressões imprecisas de alguns sons, como o zumbido das abelhas. Eles também ainda não conseguem replicar como os humanos imitam a fala, a música ou sons que são imitados de maneira diferente em diferentes idiomas, como os batimentos cardíacos.

O professor de lingüística da Universidade de Stanford, Robert Hawkins, diz que a linguagem é cheia de onomatopeias e palavras que imitam, mas não reproduzem totalmente, as coisas que descrevem, como o som de “miau”, que se aproxima de maneira muito inexata do som que os gatos fazem. “Os processos que nos levam do som de um gato actual a uma palavra como ‘miau’ revelam muito sobre a intrincada interação entre fisiologia, raciocínio social e comunicação na evolução da linguagem”, diz Hawkins, que não esteve envolvido na pesquisa CSAIL. “Este modelo apresenta um passo emocionante para formalizar e testar teorias desses processos, demonstrando que tanto as restrições físicas do trato vocal humano como as pressões sociais da comunicação são necessárias para explicar a distribuição das imitações vocais.”

Caren, Chandra e Ma escreveram o artigo com dois outros afiliados do CSAIL: Jonathan Ragan-Kelley, professor associado do Departamento de Engenharia Elétrica e Ciência da Computação do MIT, e Joshua Tenenbaum, professor de Cérebro e Ciências Cognitivas do MIT e Centro de Cérebros, Mentes e Máquinas membro. O seu trabalho foi apoiado, em parte, pela Hertz Basis e pela Nationwide Science Basis. Foi apresentado na SIGGRAPH Asia no início de dezembro.