O Mannequin Context Protocol (MCP) e o Agent-to-Agent (A2A) ganharam uma atenção significativa da indústria no ano passado. O MCP chamou a atenção do mundo de forma dramática pela primeira vez quando foi publicado pela Anthropic em novembro de 2024, conquistando dezenas de milhares de estrelas no GitHub no primeiro mês. As organizações rapidamente perceberam o valor do MCP como uma forma de abstrair APIs em linguagem pure, permitindo que os LLMs as interpretassem e usassem facilmente como ferramentas. Em abril de 2025, o Google introduziu o A2A, fornecendo um novo protocolo que permite aos agentes descobrir as capacidades uns dos outros, possibilitando o rápido crescimento e escalonamento dos sistemas de agentes.

Ambos os protocolos estão alinhados com a Linux Basis e são projetados para sistemas agentes, mas suas curvas de adoção diferiram significativamente. O MCP teve uma adoção rápida, enquanto o progresso do A2A foi mais lento. Isto levou a comentários da indústria sugerindo que o A2A está silenciosamente desaparecendo em segundo plano, com muitas pessoas acreditando que o MCP emergiu como o padrão de fato para sistemas de agentes.

Como esses dois protocolos se comparam? Existe realmente uma batalha épica em andamento entre MCP e A2A? Será que será Blu-ray x HD-DVD ou VHS x Betamax de novo? Bem, não exatamente. A realidade é que, embora exista alguma sobreposição, elas operam em diferentes níveis da pilha de agentes e são ambas altamente relevantes.

O MCP foi projetado como uma forma de os LLMs entenderem quais ferramentas externas estão disponíveis para ele. Antes do MCP, essas ferramentas eram expostas principalmente por meio de APIs. No entanto, o tratamento bruto da API por um LLM é desajeitado e difícil de escalar. Os LLMs são projetados para operar no mundo da linguagem pure, onde interpretam uma tarefa e identificam a ferramenta certa capaz de realizá-la. As APIs também sofrem com problemas relacionados à padronização e controle de versão. Por exemplo, se uma API passar por uma atualização de versão, como o LLM saberia disso e a usaria corretamente, especialmente ao tentar escalar entre milhares de APIs? Isso rapidamente se torna um empecilho. Estes foram precisamente os problemas que o MCP foi concebido para resolver.

Arquitetonicamente, o MCP funciona bem – isto é, até certo ponto. À medida que o número de ferramentas em um servidor MCP aumenta, as descrições e o manifesto das ferramentas enviados ao LLM podem se tornar enormes, consumindo rapidamente toda a janela de contexto do immediate. Isto afeta até mesmo os maiores LLMs, incluindo aqueles que suportam centenas de milhares de tokens. Em escala, isso se torna uma restrição elementary. Recentemente, houve avanços impressionantes na redução da contagem de tokens usados pelos servidores MCP, mas mesmo assim, os limites de escalabilidade do MCP provavelmente permanecerão.

É aqui que entra o A2A. O A2A não opera no nível de ferramentas ou descrições de ferramentas e não se envolve nos detalhes da abstração da API. Em vez disso, a A2A introduz o conceito de Cartões de Agente, que são descritores de alto nível que capturam as capacidades gerais de um agente, em vez de listar explicitamente as ferramentas ou habilidades detalhadas que o agente pode acessar. Além disso, o A2A funciona exclusivamente entre agentes, o que significa que não tem a capacidade de interagir diretamente com ferramentas ou sistemas finais como o MCP faz.

Então, qual você deve usar? Qual é melhor? Em última análise, a resposta é ambas.

Se você estiver construindo um sistema de agente simples com um único agente supervisor e uma variedade de ferramentas que ele pode acessar, o MCP por si só pode ser a opção superb, desde que o immediate permaneça compacto o suficiente para caber na janela de contexto do LLM (que inclui todo o orçamento do immediate, incluindo esquemas de ferramentas, instruções do sistema, estado da conversa, documentos recuperados e muito mais). No entanto, se você estiver implantando um sistema multiagente, provavelmente precisará adicionar A2A ao combine.

Think about um agente supervisor responsável por lidar com uma solicitação como “analisar problemas de roaming de Wi-Fi e recomendar estratégias de mitigação”. Em vez de expor diretamente todas as ferramentas possíveis, o supervisor usa A2A para descobrir agentes especializados – como um agente de análise de RF, um agente de autenticação de usuário e um agente de desempenho de rede – com base em seus cartões de agente de alto nível. Depois que o agente apropriado for selecionado, esse agente poderá usar o MCP para descobrir e invocar as ferramentas específicas de que necessita. Nesse fluxo, o A2A fornece roteamento escalonável em nível de agente, enquanto o MCP fornece execução precisa em nível de ferramenta.

O ponto principal é que o A2A pode – e muitas vezes deve – ser usado em conjunto com o MCP. Esta não é uma decisão MCP versus A2A; é arquitetural, onde ambos os protocolos podem ser aproveitados à medida que o sistema cresce e evolui.

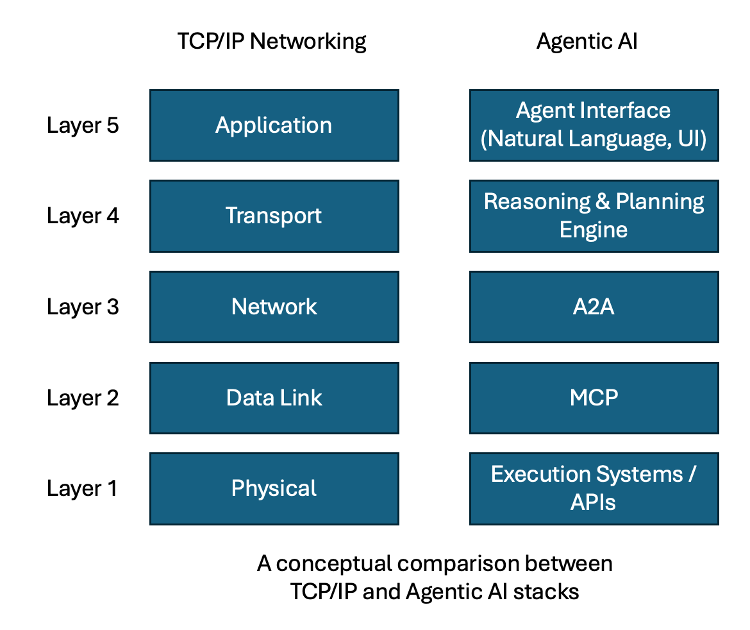

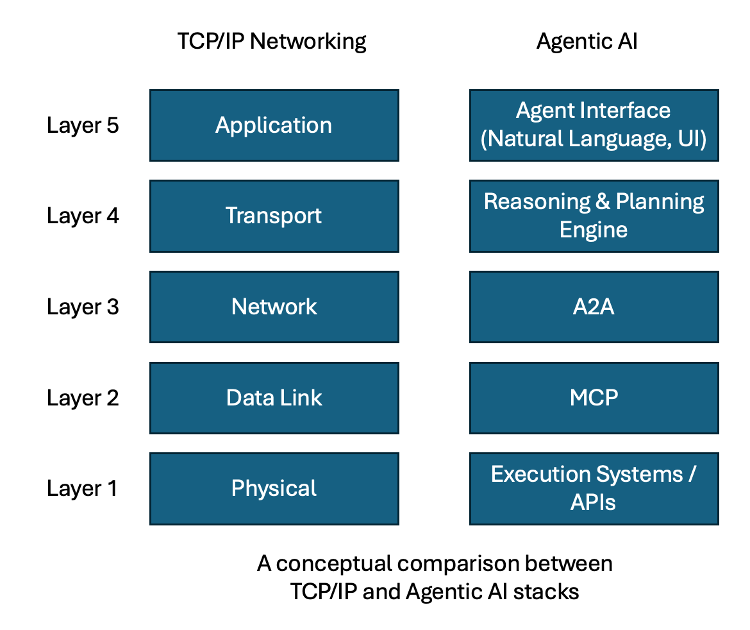

O modelo psychological que gosto de usar vem do mundo das redes. Nos primórdios das redes de computadores, as redes eram pequenas e independentes, onde um único domínio da Camada 2 (a camada de enlace de dados) period suficiente. À medida que as redes cresceram e se tornaram interconectadas, os limites da Camada 2 foram rapidamente alcançados, necessitando da introdução de roteadores e protocolos de roteamento – conhecidos como Camada 3 (a camada de rede). Os roteadores funcionam como limites para redes de Camada 2, permitindo que sejam interconectadas e, ao mesmo tempo, evitando que o tráfego de transmissão inunde todo o sistema. No roteador, as redes são descritas em termos resumidos e de nível superior, em vez de expor todos os detalhes subjacentes. Para que um computador se comunique fora de sua rede imediata de Camada 2, ele deve primeiro descobrir o roteador mais próximo, sabendo que o destino pretendido existe em algum lugar além desse limite.

Isso mapeia de perto a relação entre MCP e A2A. O MCP é análogo a uma rede de camada 2: fornece visibilidade detalhada e acesso direto, mas não pode ser dimensionado indefinidamente. A2A é análogo ao limite de roteamento da Camada 3, que agrega informações de nível superior sobre capacidades e fornece um gateway para o restante da rede agente.

A comparação pode não ser uma combinação perfeita, mas oferece um modelo psychological intuitivo que ressoa com aqueles que têm experiência em networking. Assim como as redes modernas são construídas na Camada 2 e na Camada 3, os sistemas de IA de agência eventualmente também exigirão a pilha completa. Sob esta luz, o MCP e o A2A não devem ser considerados padrões concorrentes. Com o tempo, ambos provavelmente se tornarão camadas críticas da pilha de agentes maior, à medida que construímos sistemas de IA cada vez mais sofisticados.

As equipes que reconhecerem isso cedo serão aquelas que escalarão com sucesso seus sistemas de agente em arquiteturas duráveis e de nível de produção.