Geração de recuperação usededed (RAG) é uma abordagem para a construção de sistemas de IA que combina um modelo de idioma com uma fonte de conhecimento externa. Em termos simples, a IA primeiro procura documentos relevantes (como artigos ou páginas da net) relacionados à consulta de um usuário e, em seguida, usa esses documentos para gerar uma resposta mais precisa. Este método foi comemorado por ajudar Modelos de idiomas grandes (LLMS) Mantenha -se factual e reduza as alucinações, fundamentando suas respostas em dados reais.

Intuitivamente, pode -se pensar que quanto mais documentos uma IA recupera, mais informada sua resposta será. No entanto, pesquisas recentes sugerem uma reviravolta surpreendente: quando se trata de alimentar informações a uma IA, às vezes menos é mais.

Menos documentos, melhores respostas

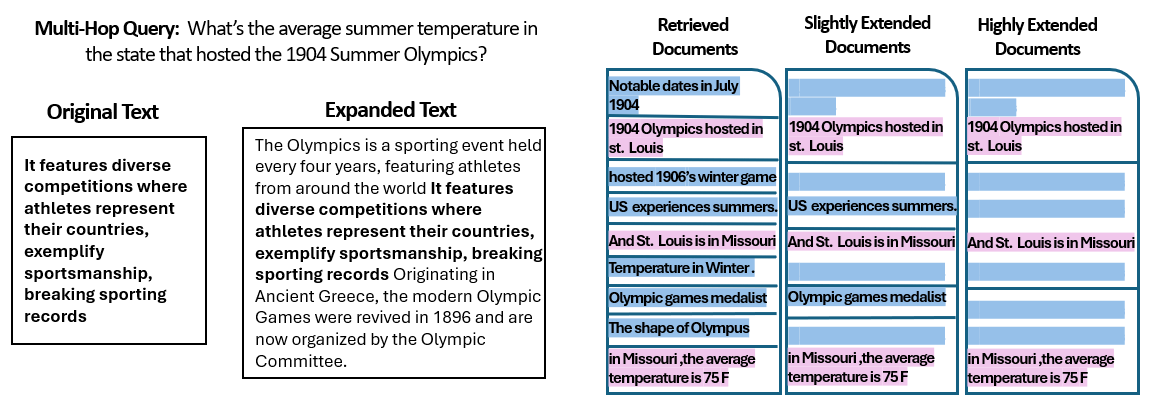

UM Novo estudo por pesquisadores da Universidade Hebraica de Jerusalém exploraram como o número de documentos dados a um sistema de pano afeta seu desempenho. Fundamentalmente, eles mantiveram a quantidade complete de texto constante – o que significa que, se menos documentos fossem fornecidos, esses documentos foram ligeiramente expandidos para preencher o mesmo comprimento que muitos documentos. Dessa forma, quaisquer diferenças de desempenho podem ser atribuídas à quantidade de documentos, em vez de simplesmente ter uma entrada mais curta.

Os pesquisadores usaram um conjunto de dados de resposta a perguntas (Musique) com perguntas triviais, cada uma emparelhada originalmente com 20 parágrafos da Wikipedia (apenas alguns dos quais realmente contêm a resposta, com o restante sendo distratores). Ao aparar o número de documentos de 20 para apenas os 2 a 4 verdadeiramente relevantes – e preenchendo aqueles com um pouco de contexto additional para manter um comprimento consistente – eles criaram cenários em que a IA tinha menos peças de materials a considerar, mas ainda assim as mesmas palavras totais para ler.

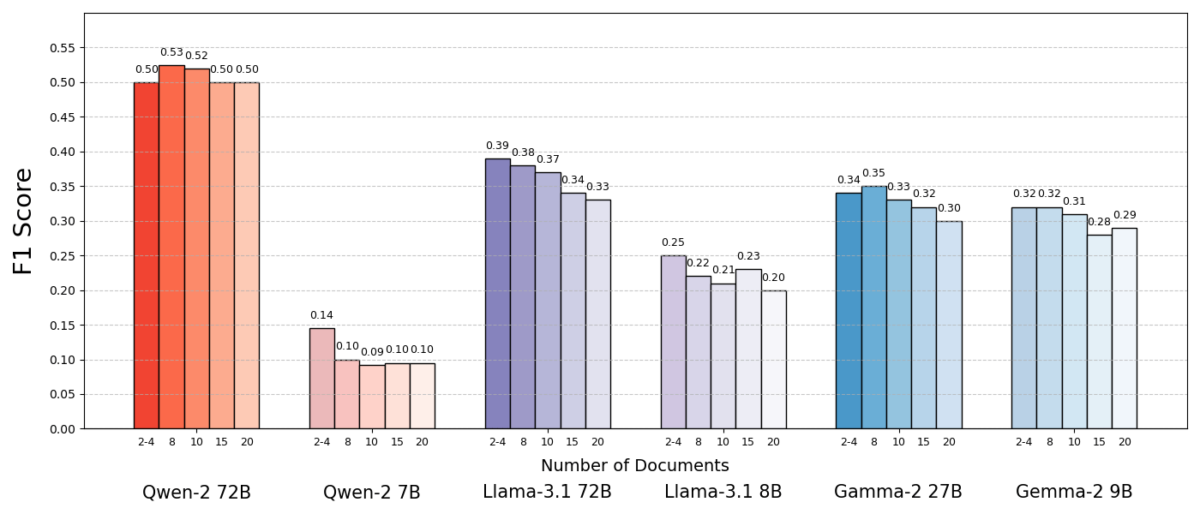

Os resultados foram impressionantes. Na maioria dos casos, os modelos de IA responderam com mais precisão quando receberam menos documentos do que o conjunto completo. O desempenho melhorou significativamente – em alguns casos em até 10% na precisão (pontuação de F1) quando o sistema usou apenas um punhado de documentos de suporte em vez de uma grande coleção. Esse impulso contra-intuitivo foi observado em vários modelos diferentes de idiomas de código aberto, incluindo variantes da lhama de Meta e outros, indicando que o fenômeno não está ligado a um único modelo de IA.

Um modelo (Qwen-2) foi uma exceção notável que lidou com vários documentos sem uma queda na pontuação, mas quase todos os modelos testados tiveram um desempenho melhor com menos documentos em geral. Em outras palavras, adicionar mais materials de referência além das principais peças relevantes prejudicam seu desempenho com mais frequência do que ajudou.

Fonte: Levy et al.

Por que isso é uma surpresa? Normalmente, os sistemas de pano são projetados sob a suposição de que recuperar uma série mais ampla de informações só pode ajudar a IA – afinal, se a resposta não estiver nos primeiros documentos, poderá estar no décimo ou vigésimo.

Este estudo vira esse script, demonstrando que a acumulação indiscriminada em documentos extras pode sair pela culatra. Mesmo quando o comprimento complete do texto foi mantido constante, a mera presença de muitos documentos diferentes (cada um com seu próprio contexto e peculiaridades) tornou a tarefa de resposta à pergunta mais desafiadora para a IA. Parece que, além de um certo ponto, cada documento adicional introduziu mais ruído do que sinal, confundindo o modelo e prejudicando sua capacidade de extrair a resposta correta.

Por que menos pode ser mais em pano

Esse resultado “menos é mais” faz sentido quando consideramos como os modelos de idiomas da IA processam as informações. Quando uma IA recebe apenas os documentos mais relevantes, o contexto que vê é focado e livre de distrações, assim como um aluno que recebeu as páginas certas para estudar.

No estudo, os modelos tiveram um desempenho significativamente melhor quando recebidos apenas os documentos de suporte, com materials irrelevante removido. O contexto restante não period apenas mais curto, mas também mais limpo – continha fatos que apontavam diretamente para a resposta e nada mais. Com menos documentos para fazer malabarismos, o modelo pode dedicar toda a sua atenção às informações pertinentes, tornando menos provável que seja desviado ou confuso.

Por outro lado, quando muitos documentos foram recuperados, a IA teve que vasculhar uma mistura de conteúdo relevante e irrelevante. Muitas vezes, esses documentos extras eram “semelhantes, mas não relacionados” – eles podem compartilhar um tópico ou palavras -chave com a consulta, mas na verdade não contêm a resposta. Esse conteúdo pode enganar o modelo. A IA pode desperdiçar esforços tentando conectar pontos entre documentos que na verdade não levam a uma resposta correta, ou pior, pode mesclar informações de várias fontes incorretamente. Isso aumenta o risco de alucinações – casos em que a IA gera uma resposta que soa plausível, mas não está fundamentada em nenhuma fonte única.

Em essência, alimentar muitos documentos para o modelo pode diluir as informações úteis e introduzir detalhes conflitantes, dificultando a opção da IA para decidir o que é verdadeiro.

Curiosamente, os pesquisadores descobriram que, se os documentos extras fossem obviamente irrelevantes (por exemplo, texto não relacionado aleatório), os modelos eram melhores em ignorá -los. O problema actual vem da distração de dados que parecem relevantes: quando todos os textos recuperados estão em tópicos semelhantes, a IA assume que deve usar todos eles, e pode ter dificuldade para dizer quais detalhes são realmente importantes. Isso se alinha à observação do estudo que Distratores aleatórios causaram menos confusão do que distratores realistas na entrada. A IA pode filtrar bobagens flagrantes, mas informações sutilmente fora do tópico são uma armadilha escorregadia-ela se infiltra sob o disfarce de relevância e descarrila a resposta. Ao reduzir o número de documentos apenas para os realmente necessários, evitamos definir essas armadilhas em primeiro lugar.

Há também um benefício prático: recuperar e processar menos documentos reduz a sobrecarga computacional para um sistema de pano. Todo documento que é puxado deve ser analisado (incorporado, lido e atendido pelo modelo), que usa recursos de tempo e computação. A eliminação de documentos supérfluos torna o sistema mais eficiente – ele pode encontrar respostas mais rápidas e com menor custo. Em cenários em que a precisão melhorou, concentrando-se em menos fontes, obtemos uma vitória: melhores respostas e um processo mais enxuto e eficiente.

Fonte: Levy et al.

Repensando o pano: direções futuras

Essa nova evidência de que a qualidade geralmente supera a quantidade de recuperação tem implicações importantes para o futuro dos sistemas de IA que dependem do conhecimento externo. Ele sugere que os designers de sistemas de pano devem priorizar a filtragem inteligente e a classificação de documentos em relação ao quantity. Em vez de buscar 100 passagens possíveis e esperando que a resposta esteja enterrada lá em algum lugar, pode ser mais sábio buscar apenas os dos principais primeiros relevantes.

Os autores do estudo enfatizam a necessidade de métodos de recuperação de “encontrar um equilíbrio entre relevância e diversidade” nas informações que eles fornecem a um modelo. Em outras palavras, queremos fornecer cobertura suficiente do tópico para responder à pergunta, mas não tanto que os fatos centrais sejam afogados em um mar de texto estranho.

Avançando, é provável que os pesquisadores explorem técnicas que ajudem os modelos de IA a lidar com vários documentos com mais graciosidade. Uma abordagem é desenvolver melhores sistemas de retriever ou re-classificadores que possam identificar quais documentos realmente agregam valor e quais apenas introduzem conflitos. Outro ângulo está melhorando os modelos de idiomas: se um modelo (como QWEN-2) conseguiu lidar com muitos documentos sem perder a precisão, examinar como foi treinado ou estruturado poderia oferecer pistas para tornar outros modelos mais robustos. Talvez os futuros modelos de linguagem grande incorporem mecanismos para reconhecer quando duas fontes estão dizendo a mesma coisa (ou se contradizem) e se concentram de acordo. O objetivo seria permitir que os modelos utilizassem uma rica variedade de fontes sem serem vítimas de confusão – obtendo efetivamente o melhor dos dois mundos (amplitude de informação e clareza de foco).

Também vale a pena notar que Os sistemas de IA ganham janelas de contexto maiores (A capacidade de ler mais texto de uma só vez), basta despejar mais dados no immediate não é uma bala de prata. O contexto maior não significa automaticamente uma melhor compreensão. Este estudo mostra que, mesmo que uma IA possa ler tecnicamente 50 páginas por vez, fornecer 50 páginas de informações de qualidade mista pode não produzir um bom resultado. O modelo ainda se beneficia de ter selecionado conteúdo relevante e com curadoria para trabalhar, em vez de um despejo indiscriminado. De fato, a recuperação inteligente pode se tornar ainda mais essential na period das janelas gigantes de contexto – para garantir que a capacidade additional seja usada para conhecimento valioso e não ruído.

As descobertas de “Mais documentos, o mesmo comprimento” (O artigo apropriadamente intitulado) Incentive o reexame de nossas suposições na pesquisa de IA. Às vezes, alimentar uma IA todos os dados que temos não é tão eficaz quanto pensamos. Ao focar nas informações mais relevantes, não apenas melhoramos a precisão das respostas geradas pela IA, mas também tornamos os sistemas mais eficientes e fáceis de confiar. É uma lição contra -intuitiva, mas com ramificações emocionantes: os futuros sistemas de pano podem ser mais inteligentes e mais magros, escolhendo cuidadosamente menos documentos melhores para recuperar.