Digamos que uma pessoa leve seu Bulldog Francês, Bowser, ao parque canino. Identificar Bowser enquanto ele brinca entre os outros caninos é fácil para o dono do cachorro enquanto estiver no native.

Mas se alguém quiser usar um modelo generativo de IA como o GPT-5 para monitorar seu animal de estimação enquanto ele está no trabalho, o modelo poderá falhar nesta tarefa básica. Modelos de linguagem visible como o GPT-5 geralmente são excelentes no reconhecimento de objetos gerais, como um cachorro, mas têm um desempenho ruim na localização de objetos personalizados, como Bowser, o Bulldog Francês.

Para resolver esta lacuna, pesquisadores do MIT, do MIT-IBM Watson AI Lab, do Weizmann Institute of Science e de outros lugares introduziram um novo método de treinamento que ensina modelos de linguagem de visão para localizar objetos personalizados em uma cena.

Seu método usa dados de rastreamento de vídeo cuidadosamente preparados, nos quais o mesmo objeto é rastreado em vários quadros. Eles projetaram o conjunto de dados para que o modelo se concentrasse em pistas contextuais para identificar o objeto personalizado, em vez de confiar no conhecimento previamente memorizado.

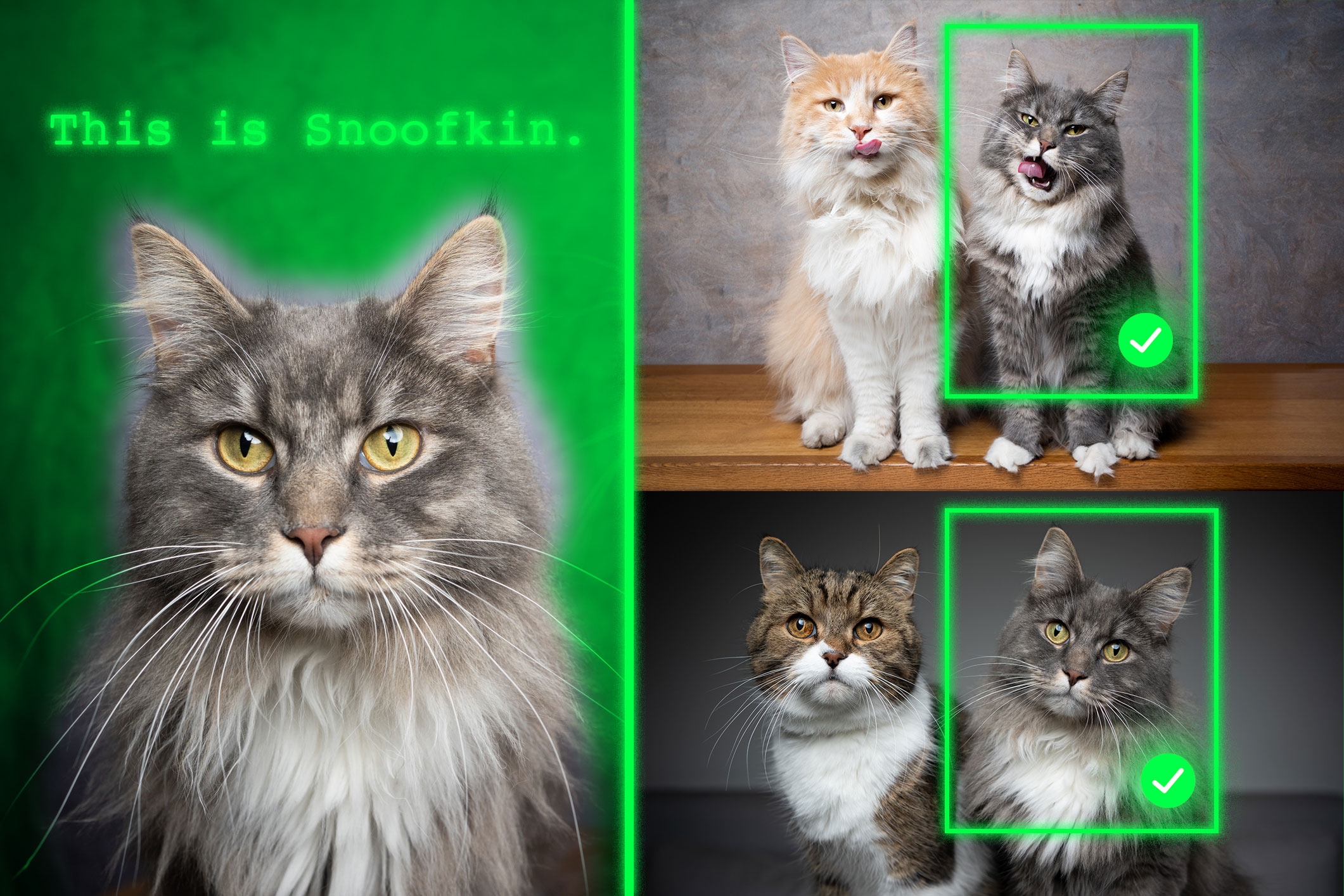

Ao receber alguns exemplos de imagens que mostram um objeto personalizado, como o animal de estimação de alguém, o modelo retreinado é mais capaz de identificar a localização desse mesmo animal de estimação em uma nova imagem.

Os modelos retreinados com seu método superaram os sistemas de última geração nessa tarefa. É importante ressaltar que sua técnica deixa intactas o restante das habilidades gerais do modelo.

Esta nova abordagem poderá ajudar futuros sistemas de IA a rastrear objetos específicos ao longo do tempo, como a mochila de uma criança, ou a localizar objetos de interesse, como uma espécie de animal em monitorização ecológica. Também poderia ajudar no desenvolvimento de tecnologias assistivas baseadas em IA que ajudam os usuários com deficiência visible a encontrar determinados itens em uma sala.

“Em última análise, queremos que esses modelos sejam capazes de aprender a partir do contexto, assim como os humanos fazem. Se um modelo puder fazer isso bem, em vez de treiná-lo novamente para cada nova tarefa, poderíamos apenas fornecer alguns exemplos e ele inferiria como executar a tarefa a partir desse contexto. Esta é uma habilidade muito poderosa”, diz Jehanzeb Mirza, pós-doutorado no MIT e autor sênior de um estudo. artigo sobre esta técnica.

Mirza é acompanhado no artigo pelos co-autores principais Sivan Doveh, um pós-doutorado na Universidade de Stanford que period estudante de graduação no Weizmann Institute of Science quando esta pesquisa foi conduzida; e Nimrod Shabtay, pesquisador da IBM Analysis; James Glass, pesquisador sênior e chefe do Grupo de Sistemas de Linguagem Falada no Laboratório de Ciência da Computação e Inteligência Synthetic do MIT (CSAIL); e outros. O trabalho será apresentado na Conferência Internacional sobre Visão Computacional.

Uma deficiência inesperada

Os pesquisadores descobriram que grandes modelos de linguagem (LLMs) podem se destacar no aprendizado a partir do contexto. Se eles alimentarem um LLM com alguns exemplos de uma tarefa, como problemas de adição, ele poderá aprender a responder a novos problemas de adição com base no contexto fornecido.

Um modelo de linguagem de visão (VLM) é essencialmente um LLM com um componente visible conectado a ele, então os pesquisadores do MIT pensaram que ele herdaria os recursos de aprendizagem em contexto do LLM. Mas este não é o caso.

“A comunidade de investigação ainda não conseguiu encontrar uma resposta definitiva para este problema específico. O estrangulamento pode surgir do facto de alguma informação visible ser perdida no processo de fusão dos dois componentes, mas simplesmente não sabemos”, diz Mirza.

Os pesquisadores decidiram melhorar as habilidades do VLM para fazer localização no contexto, o que envolve encontrar um objeto específico em uma nova imagem. Eles se concentraram nos dados usados para treinar novamente os VLMs existentes para uma nova tarefa, um processo chamado ajuste fino.

Os dados típicos de ajuste fino são coletados de fontes aleatórias e representam coleções de objetos do cotidiano. Uma imagem pode conter carros estacionados na rua, enquanto outra inclui um buquê de flores.

“Não há coerência actual nesses dados, então o modelo nunca aprende a reconhecer o mesmo objeto em múltiplas imagens”, afirma.

Para resolver esse problema, os pesquisadores desenvolveram um novo conjunto de dados selecionando amostras de dados de rastreamento de vídeo existentes. Esses dados são videoclipes que mostram o mesmo objeto se movendo em uma cena, como um tigre caminhando por uma pastagem.

Eles cortaram quadros desses vídeos e estruturaram o conjunto de dados para que cada entrada consistisse em múltiplas imagens mostrando o mesmo objeto em contextos diferentes, com exemplos de perguntas e respostas sobre sua localização.

“Ao usar múltiplas imagens do mesmo objeto em diferentes contextos, incentivamos o modelo a localizar consistentemente esse objeto de interesse, concentrando-se no contexto”, explica Mirza.

Forçando o foco

Mas os pesquisadores descobriram que os VLMs tendem a trapacear. Em vez de responder com base em pistas contextuais, eles identificarão o objeto usando o conhecimento adquirido durante o pré-treinamento.

Por exemplo, uma vez que o modelo já aprendeu que a imagem de um tigre e o rótulo “tigre” estão correlacionados, poderia identificar o tigre que atravessa a pastagem com base neste conhecimento pré-treinado, em vez de inferir a partir do contexto.

Para resolver esse problema, os pesquisadores usaram pseudonomes em vez de nomes reais de categorias de objetos no conjunto de dados. Neste caso, eles mudaram o nome do tigre para “Charlie”.

“Demoramos um pouco para descobrir como evitar que o modelo trapaceasse. Mas mudamos o jogo para o modelo. O modelo não sabe que ‘Charlie’ pode ser um tigre, então é forçado a olhar para o contexto”, diz ele.

Os pesquisadores também enfrentaram desafios para encontrar a melhor forma de preparar os dados. Se os quadros estiverem muito próximos, o fundo não mudará o suficiente para fornecer diversidade de dados.

No remaining, o ajuste fino dos VLMs com este novo conjunto de dados melhorou a precisão na localização personalizada em cerca de 12%, em média. Quando incluíram o conjunto de dados com pseudonomes, os ganhos de desempenho atingiram 21%.

À medida que o tamanho do modelo aumenta, sua técnica leva a maiores ganhos de desempenho.

No futuro, os pesquisadores querem estudar as possíveis razões pelas quais os VLMs não herdam capacidades de aprendizagem em contexto de seus LLMs básicos. Além disso, planeiam explorar mecanismos adicionais para melhorar o desempenho de um VLM sem a necessidade de treiná-lo novamente com novos dados.

“Este trabalho reformula a localização de objetos personalizados em poucas tomadas — adaptando-se dinamicamente ao mesmo objeto em novas cenas — como um problema de ajuste de instrução e usa sequências de rastreamento de vídeo para ensinar VLMs a localizar com base no contexto visible em vez de courses anteriores. Ele também apresenta o primeiro benchmark para essa configuração com ganhos sólidos em VLMs abertos e proprietários. Dada a imensa importância do aterramento rápido e específico da instância — muitas vezes sem ajuste fino — para usuários de fluxos de trabalho do mundo actual (como robótica, assistentes de realidade aumentada, ferramentas criativas, and so on.), a receita prática e centrada em dados oferecida por este trabalho pode ajudar a melhorar a adoção generalizada de modelos básicos de linguagem de visão”, diz Saurav Jha, pós-doutorado no Mila-Quebec Synthetic Intelligence Institute, que não esteve envolvido neste trabalho.

Coautores adicionais são Wei Lin, pesquisador associado da Universidade Johannes Kepler; Eli Schwartz, cientista pesquisador da IBM Analysis; Hilde Kuehne, professora de ciência da computação no Tuebingen AI Middle e professora afiliada do MIT-IBM Watson AI Lab; Raja Giryes, professor associado da Universidade de Tel Aviv; Rogerio Feris, principal cientista e gerente do MIT-IBM Watson AI Lab; Leonid Karlinsky, principal cientista pesquisador da IBM Analysis; Assaf Arbelle, cientista pesquisador sênior da IBM Analysis; e Shimon Ullman, professor Samy e Ruth Cohn de Ciência da Computação no Weizmann Institute of Science.

Esta pesquisa foi financiada, em parte, pelo MIT-IBM Watson AI Lab.