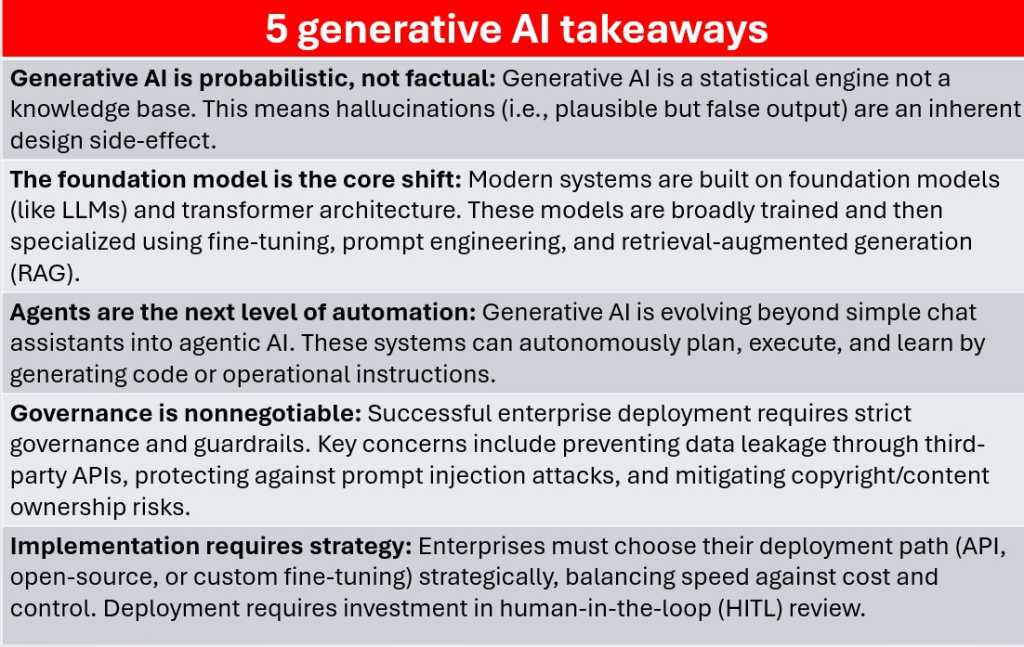

Todo sistema generativo de IA, não importa quão avançado seja, é construído em torno da previsão. Lembre-se, um modelo não é verdadeiramente saber fatos – ele analisa uma série de tokens e, em seguida, calcula, com base na análise de seus dados de treinamento subjacentes, qual token tem maior probabilidade de vir a seguir. Isto é o que torna o resultado fluente e humano, mas se a sua previsão estiver errada, isso será percebido como uma alucinação.

Fundição

Como o modelo não distingue entre algo que se sabe ser verdade e algo que provavelmente se seguirá ao texto de entrada que foi fornecido, as alucinações são um efeito colateral direto do processo estatístico que alimenta a IA generativa. E não se esqueça de que frequentemente pressionamos os modelos de IA para encontrar respostas a perguntas que nós, que também temos acesso a esses dados, não conseguimos responder sozinhos.

Nos modelos de texto, as alucinações podem significar inventar citações, fabricar referências ou deturpar um processo técnico. Na análise de código ou de dados, pode produzir resultados sintaticamente corretos, mas logicamente errados. Mesmo os pipelines RAG, que fornecem contexto de dados actual aos modelos, apenas reduzir alucinação – eles não a eliminam. As empresas que usam IA generativa precisam revisar camadas, pipelines de validação e supervisão humana para evitar que essas falhas se espalhem nos sistemas de produção.