Em 2014, o filósofo britânico Nick Bostrom publicou um livro sobre o futuro da inteligência synthetic com o título sinistro Superinteligência: Caminhos, Perigos, Estratégias. Provou ser altamente influente na promoção da ideia de que sistemas avançados de IA – “superinteligências” mais capazes do que os humanos – poderão um dia dominar o mundo e destruir a humanidade.

Uma década depois, o chefe da OpenAI, Sam Altman, diz que a superinteligência pode ser apenas “alguns milhares de dias” ausente. Há um ano, o cofundador da OpenAI da Altman, Ilya Sutskever, montou uma equipe dentro da empresa para se concentrar em “superinteligência segura”, mas ele e sua equipe já arrecadaram um bilhão de dólares para criar uma startup própria para perseguir esse objetivo.

Do que exatamente eles estão falando? Em termos gerais, a superinteligência é qualquer coisa mais inteligente que os humanos. Mas desvendar o que isso pode significar na prática pode ser um pouco complicado.

Diferentes tipos de IA

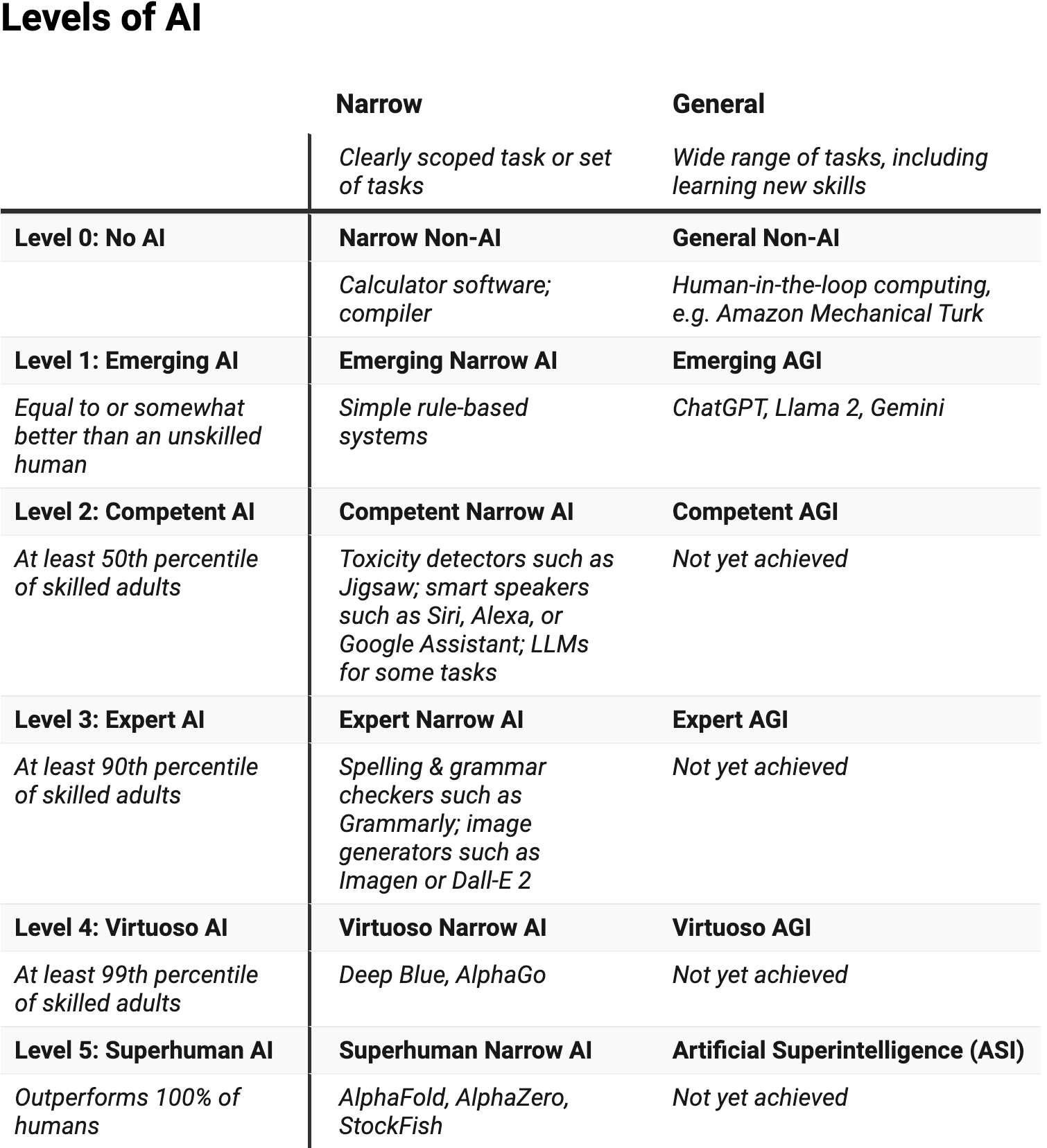

Na minha opinião, a maneira mais útil de pensar sobre diferentes níveis e tipos de inteligência em IA foi desenvolvido pela cientista da computação norte-americana Meredith Ringel Morris e seus colegas do Google.

Sua estrutura lista seis níveis de desempenho de IA: sem IA, emergente, competente, especialista, virtuoso e sobre-humano. Também faz uma distinção importante entre sistemas restritos, que podem realizar uma pequena gama de tarefas, e sistemas mais gerais.

Um sistema estreito e sem IA é algo como uma calculadora. Realiza diversas tarefas matemáticas de acordo com um conjunto de regras explicitamente programadas.

Já existem muitos sistemas estreitos de IA muito bem-sucedidos. Morris dá o Programa de xadrez Deep Blue que derrotou o famoso campeão mundial Garry Kasparov em 1997 como um exemplo de sistema de IA estreito de nível virtuoso.

Alguns sistemas estreitos têm até capacidades sobre-humanas. Um exemplo é AlfaFoldque usa aprendizado de máquina para prever a estrutura das moléculas de proteínas, e cujos criadores ganhou o Prêmio Nobel de Química este ano. E quanto aos sistemas gerais? Este é um software program que pode realizar uma gama muito mais ampla de tarefas, incluindo coisas como aprender novas habilidades.

Um sistema geral sem IA pode ser algo como Turco Mecânico da Amazon: Ele pode fazer uma ampla variedade de coisas, mas as faz perguntando a pessoas reais.

No geral, os sistemas gerais de IA são muito menos avançados do que os seus primos estreitos. De acordo com Morris, os modelos de linguagem de última geração por trás de chatbots como o ChatGPT são IA gerais – mas até agora estão no nível “emergente” (o que significa que são “iguais ou um pouco melhores que um ser humano não qualificado”). , e ainda assim alcançar “competentes” (até 50 por cento dos adultos qualificados).

Portanto, segundo esse cálculo, ainda estamos a alguma distância da superinteligência geral.

Quão inteligente é a IA agora?

Como aponta Morris, determinar com precisão onde qualquer sistema se situa dependeria de testes ou benchmarks confiáveis.

Dependendo de nossos benchmarks, um sistema de geração de imagens como DALL-E pode estar em um nível virtuoso (porque pode produzir imagens que 99% dos humanos não conseguiriam desenhar ou pintar), ou pode estar emergente (porque produz erros que nenhum ser humano faria, como mãos mutantes e objetos impossíveis).

Há um debate significativo até mesmo sobre as capacidades dos sistemas atuais. Um artigo notável de 2023 argumentou O GPT-4 mostrou “faíscas de inteligência synthetic geral”.

OpenAI diz que seu modelo de linguagem mais recente, o1pode “realizar raciocínios complexos” e “rivalizar com o desempenho de especialistas humanos” em muitos benchmarks.

No entanto, um artigo recente de pesquisadores da Apple encontrado o1 e muitos outros modelos de linguagem têm problemas significativos para resolver problemas genuínos de raciocínio matemático. Seus experimentos mostram que os resultados desses modelos parecem se assemelhar a uma correspondência de padrões sofisticada, em vez de um verdadeiro raciocínio avançado. Isto indica que a superinteligência não é tão iminente como muitos sugeriram.

A IA continuará ficando mais inteligente?

Algumas pessoas pensam que o ritmo rápido do progresso da IA ao longo dos últimos anos irá continuar ou mesmo acelerar. Empresas de tecnologia estão investindo centenas de bilhões de dólares em {hardware} e capacidades de IA, então isso não parece impossível.

Se isso acontecer, poderemos de fato ver uma superinteligência geral dentro dos “alguns milhares de dias” propostos por Sam Altman (isso é uma década ou mais, em termos menos de ficção científica). Sutskever e sua equipe mencionaram um prazo semelhante em seu artigo sobre superalinhamento.

Muitos sucessos recentes na IA resultaram da aplicação de uma técnica chamada “aprendizagem profunda”, que, em termos simplistas, encontra padrões associativos em gigantescas colecções de dados. De fato, o Prêmio Nobel de Física deste ano foi concedido a John Hopfield e também ao “Padrinho da IA” Geoffrey Hinton, pela invenção da rede Hopfield e da máquina Boltzmann, que são a base de muitos modelos poderosos de aprendizagem profunda usados atualmente.

Sistemas gerais como o ChatGPT dependem de dados gerados por humanos, muitos deles na forma de textos de livros e websites. As melhorias nas suas capacidades resultam, em grande parte, do aumento da escala dos sistemas e da quantidade de dados sobre os quais são treinados.

No entanto, há pode não haver dados gerados por humanos suficientes levar este processo muito mais longe (embora os esforços para utilizar os dados de forma mais eficiente, gerar dados sintéticos e melhorar a transferência de competências entre diferentes domínios possam trazer melhorias). Mesmo que houvesse dados suficientes, alguns pesquisadores dizem que modelos de linguagem como o ChatGPT são fundamentalmente incapaz de alcançar o que Morris chamaria de competência geral.

Um artigo recente sugeriu que uma característica essencial da superinteligência seria aberturapelo menos de uma perspectiva humana. Precisaria ser capaz de gerar continuamente resultados que um observador humano consideraria novos e com os quais seria capaz de aprender.

Os modelos de fundação existentes não são treinados de forma aberta e os sistemas abertos existentes são bastante restritos. Este artigo também destaca como a novidade ou a capacidade de aprendizagem por si só não são suficientes. É necessário um novo tipo de modelo de base aberta para alcançar a superinteligência.

Quais são os riscos?

Então, o que tudo isso significa para os riscos da IA? No curto prazo, pelo menos, não precisamos nos preocupar com a possibilidade de a IA superinteligente dominar o mundo.

Mas isso não quer dizer que a IA não apresente riscos. Mais uma vez, Morris e companhia refletiram sobre isso: à medida que os sistemas de IA ganham grande capacidade, eles também podem ganhar maior autonomia. Diferentes níveis de capacidade e autonomia apresentam riscos diferentes.

Por exemplo, quando os sistemas de IA têm pouca autonomia e as pessoas os utilizam como uma espécie de consultor – quando pedimos ao ChatGPT para resumir documentos, por exemplo, ou deixar o algoritmo do YouTube moldar os nossos hábitos de visualização – podemos enfrentar o risco de confiar excessivamente ou confiar demais neles.

Entretanto, Morris aponta outros riscos a ter em conta à medida que os sistemas de IA se tornam mais capazes, desde pessoas que formam relações parassociais com sistemas de IA até à deslocação em massa de empregos e ao tédio em toda a sociedade.

O que vem a seguir?

Suponhamos que um dia teremos agentes de IA superinteligentes e totalmente autônomos. Enfrentaremos então o risco de eles concentrarem o poder ou agirem contra os interesses humanos?

Não necessariamente. Autonomia e controle pode andar de mãos dadas. Um sistema pode ser altamente automatizado e ainda fornecer um alto nível de controle humano.

Como muitos na comunidade de pesquisa em IA, acredito superinteligência segura é viável. Contudo, construí-lo será uma tarefa complexa e multidisciplinar, e os investigadores terão de trilhar caminhos inexplorados para lá chegar.

Este artigo foi republicado de A conversa sob uma licença Inventive Commons. Leia o artigo unique.