No evento CES 2025, a Nvidia anunciou um novo computador desktop de US$ 3.000 desenvolvido em colaboração com a MediaTek, que é equipado com uma nova CPU Grace baseada em Arm e um Superchip de GPU Blackwell. O novo sistema é chamado de “projeto DIGITS” (não deve ser confundido com o Nvidia The Deep Studying GPU Coaching System: DÍGITOS). A plataforma oferece uma série de novos recursos para os mercados de IA e HPC.

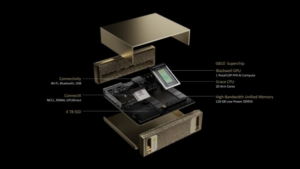

O Projeto DIGITS apresenta o novo superchip Nvidia GB10 Grace Blackwell com 20 núcleos Arm e foi projetado para oferecer um “petaflop” (com precisão FP4) de desempenho de computação GPU-AI para prototipagem, ajuste fino e execução de grandes modelos de IA. (Obrigatório explicador de ponto flutuante pode ser útil aqui.)

Desde o lançamento da linha de placas de vídeo G8x (2006), a Nvidia tem feito um bom trabalho ao fornecer ferramentas e bibliotecas CUDA disponíveis em toda a linha de GPUs. A capacidade de usar uma placa de vídeo de baixo custo para o desenvolvimento CUDA ajudou a criar um ecossistema vibrante de aplicativos. Devido ao custo e à escassez de GPUs de alto desempenho, o projeto DIGITS deve permitir mais desenvolvimento de software program baseado em LLM. Assim como uma GPU de baixo custo, a capacidade de executar, configurar e ajustar modelos de transformadores abertos (por exemplo, lhama) em um desktop deve ser atraente para os desenvolvedores. Por exemplo, ao oferecer 128 GB de memória, o sistema DIGITS ajudará a superar a limitação de 24 GB em muitas placas de vídeo de consumo de baixo custo.

Especificações escassas

O novo Superchip GB10 apresenta uma GPU Nvidia Blackwell com núcleos CUDA de última geração e Tensor Cores de quinta geração, conectados by way of interconexão chip a chip NVLink-C2C a uma CPU semelhante a Nvidia Grace de alto desempenho, que inclui 20 núcleos Arm com eficiência energética (dez núcleos de CPU Arm Cortex-X925 e dez Cortex-A725. Embora nenhuma especificação estivesse disponível, presume-se que o lado da GPU do GB10 ofereça menos desempenho do que o Grace-Blackwell GB200. Para ser claro; o GB10 não é um lixo ou cortado a laser GB200. O Superchip GB200 possui 72 núcleos Arm Neoverse V2 combinados com duas GPUs B200 Tensor Core.

A característica definidora do sistema DIGITS são 128 GB (LPDDR5x) de memória unificada e coerente entre CPU e GPU. Esse tamanho de memória quebra a “barreira de memória da GPU” ao executar modelos de IA ou HPC em GPUs; por exemplo, os preços atuais de mercado para a Nvidia A100 de 80 GB variam de US$ 18.000 a US$ 20.000. Com memória unificada e coerente, as transferências PCIe entre CPU e GPU também são eliminadas. A renderização na imagem abaixo indica que a quantidade de memória é fixa e não pode ser expandida pelo usuário. O diagrama também indica que conexões de rede ConnectX (Ethernet?), Wifi, Bluetooth e USB estão disponíveis.

O sistema também oferece até 4 TB de armazenamento NVMe. Em termos de potência, a Nvidia menciona uma tomada elétrica padrão. Não há requisitos específicos de energia, mas o tamanho e o design podem fornecer algumas pistas. Primeiro, como nos sistemas Mac mini, o tamanho pequeno (veja a Figura 2) indica que a quantidade de calor gerada não deve ser tão alta. Em segundo lugar, com base nas imagens do salão da CES, não existem aberturas de ventilação ou recortes. A parte frontal e traseira do case parece ter um materials semelhante a uma esponja que pode fornecer fluxo de ar e servir como filtros de todo o sistema. Como o design térmico indica potência e a potência indica desempenho, o sistema DIGITS provavelmente não é um gritador ajustado para desempenho máximo (e uso de energia), mas sim um sistema de desktop de IA bacana, silencioso e proficiente com uma arquitetura de memória otimizada.

Como mencionado, o sistema é incrivelmente pequeno. A imagem abaixo oferece alguma perspectiva em relação a um teclado e monitor (não há cabos mostrados. Em nossa experiência, alguns deles pequeno sistemas podem ser arrancados da mesa pelo peso do cabo.)

IA na área de trabalho

A Nvidia relata que os desenvolvedores podem executar modelos de linguagem grandes de até 200 bilhões de parâmetros para turbinar a inovação em IA. Além disso, usando a rede Nvidia ConnectX, dois supercomputadores do Undertaking DIGITS AI podem ser conectados para executar modelos de até 405 bilhões de parâmetros. Com o Projeto DIGITS, os usuários podem desenvolver e executar inferências em modelos usando seus ter sistema de desktop e, em seguida, implante perfeitamente os modelos em nuvem acelerada ou infraestrutura de information middle.

CEO da Nvidia, Jensen Huang, durante uma palestra em Taipei em 5 de junho de 2024 (jamesonwu1972/Shutterstock)

“A IA será dominante em todas as aplicações de todos os setores. Com o Undertaking DIGITS, o Grace Blackwell Superchip chega a milhões de desenvolvedores”, disse Jensen Huang, fundador e CEO da Nvidia. “Colocar um supercomputador de IA nas mesas de cada cientista de dados, pesquisador de IA e estudante capacita-os a se envolver e moldar a period da IA.”

Esses sistemas não se destinam ao treinamento, mas são projetados para funcionar quantizado LLMs localmente (reduz o tamanho de precisão dos pesos do modelo). O número de desempenho petaFLOP citado da Nvidia é para pesos de precisão FP4 (quatro bits ou 16 números possíveis)

Muitos modelos podem funcionar adequadamente neste nívelmas quantização pode ser aumentado para FP8, FP16 ou superior para possivelmente melhores resultados dependendo do tamanho do modelo e da memória disponível. Por exemplo, usar pesos de precisão FP8 para um modelo Llama-3-70B requer um byte por parâmetro ou aproximadamente 70 GB de memória. Reduzir pela metade a precisão para FP4 reduzirá para 35 GB de memória, mas aumentar para FP32 exigirá 140 GB, que é maior do que o sistema DIGITS oferece.

Cluster HPC alguém?

O que talvez não seja amplamente conhecido é que o DIGITS não é o primeiro sistema Nvidia de mesa. Em 2024, GPTshop.ai introduziu um sistema de mesa baseado no GH200. HPCwire forneceu cobertura que incluía benchmarks de HPC. Ao contrário do projeto DIGITS, os sistemas GPTshop fornecem todo o peso do Superchip GH200 Grace-Hopper e do Superchip GB200 Grace-Blackwell em um case de mesa. O aumento do desempenho também acarreta um custo mais elevado.

Usar os sistemas do Projeto DIGITS para HPC de desktop pode ser uma abordagem interessante. Além de executar modelos de IA maiores, a memória world CPU-GPU integrada pode ser muito benéfica para aplicações HPC. Considere um recente História da HPCwire sobre o aplicativo CFD executado exclusivamente em dois processadores Intel Xeon 6 Granite Rapids (sem GPU). Segundo o autor Dr. Moritz Lehmann, o fator que permitiu a simulação foi a quantidade de memória que ele foi capaz de usar para sua simulação.

De maneira semelhantemuitos aplicativos HPC tiveram que encontrar maneiras de contornar os pequenos domínios de memória das placas de vídeo comuns conectadas ao PCIe. O uso de vários cartões ou MPI ajuda a espalhar o aplicativo, mas o fator mais capacitador no HPC é sempre mais memória.

É claro que são necessários benchmarks para determinar a adequação do Projeto DIGITS totalmente para HPC de desktop, mas há outra possibilidade: “construir um cluster Beowulf destes”. Muitas vezes considerada uma piada, esta frase pode ser um pouco mais séria em relação ao projeto DIGITS. Obviamente, os clusters são construídos com servidores e (múltiplas) placas GPU conectadas ao PCEe. No entanto, uma CPU-GPU de memória world pequena, com potência moderada e totalmente integrada pode constituir um bloco de construção de cluster mais equilibrado e atraente. E aqui está o bônus: eles já rodam Linux e possuem rede ConnectX integrada.

Itens relacionados:

Nvidia apregoa menor tempo de primeiro treinamento com nuvem DGX na AWS

Nvidia apresenta nova GPU Blackwell para modelos de IA com trilhões de parâmetros

NVIDIA é cada vez mais o molho secreto em implantações de IA, mas você ainda precisa de experiência

Nota do editor: Esta história apareceu pela primeira vez em HPCwire.