Uma transformação de IA bem -sucedida começa com uma forte base de segurança. Com um rápido aumento no desenvolvimento e adoção da IA, as organizações precisam de visibilidade em seus aplicativos e ferramentas emergentes de IA. A Microsoft Safety fornece proteção contra ameaças, gerenciamento de postura, segurança de dados, conformidade e governança para garantir aplicativos de IA que você construa e usa. Esses recursos também podem ser usados para ajudar as empresas a proteger e governar aplicativos de IA construídos com o modelo Deepseek R1 e a obter visibilidade e controle sobre o uso do aplicativo de consumidor Deepseek Seapery Deepseek.

Segura e governar aplicativos de IA construídos com o modelo Deepseek R1 na Azure AI Foundry e Github

Desenvolver com IA confiável

Na semana passada, anunciamos A disponibilidade do Deepseek R1 na Azure AI Foundry and Githubjuntando -se a um portfólio diversificado de mais de 1.800 modelos.

Hoje, os clientes estão construindo aplicativos de IA prontos para produção com a Azure AI Foundry, considerando seus requisitos variados de segurança, segurança e privacidade. Semelhante a outros modelos fornecidos na Azure IA Foundry, o Deepseek R1 passou por avaliações rigorosas de equipe e segurança vermelhas, incluindo avaliações automatizadas do comportamento do modelo e extensas revisões de segurança para mitigar riscos potenciais. As salvaguardas de hospedagem da Microsoft para modelos de IA são projetadas para manter os dados do cliente dentro dos limites seguros do Azure.

Com a segurança do conteúdo do Azure AI, a filtragem de conteúdo integrada está disponível por padrão para ajudar a detectar e bloquear conteúdo malicioso, prejudicial ou não fundamentado, com opções de opção para flexibilidade. Além disso, o sistema de avaliação de segurança permite que os clientes testem com eficiência seus aplicativos antes da implantação. Essas salvaguardas ajudam a Azure AI Foundry a fornecer um ambiente seguro, compatível e responsável para as empresas construirem e implantarem com confiança soluções de IA. Ver Azure AI Foundry e Github Para mais detalhes.

Comece com gerenciamento de postura de segurança

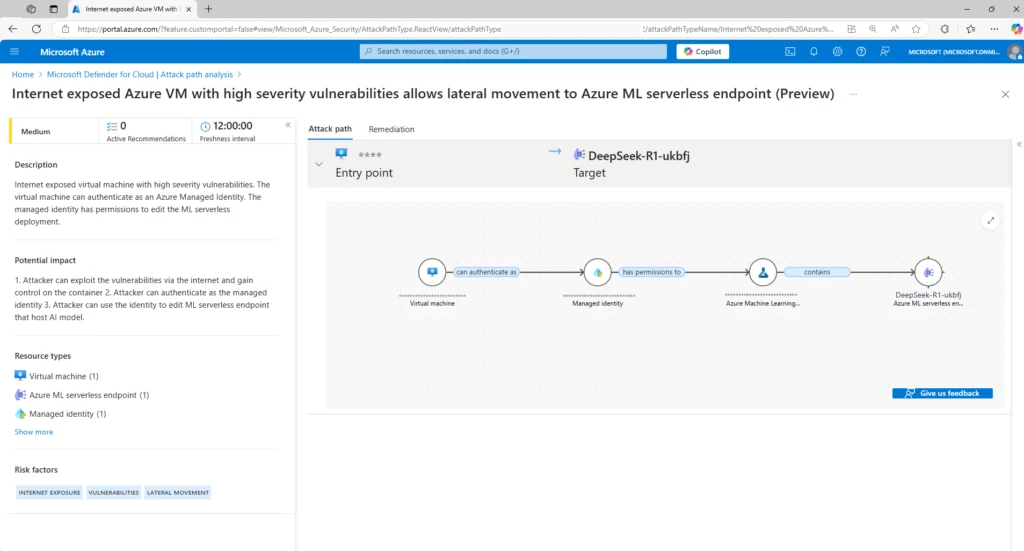

As cargas de trabalho da IA introduzem novas superfícies e vulnerabilidades de ataque cibernético, especialmente quando os desenvolvedores aproveitam os recursos de código aberto. Portanto, é elementary começar com o gerenciamento da postura de segurança, para descobrir todos os inventários de IA, como modelos, orquestradores, fontes de dados de aterramento e riscos diretos e indiretos em torno desses componentes. Quando os desenvolvedores criam cargas de trabalho de IA com Deepseek R1 ou outros modelos de IA, Microsoft Defender for CloudOs recursos de gerenciamento de postura de segurança da AI Pode ajudar as equipes de segurança a obter visibilidade das cargas de trabalho da IA, a descobrir superfícies e vulnerabilidades de ataques cibernéticos de IA, detectar caminhos de ataque cibernético que podem ser explorados por maus atores e obter recomendações para fortalecer proativamente sua postura de segurança contra ameaças cibernéticas.

Ao mapear as cargas de trabalho de IA e sintetizando insights de segurança, como riscos de identidade, dados confidenciais e exposição à Web, o defensor da nuvem superfície continuamente problemas de segurança contextualizados e sugere recomendações de segurança baseadas em risco adaptadas para priorizar lacunas críticas em suas cargas de trabalho de IA. As recomendações de segurança relevantes também aparecem no próprio recurso do Azure AI no portal do Azure. Isso fornece aos desenvolvedores ou proprietários de cargas de trabalho acesso direto a recomendações e os ajuda a correr as ameaças cibernéticas mais rapidamente.

Safeguard Deepseek R1 AI Cargas de trabalho com proteção cibernética

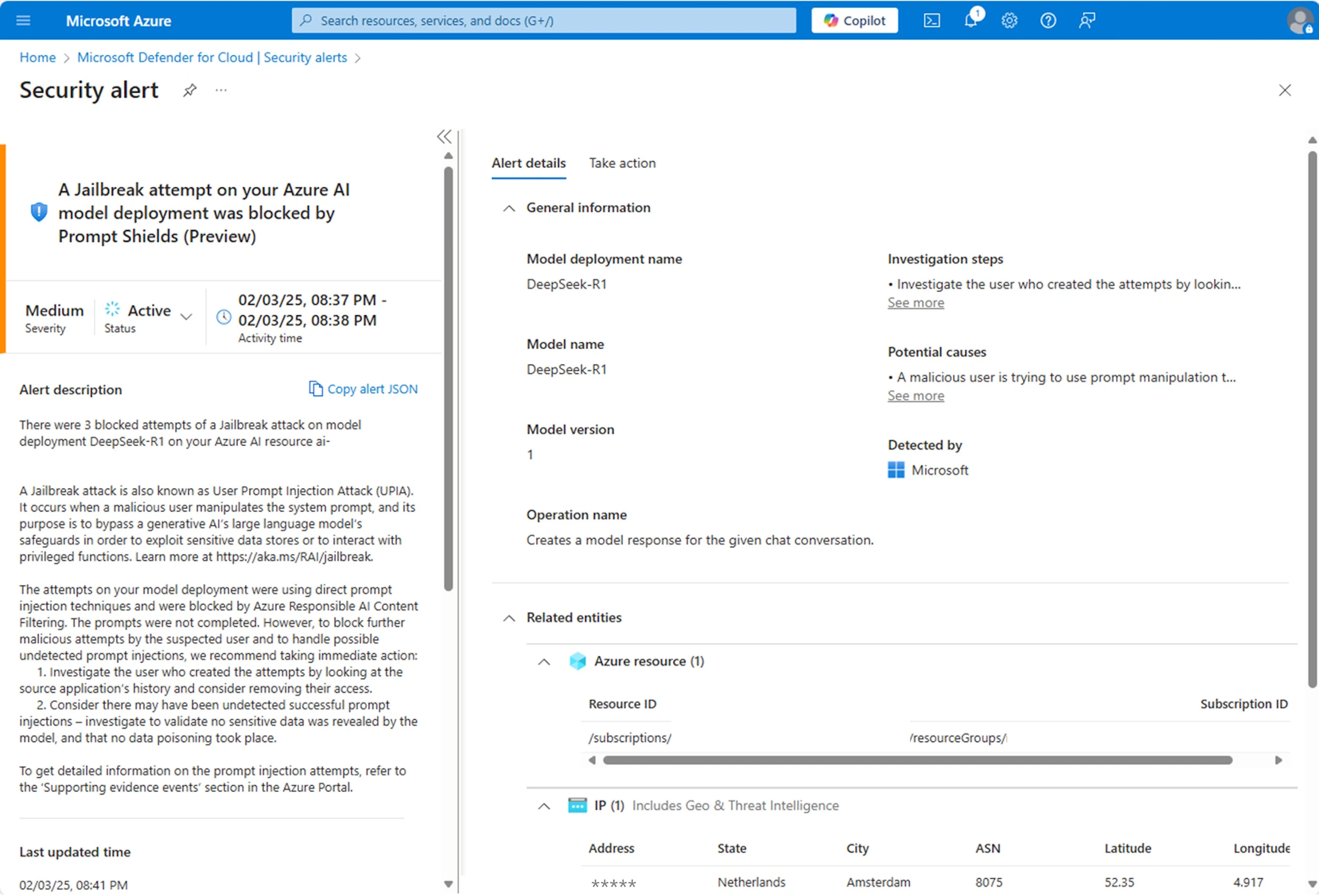

Embora ter uma forte postura de segurança reduz o risco de ataques cibernéticos, a natureza complexa e dinâmica da IA exige monitoramento ativo no tempo de execução também. Nenhum modelo de IA está isento de atividades maliciosas e pode ser vulnerável para provar ataques cibernéticos de injeção e outras ameaturas cibernéticas. O monitoramento dos modelos mais recentes é elementary para garantir que seus aplicativos de IA sejam protegidos.

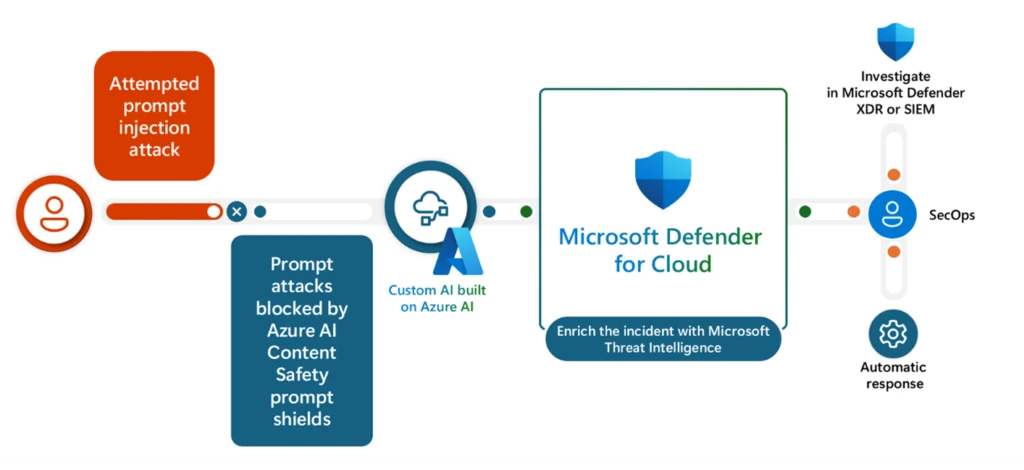

Integrado à Azure AI Foundry, o Defender for Cloud monitora continuamente seus aplicativos de AI profundo para atividades incomuns e prejudiciais, correlaciona os achados e enriquece alertas de segurança com evidências de apoio. Isso fornece aos seus analistas do Centro de Operações de Segurança (SOC) com alertas sobre ameaças cibernéticas ativas, como ataques cibernéticos de jailbreak, roubo de credenciais e vazamentos de dados sensíveis. Por exemplo, quando ocorre um pico de ataque cibernético de injeção, os escudos do immediate de segurança de conteúdo do Azure AI podem bloqueá-lo em tempo actual. O alerta é então enviado ao Microsoft Defender for Cloud, onde o incidente é enriquecido com a inteligência de ameaças do Microsoft, ajudando os analistas do SOC a entender os comportamentos do usuário com visibilidade em evidências de suporte, como endereço IP, detalhes de implantação do modelo e solicitações suspeitas de usuário que desencadearam o alerta .

Além disso, esses alertas se integram com Microsoft Defender XDRpermitindo que as equipes de segurança centralizem alertas de carga de trabalho de IA em incidentes correlacionados para entender o escopo completo de um ataque cibernético, incluindo atividades maliciosas relacionadas às suas aplicações generativas de IA.

Proteger e governar o uso do aplicativo Deepseek

Além do modelo Deepseek R1, a DeepSeek também fornece um aplicativo de consumidor hospedado em seus servidores locais, onde as práticas de coleta de dados e segurança cibernética podem não se alinhar aos seus requisitos organizacionais, como costuma ser o caso dos aplicativos focados no consumidor. Isso ressalta os riscos que as organizações enfrentam se os funcionários e parceiros introduzirem aplicativos de IA não autorizados, levando a possíveis vazamentos de dados e violações de políticas. A Microsoft Safety fornece recursos para descobrir o uso de aplicativos de IA de terceiros em sua organização e fornece controles para proteger e governar seu uso.

Seguro e ganha visibilidade no uso do aplicativo Deepseek

O Microsoft Defender for Cloud Apps fornece avaliações de risco prontas para uso para mais de 850 aplicativos generativos de IA, e a lista de aplicativos é atualizada continuamente à medida que os novos se tornam populares. Isso significa que você pode descobrir o uso desses aplicativos generativos de IA em sua organização, incluindo o aplicativo Deepseek, avaliar sua segurança, conformidade e riscos legais e configurar os controles de acordo. Por exemplo, para aplicativos de IA de alto risco, as equipes de segurança podem identificá-los como aplicativos não autorizados e bloquear o acesso do usuário aos aplicativos.

Segurança abrangente de dados

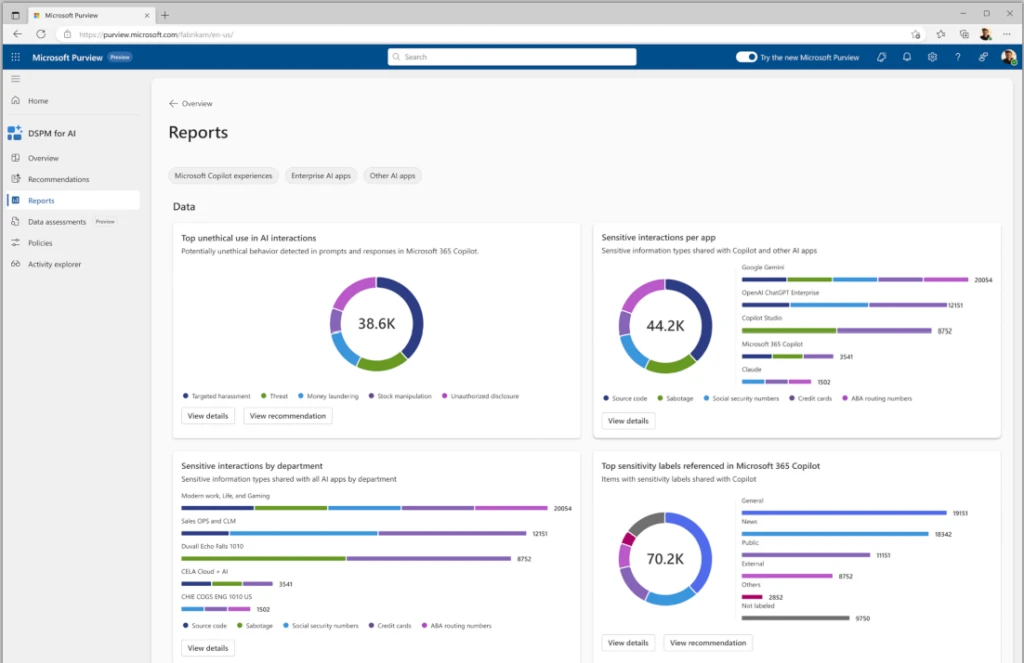

Além disso, Microsoft Purview Knowledge Safety Posture Administration (DSPM) Para a IA, fornece visibilidade dos riscos de segurança de dados e conformidade, como dados confidenciais nos avisos do usuário e uso não compatível, e recomenda controles para mitigar os riscos. Por exemplo, os relatórios no DSPM para IA podem oferecer informações sobre o tipo de dados confidenciais colados para aplicativos generativos de consumidores de IA, incluindo o aplicativo Deepseek Shopper, para que as equipes de segurança de dados possam criar e ajustar suas políticas de segurança de dados para proteger esses dados e impedir vazamentos de dados.

Impedir vazamentos de dados sensíveis e exfiltração

O vazamento de dados organizacionais está entre as principais preocupações dos líderes de segurança em relação ao uso da IA, destacando a importância das organizações para implementar controles que impedem os usuários de compartilhar informações confidenciais com aplicativos de IA de terceiros externos.

Prevenção de perda de dados da Microsoft Purview (DLP) Permite impedir que os usuários colam dados confidenciais ou enviem arquivos contendo conteúdo sensível em aplicativos de IA generativos de navegadores suportados. Sua política de DLP também pode se adaptar aos níveis de risco internos, aplicando restrições mais fortes aos usuários que são categorizados como ‘risco elevado’ e restrições menos rigorosas para aqueles categorizados como ‘baixo risco’. Por exemplo, usuários de risco elevado são restritos de colar dados confidenciais em aplicativos de IA, enquanto os usuários de baixo risco podem continuar sua produtividade ininterrupta. Ao alavancar esses recursos, você pode proteger seus dados confidenciais de riscos potenciais do uso de aplicativos de IA de terceiros externos. Os administradores de segurança podem investigar esses riscos de segurança de dados e executar investigações de risco privilegiado dentro da prisão. Esses mesmos riscos de segurança de dados estão surgidos no defensor XDR para investigações holísticas.

Esta é uma visão geral rápida de alguns dos recursos para ajudá -lo a proteger e governar os aplicativos de IA que você desenvolve no Azure AI Foundry e no Github, bem como aplicativos de IA que os usuários da sua organização usam. Esperamos que você ache isso útil!

Para saber mais e começar a proteger seus aplicativos de IA, dê uma olhada nos recursos adicionais abaixo:

Saiba mais com a Microsoft Safety

Para saber mais sobre as soluções de segurança do Microsoft, visite nossowebsite.Marque oWeblog de segurançaPara acompanhar nossa cobertura especializada em questões de segurança. Além disso, siga -nos no LinkedIn (Segurança da Microsoft) e x (@MsftSecurity) para as últimas notícias e atualizações sobre segurança cibernética.