Os sistemas de design auxiliado por computador (CAD) são ferramentas testadas e comprovadas usadas para projetar muitos dos objetos físicos que usamos todos os dias. Mas o software program CAD requer amplo conhecimento para ser dominado, e muitas ferramentas incorporam um nível de detalhe tão alto que não se prestam a brainstorming ou prototipagem rápida.

Num esforço para tornar o design mais rápido e acessível para não especialistas, investigadores do MIT e de outros lugares desenvolveram um sistema de montagem robótica orientado por IA que permite às pessoas construir objetos físicos simplesmente descrevendo-os em palavras.

Seu sistema usa um modelo generativo de IA para construir uma representação 3D da geometria de um objeto com base na solicitação do usuário. Em seguida, um segundo modelo generativo de IA raciocina sobre o objeto desejado e descobre onde os diferentes componentes devem ir, de acordo com a função e a geometria do objeto.

O sistema pode construir automaticamente o objeto a partir de um conjunto de peças pré-fabricadas usando montagem robótica. Ele também pode iterar no design com base no suggestions do usuário.

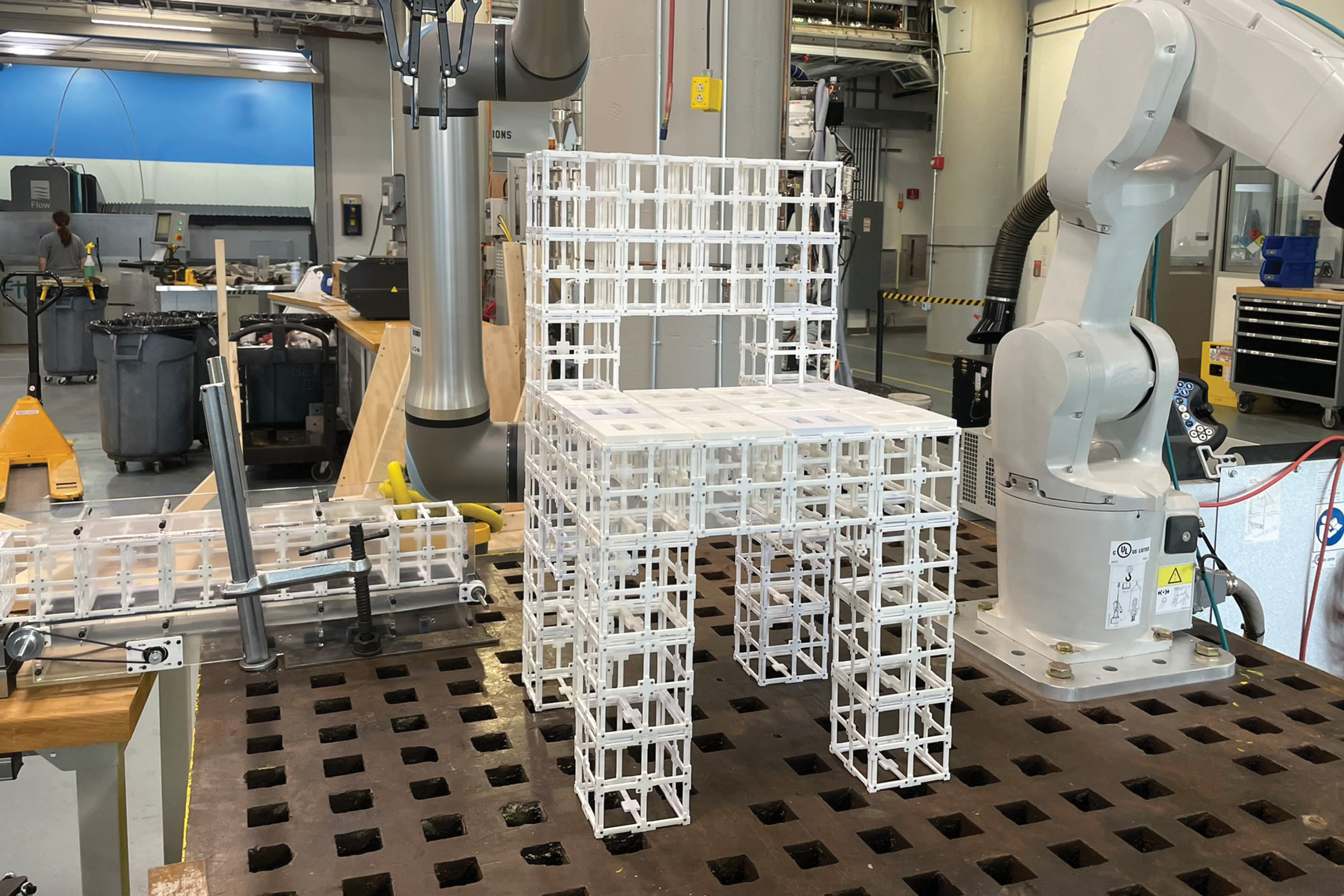

Os pesquisadores usaram esse sistema ponta a ponta para fabricar móveis, incluindo cadeiras e estantes, a partir de dois tipos de componentes pré-fabricados. Os componentes podem ser desmontados e remontados à vontade, reduzindo a quantidade de resíduos gerados no processo de fabricação.

Eles avaliaram esses designs por meio de um estudo de usuários e descobriram que mais de 90% dos participantes preferiram os objetos feitos por seu sistema baseado em IA, em comparação com diferentes abordagens.

Embora este trabalho seja uma demonstração inicial, a estrutura pode ser especialmente útil para a prototipagem rápida de objetos complexos, como componentes aeroespaciais e objetos arquitetônicos. No longo prazo, poderia ser usado em residências para fabricar móveis ou outros objetos localmente, sem a necessidade de envio de produtos volumosos de uma instalação central.

“Mais cedo ou mais tarde, queremos ser capazes de comunicar e falar com um robô e um sistema de IA da mesma forma que falamos uns com os outros para fazer coisas juntos. Nosso sistema é um primeiro passo para permitir esse futuro”, diz o autor principal Alex Kyaw, um estudante de pós-graduação nos departamentos de Engenharia Elétrica e Ciência da Computação (EECS) e Arquitetura do MIT.

Kyaw é acompanhado por Richa Gupta, estudante de graduação em arquitetura do MIT; Faez Ahmed, professor associado de engenharia mecânica; Lawrence Sass, professor e presidente do Grupo de Computação do Departamento de Arquitetura; autor sênior Randall Davis, professor do EECS e membro do Laboratório de Ciência da Computação e Inteligência Synthetic (CSAIL); bem como outros do Google Deepmind e Autodesk Analysis. O papel foi apresentado recentemente na Conferência sobre Sistemas de Processamento de Informação Neural.

Gerando um design multicomponente

Embora os modelos generativos de IA sejam bons na geração de representações 3D, conhecidas como malhas, a partir de prompts de texto, a maioria não produz representações uniformes da geometria de um objeto que tenham os detalhes em nível de componente necessários para a montagem robótica.

Separar essas malhas em componentes é um desafio para um modelo porque a atribuição de componentes depende da geometria e da funcionalidade do objeto e de suas partes.

Os pesquisadores enfrentaram esses desafios usando um modelo de linguagem de visão (VLM), um poderoso modelo generativo de IA que foi pré-treinado para compreender imagens e texto. Eles incumbem o VLM de descobrir como dois tipos de peças pré-fabricadas, componentes estruturais e componentes de painel, devem se encaixar para formar um objeto.

“Há muitas maneiras de colocar painéis em um objeto físico, mas o robô precisa ver a geometria e raciocinar sobre essa geometria para tomar uma decisão sobre ela. Ao servir como olhos e cérebro do robô, o VLM permite que o robô faça isso”, diz Kyaw.

Um usuário envia um texto ao sistema, talvez digitando “faça uma cadeira para mim”, e fornece uma imagem de uma cadeira gerada por IA para começar.

Em seguida, o VLM raciocina sobre a cadeira e determina onde os componentes do painel vão sobre os componentes estruturais, com base na funcionalidade de muitos exemplos de objetos que já viu antes. Por exemplo, o modelo pode determinar que o assento e o encosto devem ter painéis para ter superfícies para quem está sentado e apoiado na cadeira.

Ele gera essas informações como texto, como “assento” ou “encosto”. Cada superfície da cadeira é então rotulada com números e a informação é enviada de volta ao VLM.

Em seguida o VLM escolhe as etiquetas que correspondem às partes geométricas da cadeira que deverá receber painéis na malha 3D para completar o desenho.

Co-design humano-IA

O usuário permanece informado durante todo esse processo e pode refinar o design dando ao modelo uma nova solicitação, como “use apenas painéis no encosto, não no assento”.

“O espaço de design é muito grande, por isso o restringimos através do suggestions dos usuários. Acreditamos que esta é a melhor maneira de fazer isso porque as pessoas têm preferências diferentes e seria impossível construir um modelo idealizado para todos”, diz Kyaw.

“O processo humano permite que os usuários orientem os projetos gerados por IA e tenham um senso de propriedade no resultado ultimate”, acrescenta Gupta.

Uma vez finalizada a malha 3D, um sistema de montagem robótica constrói o objeto usando peças pré-fabricadas. Estas peças reutilizáveis podem ser desmontadas e remontadas em diferentes configurações.

Os pesquisadores compararam os resultados de seu método com um algoritmo que coloca os painéis em todas as superfícies horizontais voltadas para cima e um algoritmo que coloca os painéis aleatoriamente. Num estudo de utilizadores, mais de 90% dos indivíduos preferiram os designs feitos pelo seu sistema.

Também pediram ao VLM que explicasse por que optou por colocar painéis nessas áreas.

“Aprendemos que o modelo de linguagem de visão é capaz de compreender até certo ponto os aspectos funcionais de uma cadeira, como inclinar-se e sentar-se, para entender por que está colocando painéis no assento e no encosto. Não se trata apenas de cuspir aleatoriamente essas atribuições”, diz Kyaw.

No futuro, os pesquisadores querem aprimorar seu sistema para lidar com solicitações de usuário mais complexas e diferenciadas, como uma mesa feita de vidro e metallic. Além disso, pretendem incorporar componentes pré-fabricados adicionais, como engrenagens, dobradiças ou outras peças móveis, para que os objetos possam ter mais funcionalidade.

“Nossa esperança é reduzir drasticamente a barreira de acesso às ferramentas de design. Mostramos que podemos usar IA generativa e robótica para transformar ideias em objetos físicos de maneira rápida, acessível e sustentável”, diz Davis.