Fluxos de trabalho autônomos, alimentados por suggestions em tempo actual e aprendizado contínuo, estão se tornando essenciais para a produtividade e a tomada de decisões.

Nos primeiros dias da mudança de IA, os aplicativos de IA foram em grande parte construídos como camadas finas sobre modelos básicos prontos para uso. Mas à medida que os desenvolvedores começaram a lidar com casos de uso mais complexos, eles rapidamente encontraram as limitações de simplesmente usar RAG em modelos prontos para uso. Embora essa abordagem oferecesse um caminho rápido para a produção, muitas vezes não conseguia fornecer a precisão, a confiabilidade, a eficiência e o envolvimento necessários para casos de uso mais sofisticados.

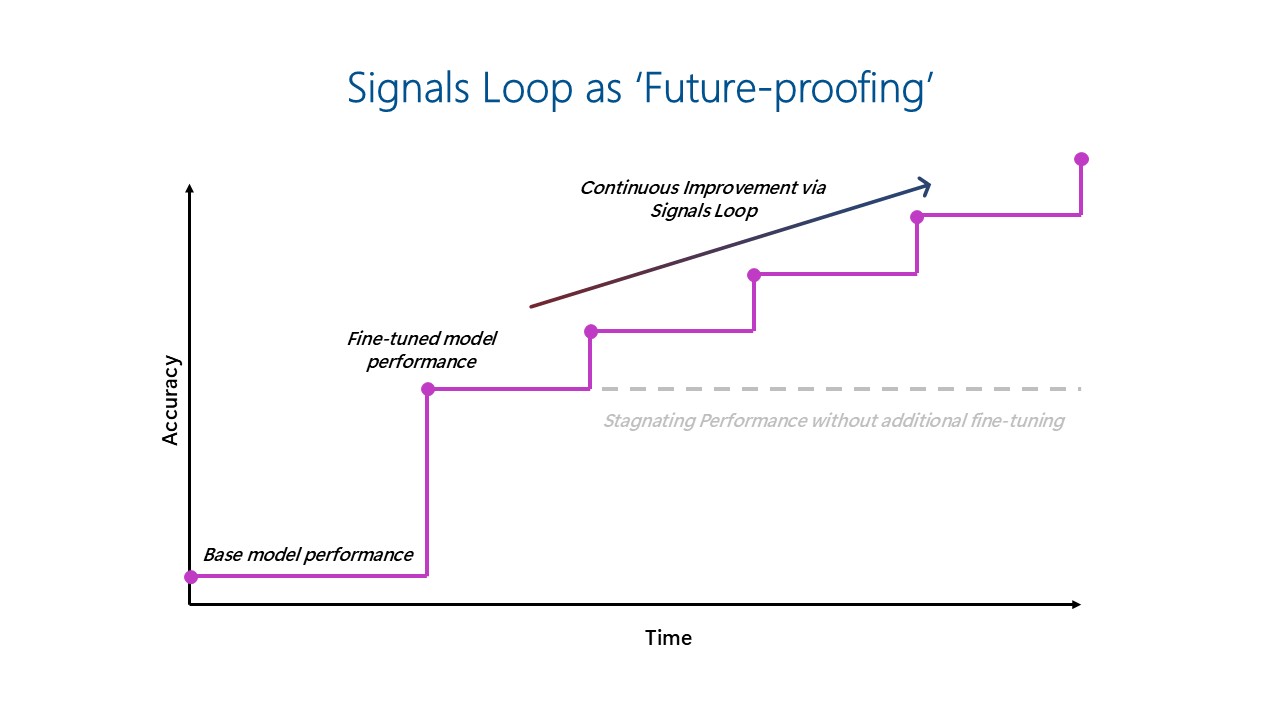

No entanto, esta dinâmica está a mudar. À medida que a IA passa de copilotos auxiliares para colegas de trabalho autônomos, a arquitetura por trás desses sistemas deve evoluir. Fluxos de trabalho autônomos, alimentados por suggestions em tempo actual e aprendizado contínuo, estão se tornando essenciais para a produtividade e a tomada de decisões. As aplicações de IA que incorporam aprendizagem contínua através de ciclos de suggestions em tempo actual – aquilo a que chamamos “loop de sinais” – estão a emergir como a chave para construir uma diferenciação mais adaptável e resiliente ao longo do tempo.

Construir aplicativos e agentes de IA verdadeiramente eficazes requer mais do que apenas acesso a LLMs poderosos. Exige repensar a arquitetura da IA – uma arquitetura que coloque a aprendizagem e a adaptação contínuas no seu núcleo. O ‘loop de sinais’ centra-se na captura das interações do usuário e dos dados de uso do produto em tempo actual e, em seguida, na integração sistemática desse suggestions para refinar o comportamento do modelo e desenvolver os recursos do produto, criando aplicativos que melhoram com o tempo.

À medida que a ascensão dos modelos fronteiriços de código aberto democratiza o acesso aos pesos dos modelos, o ajuste fino (incluindo a aprendizagem por reforço) torna-se mais acessível e a construção destes ciclos torna-se mais viável. Recursos como memória também estão aumentando o valor dos loops de sinais. Essas tecnologias permitem que os sistemas de IA retenham o contexto e aprendam com o suggestions dos usuários, gerando maior personalização e melhorando a retenção de clientes. E à medida que o uso de agentes continua a crescer, garantir a precisão torna-se ainda mais crítico, sublinhando a crescente importância do ajuste fino e da implementação de um circuito de sinais robusto.

Na Microsoft, vimos em primeira mão o poder da abordagem do loop de sinais. Produtos originais como Copiloto Dragão e Copiloto GitHub exemplificam como os loops de sinais podem impulsionar a melhoria rápida do produto, maior relevância e envolvimento do usuário a longo prazo.

Implementando loop de sinais para melhoria contínua de IA: Insights do Dragon Copilot e GitHub Copilot

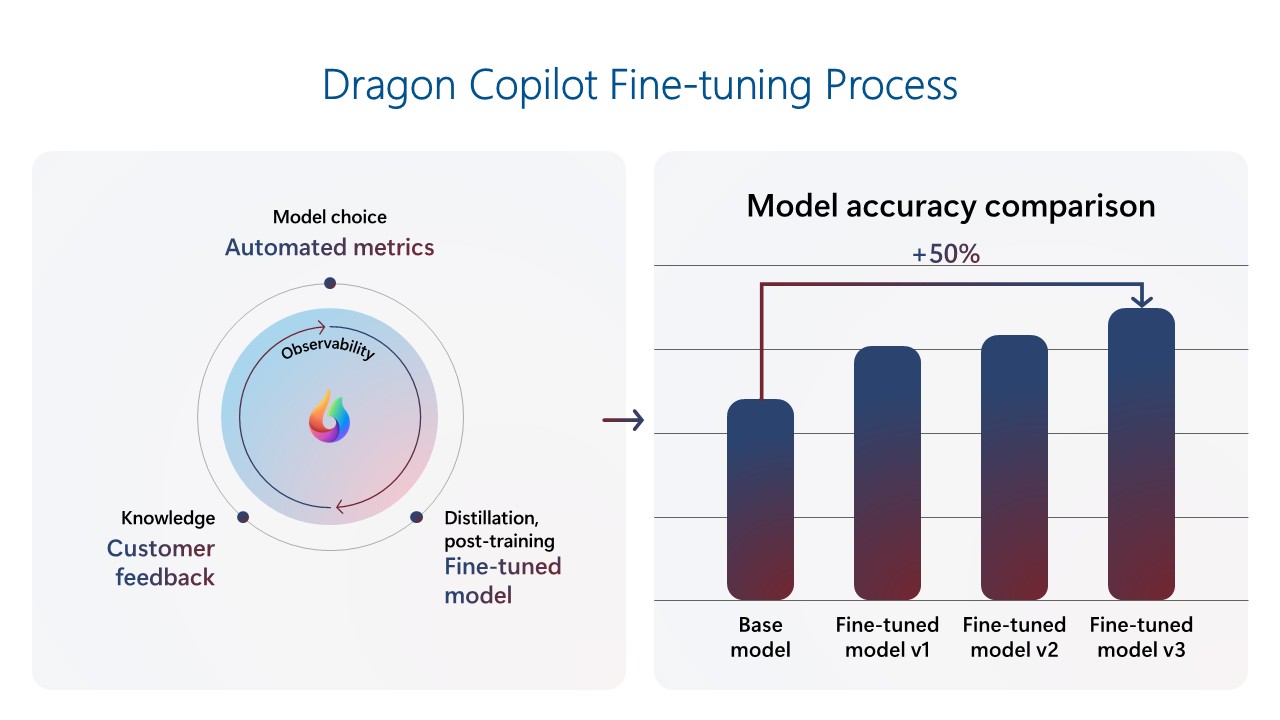

Copiloto Dragão é um copiloto de saúde que ajuda os médicos a se tornarem mais produtivos e a prestarem melhor atendimento aos pacientes. A equipe Dragon Copilot construiu um circuito de sinais para impulsionar a melhoria contínua do produto. A equipe construiu um modelo ajustado usando um repositório de dados clínicos, que resultou em um desempenho muito melhor do que o modelo básico básico apenas com prompts. À medida que o produto ganhou uso, a equipe usou a telemetria de suggestions do cliente para refinar continuamente o modelo. Quando novos modelos fundamentais são lançados, eles são avaliados com métricas automatizadas para avaliar o desempenho e atualizados se houver ganhos significativos. Esse ciclo cria melhorias combinadas a cada geração de modelo, o que é especialmente importante em um campo onde a demanda por precisão é extremamente alta. Os modelos mais recentes agora superam os modelos básicos em aproximadamente 50%. Esse alto desempenho ajuda os médicos a se concentrarem nos pacientes, capturarem a história completa do paciente e melhorarem a qualidade do atendimento, produzindo documentação precisa e abrangente, de maneira eficiente e consistente.

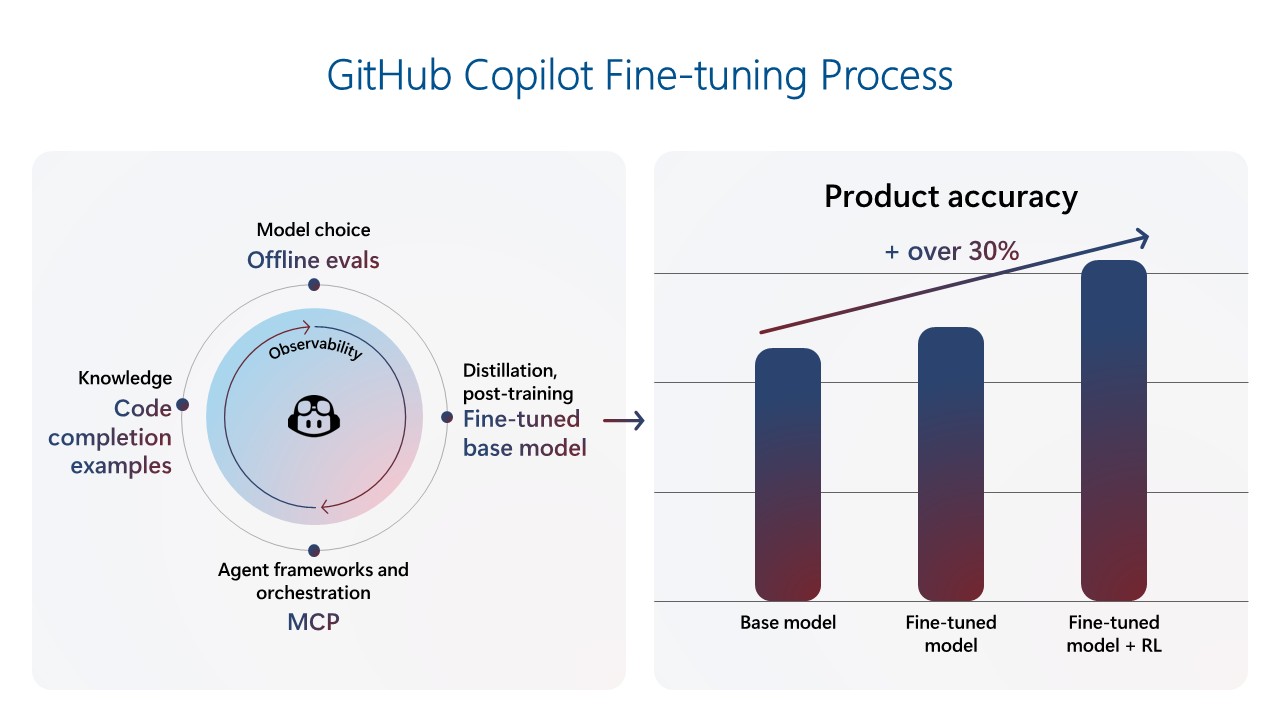

Copiloto GitHub foi o primeiro Microsoft Copilot, atraindo a atenção generalizada e estabelecendo o padrão de como poderia ser a assistência alimentada por IA. No seu primeiro ano, cresceu rapidamente para mais de um milhão de utilizadores e já atingiu mais de 20 milhões de utilizadores. À medida que as expectativas de qualidade e relevância das sugestões de código continuam a aumentar, a equipe do GitHub Copilot mudou seu foco para a construção de um ambiente robusto no meio do treinamento e pós-treinamento, permitindo um ciclo de sinais para fornecer inovações do Copilot por meio de ajuste fino contínuo. O mais recente modelo de conclusão de código foi treinado em mais de 400 mil amostras do mundo actual de repositórios públicos e ajustado por meio de aprendizado de reforço usando dados de treinamento sintéticos feitos à mão. Junto com esse novo modelo, a equipe introduziu diversas mudanças no lado do cliente e na experiência do usuário, alcançando uma melhoria de mais de 30% no código retido para conclusões e uma melhoria de 35% na velocidade. Essas melhorias permitem que o GitHub Copilot antecipe as necessidades dos desenvolvedores e atue como um parceiro de codificação proativo.

Principais implicações para o futuro da IA: ajuste fino, ciclos de suggestions e velocidade são importantes

As experiências do Dragon Copilot e do GitHub Copilot ressaltam uma mudança elementary na forma como produtos diferenciados de IA serão construídos e dimensionados no futuro. Algumas implicações importantes emergem:

- O ajuste fino não é opcional – é estrategicamente importante: O ajuste fino não é mais um nicho, mas um recurso central que permite melhorias significativas de desempenho. Em todos os nossos produtos, o ajuste fino levou a ganhos dramáticos em precisão e qualidade de recursos. À medida que os modelos de código aberto democratizam o acesso aos recursos básicos, a capacidade de ajuste fino para casos de uso específicos definirá cada vez mais a excelência do produto.

- Os ciclos de suggestions podem gerar melhoria contínua: À medida que os modelos fundamentais se tornam cada vez mais comoditizados, a defesa a longo prazo dos produtos de IA não virá apenas do modelo, mas da eficácia com que esses modelos aprendem com a utilização. O loop de sinais – alimentado por interações e ajustes finos do usuário no mundo actual – permite que as equipes forneçam experiências de alto desempenho que melhoram continuamente ao longo do tempo.

- As empresas devem evoluir para suportar a iteração em escala, e a velocidade será elementary: construir um sistema que suporte atualizações frequentes de modelos requer ajuste de pipelines de dados, ajustes finos, ciclos de avaliação e fluxos de trabalho de equipe. As organizações de engenharia e de produtos das empresas devem se alinhar em torno de iteração rápida e ajuste fino, análise de telemetria, geração de dados sintéticos e estruturas de avaliação automatizadas para acompanhar as necessidades dos usuários e os recursos do modelo. As organizações que evoluírem os seus sistemas e ferramentas para incorporarem rapidamente sinais – desde a telemetria ao suggestions humano – estarão mais bem posicionadas para liderar. Fundição de IA do Azure fornece os componentes essenciais necessários para facilitar este modelo contínuo e melhoria do produto.

- Agentes exigem design intencional e adaptação contínua: Os agentes de construção vão além da seleção de modelos. Exige uma orquestração cuidadosa de memória, raciocínio e mecanismos de suggestions. Os loops de sinais permitem que os agentes evoluam de assistentes reativos para colegas de trabalho proativos que aprendem com as interações e melhoram com o tempo. O Azure AI Foundry fornece a infraestrutura para dar suporte a essa evolução, ajudando as equipes a projetar agentes que atuem, se adaptem dinamicamente e forneçam valor sustentado.

Embora nos primeiros dias do ajuste fino da IA não fosse econômico e exigisse muito tempo e esforço, o surgimento de modelos e métodos de fronteira de código aberto, como LoRA e destilação, tornou o ajuste mais econômico e as ferramentas tornaram-se mais fáceis de usar. Como resultado, o ajuste fino está mais acessível a mais organizações do que nunca. Embora os modelos prontos para uso tenham um papel a desempenhar para cargas de trabalho horizontais, como pesquisa de conhecimento ou atendimento ao cliente, as organizações estão cada vez mais experimentando o ajuste fino para cenários específicos do setor e do domínio, adicionando seus dados específicos do domínio aos seus produtos e modelos.

O loop de sinais “prova o futuro” dos investimentos em IA, permitindo que os modelos melhorem continuamente ao longo do tempo, à medida que os dados de uso são realimentados no modelo ajustado, evitando a estagnação do desempenho.

Crie experiências de IA adaptáveis com o Azure AI Foundry

Para simplificar a implementação de ciclos de suggestions de ajuste fino, o Azure AI Foundry oferece soluções líderes do setor capacidades de ajuste fino por meio de uma plataforma unificada que agiliza todo o ciclo de vida da IA, desde a seleção do modelo até a implantação, ao mesmo tempo que incorpora conformidade e governança de nível empresarial. Isso permite que as equipes criem, adaptem e dimensionem soluções de IA com confiança e controle.

Aqui estão quatro razões principais pelas quais o ajuste fino Fundição de IA do Azure se destaca:

- Escolha do modelo: acesse um amplo portfólio de modelos abertos e proprietários dos principais fornecedores, com a flexibilidade de escolher entre opções de computação gerenciada ou sem servidor.

- Confiabilidade: conte com uma disponibilidade de 99,9% para modelos Azure OpenAI e beneficie-se de garantias de latência com PTUs (unidades de produção provisionadas).

- Plataforma unificada: aproveite um ambiente completo que reúne modelos, treinamento, avaliação, implantação e métricas de desempenho, tudo em um só lugar.

- Escalabilidade: comece aos poucos com um nível de desenvolvedor econômico para experimentação e dimensione perfeitamente para cargas de trabalho de produção usando PTUs.

Junte-se a nós na construção do futuro da IA, onde os copilotos se tornam colegas de trabalho e os fluxos de trabalho se tornam motores de produtividade que melhoram a si mesmos.

Saber mais