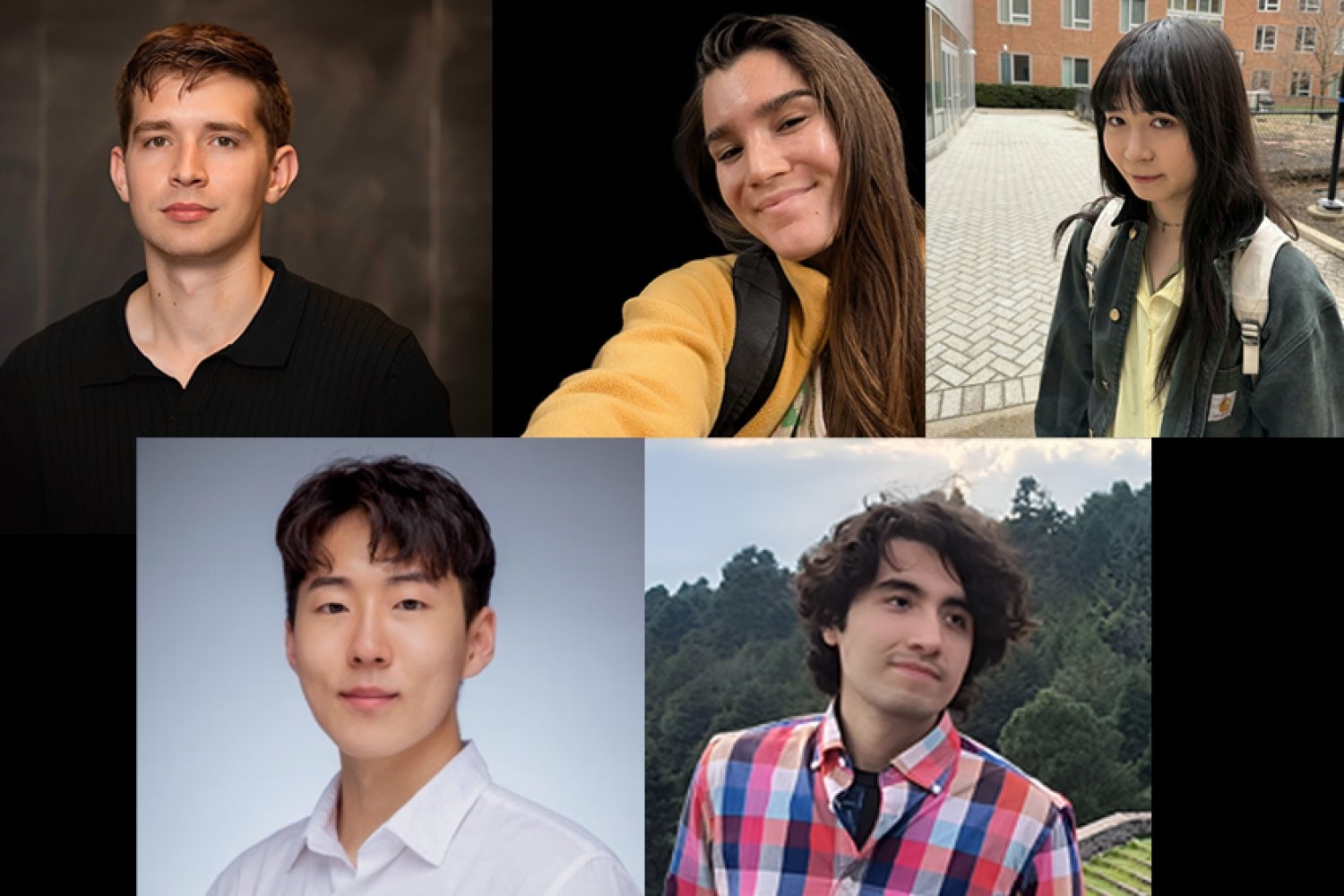

A adoção de novas ferramentas e tecnologias ocorre quando os usuários as percebem em grande parte como confiáveis, acessíveis e uma melhoria em relação aos métodos e fluxos de trabalho disponíveis em relação ao custo. Cinco estudantes de doutorado da turma inaugural do Programa de Verão do MIT-IBM Watson AI Lab Summer season estão utilizando recursos de última geração, aliviando os pontos problemáticos da IA e criando novos recursos e capacidades para promover a utilidade e implantação da IA — desde aprender quando confiar em um modelo que prevê a precisão de outro até raciocinar de forma mais eficaz sobre bases de conhecimento. Juntos, os esforços dos alunos e de seus mentores formam uma linha direta, onde pesquisas práticas e tecnicamente rigorosas levam a modelos mais confiáveis e valiosos em todos os domínios.

Construindo sondas, roteadores, novos mecanismos de atenção, conjuntos de dados sintéticos e pipelines de síntese de programas, o trabalho dos alunos abrange segurança, eficiência de inferência, dados multimodais e raciocínio baseado no conhecimento. Suas técnicas enfatizam o dimensionamento e a integração, com o impacto sempre à vista.

Aprendendo a confiar e quando

A pesquisa do estudante de pós-graduação em matemática do MIT, Andrey Bryutkin, prioriza a confiabilidade dos modelos. Ele procura estruturas internas dentro de problemas, como equações que governam um sistema e leis de conservação, para entender como aproveitá-las para produzir soluções mais confiáveis e robustas. Armado com isso e trabalhando com o laboratório, Bryutkin desenvolveu um método para examinar a natureza dos comportamentos dos grandes modelos de aprendizagem (LLMs). Juntamente com Veronika Thost da IBM Analysis e Marzyeh Ghassemi do laboratório – professora associada e professora de desenvolvimento de carreira de Germeshausen no Departamento de Engenharia Elétrica e Ciência da Computação (EECS) do MIT e membro do Instituto de Ciências da Engenharia Médica e do Laboratório de Informação e Sistemas de Decisão – Bryutkin explorou a “incerteza da incerteza” dos LLMs.

Classicamente, pequenas redes neurais feed-forward com duas a três camadas de profundidade, chamadas sondas, são treinadas junto com LLMs e empregadas para sinalizar respostas não confiáveis do modelo maior para os desenvolvedores; entretanto, esses classificadores também podem produzir falsos negativos e fornecer apenas estimativas pontuais, que não oferecem muitas informações sobre quando o LLM está falhando. Investigando prompts seguros/inseguros e tarefas de resposta a perguntas, a equipe do MIT-IBM usou pares de rótulos de immediate, bem como estados ocultos, como vetores de ativação e últimos tokens de um LLM, para medir pontuações de gradiente, sensibilidade a prompts e dados fora de distribuição para determinar o quão confiável period a sonda e aprender áreas de dados que são difíceis de prever. Seu método também ajuda a identificar possíveis ruídos de rotulagem. Esta é uma função crítica, uma vez que a fiabilidade dos sistemas de IA depende inteiramente da qualidade e precisão dos dados rotulados sobre os quais se baseiam. Sondagens mais precisas e consistentes são especialmente importantes para domínios com dados críticos em aplicações como a família de modelos Granite Guardian da IBM.

Outra forma de garantir respostas confiáveis às perguntas de um LLM é aumentá-las com bases de conhecimento externas e confiáveis para eliminar alucinações. Para dados estruturados, como conexões de mídia social, transações financeiras ou bancos de dados corporativos, os gráficos de conhecimento (KG) são adequados; no entanto, as comunicações entre o LLM e os KGs geralmente usam pipelines fixos e multiagentes que são computacionalmente ineficientes e caros. Abordando isso, o estudante de pós-graduação em física Jinyeop Music, junto com os pesquisadores de laboratório Yada Zhu da IBM Analysis e o professor associado do EECS Julian Shun criaram uma estrutura de aprendizagem por reforço de agente único e multivoltas que agiliza esse processo. Aqui, o grupo projetou um servidor API que hospeda Freebase e Wikidata KGs, que consistem em dados de conhecimento gerais baseados na net, e um agente LLM que emite ações de recuperação direcionadas para buscar informações pertinentes do servidor. Então, por meio de idas e vindas contínuas, o agente anexa os dados coletados dos KGs ao contexto e responde à consulta. Crucialmente, o sistema utiliza a aprendizagem por reforço para se treinar e fornecer respostas que estabeleçam um equilíbrio entre precisão e integridade. A estrutura combina um servidor API com um único agente de aprendizagem por reforço para orquestrar o raciocínio baseado em dados com maior precisão, transparência, eficiência e transferibilidade.

Gastando computação com sabedoria

A oportunidade e a integridade da resposta de um modelo têm peso semelhante à importância da sua precisão. Isto é especialmente verdadeiro para lidar com textos de entrada longos e aqueles em que os elementos, como o assunto de uma história, evoluem ao longo do tempo, por isso o estudante de pós-graduação do EECS, Songlin Yang, está reprojetando quais modelos podem lidar em cada etapa da inferência. Com foco nas limitações dos transformadores, como as dos LLMs, Rameswar Panda do laboratório da IBM Analysis e Yoon Kim, professor NBX e professor associado no EECS, juntaram-se a Yang para desenvolver arquiteturas de modelos de linguagem de próxima geração além dos transformadores.

Os transformadores enfrentam duas limitações principais: alta complexidade computacional na modelagem de sequências longas devido ao mecanismo de atenção softmax e expressividade limitada resultante do fraco viés indutivo do RoPE (codificação posicional rotativa). Isto significa que à medida que o comprimento da entrada duplica, o custo computacional quadruplica. RoPE permite que os transformadores entendam a ordem sequencial dos tokens (ou seja, palavras); no entanto, ele não faz um bom trabalho ao capturar mudanças de estado interno ao longo do tempo, como valores de variáveis, e é limitado aos comprimentos de sequência vistos durante o treinamento.

Para resolver isso, a equipe do MIT-IBM explorou algoritmos teoricamente fundamentados, mas com {hardware} eficiente. Como alternativa à atenção softmax, adotaram a atenção linear, reduzindo a complexidade quadrática que limita o comprimento viável da sequência. Eles também investigaram arquiteturas híbridas que combinam softmax e atenção linear para encontrar um melhor equilíbrio entre eficiência computacional e desempenho.

Aumentando a expressividade, eles substituíram o RoPE por uma codificação posicional reflexiva dinâmica baseada na transformação Householder. Essa abordagem permite interações posicionais mais ricas para uma compreensão mais profunda das informações sequenciais, ao mesmo tempo que mantém uma computação rápida e eficiente. O avanço da equipe MIT-IBM reduz a necessidade de transformadores dividirem os problemas em muitas etapas, permitindo-lhes lidar com subproblemas mais complexos com menos tokens de inferência.

Visões de novo

Os dados visuais contêm uma infinidade que o cérebro humano pode rapidamente analisar, internalizar e depois imitar. Usando modelos de linguagem de visão (VLMs), dois estudantes de pós-graduação estão explorando maneiras de fazer isso por meio de código.

Nos últimos dois verões e sob a orientação de Aude Oliva, diretora do MIT-IBM Watson AI Lab do MIT e pesquisadora sênior do Laboratório de Ciência da Computação e Inteligência Synthetic; e Rogerio Feris, Dan Gutfreund e Leonid Karlinsky da IBM Analysis (agora na Xero), Jovana Kondic do EECS explorou a compreensão visible de documentos, especificamente gráficos. Eles contêm elementos, como pontos de dados, legendas e rótulos de eixos, que exigem reconhecimento óptico de caracteres e raciocínio numérico, com os quais os modelos ainda têm dificuldades. Para facilitar o desempenho em tarefas como essas, o grupo de Kondic decidiu criar um grande conjunto de dados gráficos sintéticos e de código aberto a partir de código que pudesse ser usado para treinamento e benchmarking.

Com seu protótipo, ChartGen, os pesquisadores criaram um pipeline que passa imagens do gráfico inicial por meio de um VLM, que é solicitado a ler o gráfico e gerar um script Python que provavelmente foi usado para criar o gráfico em primeiro lugar. O componente LLM da estrutura aumenta iterativamente o código de muitos gráficos para produzir mais de 200.000 pares exclusivos de gráficos e seus códigos, abrangendo quase 30 tipos de gráficos, além de oferecer suporte a dados e anotações, como descrições e pares de perguntas e respostas sobre os gráficos. A equipe está expandindo ainda mais seu conjunto de dados, ajudando a permitir a compreensão multimodal crítica para visualizações de dados para aplicações empresariais, como relatórios financeiros e científicos, blogs e muito mais.

Em vez de gráficos, o estudante de pós-graduação do EECS, Leonardo Hernandez Cano, está de olho no design digital, especificamente na geração de texturas visuais para aplicações CAD e no objetivo de descobrir maneiras eficientes de habilitar recursos em VLMs. Em parceria com os grupos de laboratório liderados por Armando Photo voltaic-Lezama, professor do EECS e distinto professor de computação no MIT Schwarzman School of Computing, e Nathan Fulton da IBM Analysis, Hernandez Cano criou um sistema de síntese de programas que aprende a refinar o código por conta própria. O sistema começa com uma descrição de textura fornecida por um usuário na forma de uma imagem. Em seguida, ele gera um programa Python inicial, que produz texturas visuais, e refina iterativamente o código com o objetivo de encontrar um programa que produza uma textura que corresponda à descrição alvo, aprendendo a procurar novos programas a partir dos dados que o próprio sistema produz. Através desses refinamentos, o novo programa pode criar visualizações com a luminosidade, cor, iridescência desejada, and so on., imitando materiais reais.

Quando vistos em conjunto, estes projetos, e as pessoas por trás deles, estão a dar um impulso coeso em direção a uma inteligência synthetic mais robusta e prática. Ao enfrentar os principais desafios de fiabilidade, eficiência e raciocínio multimodal, o trabalho abre caminho para sistemas de IA que não são apenas mais poderosos, mas também mais fiáveis e económicos, para aplicações empresariais e científicas do mundo actual.