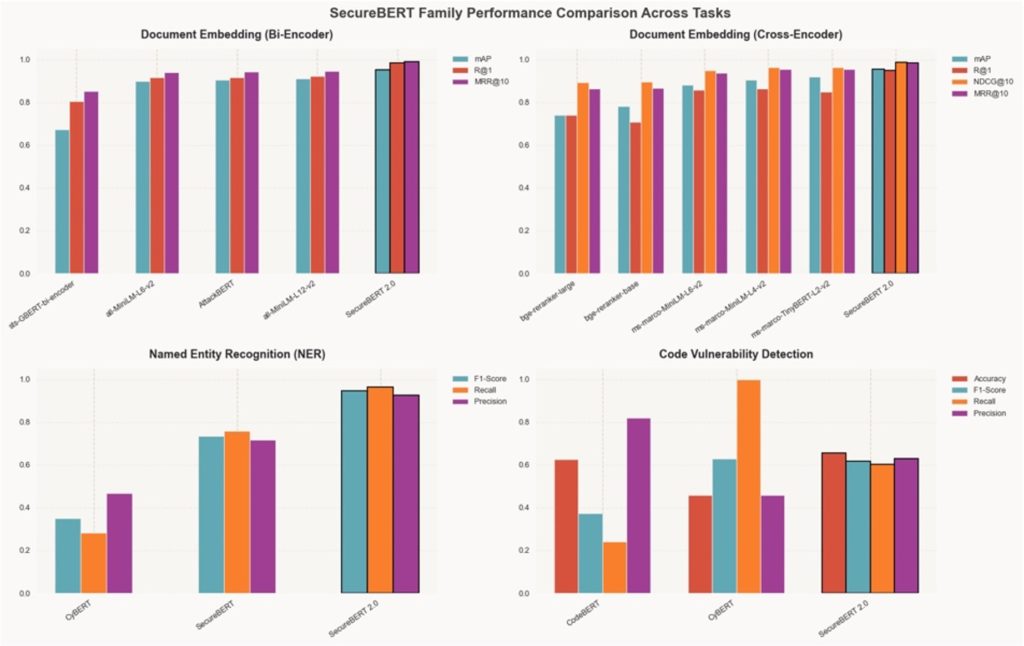

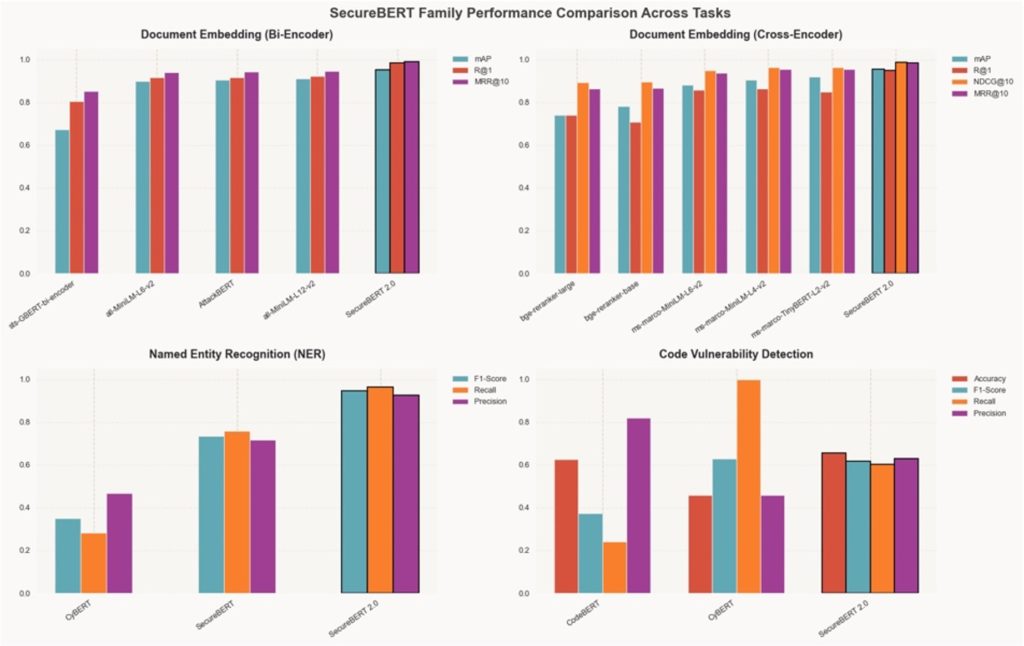

Hoje, temos o prazer de compartilhar que o modelo SecureBERT 2.0 está disponível em Abraçando o rosto e GitHub com um acompanhamento artigo de pesquisa. Este lançamento representa um marco significativo, com base no modelo SecureBERT já amplamente adotado para desbloquear aplicações de segurança cibernética ainda mais avançadas. Basta ver este desempenho incomparável em tarefas do mundo actual:

Em 2022, o primeiro modelo SecureBERT foi apresentado por Ehsan e uma equipe de pesquisadores da Carnegie Mellon College e UNC Charlotte como um modelo de linguagem pioneiro projetado especificamente para o domínio da segurança cibernética. Ele preencheu a lacuna entre os modelos de PNL de uso geral, como o BERT, e as necessidades especializadas dos profissionais de segurança cibernética, permitindo que os sistemas de IA entender a linguagem técnica de ameaças, vulnerabilidades e explorações.

Em dezembro de 2023, SecureBERT estava classificado entre os 100 modelos mais baixados no HuggingFace entre os aproximadamente 500.000 modelos então disponíveis no repositório. Ganhou reconhecimento significativo em toda a comunidade de segurança cibernética e continua em uso ativo por grandes organizações, incluindo o MITRE Risk Report ATT&CK Mapper (TRAM) e o CyberPeace Institute.

Neste weblog, refletiremos sobre o impacto do modelo SecureBERT authentic, detalharemos os avanços significativos feitos no SecureBERT 2.0 e exploraremos algumas aplicações do mundo actual deste novo e poderoso modelo.

O impacto do modelo SecureBERT authentic

Os analistas de segurança em empresas e agências dedicam muito tempo à análise de vários sinais de segurança para identificar, analisar, categorizar e relatar ameaças potenciais. É um processo importante que, quando feito inteiramente manualmente, é demorado, caro e sujeito a erros humanos.

O SecureBERT forneceu aos pesquisadores e analistas uma ferramenta que poderia processar relatórios de segurança, análises de malware e descrições de vulnerabilidades com uma precisão contextual nunca antes possível. Ainda hoje, serve como uma ferramenta inestimável para especialistas em segurança cibernética de algumas das principais agências, universidades e laboratórios do mundo.

No entanto, o SecureBERT tinha várias limitações. Ele teve dificuldades para lidar com entradas de contexto longo, como relatórios detalhados de inteligência sobre ameaças e dados em formatos mistos, combinando texto e código. Como o SecureBERT foi treinado no RoBERTa-base, um codificador BERT clássico com limite de contexto de 512 tokens e sem FlashAttention, ele period mais lento e consumia mais memória durante o treinamento e a inferência. Por outro lado, o SecureBERT 2.0, baseado no ModernBERT, se beneficia de uma arquitetura otimizada com contexto estendido, taxa de transferência mais rápida, menor latência e uso reduzido de memória.

Com o SecureBERT 2.0, abordamos essas lacunas nos dados de treinamento e avançamos na arquitetura para fornecer um modelo ainda mais capaz e contextualmente consciente do que nunca. Embora o SecureBERT authentic fosse um modelo básico independente, a versão 2.0 inclui diversas variantes aprimoradas, especializadas em vários aplicativos de segurança cibernética do mundo actual.

Apresentando SecureBERT 2.0

SecureBERT 2.0 traz maior relevância contextual e experiência de domínio para segurança cibernética, compreendendo fontes de código e lógica de programação de uma forma que seu antecessor simplesmente não conseguia. A chave aqui é um conjunto de dados de treinamento maior, mais diversificado e estrategicamente selecionado para ajudar o modelo a capturar melhor nuances sutis de segurança e fornecer análises de ameaças mais precisas, confiáveis e conscientes do contexto.

Embora grandes modelos autoregressivos, como o GPT-5, sejam excelentes na geração de linguagem, modelos baseados em codificadores, como o SecureBERT 2.0, são projetados para compreender, representar e recuperar informações com precisão – uma necessidade elementary em segurança cibernética. Os modelos generativos prevêem o próximo token; modelos codificadores transformam entradas inteiras em incorporações densas e semanticamente ricas que capturam relacionamentos, contexto e significado sem fabricar conteúdo.

Essa distinção torna o SecureBERT 2.0 excellent para aplicações críticas de segurança e de alta precisão, onde a precisão factual, a explicabilidade e a velocidade são fundamentais. Construído na arquitetura ModernBERT, ele usa codificação hierárquica de longo contexto e compreensão multimodal de texto e código para analisar dados complexos de ameaças e código-fonte com eficiência.

Vamos dar uma olhada em como o SecureBERT 2.0 ajuda os analistas de segurança em aplicações do mundo actual.

Aplicações do mundo actual do SecureBERT 2.0

Think about que você é um analista SOC encarregado de investigar uma suspeita de comprometimento da cadeia de suprimentos. Tradicionalmente, isso envolveria a correlação de inteligência de código aberto, alertas internos e relatórios de vulnerabilidade em um processo que poderia levar várias semanas de análise handbook de dados e referência cruzada.

Com o SecureBERT 2.0, você pode simplesmente incorporar todos os ativos relevantes – relatórios, códigos, dados CVE e inteligência de ameaças, por exemplo – no sistema. O modelo revela imediatamente ligações entre indicadores obscuros e padrões de infra-estruturas nunca antes vistos.

Este é apenas um cenário potencial entre muitos; SecureBERT 2.0 pode oferecer suporte e agilizar uma grande variedade de aplicações de segurança em potencial:

- Correlação de inteligência de ameaças: vinculando indicadores de comprometimento em diversas fontes para descobrir padrões de campanha e táticas adversárias

- Triagem de incidentes e priorização de alertas: incorporação de alertas e relatórios para detectar duplicatas, incidentes relacionados ou CVEs conhecidos, reduzindo o ruído e a carga de trabalho do analista

- Detecção segura de código e vulnerabilidade: identificação de padrões arriscados, dependências inseguras e possíveis vulnerabilidades de dia zero no código-fonte

- Pesquisa semântica e RAG para operações de segurança: fornecendo recuperação com reconhecimento de contexto em bases de conhecimento internas, feeds de ameaças e documentação para uma resposta mais rápida do analista

- Pesquisa de políticas e conformidade: possibilitando pesquisas semânticas precisas em grandes corporações regulatórias e de governança

Ao contrário dos LLMs generativos que criam texto, o SecureBERT 2.0 interpreta e estrutura informações para fornecer inferência mais rápida, reduzir custos de computação e minimizar o risco de alucinação. Isso o torna um modelo de base confiável para ambientes empresariais, de defesa e de pesquisa onde a precisão e a integridade dos dados são mais importantes.

Sob o capô do SecureBERT 2.0

Existem três componentes na arquitetura SecureBERT 2.0 que tornam este modelo um avanço tão significativo: sua base ModernBERT, sua expansão de dados e uma abordagem mais inteligente para pré-treinamento.

SecureBERT 2.0 é desenvolvido com ModernBERT, um transformador de última geração projetado para processamento de documentos longos. Mecanismos de atenção estendidos e codificação hierárquica permitem que o modelo seize sintaxe refinada e estrutura de alto nível – elementary para analisar relatórios de segurança longos e com várias seções.

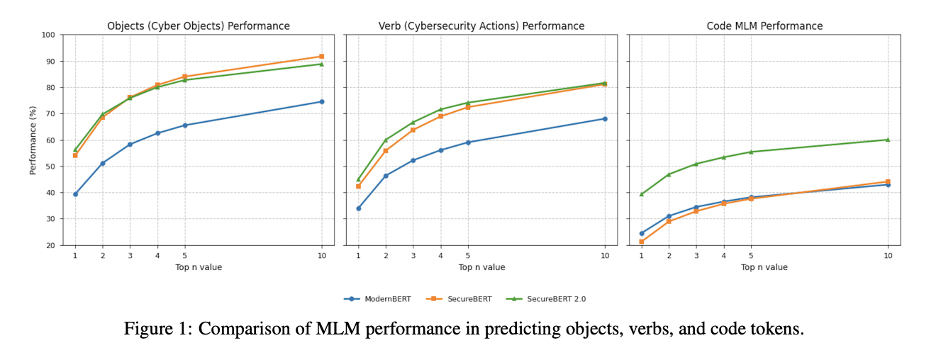

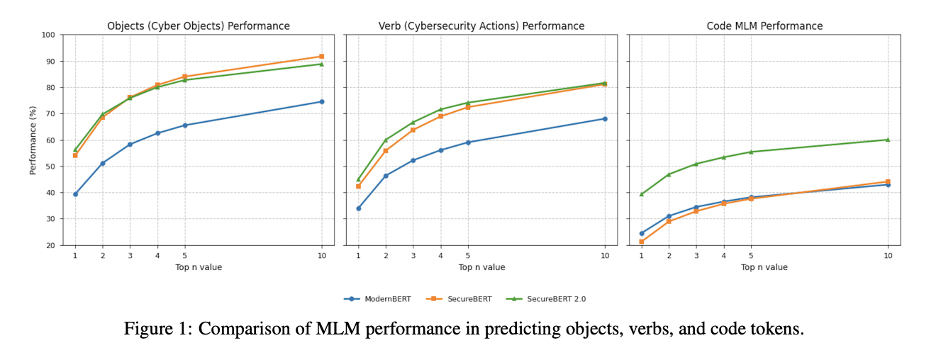

O modelo é treinado em 13 vezes mais dados do que o SecureBERT authentic com um novo corpus que inclui artigos de segurança e blogs técnicos selecionados, dados filtrados de segurança cibernética, repositórios de vulnerabilidades de código e narrativas de incidentes. No complete, este conjunto de dados cobre 13 mil milhões de tokens de texto e 53 milhões de tokens de código.

Finalmente, um currículo de pré-treinamento de microannealing faz a transição gradual de dados selecionados para dados do mundo actual, equilibrando qualidade e diversidade. O mascaramento direcionado ensina o modelo a prever ações e entidades de segurança cruciais como “ignorar”, “criptografar” ou “CVE”, fortalecendo a representação do domínio.

O desempenho do SecureBERT 2.0 é uma melhoria acentuada em relação ao seu antecessor e outros modelos avaliados em benchmarks; os detalhes podem ser encontrados em artigo de pesquisa completo.

Olhando para o futuro: IA para segurança na Cisco

SecureBERT 2.0 demonstra o que é possível quando a arquitetura e os dados são desenvolvidos especificamente para segurança cibernética. Ele se junta a outros modelos, como o generativo Basis-Sec-8B da equipe Basis AI da Cisco, como parte do compromisso contínuo da Cisco de aplicar IA de forma responsável no domínio da segurança cibernética.

Estamos entusiasmados em compartilhar este modelo com o mundo, em ver algumas das maneiras inovadoras como ele será adotado pela comunidade de segurança e em continuar explorando usos potenciais para criação de taxonomia, geração de gráficos de conhecimento e outras aplicações de ponta.

Você pode começar com o modelo SecureBERT 2.0 em Abraçando o rosto e GitHub hoje e discover nosso artigo de pesquisa para obter mais detalhes e benchmarking de desempenho.

O futuro da IA de segurança cibernética é seguramente inteligente.