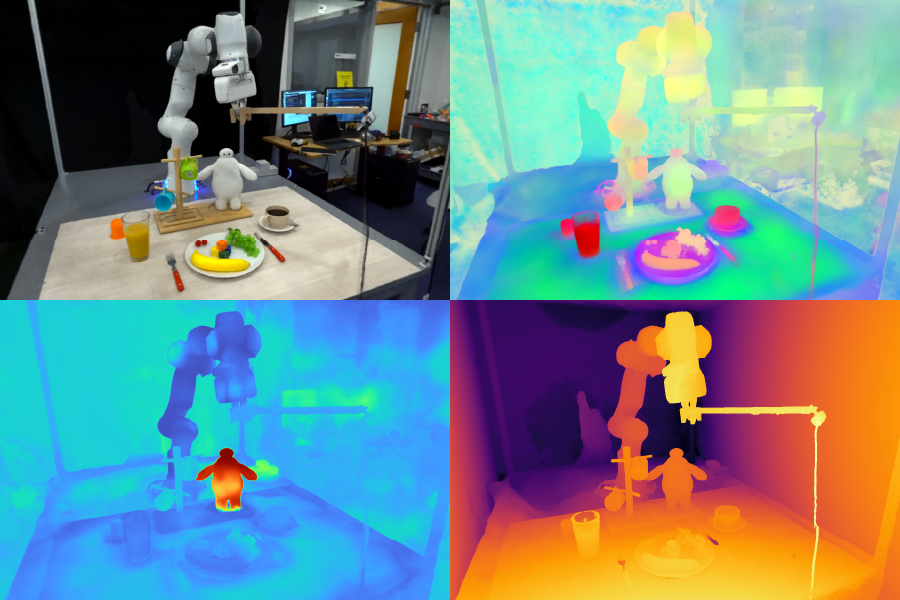

Function Fields for Robotic Manipulation (F3RM) permite que robôs interpretem prompts de texto abertos usando linguagem pure, ajudando as máquinas a manipular objetos desconhecidos. Os campos de recursos 3D do sistema podem ser úteis em ambientes que contêm milhares de objetos, como armazéns. Imagens cortesia dos pesquisadores.

Por Alex Shipps | MIT CSAIL

Think about que você está visitando um amigo no exterior e olha dentro da geladeira dele para ver o que seria um ótimo café da manhã. Muitos dos itens inicialmente parecem estranhos para você, com cada um envolto em embalagens e recipientes desconhecidos. Apesar dessas distinções visuais, você começa a entender para que cada um é usado e os pega conforme necessário.

Inspirado pela capacidade dos humanos de manipular objetos desconhecidos, um grupo do Laboratório de Ciência da Computação e Inteligência Synthetic (CSAIL) do MIT projetou Campos de Recursos para Manipulação Robótica (F3RM), um sistema que combina imagens 2D com características do modelo de base em cenas 3D para ajudar robôs a identificar e agarrar itens próximos. F3RM pode interpretar instruções de linguagem aberta de humanos, tornando o método útil em ambientes do mundo actual que contêm milhares de objetos, como armazéns e residências.

O F3RM oferece aos robôs a capacidade de interpretar prompts de texto abertos usando linguagem pure, ajudando as máquinas a manipular objetos. Como resultado, as máquinas podem entender solicitações menos específicas de humanos e ainda concluir a tarefa desejada. Por exemplo, se um usuário pede ao robô para “pegar uma caneca alta”, o robô pode localizar e pegar o merchandise que melhor se encaixa nessa descrição.

“Fazer robôs que realmente possam generalizar no mundo actual é incrivelmente difícil”, diz Ge Yangpós-doutorado no Instituto de Inteligência Synthetic e Interações Fundamentais da Nationwide Science Basis AI e MIT CSAIL. “Nós realmente queremos descobrir como fazer isso, então com este projeto, tentamos pressionar por um nível agressivo de generalização, de apenas três ou quatro objetos para qualquer coisa que encontrarmos no Stata Heart do MIT. Queríamos aprender como fazer robôs tão flexíveis quanto nós, já que podemos agarrar e posicionar objetos mesmo que nunca os tenhamos visto antes.”

Aprendendo “o que está onde olhando”

O método pode auxiliar robôs a escolher itens em grandes centros de distribuição com desordem e imprevisibilidade inevitáveis. Nesses depósitos, os robôs geralmente recebem uma descrição do inventário que eles precisam identificar. Os robôs devem corresponder o texto fornecido a um objeto, independentemente das variações na embalagem, para que os pedidos dos clientes sejam enviados corretamente.

Por exemplo, os centros de distribuição de grandes varejistas on-line podem conter milhões de itens, muitos dos quais um robô nunca encontrou antes. Para operar em tal escala, os robôs precisam entender a geometria e a semântica de diferentes itens, com alguns estando em espaços apertados. Com as habilidades avançadas de percepção espacial e semântica do F3RM, um robô poderia se tornar mais eficaz em localizar um objeto, colocá-lo em uma caixa e, em seguida, enviá-lo para embalagem. Em última análise, isso ajudaria os trabalhadores da fábrica a enviar os pedidos dos clientes de forma mais eficiente.

“Uma coisa que frequentemente surpreende as pessoas com o F3RM é que o mesmo sistema também funciona em escala de sala e prédio, e pode ser usado para construir ambientes de simulação para aprendizado de robôs e mapas grandes”, diz Yang. “Mas antes de ampliarmos ainda mais esse trabalho, queremos primeiro fazer esse sistema funcionar muito rápido. Dessa forma, podemos usar esse tipo de representação para tarefas de controle robótico mais dinâmicas, esperançosamente em tempo actual, para que robôs que lidam com tarefas mais dinâmicas possam usá-lo para percepção.”

A equipe do MIT observa que a capacidade do F3RM de entender diferentes cenas pode torná-lo útil em ambientes urbanos e domésticos. Por exemplo, a abordagem pode ajudar robôs personalizados a identificar e pegar itens específicos. O sistema auxilia os robôs a compreender seus arredores — tanto física quanto perceptivamente.

“A percepção visible foi definida por David Marr como o problema de saber ‘o que está onde olhando’”, diz o autor sênior Phillip Isolaprofessor associado de engenharia elétrica e ciência da computação do MIT e pesquisador principal do CSAIL. “Modelos de fundação recentes ficaram muito bons em saber o que estão olhando; eles podem reconhecer milhares de categorias de objetos e fornecer descrições de texto detalhadas de imagens. Ao mesmo tempo, campos de radiância ficaram muito bons em representar onde as coisas estão em uma cena. A combinação dessas duas abordagens pode criar uma representação do que está onde em 3D, e o que nosso trabalho mostra é que essa combinação é especialmente útil para tarefas robóticas, que exigem a manipulação de objetos em 3D.”

Criando um “gêmeo digital”

O F3RM começa a entender o ambiente ao tirar fotos com um bastão de selfie. A câmera montada tira 50 imagens em poses diferentes, permitindo que ela construa uma campo de radiância neural (NeRF), um método de aprendizado profundo que pega imagens 2D para construir uma cena 3D. Esta colagem de fotos RGB cria um “gêmeo digital” de seus arredores na forma de uma representação de 360 graus do que está próximo.

Além de um campo de radiância neural altamente detalhado, o F3RM também constrói um campo de características para aumentar a geometria com informações semânticas. O sistema usa GRAMPOum modelo de base de visão treinado em centenas de milhões de imagens para aprender conceitos visuais de forma eficiente. Ao reconstruir os recursos 2D CLIP para as imagens tiradas pelo bastão de selfie, o F3RM efetivamente eleva os recursos 2D para uma representação 3D.

Mantendo as coisas em aberto

Após receber algumas demonstrações, o robô aplica o que sabe sobre geometria e semântica para agarrar objetos que nunca encontrou antes. Depois que um usuário envia uma consulta de texto, o robô pesquisa no espaço de possíveis agarramentos para identificar aqueles com maior probabilidade de sucesso em pegar o objeto solicitado pelo usuário. Cada opção potencial é pontuada com base em sua relevância para o immediate, similaridade com as demonstrações nas quais o robô foi treinado e se causa alguma colisão. O agarramento com maior pontuação é então escolhido e executado.

Para demonstrar a capacidade do sistema de interpretar solicitações abertas de humanos, os pesquisadores solicitaram que o robô pegasse Baymax, um personagem do filme “Large Hero 6”, da Disney. Embora F3RM nunca tenha sido treinado diretamente para pegar um brinquedo do super-herói de desenho animado, o robô usou sua consciência espacial e recursos de visão e linguagem dos modelos básicos para decidir qual objeto pegar e como pegá-lo.

O F3RM também permite que os usuários especifiquem qual objeto eles querem que o robô manuseie em diferentes níveis de detalhes linguísticos. Por exemplo, se houver uma caneca de metallic e uma caneca de vidro, o usuário pode pedir ao robô a “caneca de vidro”. Se o bot vir duas canecas de vidro e uma delas estiver cheia de café e a outra com suco, o usuário pode pedir a “caneca de vidro com café”. Os recursos do modelo de base incorporados no campo de recursos permitem esse nível de compreensão aberta.

“Se eu mostrasse a uma pessoa como pegar uma caneca pela borda, ela poderia facilmente transferir esse conhecimento para pegar objetos com geometrias semelhantes, como tigelas, copos de medição ou até mesmo rolos de fita. Para robôs, atingir esse nível de adaptabilidade tem sido bastante desafiador”, diz o aluno de doutorado do MIT, afiliado do CSAIL e coautor principal William Shen. “O F3RM combina compreensão geométrica com semântica de modelos de fundação treinados em dados de escala de web para permitir esse nível de generalização agressiva a partir de apenas um pequeno número de demonstrações.”

Shen e Yang escreveram o artigo sob a supervisão de Isola, com a professora do MIT e pesquisadora principal do CSAIL Leslie Pack Kaelbling e os alunos de graduação Alan Yu e Jansen Wong como coautores. A equipe foi apoiada, em parte, pela Amazon.com Providers, a Nationwide Science Basis, o Air Power Workplace of Scientific Analysis, a Iniciativa Universitária Multidisciplinar do Workplace of Naval Analysis, o Military Analysis Workplace, o MIT-IBM Watson Lab e o MIT Quest for Intelligence. O trabalho deles será apresentado na Conferência sobre Aprendizado de Robôs de 2023.

Notícias do MIT