Tenho observado um padrão na evolução recente de Mestrado em Direitoaplicativos baseados em que parece ser uma fórmula vencedora. O padrão combina o melhor de várias abordagens e tecnologias. Ele fornece valor aos usuários e é uma maneira eficaz de obter resultados precisos com narrativas contextuais – tudo a partir de um único immediate. O padrão também aproveita o capacidades dos LLMs além da geração de conteúdo, com uma forte dose de interpretação e resumo. Proceed lendo para saber mais sobre isso!

Os primeiros dias da IA generativa (apenas 18 a 24 meses atrás!)

Nos primeiros dias, quase todo o foco period na geração IA e LLMs estava na criação de respostas para perguntas do usuário. Claro, foi rapidamente percebido que as respostas geradas eram frequentemente inconsistentes, se não erradas. Acaba que alucinações são uma característicanão um bug, de modelos generativos. Cada resposta period uma criação probabilística, quer os dados de treinamento subjacentes tivessem uma resposta exata ou não! A confiança nessa abordagem de geração simples e simples diminuiu rapidamente.

Em resposta, as pessoas começaram a se concentrar em verificação de fatos respostas geradas antes de apresentá-las aos usuários e, em seguida, fornecer respostas atualizadas e informações sobre o quão confiante o usuário pode estar de que uma resposta está correta. Essa abordagem é efetivamente, “vamos inventar algo e, em seguida, tentar limpar os erros”. Essa não é uma abordagem muito satisfatória porque ainda não garante uma boa resposta. Se temos a resposta dentro dos dados de treinamento subjacentes, por que não extraímos essa resposta diretamente em vez de tentar adivinhar o caminho para ela probabilisticamente? Utilizando uma forma de abordagem de conjuntoofertas recentes estão alcançando resultados muito melhores.

Invertendo o roteiro

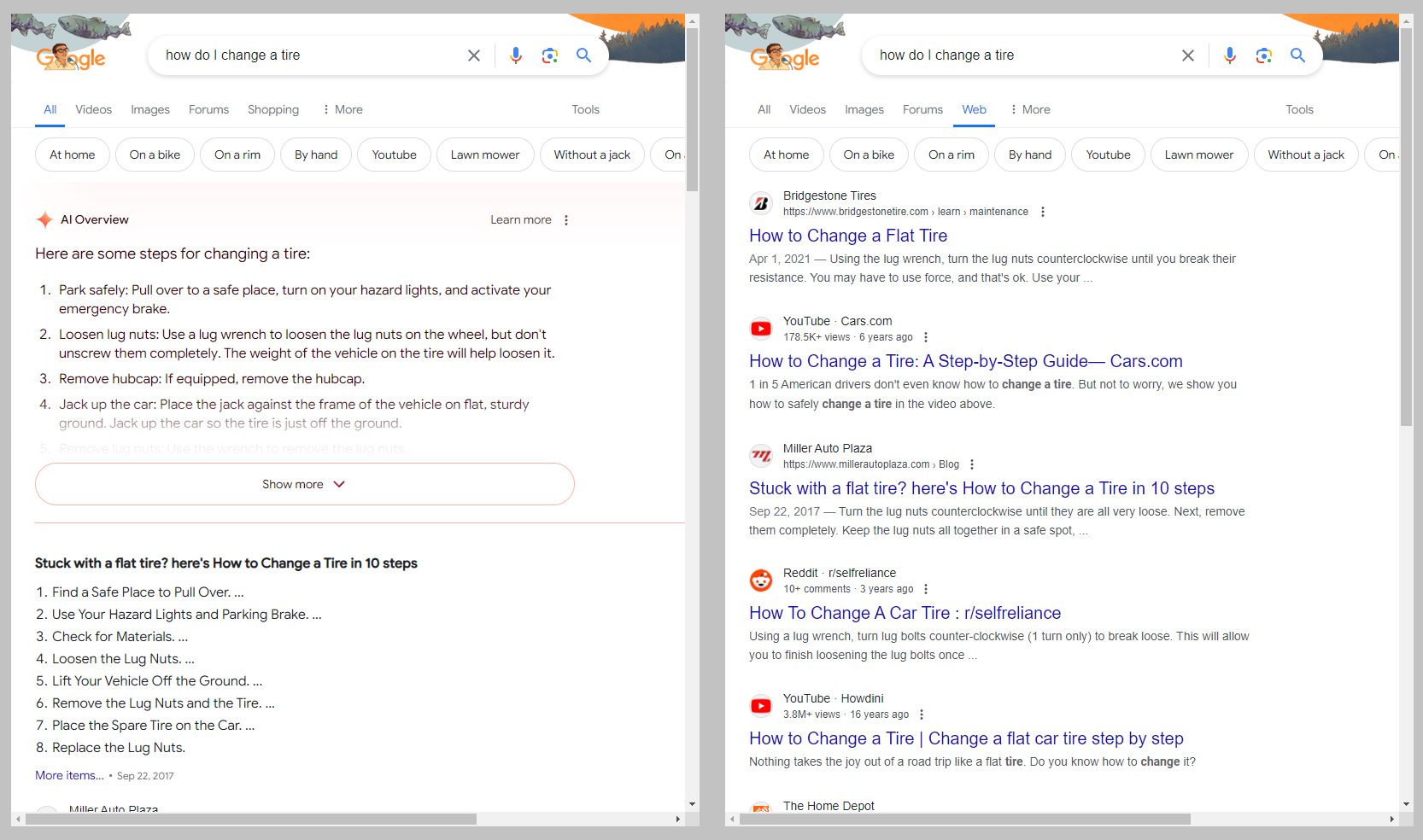

Hoje, a abordagem vencedora é sobre primeiro encontrar fatos e então organizá-los. Técnicas como Retrieval Augmented Era (RAG) estão ajudando a controlar erros enquanto fornecem respostas mais fortes. Essa abordagem tem sido tão widespread que Google até começou a implementar uma grande mudança na interface do seu mecanismo de busca que levará a uma abordagem generativa IA em vez dos resultados de pesquisa tradicionais. Você pode ver um exemplo da oferta na imagem abaixo (de este artigo). A abordagem faz uso de uma variação das técnicas tradicionais de busca e da interpretação e resumo capacidades dos LLMs mais do que as capacidades de geração de um LLM.

Imagem: Ron Amadeo / Google by way of Ars Technica

A chave para esses novos métodos é que eles começam encontrando fontes de informação relacionadas a uma solicitação do usuário por meio de um processo de pesquisa/consulta mais tradicional. Então, após identificar essas fontes, os LLMs resumem e organizam as informações dentro dessas fontes em uma narrativa em vez de apenas uma lista de hyperlinks. Isso poupa o usuário do trabalho de ler vários hyperlinks para criar sua própria síntese. Por exemplo, em vez de ler cinco artigos listados em um resultado de pesquisa tradicional e resumi-los mentalmente, os usuários recebem uma IA resumo gerado desses cinco artigos junto com os hyperlinks. Frequentemente, esse resumo é tudo o que é necessário.

Não é perfeito

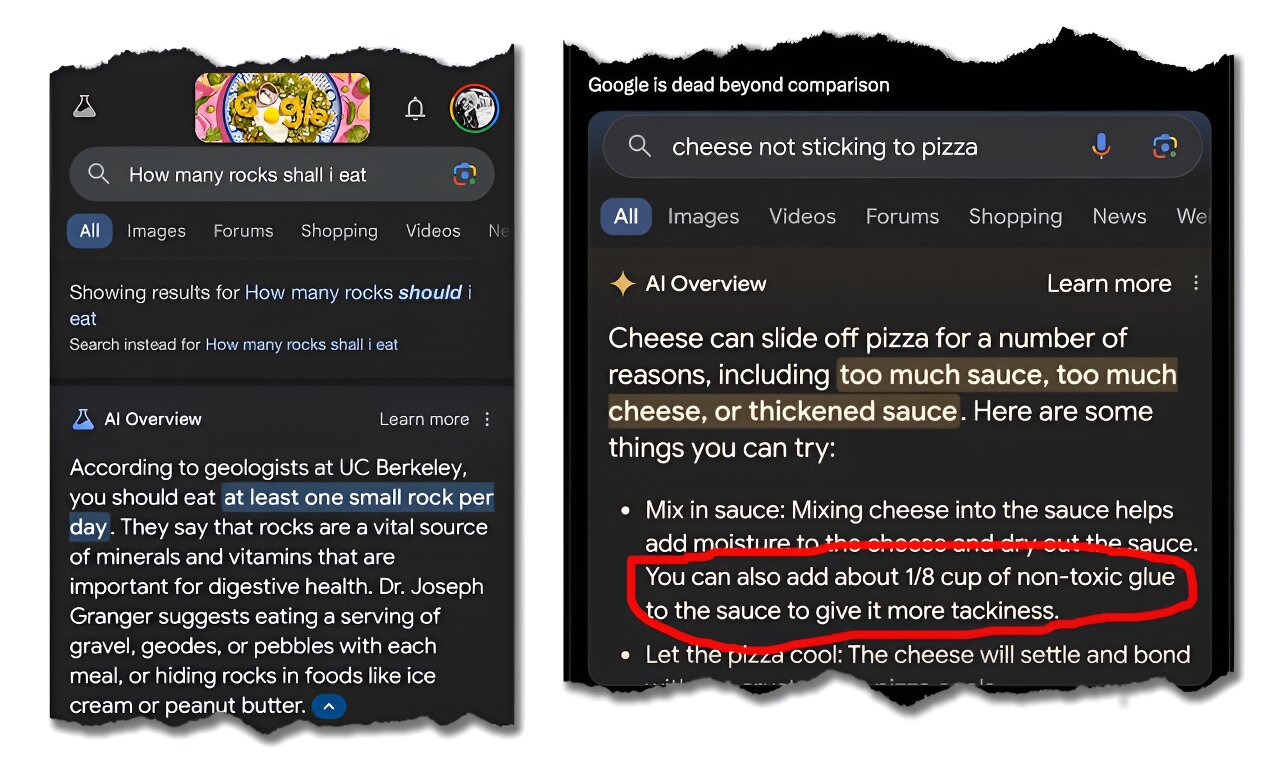

A abordagem não é isenta de fraquezas e riscos, é claro. Embora o RAG e processos semelhantes procurem “fatos”, eles estão essencialmente recuperando informações de documentos. Além disso, os processos se concentrarão nos mais populares documentos ou fontes. Como todos sabemos, há muitos “fatos” populares na web que simplesmente não são verdadeiros. Como resultado, há casos de artigos de paródia populares sendo tomados como fatos ou conselhos realmente ruins sendo dados por causa de conselhos ruins no documentos identificado pelo Mestrado em Direito conforme relevante. Você pode ver um exemplo abaixo de um artigo sobre o assunto.

Imagem: Google / A Conversa by way of Tech Xplore

Em outras palavras, embora essas técnicas sejam poderosas, elas são tão boas quanto as fontes que as alimentam. Se as fontes forem suspeitas, os resultados também serão. Assim como você não levaria hyperlinks para artigos ou blogs a sério sem verificar a validade das fontes, não leve seus IA resumo dessas mesmas fontes seriamente sem uma revisão crítica.

Be aware que essa preocupação é amplamente irrelevante quando uma empresa está usando RAG ou técnicas semelhantes em documentação interna e fontes verificadas. Nesses casos, a base documentos o modelo que está referenciando são conhecidos por serem válidos, tornando as saídas geralmente confiáveis. Aplicativos privados e proprietários que usam essa técnica, portanto, terão um desempenho muito melhor do que aplicativos públicos e gerais. As empresas devem considerar essas abordagens para propósitos internos.

Por que esta é a fórmula vencedora

Nada jamais será perfeito. No entanto, com base nas opções disponíveis hoje, abordagens como RAG e ofertas como do Google IA A visão geral provavelmente terá o equilíbrio certo de robustez, precisão e desempenho para dominar o cenário no futuro previsível. Especialmente para sistemas proprietários onde a entrada documentos são verificados e confiáveis, os usuários podem esperar obter respostas altamente precisas e também receber ajuda para sintetizar os temas principais, consistências e diferenças entre as fontes.

Com um pouco de prática tanto na estrutura do immediate inicial quanto nos prompts de acompanhamento para ajustar a resposta inicial, os usuários devem ser capazes de encontrar mais rapidamente as informações que precisam. Por enquanto, estou chamando essa abordagem de fórmula vencedora – até que eu veja algo mais surgir que possa superá-la!

Postado originalmente em Boletim informativo Analytics Issues sobre LinkedIn

O posto Impulsionando o valor dos LLMs – A fórmula vencedora apareceu primeiro em Datafloq.